ChatGPT-PLUS:基于多平台大语言模型的 AI 助手全套开源解决方案

ChatGPT-PLUS是一个基于 AI 大语言模型 API 实现的 AI 助手全套开源解决方案,集成了多个平台的大语言模型,包括 OpenAI、Azure、ChatGLM、讯飞星火、文心一言等。该项目采用 Go + Vue3 + element-plus 实现,提供完整的开源系统,支持各种预训练角色应用、绘画功能集成、支付功能、插件 API 功能等特性。详细功能截图和体验地址可在文章中找到。

【ChatGLM】大模型之 ChatGLM 部署

目录 1. 资源下载 2. 部署启动 HuggingFace 模型权重下载 手动模型权重下载 源码下载 源码修改 对于 `cli_demo.py` 和 `web_demo.py` 中模型加载部分需要从 HuggingFace 下载 改为从本地加载 命令行启动 网页启动 启动后的效果:

LLaMa、Qwen、ChatGLM、ChatGLM2的区别

以下比较的前提是首先和BERT(transfomer)的对比 感谢帮忙给我github repository的star,更多最新模型长期更新:https://github.com/zysNLP/quickllm LLaMa: 去掉bias LayNorm方式:RMSnorm:https://zhuanlan.zhihu.com/p/650231190 torch自带LayerNorm ( F.layer_norm ) : 这是PyTorch库中内置的Layer Normalization实现。 输入

在矩池云使用ChatGLM-6B & ChatGLM2-6B

ChatGLM-6B 和 ChatGLM2-6B都是基于 General Language Model (GLM) 架构的对话语言模型,是清华大学 KEG 实验室和智谱 AI 公司于 2023 年共同发布的语言模型。模型有 62 亿参数,一经发布便受到了开源社区的欢迎,在中文语义理解和对话生成上有着不凡的表现。 ChatGLM-6B 可以在消费级的显卡

阿里云部署 ChatGLM2-6B 与 langchain+ChatGLM

更新系统 安装git 克隆 ChatGLM2-6B 源码 克隆 chatglm2-6b 模型 安装 ChatGLM2-6B 依赖 修改模型的路径 修改成 启动服务 启动成功后 克隆 langchain-ChatGLM 源码 git clone https://github.com/imClumsyPanda/langchain-ChatGLM.git 克隆模型 安装 langchain-ChatGLM 依赖 修改配置 修改一 修改成 修改二 修改成 修改

AIGC - ChatGLM大模型:ChatGLM2-6B模型推理部署

如果你要问我为什么直接部署ChatGLM2的模型? 因为当我在8月份在上海召开的全球人工智能大会上了解到清华-智谱发布的ChatGLM模型时,它已经发布了新的版本ChatGLM2,并且推理的效果提升了不少,那么本着只要最好的原则,我就直接上手先玩新版本了。 作为AIGC方面的小白来说

ChatGLM2-6B、ChatGLM-6B 模型介绍及训练自己数据集实战

介绍 ChatGLM-6B是开源的文本生成式对话模型,基于General Language Model(GLM)框架,具有62亿参数,结合模型蒸馏技术,实测在2080ti显卡训练中上(INT4)显存占用 6G 左右, 优点 :1.较低的部署门槛: FP16 半精度下,ChatGLM-6B 需要至少 13GB 的显存进行推理,结合模型量化技术,一需求可以进一步

【ChatGLM】记录一次Windows部署ChatGLM-6B流程及遇到的问题

系统版本:Windows 10 企业版 版本号:20H2 系统类型:64 位操作系统, 基于 x64 的处理器 处理器:Intel® Core™ i7-8700 CPU @ 3.20GHz 3.19 GHz 机带 RAM:16.0 GB 显卡:NVIDIA RTX 2070(8G) Python版本:3.10.11 文件分为两个部分: github上开源的训练、推理、以及运行demo、api的一些代码文件 hugg

【ChatGLM_01】ChatGLM2-6B本地安装与部署(大语言模型)

ChatGLM2-6B是一个开源的、支持中英双语的对话语言模型,基于General Language Model (GLM)架构。 ChatGLM2-6B具备的能力: 自我认知:“介绍一下你的优点” 提纲写作:“帮我写一个介绍ChatGLM的博客提纲” 文案写作:“写10条热评文案” 信息抽取:‘从上述信息中抽取人、时间、事件

三个开源大模型(chatglm2-6B, moss, llama)-chatglm2的测试

chatglm2-6B 是清华大学开源的一款支持中英双语的对话语言模型。经过了 1.4T 中英标识符的预训练与人类偏好对齐训练,具有62 亿参数的 ChatGLM2-6B 已经能生成相当符合人类偏好的回答。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6G

【Linux】【chatGLM-6B】如何从huggingface上下载chatGLM-6B模型于centos系统

从 https://github.com/git-lfs/git-lfs/releases 这个网址上选择以下框框中的内容进行下载 tar -zxvf git-lfs-linux-amd64-v2.12.1.tar.gz sudo ./install.sh 输入如下代码开始下载: git lfs clone https://huggingface.co/chatglm-6b 直接git clone下载的文件都特别小,不像是完整版的

ChatGLM Java SDK:智谱 AI 通用语言模型 Zhipu ChatGLM Java SDK

此项目是由 Java 的 JDK11 的长期版本开发,设备环境需要 JDK = 11 Java Maven Dependency (BlueChatGLM)调用 Java Gradle (BlueChatGLM)调用 Java sbt (BlueChatGLM)调用 1.1 NTP 网络时间服务器 它通过互联网或局域网上的时间服务器来提供高精度,高安全的时间信息,确保所有设备都使用相同的时间是关

【ChatGLM】本地版ChatGPT ?6G显存即可轻松使用 !ChatGLM-6B 清华开源模型本地部署教程

目录 感谢B站秋葉aaaki大佬 前言 部署资源 部署流程 实机演示 ChatGML微调(人格炼成)(个人感觉蛮有趣的地方) 分享有趣の微调人格 实机演示(潘金莲人格) 秋葉aaaki的个人空间_哔哩哔哩_bilibili https://space.bilibili.com/12566101 由于ChatGLM-6B的规模较小,目前已知其具有相当

【ChatGLM】手把手教你云服务器部署ChatGLM聊天网站,不限次数调用。

私人部署地址:http://ilovechatgpt.cn。 免费使用!无限调用!速度还蛮快呢。 官方地址:https://github.com/THUDM/ChatGLM-6B ChatGLM-6B 是一个 开源的、支持中英双语的对话语言模型 ,由基于 清华大学 KEG 实验室 与 智谱 AI 于 2023 年联合训练,可以针对用户的问题和要求提供适当的答复和

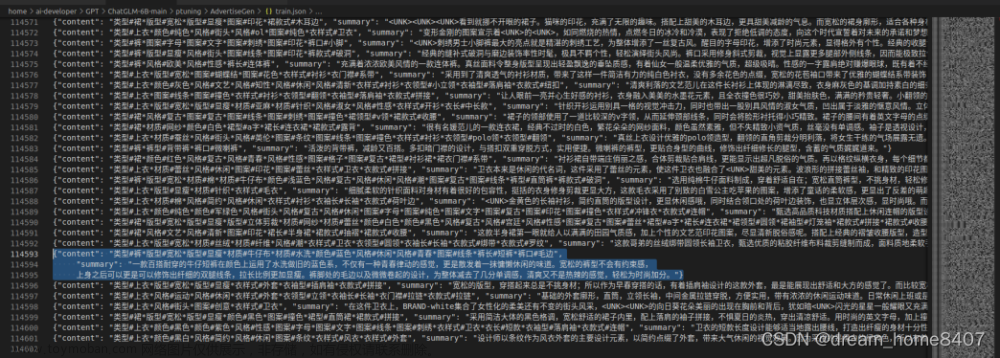

LLMs之ChatGLM2:基于ChatGLM Efficient Tuning(微调工具包)实现对ChatGLM2进行LoRA微调(CLI/GUI【text-generation-webui】)并进

LLMs之ChatGLM2:基于ChatGLM Efficient Tuning(微调工具包)实现对ChatGLM2进行LoRA微调(CLI/GUI【text-generation-webui】)并进行推理测试图文教程之详细攻略 目录 1、硬件要求和Python依赖 2、代码和模型权重下载 (1)、项目代码下载