教你如何在本地搭建DeepSeek,摆脱DeepSeek服务器繁忙,在家也能用

深度解析如何通过Ollama框架在Windows/macOS/Linux系统本地部署DeepSeek模型,提供从环境准备、安装配置到API对接的完整解决方案,彻底解决服务器卡顿和API限流问题,附常见错误排查手册。

将谷歌 Gemma AI大模型 部署安装本地教程(可离线使用)

作者主页: 点击! ————前言———— 谷歌 Gemma 是一个基于 Python 的图像分析工具,提供快速和准确的物体检测、定位、分类和风格迁移功能。它使用 TensorFlow Lite 模型,使它可以快速运行在移动设备上。 主要功能 物体检测: Gemma 可以识别图像中的物体,并标出其位置

笔记本电脑部署本地离线版类似ChatGPT3.5的AI模型(CPU+内存运行)

如果通过GPU来运行,一般办公电脑的显卡可能达不到所需的要求,所以,可以通过CPU+内存的方式花最低的代价来部署一套本地运行AI的模型。 1、首先下载CPU-Z,运行看一下电脑当前的指令集是否包含AVX512,非AVX512指令部署完应该也能运行,但可能运行速度会非常慢。(我的电

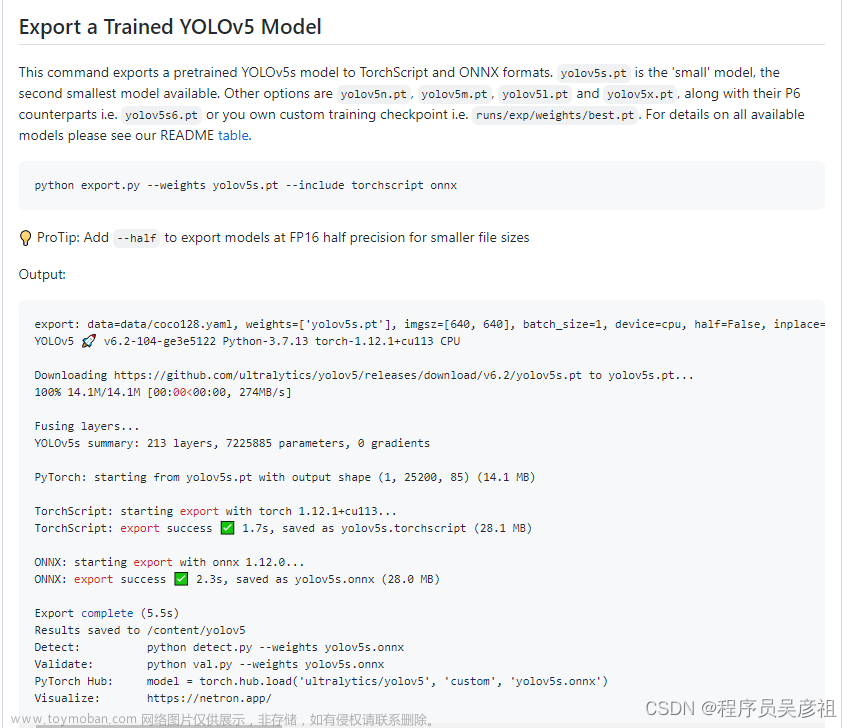

fastdeploy快速部署yolov5离线模型

本篇主要是介绍了yolov5模型的快速部署,使用过yolov5训练过的兄弟都知道,训练完之后,无论你的模型是如何导出的,最后想要使用导出的模型,可能还脱离不了yolov5框架,因为,在使用导出的模型前,yolov5对输入层和输出层都做了较多的图像处理,导致,最后要么是调用

离线AI聊天清华大模型(ChatGLM3)本地搭建

在特定的情况下,要保证信息安全的同时还能享受到AIGC大模型带来的乐趣和功能,那么,离线部署就能帮助到你,最起码,它是一个真正可用的方案。 大模型本身清华的 (ChatGLM3),为的是对中文支持友好,另外就是我也很看好它,毕竟一直在优化自己的模型,提升模型的质量

【UE5】离线AI聊天-接入LLAMA语言模型 教程

前言:LLAMA是一种神经网络模型,全称为Language Model with an Average Attention Mechanism(具有平均注意机制的语言模型)。它是一种用于自然语言处理任务的模型,特别适用于生成文本和回答问题。LLAMA模型结合了注意力机制和平均池化,以提高模型对输入文本的理解和生成能力。它

离线AI聊天清华大模型(ChatGLM3)本地搭建指南

随着人工智能技术的飞速发展,聊天机器人成为了一个热门的研究领域。清华大学研发的ChatGLM3模型,作为其中的佼佼者,为开发者提供了强大的自然语言处理能力。本文将指导您如何在本地搭建ChatGLM3模型,实现离线AI聊天功能。 一、前置准备 在开始搭建之前,您需要准备

打造专属个人模型-私有独立离线模型部署-阿里云GPU服务器配置

阿里云有免费的机器学习 GPU 服务器,免费试用活动页https://free.aliyun.com 只要没有申请过 PAI-DSW 资源的新老用户皆可申请 5000CU 的免费额度,3个月内使用。 选择第一个进行立即试用 可以看到试用的界面 如果遇到下面的错误,当前账号没有权限开通PAI,请联系主账号。 您可以

AntSK 0.2.3 版本更新:轻松集成 AI 本地离线模型

大家好,今天和大家分享 AntSK 知识库/智能体 项目的最新进展。 AntSK 是一个基于 .Net 8、Blazor 及 SemanticKernel 开发的 AI 项目,旨在为开发者提供一个强大的 AI 知识库与智能体平台。最新版本的项目可以在 GitHub 上找到: 在 AntSK 之前的版本

离线生成双语字幕,一键生成中英双语字幕,基于AI大模型,ModelScope

离线生成双语字幕整合包,一键生成中英双语字幕,基于AI大模型 制作双语字幕的方案网上有很多,林林总总,不一而足。制作双语字幕的原理也极其简单,无非就是人声背景音分离、语音转文字、文字翻译,最后就是字幕文件的合并,但美中不足之处这些环节中需要接口api的

【通义千问】大模型Qwen GitHub开源工程学习笔记(4)-- 模型的量化与离线部署

量化方案基于AutoGPTQ,提供了Int4量化模型,其中包括Qwen-7B-Chat和Qwen-14B-Chat。更新承诺在模型评估效果几乎没有损失的情况下,降低存储要求并提高推理速度。量化是指将模型权重和激活的精度降低以节省存储空间并提高推理速度的过程。AutoGPTQ是一种专有量化工具。Int4是指

Topaz Photo AI v2.4.1 (离线模型)人工智能降噪软件

Topaz Photo AI中文汉化安装版是一款强大的人工智能降噪软件,允许用户使用复杂的锐化算法来提高图像清晰度,还包括肖像编辑选项,如面部重塑、肤色优化和面部表情增强,功能强大!鉴于官方提供的模型在中国大陆下载特别慢,有的时候中途还出错,特意给大家整理出独

本地化部署离线开源免费语音识别API,支持多模态AI能力引擎

思通数科作为一家专注于多模态AI能力开源引擎平台,其技术产品涵盖了自然语言处理、情感分析、实体识别、图像识别与分类、OCR识别以及语音识别等多个领域。在语音识别这一细分市场,思通数科的技术产品中的音频文件转写服务有着相似的应用场景和功能特点。 思通数

通过制作llama_cpp的docker镜像在内网离线部署运行大模型

对于机器在内网,无法连接互联网的服务器来说,想要部署体验开源的大模型,需要拷贝各种依赖文件进行环境搭建难度较大,本文介绍如何通过制作docker镜像的方式,通过llama.cpp实现量化大模型的快速内网部署体验。 一、llama_cpp介绍 LLaMA 全称是Large Language Model Meta AI,是由

[嵌入式AI从0开始到入土]7_转化为昇腾支持的om离线模型

注:等我摸完鱼再把链接补上 可以关注我的B站号工具人呵呵的个人空间,后期会考虑出视频教程,务必催更,以防我变身鸽王。 第一章 昇腾Altas 200 DK上手 第二章 下载昇腾案例并运行 第三章 官方模型适配工具使用 第四章 炼丹炉的搭建(基于Ubuntu23.04 Desktop) 第五章 Ubunt

![[嵌入式AI从0开始到入土]7_转化为昇腾支持的om离线模型](https://imgs.yssmx.com/Uploads/2024/02/770839-1.png)