-

PHP如何实现模糊搜索分词功能

1、将 文件下载下来解压到一个目录,例如 D :/wamp/scws 2、需要配置php.ini extension=php_scws.dllscws.default.charset=utf8//配置默认的编码方式scws.default.fpath=D:/wamp/scws//加压后文件的路径 3、安装完成后,开始使用。 $app=scws_new();//编码$app-set_charset(utf8);//这里没有调用set_dict和set_rule系统会

-

中文分词入门:使用IK分词器进行文本分词(附Java代码示例)

中文分词是将连续的中文文本切分成一个个独立的词语的过程,是中文文本处理的基础。IK分词器是一个高效准确的中文分词工具,采用了\\\"正向最大匹配\\\"算法,并提供了丰富的功能和可定制选项。 细粒度和颗粒度的分词模式选择。 可自定义词典,提高分词准确性。 支持中文

-

Elasticsearch分词详解:ES分词介绍、倒排索引介绍、分词器的作用、停用词

详见:https://blog.csdn.net/weixin_40612128/article/details/123476053

-

【ElasticSearch】分词器(ElasticSearchIK分词器)

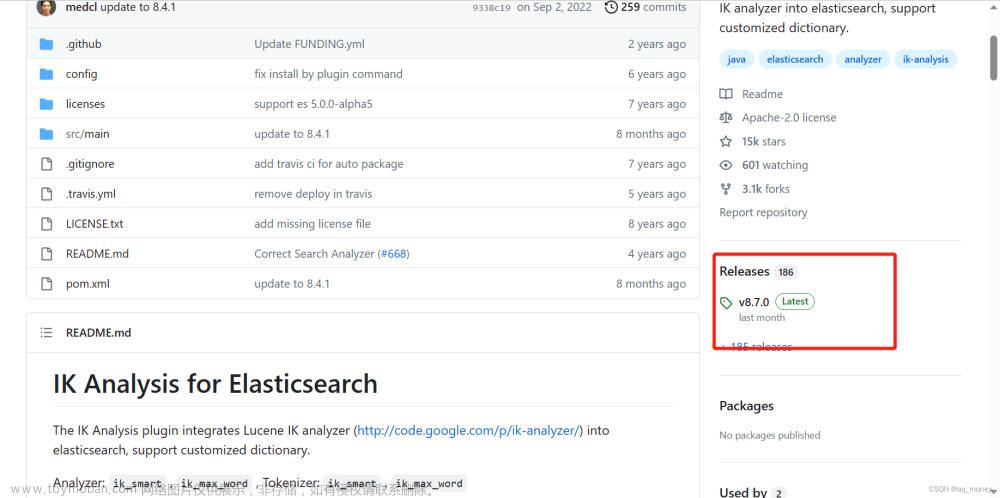

•IKAnalyzer 是一个开源的,基于java语言开发的轻量级的中文分词工具包 •是一个基于Maven构建的项目 •具有60万字/秒的高速处理能力 •支持用户词典扩展定义 IK 分词器安装 IK分词器有两种分词模式:ik_max_word 和 ik_smart 模式。 1、 ik_max_word 会将文本做最细粒度的拆分,比如会

-

ElasticSearch-使用IK分词器进行分词

使用KIbana测试IK分词器 打开开发工具台 ik_smart 最少分词器 分词结果比较少 ik_max_word 颗粒度最细分词器 分词结果比较多,组成各种结果,穷尽词库的可能! 再看个例子,把我们的句子换成 超级喜欢魏一鹤学习Java 首先看最少分词 然后是最细颗粒度分词 问题来了 我们输入超级喜

-

ES自定义分词,对数字进行分词

需求:需要将下面类似的数据分词为:GB,T,32403,1,2015 我们使用的Unicode进行正则匹配,Unicode将字符编码分为了七类,其中 P代表标点 L 代表字母 Z 代表分隔符(空格,换行) S 代表数学符号,货币符号 M代表标记符号 N 阿拉伯数字,罗马数字 C其他字符 例如:所以pP的作用是匹配

-

es自定义分词器对数字分词

背景:就是一个搜索框,可以输入产品名称、产品code、产品拼音、产品缩写等内容来查询。 问题:就是像产品code这种,比如00034,分词完还是00034,直接查询00是查不到的。 一开始的方案一,就是multi_match产品名称、产品缩写这些,然后前缀查询产品code,然后再should一下。但

-

强大的中文分词器--结巴分词(java版)

原生jieba分词是强大的Python组件,可以用来进行提取,标注以及定位。 精确模式:试图将句子最精确地切开,适合文本分析; 全模式:把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义; 搜索引擎模式:在精确模式的基础上,对长词再次切分

-

详细介绍NLP中文分词原理及分词工具

正向最大匹配算法FMM 从左到右扫描文本,得到词的最大匹配。 案例分析: 用正向最大匹配法对“秦皇岛今天晴空万里”进行中文分词,见下表。 词典 :“秦皇岛”“岛”“今天”“天晴”“晴空万里”“万里”…… 根据当前词典,单词扫描的最大长度 max=4 正向最大匹配函

-

自定义分词器:ElasticSearch自定义分词器

自定义分词器:ElasticSearch自定义分词器 ElasticSearch是一个开源的搜索和分析引擎,它提供了实时的、可扩展的、高性能的搜索功能。ElasticSearch使用Lucene库作为底层搜索引擎,它提供了强大的文本分析和搜索功能。在ElasticSearch中,分词器是将文本拆分为单词的过程,它是搜索

-

结巴分词-强大的中文分词器实践(java版)

原生jieba分词是强大的Python组件,可以用来进行提取,标注以及定位。 精确模式:试图将句子最精确地切开,适合文本分析; 全模式:把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义; 搜索引擎模式:在精确模式的基础上,对长词再次切分

-

Jieba分词统计词频及自定义分词词典

统计词频的测试文本如下: 编写代码 运行代码查看统计结果 2.1 创建词典 首先我们创建一个 user_dict.txt 文本文件,在文件中添加我们需要的词典,如下所示: 2.2 编写代码 接着我们编写代码进行词典的测试,测试的文本如下: 首先我们 不导入 自定义的分词词典,看看分词

-

Elasticsearch分词器--空格分词器(whitespace analyzer)

文本分析,是将全文本转换为一系列单词的过程,也叫分词。analysis是通过analyzer(分词器)来实现的,可以使用Elasticearch内置的分词器,也可以自己去定制一些分词器。除了在数据写入时将词条进行转换,那么在查询的时候也需要使用相同的分析器对语句进行分析。 分词器

-

es自定义分词器支持数字字母分词,中文分词器jieba支持添加禁用词和扩展词典

自定义分析器,分词器 所有字段检索 高亮搜索 分词测试 GET /test_index/_analyze jieba中文分词支持添加禁用词和扩展词库功能 创建索引:PUT http://xxxx:9200/test_index 分词测试: GET http://xxxxxx:9200/test_index/_analyze

-

本地elasticsearch中文分词器 ik分词器安装及使用

ElasticSearch 内置了分词器,如标准分词器、简单分词器、空白词器等。但这些分词器对我们最常使用的中文并不友好,不能按我们的语言习惯进行分词。 ik分词器就是一个标准的中文分词器。它可以根据定义的字典对域进行分词,并且支持用户配置自己的字典,所以它除了可