-

Python爬虫基础:使用requests模块获取网页内容

了解如何使用Python中的requests模块进行网页内容获取,包括获取网页步骤、代码实现、状态码查看、提取信息等。

-

Python爬虫基础:使用requests模块获取网页内容

了解如何使用Python中的requests模块进行网页内容获取,包括获取网页步骤、代码实现、状态码查看、提取信息等。

-

快乐学Python,数据分析之使用爬虫获取网页内容

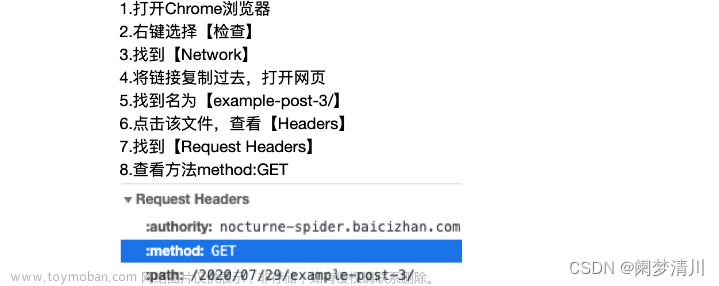

在上一篇文章中,我们了解了爬虫的原理以及要实现爬虫的三个主要步骤:下载网页-分析网页-保存数据。 下面,我们就来看一下:如何使用Python下载网页。 浏览器画网页的流程,是浏览器将用户输入的网址告诉网站的服务器,然后网站的服务器将网址对应的网页返回给浏览

-

Python实现获取网页内容及自动填表单与登录功能

这篇文章主要为大家详细介绍了如何利用Python实现模拟浏览器启动,获取网页内容、自动填表单、自动登录、自动过验证码等功能,需要的可以参考一下 库 源码 知识点补充 食用前准备 python 3.10.10 #二维码的库ddddocr 需要 下面为大家介绍一下文中用到的ddddocr库的相关使用吧

-

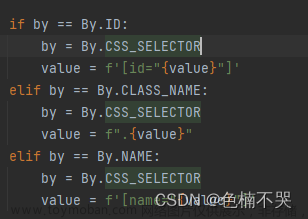

一个月学通Python(三十四):使用Selenium模拟人工操作及获取网页内容

结合自身经验和内部资料总结的Python教程,每天3-5章,最短1个月就能全方位的完成Python的学习并进行实战开发,学完了定能成为大佬!加油吧!卷起来! 全部文章请访问专栏:《Python全栈教程(0基础)》 再推荐一下最近热更的:《大厂测试高频面试题详解》 该专栏对近年

-

python通过selenium爬取网页信息,python获取浏览器请求内容,控制已经打开的浏览器

背景:通过python中直接get或者urlopen打开一些有延迟加载数据的网页,会抓取不到部分信息。 1. 命令行打开chrome,并开启调试端口 (前提,找到chrome安装目录,找到chrome.exe所在路径,添加到环境变量中,例如我的是C:Program FilesGoogleChromeApplication) remote-debugging-port指定远程调试

-

爬虫:使用Selenium模拟人工操作及获取网页内容

结合自身经验和内部资料总结的Python教程,每天3-5章,最短1个月就能全方位的完成Python的学习并进行实战开发,学完了定能成为大佬!加油吧!卷起来! 全部文章请访问专栏:《Python全栈教程(0基础)》 再推荐一下最近热更的:《大厂测试高频面试题详解》 该专栏对近年

-

爬虫(三):使用Selenium模拟人工操作及获取网页内容

结合自身经验和内部资料总结的Python教程,每天3-5章,最短1个月就能全方位的完成Python的学习并进行实战开发,学完了定能成为大佬!加油吧!卷起来! 全部文章请访问专栏:《Python全栈教程(0基础)》 再推荐一下最近热更的:《大厂测试高频面试题详解》 该专栏对近年

-

requests或selenium获取网页内容不全问题(非异步加载)

最近用python做脚本的时候,发现了一个问题,就是获取的网页并不全。可能原因之一是页面内容过大,无法加载全部到内存中 下面的解决方法只针对静态加载页面(有的网页是动态加载数据,需要查看对应的js请求或者用selenium来获取就好)。 解决方法为放入文件里,再读取

-

可以这样获取网页中的canvas内容,并且以图片的形式保存在本地

1.获取canvas元素。我们可以使用JavaScript的document.getElementById()或document.querySelector()方法来获取canvas元素。 2.获取canvas的绘图上下文。我们可以使用canvas.getContext()方法获取canvas的绘图上下文。 3.使用toDataURL()方法将canvas内容转换为图片的base64编码。该方法接受一个参数,用于指定

-

使用Python和Selenium抓取网页内容

采集动态网页是困扰许多人的难题,不妨使用 Python 和 Selenium抓取网页数据。 微信搜索关注《Python学研大本营》,加入读者群,分享更多精彩 你是否对从网站提取数据感兴趣,但发现自己被网络抓取的复杂性所困扰?不要害怕,我们在这篇文章中将展示如何利用 Selenium 和

-

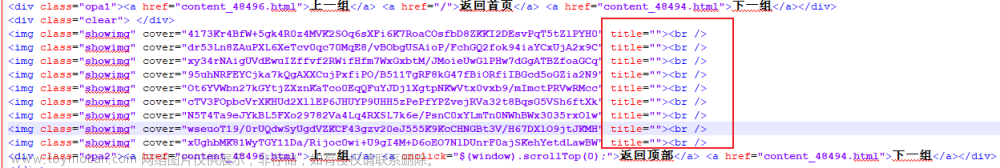

Python爬取网页Flex渲染的动态内容

我最近使用Python爬取网页内容时遇到Flex渲染的动态页面,比如下图的课程目录标题,此时按鼠标右键,菜单里没有复制链接的选项。 我的目的是:获取各个视频标题、链接。 按F12进入开发者模式分析网页,可见有多个flex标签,像这种通过flex动态渲染的网页,视频链接隐藏

-

Python用selenium采集网页内容被屏蔽了

如果在使用Selenium访问某个网页时,你发现页面被屏蔽或出现了类似于“检测到自动化软件,请手动操作”的提示,这通常是因为该网站有反爬策略,用于检测和阻止自动化工具的访问。以下是一些可能帮助你绕过这些反爬策略的方法: 1、使用无头浏览器(Head

-

Python使用Selenium Webdriver爬取网页所有内容

有时候,我们在用urllib或者requests库抓取页面时,得到的html源代码和浏览器中看到的不一样。这将是我们面临的一个非常常见的问题。现在网页越来越多地采用Ajax、前端模块化工具来构建,整个网页可能都是由JavaScript渲染出来的,也就是说原始的HTML代码可能就是一个空壳,

-

100天玩转python——day67 使用Selenium抓取网页动态内容

根据权威机构发布的全球互联网可访问性审计报告,全球约有四分之三的网站其内容或部分内容是通过JavaScript动态生成的,这就意味着在浏览器窗口中“查看网页源代码”时无法在HTML代码中找到这些内容,也就是说我们之前用的抓取数据的方式无法正常运转了。解决这样的