-

PySpark大数据教程:深入学习SparkCore的RDD持久化和Checkpoint

本教程详细介绍了PySpark中SparkCore的RDD持久化和Checkpoint功能,重点讲解了缓存和检查点的作用、如何进行缓存、如何设置检查点目录以及它们之间的区别。还提供了join操作的示例和Spark算子补充知识。

-

【Spark】Spark的常用算子

Spark的常用算子 Spark 内置算子是指 Spark 提供的具有高性能、高效率和高可靠性的数据操作函数。Spark 内置算子可以帮助我们完成大量的数据预处理、处理和分析任务。其主要包括以下 4 类算子: 转换算子(Transformation):用于将一个 RDD 转换为另一个 RDD,常见的有 map、flat

-

Spark---RDD算子(单值类型转换算子)

RDD算子是用于对RDD进行转换(Transformation)或行动(Action)操作的方法或函数。通俗来讲,RDD算子就是RDD中的函数或者方法,根据其功能,RDD算子可以分为两大类: 转换算子(Transformation): 转换算子用于从一个RDD生成一个新的RDD,但是原始RDD保持不变。常见的转换算子包括

-

Spark中Rdd算子和Action算子--学习笔记

filter distinct groupBy groupByKey,sortBy,SortByKey rdd之间的连接 collect,take,count()类的聚合算子,saveAsTextFile, 统计算子,countByKey() countByKey().items() countByValue() , countByValue().items() 词频统计 缓存是将数据存储再内存或者磁盘上,缓存的特点是计算结束后缓存自动清空 为什么使用缓存? 提升

-

spark-常用算子

这种变换并不触发提交作业,这种算子是延迟执行的,也就是说从一个RDD转换生成另一个RDD的转换操作不是马上执行,需要等到有Action操作的时候才会真正触发。 这种变换并不触发提交作业,针对处理的数据项是Value型的数据 (1)输入分区与输出分区一对一型: 1.map算子 处

-

【Spark】RDD转换算子

目录 map mapPartitions mapPartitionsWithIndex flatMap glom groupBy shuffle filter sample distinct coalesce repartition sortBy ByKey intersection union subtract zip partitionBy reduceByKey groupByKey reduceByKey 和 groupByKey 的区别 aggregateByKey foldByKey combineByKey reduceByKey、foldByKey、aggregateByKey、combineByKey 的区别 join leftOuterJoin

-

2023_Spark_实验十二:Spark高级算子使用

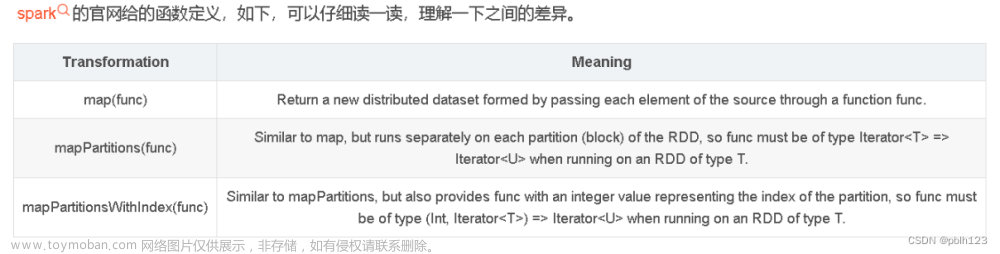

掌握Spark高级算子在代码中的使用 相同点分析 三个函数的共同点,都是Transformation算子。惰性的算子。 不同点分析 map函数是一条数据一条数据的处理,也就是,map的输入参数中要包含一条数据以及其他你需要传的参数。 mapPartitions函数是一个partition数据一起处理,也即是说,

-

Spark-Core核心算子

1、Spark简介 2、Spark-Core核心算子 3、Spark-Core 4、SparkSQL 1、从集合中获取 2、从外部存储系统创建 3、从其它RDD中创建 在其它执行步骤完成后,生成新的RDD对象 4、分区规则—load数据时 从集合中创建 从文件中创建 1、Value类型 1.1 map()_ 1.2 mapPartitions() 以分区为单位执行的 map() 1

-

Spark算子-Scala版本 头歌答案

第1关 Spark算子--Scala版本 编程要求 根据提示,在右侧编辑器 begin-end 处补充代码,输出每个元素及其长度并去重。 测试说明 平台会对你编写的代码进行测试: 预期输出: 开始你的任务吧,祝你成功! 第2关:转换算子之flatMap和filter算子 编程要求 根据提示,在右侧编辑器

-

Spark中RDD的Transformation算子

map算子的功能为做映射,即将原来的RDD中对应的每一个元素,应用外部传入的函数进行运算,返回一个新的RDD flatMap算子的功能为扁平化映射,即将原来RDD中对应的每一个元素应用外部的运算逻辑进行运算,然后再将返回的数据进行压平,类似先map,然后再flatten的操作,最后

-

横扫Spark之 - 9个常见的行动算子

水善利万物而不争,处众人之所恶,故几于道💦 1. collect() 收集RDD每个分区的数据以数组封装之后发给Driver 如果RDD数据量比较大,Driver内存默认只有1G,可能出现内存溢出,工作中一般需要将Driver内存设置为5-10G。可以通过 bin/spark-submit --driver-memory 10G 这样设置 结果

-

Spark源码解析(一):RDD之Transfrom算子

RDD 代表的是分布式数据形态,因此,RDD 到 RDD 之间的转换,本质上是数据形态上的转换(Transformations) 在 RDD 的编程模型中,一共有两种算子,Transformations 类算子和 Actions 类算子。开发者需要使用 Transformations 类算子,定义并描述数据形态的转换过程,然后调用 Actions 类算子

-

2023_Spark_实验十:RDD基础算子操作

Ø练习 1: Ø 练习 2: Ø 练习 3: Ø 练习 4: Ø 练习 5: groupByKey groupByKey会将RDD[key,value]按照相同的key进行分组,形成RDD[key,iterable[value]]的形式,有点类似于sql中的groupby,例如类似于mysql中的group_contact cogroup groupByKey是对单个RDD的数据进行分组,还可以使用一个叫作cogroup()的函

-

2023_Spark_实验十一:RDD高级算子操作

coalesce : 总所周知,spark的rdd编程中有两个算子repartition和coalesce。公开的资料上定义为,两者都是对spark分区数进行调整的算子。 repartition会经过shuffle,其实际上就是调用的coalesce(shuffle=true)。 coalesce,默认shuffle=false,不会经过shuffle。 当

-

spark之action算子学习笔记(scala,pyspark双语言)

函数签名:def collect(): Array[T] 功能说明:收集每个分区数据,以数组Array的形式封装后发给driver。设置driver内存:bin/spark-submit --driver-memory 10G(内存大小) 注意:collect会把所有分区的数据全部拉取到driver端,如果数据量过大,可能内存溢出。 图1 结果 图2 结果 返回RDD中元素的