VicWord - 纯 PHP 分词工具:高效、灵活的中文文本分词解决方案

VicWord 是一款由开发者 lizhichao 创建并维护的高效、灵活的纯 PHP 分词库。它旨在为 PHP 开发者提供快速、准确的中文文本分词解决方案。本文将详细介绍 VicWord 的特点、技术分析以及常见应用场景。

中文分词入门:使用IK分词器进行文本分词(附Java代码示例)

中文分词是将连续的中文文本切分成一个个独立的词语的过程,是中文文本处理的基础。IK分词器是一个高效准确的中文分词工具,采用了\\\"正向最大匹配\\\"算法,并提供了丰富的功能和可定制选项。 细粒度和颗粒度的分词模式选择。 可自定义词典,提高分词准确性。 支持中文

Python文本分析之中文分词(jieba库)

(1)全自动安装 (2)半自动安装 首先登入https://pypi.org/project/jieba/下载安装包 最后解压安装包: python setup py install (3)手动安装 首先登入https://pypi.org/project/jieba/下载安装包 最后把jieba目录放置在site-packages目录内 语法: jieba.cut(sentence, cut_all=False, HMM=True, use_paddle=False) 功能

文本分析-使用jieba库进行中文分词和去除停用词(附案例实战)

🤵♂️ 个人主页:@艾派森的个人主页 ✍🏻作者简介:Python学习者 🐋 希望大家多多支持,我们一起进步!😄 如果文章对你有帮助的话, 欢迎评论 💬点赞👍🏻 收藏 📂加关注+ 中文分词是将中文文本切分成一系列有意义的词语的过程。中文分词可以用于

强大的中文分词器--结巴分词(java版)

原生jieba分词是强大的Python组件,可以用来进行提取,标注以及定位。 精确模式:试图将句子最精确地切开,适合文本分析; 全模式:把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义; 搜索引擎模式:在精确模式的基础上,对长词再次切分

详细介绍NLP中文分词原理及分词工具

正向最大匹配算法FMM 从左到右扫描文本,得到词的最大匹配。 案例分析: 用正向最大匹配法对“秦皇岛今天晴空万里”进行中文分词,见下表。 词典 :“秦皇岛”“岛”“今天”“天晴”“晴空万里”“万里”…… 根据当前词典,单词扫描的最大长度 max=4 正向最大匹配函

结巴分词-强大的中文分词器实践(java版)

原生jieba分词是强大的Python组件,可以用来进行提取,标注以及定位。 精确模式:试图将句子最精确地切开,适合文本分析; 全模式:把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义; 搜索引擎模式:在精确模式的基础上,对长词再次切分

本地elasticsearch中文分词器 ik分词器安装及使用

ElasticSearch 内置了分词器,如标准分词器、简单分词器、空白词器等。但这些分词器对我们最常使用的中文并不友好,不能按我们的语言习惯进行分词。 ik分词器就是一个标准的中文分词器。它可以根据定义的字典对域进行分词,并且支持用户配置自己的字典,所以它除了可

Elasticsearch 中文分词器

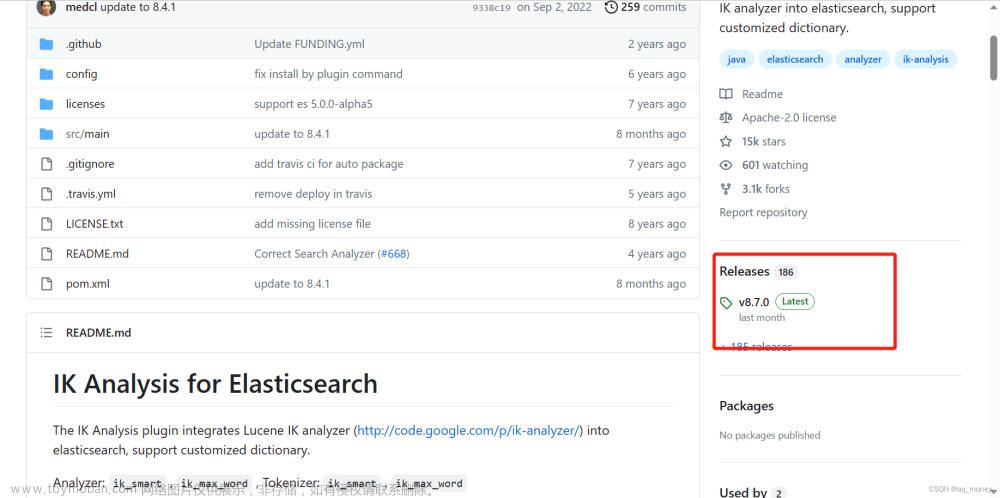

我们在ES中最常用的中文分词器就是IK分词器,其项目地址为:https://github.com/medcl/elasticsearch-analysis-ik 下载地址: https://github.com/medcl/elasticsearch-analysis-ik/releases 下载时注意和es的版本对应,我们es版本为:8.6.2。所以我们下载 elasticsearch-analysis-ik-8.6.2.zip 解压包内容如下: 在ES

【Solr】中文分词配置

提示:在设置中文分词前需确保已经生成过core,未生成core的可以使用: solr create -c \\\"自定义名称\\\" 进行定义。 未分词前的效果预览: 下载分词器: 下载地址: https://mvnrepository.com/artifact/com.github.magese/ik-analyzer/8.3.0 或者通过 maven 更新下载 复制jar包 把下载好的jar包放到以下目录

【ElasticSearch】中文分词器

ES默认的analyzer(分词器),对英文单词比较友好,对中文分词效果不好。不过ES支持安装分词插件,增加新的分词器。 1、如何指定analyzer? 默认的分词器不满足需要,可以在定义索引映射的时候,指定text字段的分词器 例子: 只要在定义text字段的时候,增加一个analyzer配置

Python结巴中文分词笔记

🌐 jieba库概述 Jieba是一个流行的中文分词库,它能够将中文文本切分成词语,并对每个词语进行词性标注。中文分词是自然语言处理的重要步骤之一,它对于文本挖掘、信息检索、情感分析等任务具有重要意义。 💡 jieba分词的原理 jieba分词的原理是基于统计和规则的混合分

中文分词和tfidf特征应用

中文分词和TF-IDF(Term Frequency-Inverse Document Frequency)是自然语言处理(NLP)中的两个基础技术。 中文分词 因为中文文本没有明显的单词分隔符,所以需要进行分词。常用的分词算法有: 基于词典的分词:最长匹配算法、正向最大匹配、逆向最大匹配等。 基于统计的分词:隐

ElasticSearch中文分词和模糊查询

ElasticSearch是一个一个分布式的实时文档存储,每一个字段都可以被索引与搜索,并且能支持PB级别的结构化或者非结构化数据。早期我们应用的全局搜索是简单的SQL模糊查询,为了分担数据库压力所以用了ES,选择他的原因除了以上几点外,还有其提供的API方式简单

Elasticsearch之ik中文分词篇

es在7.3版本已经支持中文分词,由于中文分词只能支持到单个字进行分词,不够灵活与适配我们平常使用习惯,所以有很多对应中文分词出现,最近使用的是ik分词器,就说说它吧。 安装可以百度下有很多教程,需要注意的是ik分词器的版本要跟es版本对应上,避免出现不必要