-

使用Python和Selenium库实现自动化网络爬虫

本文将详细介绍如何使用Python和Selenium库实现自动化网络爬虫。我们将以驱动谷歌Chrome浏览器为例,演示如何打开特定网页并从中提取所需的数据。文章将逐步介绍必要的库和工具的安装,导入所需的模块,创建浏览器实例,定位和提取数据,处理和使用数据,以及关闭浏览器实例。 提供了完整的示例代码和详细步骤,使读者能够快速上手和理解自动化网络爬虫的实现过程。

-

网络请求爬虫【requests】和自动化爬虫【selenium】

在Python开发的爬虫项目中, requests 和 selenium 是两个常用的库,它们各有特点和应用场景。 相同点 数据抓取: 无论是 selenium 还是 requests ,两者的基本目的都是为了从网络上抓取数据。 自动化: 它们都能够自动化地访问网页,获取需要的信息。 不同点 工作原理: requests 直

-

Python从入门到网络爬虫、自动化

可以创建C++、C#、Python、Golang、Java、React、Node、Vue、PHP项目 创建Java项目 创建Python项目 简单if……else……语句 Python从入门到精通

-

Python实验项目9 :网络爬虫与自动化

实验 1:爬取网页中的数据。 要求:使用 urllib 库和 requests 库分别爬取 http://www.sohu.com 首页的前 360 个字节的数据。 实验 2 :测试 BeautifulSoup 对象的方法。 要求: 1)创建 BeautifulSoup 对象。 2)测试搜索文档树的 find_all() 方法和 find()方法。 实验 3:爬取并分

-

爬虫 — 自动化爬虫 Selenium

用 Selenium 爬取网页时,当前访问的 url 就是爬虫当中的目标 url,获取内容只要是页面上可见的,都可以爬取( 可见即可爬 )。 步骤 Selenium + 浏览器 + 浏览器驱动 1、导入 2、url(找动态 url,抓取到的数据是加密的) 3、获取内容,做解析 Selenium 是一个用于 Web 应用 程序测试

-

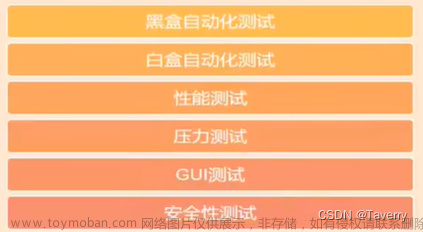

自动化测试介绍、selenium用法(自动化测试框架+爬虫可用)

1、什么是自动化测试? 程序测试程序、代码代替思维、脚本代替人工 核心:质量和效率 作用:降低成本、节省人力时间、推动CI和DevOps、准确性和可靠性、模拟人工难以实现的手段、快速持续迭代发布能力、衡量产品的质量、提升测试效率、提高测试覆盖率 2、手工测试

-

爬虫-9-selenium自动化

#所谓自动化,就是模拟人。去操作... #自动化需要浏览器驱动器,那么这个浏览器需要停止一下自动更新(减少麻烦)。 #以下都以谷歌浏览器为例。 #谷歌浏览器禁止更新详见: https://blog.csdn.net/weixin_48337566/article/details/123242827

-

python自动化爬虫实战

偶然的一次机会再次用到爬虫,借此机会记录一下爬虫的学习经历,方便后续复用。 需求:爬取网站数据并存入的csv文件中,总体分为两步 爬取网站数据 存到到csv文件中 1、配置爬虫环境 1.1、下载自动化测试驱动 由于需要实现模拟手动点击浏览器的效果,因此笔者使用到了

-

python爬虫(七)--------selenium自动化

查找方法(python3.7之前版本) find_element_by_id 根据id属性来定位 find_element_by_name 根据name元素来定位 find_element_by_xpath 根据xpath语法来定位 find_element_by_tag_name 根据标签名来定位 find_element_by_class_name 根据class的名字来定位 find_element_by_css_selector 根据css选择器来定位 以下两种方法都

-

爬虫-selenium自动化(3)-验证码

#验证码分很多种,奇葩也无处不在:哪个是真茅台,红绿灯,摩托车......(我是个人都看不出来) (๑ó﹏ò๑) #本节内容为selenium自动化实现验证码通过-------字符验证码,点触验证码。

-

使用Selenium模块编写自动化爬虫程序

使用Selenium模块编写自动化爬虫程序可以实现更复杂的爬取操作,模拟浏览器的行为。以下是关于使用Selenium模块编写自动化爬虫程序的总结: 模拟浏览器行为:Selenium模块可以模拟浏览器的行为,如点击按钮、填写表单、滚动页面等。这使得爬虫可以处理需要交互操作或动态

-

ChatGPT实战100例 - (04) 自动化爬虫

需求 :解析网页元素太复杂,要让他自动解析 操作步骤 : ChatGPT编写相关脚本 python跑起来 需要的前置技能: 听说过 python爬虫库requests和bs4 没听过?简单: requests是一个Python HTTP请求库,用于获取网页数据。 bs4是BeautifulSoup的缩写,是一个HTML/XML解析库,用于从网页数据中提取信

-

【0基础学爬虫】爬虫基础之自动化工具 Selenium 的使用

大数据时代,各行各业对数据采集的需求日益增多,网络爬虫的运用也更为广泛,越来越多的人开始学习网络爬虫这项技术,K哥爬虫此前已经推出不少爬虫进阶、逆向相关文章,为实现从易到难全方位覆盖,特设【0基础学爬虫】专栏,帮助小白快速入门爬虫,本期为自动化

-

【0基础学爬虫】爬虫基础之自动化工具 Pyppeteer 的使用

大数据时代,各行各业对数据采集的需求日益增多,网络爬虫的运用也更为广泛,越来越多的人开始学习网络爬虫这项技术,K哥爬虫此前已经推出不少爬虫进阶、逆向相关文章,为实现从易到难全方位覆盖,特设【0基础学爬虫】专栏,帮助小白快速入门爬虫,本期为自动化

-

【0基础学爬虫】爬虫基础之自动化工具 Playwright 的使用

大数据时代,各行各业对数据采集的需求日益增多,网络爬虫的运用也更为广泛,越来越多的人开始学习网络爬虫这项技术,K哥爬虫此前已经推出不少爬虫进阶、逆向相关文章,为实现从易到难全方位覆盖,特设【0基础学爬虫】专栏,帮助小白快速入门爬虫,本期为自动化