在数据驱动决策的世界中,ETL(提取、转换、加载)流程发挥着关键作用。数据的有效管理和转换对于确保企业能够根据准确且相关的信息做出明智的选择至关重要。数据湖已成为存储和分析大量数据的强大方式,而 Apache NiFi 是用于简化数据湖环境中的 ETL 流程的强大工具。

了解数据湖 ETL

在深入研究 Apache NiFi 之前,我们先澄清一下 ETL 在数据湖中的含义。

数据湖:它们是什么?

数据湖是用于存储大量结构化和非结构化数据的存储库。与传统数据库不同,数据湖不需要在存储数据之前预先构造数据。这使得数据湖适合存储原始的、多样化的数据,然后可以根据需要进行处理和分析。

数据湖中的 ETL

ETL 代表提取、转换、加载。这个过程涉及:

从各种来源提取数据

转换数据以使其适合分析

将转换后的数据加载到数据湖中

ETL 对于确保数据湖中的数据干净、一致且可供分析至关重要。

数据湖 ETL 的挑战

由于以下几个原因,在数据湖中处理 ETL 过程可能具有挑战性:

数据多样性:数据湖存储不同的数据类型,包括结构化和非结构化数据,必须对这些数据进行不同的转换和处理。

数据量:数据湖处理大量数据,通常在 PB 范围内,因此高效的数据移动和处理至关重要。

数据速度:数据不断地被引入数据湖,ETL 流程必须跟上这种快速的数据流。

数据质量:确保数据质量至关重要,因为质量差的数据可能会导致不准确的见解。

Apache NiFi简介

Apache NiFi 是一种开源数据集成工具,提供强大且用户友好的方式来设计数据流。由于其灵活性、可扩展性和数据来源功能,它非常适合数据湖中的 ETL 流程。

Apache NiFi 的主要特点

用户友好的界面:NiFi 提供拖放界面,技术用户和非技术用户都可以使用它。

数据来源:NiFi 跟踪数据从源到目的地的旅程,使您能够跟踪数据沿袭并监控数据质量。

可扩展性:NiFi可以水平扩展以处理大数据量,并且专为高可用性而设计。

为什么选择 Apache NiFi 进行数据湖 ETL?

NiFi 的灵活性和多功能性使其成为数据湖 ETL 的绝佳选择:

它支持各种数据源和目标,包括Hadoop HDFS、AWS S3、Azure Data Lake Store 等。

其数据转换功能使您能够实时处理数据。

内置安全功能可确保数据在 ETL 过程中受到保护。

设置 Apache NiFi

让我们开始为您的数据湖 ETL 设置 Apache NiFi。

1. 安装

您可以从官方网站下载 Apache NiFi。请遵循适合您的特定环境的安装说明,无论是在本地还是在云中。确保满足系统要求并安装任何必要的依赖项。

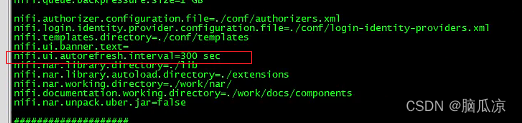

2. 配置

安装后,您需要配置 NiFi 以满足您的需求。这涉及定义数据源、配置处理器以及设置组件之间的连接。

NiFi 界面直观且用户友好。您将通过将处理器拖到画布上并连接它们来定义数据流来创建数据流。

使用 NiFi 构建 ETL 工作流程

现在,让我们探索如何使用 Apache NiFi 构建 ETL 工作流程。

创建数据管道

要在 NiFi 中创建 ETL 工作流程,请按照以下步骤操作:

定义数据源和目的地。

添加处理器来执行数据提取、转换和加载。

连接处理器以定义数据流。

例如,您可以设置一个数据管道,从 FTP 服务器提取数据,将其转换为结构化格式,然后将其加载到数据湖中。

数据转换

NiFi提供了各种用于数据转换的处理器,包括:

ConvertRecord:将数据从一种格式转换为另一种格式。

SplitText:将文本数据拆分为单独的记录。

MergeContent:将多个记录合并到一个数据流文件中。

通过配置这些处理器,您可以定制数据转换以满足您的特定 ETL 要求。

数据摄取和加载

NiFi 支持多种数据目的地。您可以轻松配置处理器以将数据发送到 Hadoop HDFS、AWS S3 等云存储服务、数据库或其他数据湖存储平台。这种灵活性使您能够根据数据湖的要求调整 ETL 流程。

数据湖集成

Apache NiFi 的优势之一是它与各种数据湖平台的无缝集成。

Hadoop HDFS 集成

将 NiFi 与 Hadoop HDFS 集成:

配置PutHDFS处理器以定义目标目录并设置 Hadoop 连接属性。

您还可以使用ListHDFS处理器从 HDFS 检索文件列表。

AWS S3 集成

对于与 AWS S3 集成:

配置PutS3Object处理器以指定 S3 存储桶、密钥和访问凭据。

该GetS3Object处理器可用于从 S3 检索对象。

Azure 数据湖存储集成

要将 NiFi 连接到 Azure Data Lake Store:

PutAzureDataLakeStore使用 Azure Data Lake Store 凭据和目标路径配置处理器。

使用FetchAzureDataLakeStore处理器从数据湖检索数据。

这种灵活性使您能够将 NiFi 与您选择的数据湖平台无缝集成。

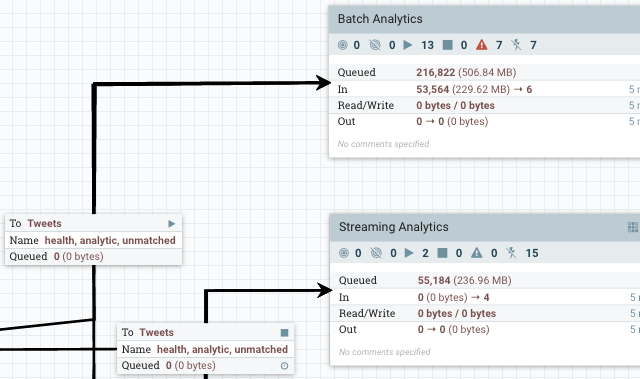

监控与管理

Apache NiFi 提供了用于监控和管理 ETL 流程的工具。

数据来源

NiFi 中的数据来源是一项强大的功能,可让您跟踪数据的旅程。它记录数据流文件上的所有操作,帮助您跟踪数据的来源并识别 ETL 管道中的任何问题。

日志记录和警报

NiFi 提供广泛的日志记录功能,这对于故障排除至关重要。您可以设置警报和通知,以了解 ETL 流程中的任何错误或问题。

性能优化

优化 ETL 性能对于数据湖运营至关重要。

负载均衡

对于高数据量,请考虑在多个 NiFi 实例之间设置负载平衡。这有助于分配工作负载并确保更好的性能和容错能力。

聚类

NiFi 可以在集群设置中进行配置,提供可扩展性和高可用性。在集群中,NiFi 实例协同工作来管理数据流并提供冗余。

资源分配

合理分配系统资源(CPU、内存、网络带宽),保证NiFi能够高效处理数据。资源分配可确保您的 ETL 工作流程顺利运行并满足数据湖的性能需求。

安全和数据治理

在数据湖环境中,安全性和数据治理至关重要。Apache NiFi 提供确保数据保护和合规性的功能。

1. 数据加密

NiFi 支持静态和传输中的数据加密。您可以配置SSL/TLS以保护在组件之间传输的数据,从而确保数据的机密性和完整性。

2. 认证与授权

NiFi允许您设置用户身份验证和授权,确保只有授权用户才能访问和修改ETL流程。这对于维护数据安全和遵守数据治理法规至关重要。

3. 数据沿袭和审计

借助 NiFi 的数据来源和审核功能,您可以跟踪对数据采取的每项操作。此审计跟踪有助于遵守数据治理要求并提供数据管理的透明度。

现实世界的用例

为了说明 Apache NiFi 在简化数据湖 ETL 方面的实际应用,让我们探讨几个实际用例。

用例 1:电子商务数据处理

想象一下,一家电子商务公司收集了大量的客户数据,包括浏览历史记录、购买记录和客户评论。这些数据需要被提取到数据湖中,转换为结构化格式,然后加载以进行分析。

通过实施 Apache NiFi,该公司可以创建 ETL 管道,从各种来源提取数据,对其进行转换以满足分析要求并将其加载到数据湖中。NiFi的实时处理能力确保最新数据可供分析。

用例 2:金融服务

金融服务机构处理源源不断的金融交易、客户记录和市场数据。有效处理这些数据并使其可用于风险评估和合规报告至关重要。

使用 Apache NiFi,该机构可以创建连续摄取和处理这些数据的 ETL 工作流程。数据经过转换、丰富并加载到数据湖中,提供实时见解并确保遵守财务法规。

在这两个用例中,Apache NiFi 的灵活性、可扩展性和数据沿袭功能使其成为处理数据湖环境中复杂 ETL 流程的理想工具。

结论

对于旨在有效利用数据的组织来说,简化数据湖中的 ETL 流程至关重要。Apache NiFi 为设计和管理数据流提供了用户友好、功能强大的解决方案,使其成为数据工程师和分析师的宝贵工具。

在本实用教程中,我们介绍了数据湖 ETL 的基础知识,介绍了 Apache NiFi,并探讨了其功能和优势。您学习了如何设置 NiFi、创建 ETL 工作流程、将其与数据湖平台集成、监控和管理 ETL 流程、优化性能以及确保数据安全和治理。

通过遵循本教程中概述的步骤,您可以利用 Apache NiFi 的功能来简化数据湖 ETL 流程,使您的数据更易于访问、更可靠,并且对于数据驱动的决策更有价值。无论您是使用小型数据湖还是管理 PB 级数据,Apache NiFi 都可以帮助您充满信心地应对数据湖 ETL 的挑战。文章来源:https://www.toymoban.com/diary/apps/499.html

文章来源地址https://www.toymoban.com/diary/apps/499.html

到此这篇关于使用 Apache NiFi 简化数据湖 ETL:实用教程的文章就介绍到这了,更多相关内容可以在右上角搜索或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!