KNN的介绍和应用

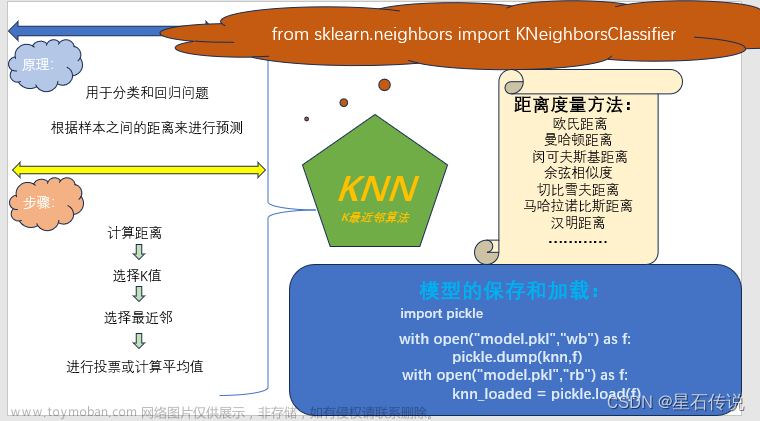

KNN(K-Nearest Neighbor)算法是一种基于实例的学习算法,也是一种常见的分类算法。

如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。

示例 :如上图,绿色圆要被决定赋予哪个类,是红色三角形还是蓝色四方形?如果K=3,由于红色三角形所占比例为2/3,绿色圆将被赋予红色三角形那个类,如果K=5,由于蓝色四方形比例为3/5,因此绿色圆被赋予蓝色四方形类。

KNN建立过程

KNN算法的工作流程如下:

-

准备训练集:我们需要有一个已标记的训练集,其中包含多个已标记的数据样本,即每个样本都有对应的类别。

-

计算相似度:对于一个未知样本,在训练集中找到与之距离最近的K个样本,通常使用欧几里得距离或曼哈顿距离等方法来计算不同样本之间的距离或相似度。一般来说,距离越近的样本在特征上是越相似的,因此被归为同一类别的概率更大。

-

进行投票:根据这K个最邻近的样本,我们可以使用多数表决的方式来预测未知样本的类别。即在这K个样本中出现次数最多的类别,就是当前未知样本所属的类别。

类别的判定

①投票决定,少数服从多数。取类别最多的为测试样本类别。

②加权投票法,依据计算得出距离的远近,对近邻的投票进行加权,距离越近则权重越大,设定权重为距离平方的倒数。

KNN算法优缺点

优点:

-

算法简单:KNN算法思路简单、实现容易,而且对于数据的分布形态没有假设条件。

-

适用于多分类问题:KNN算法可以处理多分类问题。

-

可以自适应地学习新的样本:KNN算法可以通过不断添加新的样本来自适应地学习,从而不断提高分类准确性。

缺点:

-

对数据量比较敏感:KNN算法需要计算测试样本与所有训练样本的距离,这个过程比较耗时,尤其是处理大规模的数据集时,算法效率会比较低。

-

对异常值比较敏感:KNN算法容易受到数据集中的异常值的影响,而且对异常值缺乏处理的能力。

-

需要选择好的K值:KNN算法的分类效果与K值的选择有很大关系,K值太小会导致对噪声敏感,K值太大会忽略样本之间的局部特征。因此,需要根据具体情况选择好的K值才能获得最优的分类效果。

KNN原理介绍

k近邻方法是一种惰性学习算法,可以用于回归和分类,它的主要思想是投票机制,对于一个测试实例x, 我们在有标签的训练数据集上找到和最相近的k个数据,用他们的label进行投票,分类问题则进行表决投票,回归问题使用加权平均或者直接平均的方法。knn算法中我们最需要关注两个问题:k值的选择和距离的计算。 kNN中的k是一个超参数,需要我们进行指定,一般情况下这个k和数据有很大关系,都是交叉验证进行选择,但是建议使用交叉验证的时候,k∈[2,20],使用交叉验证得到一个很好的k值。

k值还可以表示我们的模型复杂度,当k值越小意味着模型复杂度变大,更容易过拟合,(用极少数的样例来绝对这个预测的结果,很容易产生偏见,这就是过拟合)。我们有这样一句话,k值越多学习的估计误差越小,但是学习的近似误差就会增大。

KNN的应用

KNN虽然很简单,但是人们常说"大道至简",一句"物以类聚,人以群分"就能揭开其面纱,看似简单的KNN即能做分类又能做回归, 还能用来做数据预处理的缺失值填充。由于KNN模型具有很好的解释性,一般情况下对于简单的机器学习问题,我们可以使用KNN作为 Baseline,对于每一个预测结果,我们可以很好的进行解释。推荐系统的中,也有着KNN的影子。例如文章推荐系统中, 对于一个用户A,我们可以把和A最相近的k个用户,浏览过的文章推送给A。文章来源:https://www.toymoban.com/news/detail-401851.html

机器学习领域中,数据往往很重要,有句话叫做:“数据决定任务的上限, 模型的目标是无限接近这个上限”。 可以看到好的数据非常重要,但是由于各种原因,我们得到的数据是有缺失的,如果我们能够很好的填充这些缺失值, 就能够得到更好的数据,以至于训练出来更鲁棒的模型。接下来我们就来看看KNN如果做分类,怎么做回归以及怎么填充空值。文章来源地址https://www.toymoban.com/news/detail-401851.html

到了这里,关于机器学习算法:K近邻(k-nearest neighbors)初探的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!