无头模式(headless)是selenium的webdriver浏览器驱动的一项功能,允许浏览器不出现而仍可访问网页,并与之交互,这对于运行自动化测试或网络抓包大有用处,因为运行速度更快、占用资源更少。

但是笔者发现在无头模式下运行时,浏览器访问某些网站产生的cookies内容可能与在正常模式(非无头模式)下略有不同。因为某些网站使用技术来检测是否被无头浏览器访问,并可能通过设定不同的 cookie 或以其他方式表现不同来做出响应。

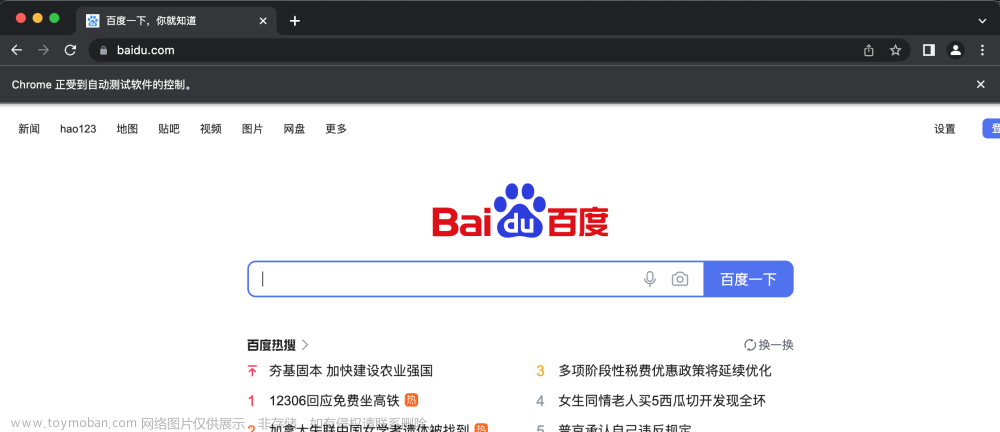

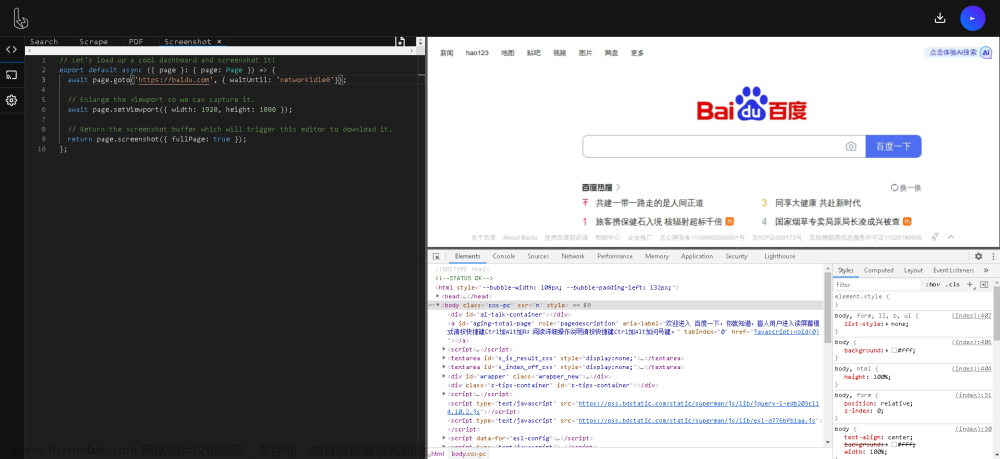

为了说明这种差异,我们可以使用 Python 中的 Selenium WebDriver 库运行一个简单的实验。 首先,我们将创建两个 Chrome 浏览器实例——一个在无头模式下,另一个在正常模式下:

from time import sleep

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

# 初始化无头模式(headless)的webdriver

options = Options()

options.add_argument('--headless')

driver_headless = webdriver.Chrome(options=options)

# 设置window.navigator.webdriver为false

driver_headless.execute_cdp_cmd("Page.addScriptToEvaluateOnNewDocument", {"source": "Object.defineProperty(navigator, 'webdriver', {get: () => False}) "})

# 打开一个网站,输出cookies

driver_headless.get('http://。。。。。。')

sleep(3)

cookies_headless = driver_headless.get_cookies()

keys_headless = set([cookie['name'] for cookie in cookies_headless])

driver_headless.quit()

# 初始化正常模式的webdriver

options2 = Options()

# 取消chrome受自动控制提示

options2.add_experimental_option('useAutomationExtension', False)

options2.add_experimental_option('excludeSwitches', ['enable-automation'])

driver_normal = webdriver.Chrome(options=options2)

# 设置window.navigator.webdriver为false

driver_normal.execute_cdp_cmd("Page.addScriptToEvaluateOnNewDocument", {"source": "Object.defineProperty(navigator, 'webdriver', {get: () => False}) "})

# 打开同一个网站,输出cookies

driver_normal.get('http://。。。。。。')

sleep(3)

cookies_normal = driver_normal.get_cookies()

keys_normal = set([cookie['name'] for cookie in cookies_normal])

driver_normal.quit()

# 两相比较

keys_only_in_headless = keys_headless - keys_normal

keys_only_in_normal = keys_normal - keys_headless

if keys_only_in_headless:

print(f'无头模式(headless)多出来的Cookie名称是: {keys_only_in_headless}')

if keys_only_in_normal:

print(f'正常模式多出来的Cookie名称是: {keys_only_in_normal}')

if not keys_only_in_headless and not keys_only_in_normal:

print('无头模式和正常模式的cookies都一样。')

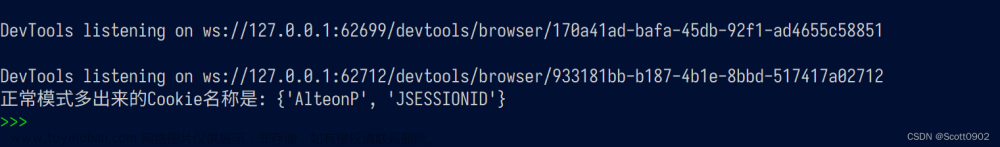

运行结果截图:

我测试了分别采用无头模式和正常模式访问同一个网站的链接,得出的cookies不一样。无头模式情况下的cookies比正常模式缺失两项内容:AlteonP、JSessionID。

我后续的操作是需要把selenium的cookies内容导出至requests库的session使用,若使用无头模式下的cookie,再用requests库的get、post访问该网站时都报错(status_code会出现400、403、412等非正常代码)。

众所周知requests库的get、post访问一个网站链接获取得到的cookies内容本来就稀缺,只有selenium的webdriver打开网站才能得到丰富的cookies,因此要从selenium的cookies导出cookies给requests库使用是非常有必要的。要让selenium的无头模式也能获取正常模式的cookies,下面是我的两个解决思路:

1、添加user-agent

在options那几行里插入下面两行代码:

user_agent = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/110.0.0.0 Safari/537.36'

options.add_argument(f'user-agent={user_agent}')

也许大家和我一样都觉得Selenium的webdriver已经自动附带user-agent而不需要重复添加。但意想不到的是,无头模式访问某些网站,网站仍会检测到selenium是在做爬虫动作,故给出的cookies内容少之又少,跟requests的get获取的cookies相差无几。所以在尝试手动添加user-agent后,无头模式获取的cookies内容变得丰富起来,这个办法看似老土,但非常管用。

2、设置浏览器窗口大小

如果第一个解决方法行不通,可试试设置浏览器窗口大小,尽管无头模式下浏览器是无形的,但也许通过设置窗口大小可以瞒过某些网站的检测。文章来源:https://www.toymoban.com/news/detail-401899.html

options.add_argument("--window-size=1920,1050") 接下来就可以导出Selenium的cookies给requests使用了。文章来源地址https://www.toymoban.com/news/detail-401899.html

from requests.cookies import RequestsCookieJar

cookies = driver.get_cookies()

jar = RequestsCookieJar()

for cookie in cookies:

jar.set(cookie['name'], cookie['value'])

se = requests.Session()

se.cookies = jar

se.headers.update({'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/110.0.0.0 Safari/537.36'})

res = se.get('http://。。。。。。', headers=headers)

assert res.status_code==200

res.encoding = 'utf-8'

print(res.text)到了这里,关于Selenium webdriver的无头模式(headless)可能导致cookies内容缺失,以及解决措施的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!