引言

主要针对显卡:nvidia

初衷:想要看某个python程序的GPU显存占用量

一、nvidia-smi

在linux下使用nvidia-smi 可以直接显示GPU使用情况1:

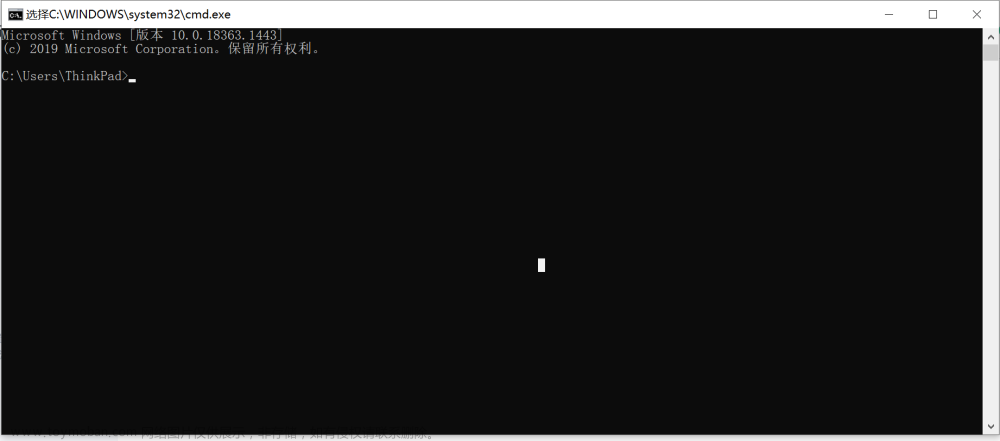

但是在windows下有的时候显示N/A (如下图所示):

未解之谜2:Windows下NVIDIA-SMI中为什么看不到GPU Memory

二、windows下的任务管理器

任务管理器也可以查看程序GPU占用信息, 点击详细信息, 看专用GPU

小知识3:专用GPU内存 vs 共享GPU内存

三、pynvml库

比较全4:python 输出 GPU内存 最大使用率

简洁仅显存5:python查看显卡gpu信息

只有输出总GPU的显存占用,并没有找到获取单个程序GPU显存占用的函数

计算单个程序占用会有误差(桌面等程序也会占用GPU,占用量是动态变化的)

四、显存不够用又没钱怎么办

减小batch、减小网络、多用pooling降低数据分辨率 – 可能会降低性能

小知识6:Pytorch节省显存小技巧

希望可以做一个不费内存速度快精度还高的实用模型

-

Linux查看GPU信息和使用情况 ↩︎

-

Windows下NVIDIA-SMI中为什么看不到GPU Memory ↩︎

-

专用GPU内存 vs 共享GPU内存 ↩︎

-

python 输出 GPU内存 最大使用率 ↩︎

-

python查看显卡gpu信息 ↩︎文章来源:https://www.toymoban.com/news/detail-404627.html

-

Pytorch节省显存小技巧 ↩︎文章来源地址https://www.toymoban.com/news/detail-404627.html

到了这里,关于python 查看程序的GPU显存占用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[NLP]LLM 训练时GPU显存耗用量估计](https://imgs.yssmx.com/Uploads/2024/02/651417-1.png)