矩阵论的所有文章,主要内容参考北航赵迪老师的课件

[注]由于矩阵论对计算机比较重要,所以选修了这门课,由于不是专业搞数学的,所以存在很多口语化描述,而且对很多东西理解不是很正确与透彻,欢迎大家指正。我可能间歇性忙,但有空一定会回复修改的。

矩阵论

1. 准备知识——复数域上矩阵,Hermite变换)

1.准备知识——复数域上的内积域正交阵

1.准备知识——Hermite阵,二次型,矩阵合同,正定阵,幂0阵,幂等阵,矩阵的秩

2. 矩阵分解——SVD准备知识——奇异值

2. 矩阵分解——SVD

2. 矩阵分解——QR分解

2. 矩阵分解——正定阵分解

2. 矩阵分解——单阵谱分解

2. 矩阵分解——正规分解——正规阵

2. 矩阵分解——正规谱分解

2. 矩阵分解——高低分解

3. 矩阵函数——常见解析函数

3. 矩阵函数——谱公式,幂0与泰勒计算矩阵函数

3. 矩阵函数——矩阵函数求导

4. 矩阵运算——观察法求矩阵特征值特征向量

4. 矩阵运算——张量积

4. 矩阵运算——矩阵拉直

4.矩阵运算——广义逆——加号逆定义性质与特殊矩阵的加号逆

4. 矩阵运算——广义逆——加号逆的计算

4. 矩阵运算——广义逆——加号逆应用

4. 矩阵运算——广义逆——减号逆

5. 线性空间与线性变换——线性空间

5. 线性空间与线性变换——生成子空间

5. 线性空间与线性变换——线性映射与自然基分解,线性变换

6. 正规方程与矩阵方程求解

7. 范数理论——基本概念——向量范数与矩阵范数

7.范数理论——基本概念——矩阵范数生成向量范数&谱范不等式

7. 矩阵理论——算子范数

7.范数理论——范数估计——许尔估计&谱估计

7. 范数理论——非负/正矩阵

8. 常用矩阵总结——秩1矩阵,优阵(单位正交阵),Hermite阵

8. 常用矩阵总结——镜面阵,正定阵

8. 常用矩阵总结——单阵,正规阵,幂0阵,幂等阵,循环阵

矩阵分解可以得到简化的乘积矩阵,可以简化后续的计算与处理度

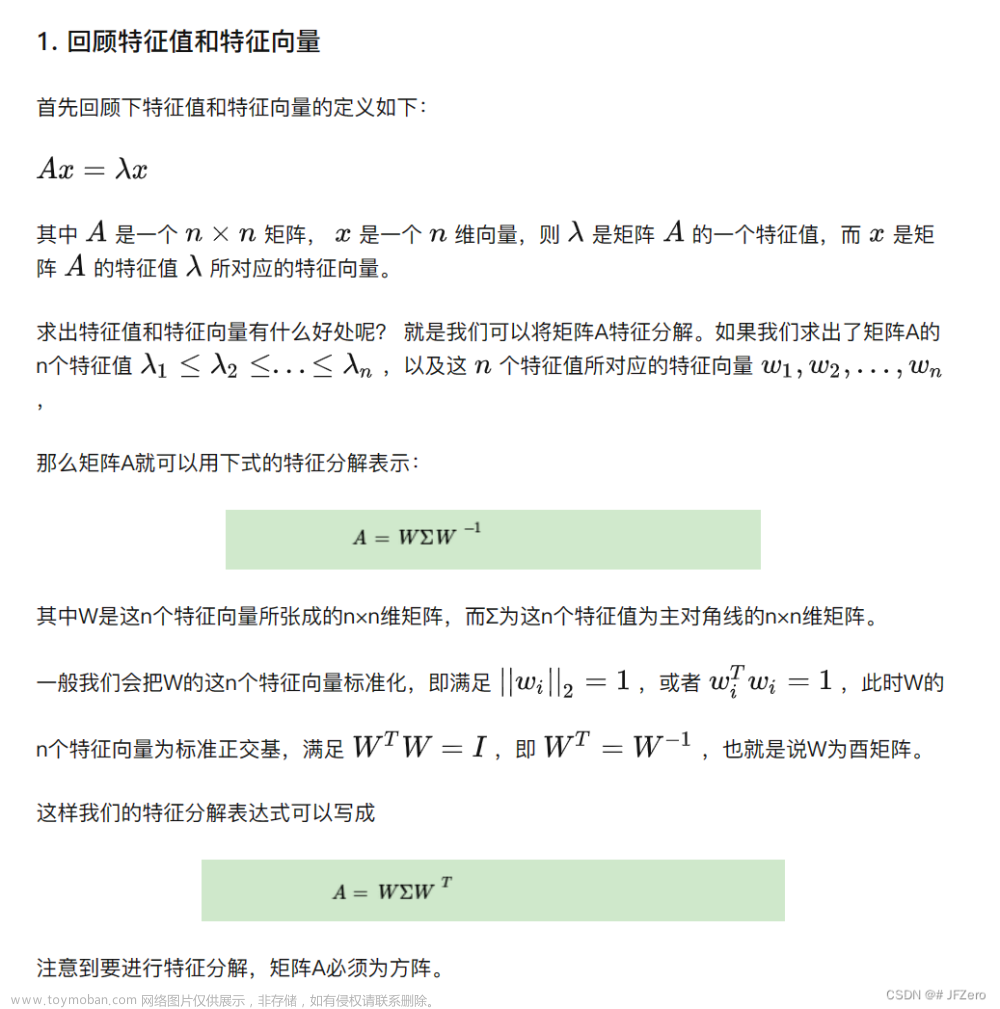

2.1.2 奇异值分解SVD

a. 正SVD

设 A = A m × n A=A_{m\times n} A=Am×n , r ( A ) > 0 r(A)>0 r(A)>0 ,正奇值 λ 1 , ⋯ , λ r \sqrt{\lambda_1},\cdots,\sqrt{\lambda_r} λ1,⋯,λr,则有分解 A = P Δ Q H A=P\Delta Q^H A=PΔQH ,其中 Δ = ( λ 1 ⋱ λ r ) \Delta=\left( \begin{matrix} \sqrt{\lambda_1}&&\\ &\ddots&\\ &&\sqrt{\lambda_r} \end{matrix} \right) Δ= λ1⋱λr , P m × r P_{m\times r} Pm×r , Q n × r Q_{n\times r} Qn×r 为半U阵, P H P = I r = Q H Q P^HP=I_r=Q^HQ PHP=Ir=QHQ ,可写正SVD公式 A = P ( λ 1 ⋱ λ r ) Q H A=P\left( \begin{matrix} \sqrt{\lambda_1}&&\\ &\ddots&\\ &&\sqrt{\lambda_r} \end{matrix} \right)Q^H A=P λ1⋱λr QH

证明

-

P m × r , Q n × r P_{m\times r},Q_{n\times r} Pm×r,Qn×r 的构造

A H A A^HA AHA 为Hermite阵,由Hermite分解定理,存在U阵,使 U H ( A H A ) U = ( λ 1 ⋱ λ n ) n × n U^H(A^HA)U=\left( \begin{matrix} \lambda_1&&\\ &\ddots&\\ &&\lambda_n \end{matrix} \right)_{n\times n} UH(AHA)U= λ1⋱λn n×n ,且 A H A A^HA AHA 为半正定阵,有 λ 1 , ⋯ , λ r > 0 , λ r + 1 = ⋯ = λ n = 0 , r ( A ) = r \lambda_1,\cdots,\lambda_r>0,\lambda_{r+1}=\cdots=\lambda_n=0,r(A)=r λ1,⋯,λr>0,λr+1=⋯=λn=0,r(A)=r

。而 U U U 的列向量 ( q 1 , q 2 , ⋯ , q n ) (q_1,q_2,\cdots,q_n) (q1,q2,⋯,qn) 为 A H A A^HA AHA 的特征向量

且 A H A q 1 = λ 1 q 1 , ⋯ , A H A q r = λ r q r , A H A q r + 1 = 0 , A H A q n = 0 A^HAq_1=\lambda_1q_1,\cdots,A^HAq_r=\lambda_rq_r,A^HAq_{r+1}=0,A^HAq_{n}=0 AHAq1=λ1q1,⋯,AHAqr=λrqr,AHAqr+1=0,AHAqn=0 ,令 Q = ( q 1 , q 2 , ⋯ , q r ) n × r Q=(q_1,q_2,\cdots,q_r)_{n\times r} Q=(q1,q2,⋯,qr)n×r , P = ( A q 1 ∣ A q 1 ∣ , ⋯ , A q r ∣ A q r ∣ ) m × r P=(\frac{Aq_1}{\vert Aq_1\vert},\cdots,\frac{Aq_r}{\vert Aq_r\vert})_{m\times r} P=(∣Aq1∣Aq1,⋯,∣Aqr∣Aqr)m×r -

P与Q为半U阵

已知 Q Q Q 中列向量为U阵的 r r r 个非零列向量,则 Q Q Q 为半U阵,而 ( A q 1 , A q 2 ) = ( A q 2 ) H ( A q 1 ) = q 2 A H A q 1 = λ 1 q 2 H q 1 = ( λ 1 q 1 , q 2 ) = 0 (Aq_1,Aq_2)=(Aq_2)^H(Aq_1)=q_2A^HAq_1=\lambda_1q_2^Hq_1=(\lambda_1q_1,q_2)=0 (Aq1,Aq2)=(Aq2)H(Aq1)=q2AHAq1=λ1q2Hq1=(λ1q1,q2)=0 。同理, A q i Aq_i Aqi 与 A q j Aq_j Aqj 都正交, ∣ A q i ∣ 2 = ( A q i ) H ( A q i ) = q i H A H A q i = λ i q i H q i = λ i ≥ 0 \vert Aq_i\vert^2=(Aq_i)^H(Aq_i)=q_i^HA^HAq_i=\lambda_iq_i^Hq_i=\lambda_i\ge0 ∣Aqi∣2=(Aqi)H(Aqi)=qiHAHAqi=λiqiHqi=λi≥0

⇒ P = ( A q 1 ∣ A q 1 ∣ , A q 2 ∣ A q 2 ∣ , ⋯ , A q r ∣ A q r ∣ ) = ( A q 1 λ 1 , A q 2 λ 2 , ⋯ , A q r λ r ) \Rightarrow P=\left(\frac{Aq_1}{\vert Aq_1 \vert},\frac{Aq_2}{\vert Aq_2 \vert},\cdots,\frac{Aq_r}{\vert Aq_r \vert}\right)=\left(\frac{Aq_1}{\sqrt{\lambda_1}},\frac{Aq_2}{\sqrt{\lambda_2}},\cdots,\frac{Aq_r}{\sqrt{\lambda_r}}\right) ⇒P=(∣Aq1∣Aq1,∣Aq2∣Aq2,⋯,∣Aqr∣Aqr)=(λ1Aq1,λ2Aq2,⋯,λrAqr),即 P P P 阵为半U阵 -

代入 P , Q P,Q P,Q

P Δ Q H = ( A q 1 λ 1 , A q 2 λ 2 , ⋯ , A q r λ r ) ( λ 1 ⋱ λ r ) ( q 1 H q 2 H ⋮ q r H ) P\Delta Q^H=\left(\frac{Aq_1}{\sqrt{\lambda_1}},\frac{Aq_2}{\sqrt{\lambda_2}},\cdots,\frac{Aq_r}{\sqrt{\lambda_r}}\right) \left( \begin{matrix}\sqrt{\lambda_1}&&\\ &&\ddots&\\ &&&\sqrt{\lambda_r} \end{matrix} \right)\left( \begin{matrix} q_1^H\\ q_2^H\\ \vdots\\ q_r^H \end{matrix} \right) PΔQH=(λ1Aq1,λ2Aq2,⋯,λrAqr) λ1⋱λr q1Hq2H⋮qrH

= ( A q 1 , A q 2 , ⋯ , A q r ) ( q 1 H q 2 H ⋮ q r H ) = ( A q 1 q 1 H , A q 2 q 2 H , , ⋯ , A q r q r H , ) =(Aq_1,Aq_2,\cdots,Aq_r)\left( \begin{matrix} q_1^H\\ q_2^H\\ \vdots\\ q_r^H \end{matrix} \right)=\left(Aq_1q_1^H,Aq_2q_2^H,,\cdots,Aq_rq_r^H,\right) =(Aq1,Aq2,⋯,Aqr) q1Hq2H⋮qrH =(Aq1q1H,Aq2q2H,,⋯,AqrqrH,)

-

验证 ( A q 1 q 1 H , A q 2 q 2 H , , ⋯ , A q r q r H ) = A \left(Aq_1q_1^H,Aq_2q_2^H,,\cdots,Aq_rq_r^H\right)=A (Aq1q1H,Aq2q2H,,⋯,AqrqrH)=A

A H A A^HA AHA 为半正定Hermite阵, r ( A H A ) = r ( A ) = r r(A^HA)=r(A)=r r(AHA)=r(A)=r。由同解定理, A H A x = 0 ⟺ A x = 0 A^HAx=0\iff Ax=0 AHAx=0⟺Ax=0 , A H A q r + 1 = ⋯ = A H A q n = 0 ⇒ A q r + 1 = ⋯ = A q n = 0 A^HAq_{r+1}=\cdots=A^HAq_{n}=0\Rightarrow Aq_{r+1}=\cdots=Aq_{n}=0 AHAqr+1=⋯=AHAqn=0⇒Aqr+1=⋯=Aqn=0

⇒ A ( q r + 1 q r + 1 H + ⋯ + q n q n H ) = 0 \Rightarrow A(q_{r+1}q_{r+1}^H+\cdots+q_nq_n^H)=0 ⇒A(qr+1qr+1H+⋯+qnqnH)=0 ,而 A ( q 1 q 1 H + ⋯ + q r q r H + q r + 1 q r + 1 H + ⋯ + q n q n H ) = A I = A A(q_1q_1^H+\cdots+q_rq_r^H+q_{r+1}q_{r+1}^H+\cdots+q_nq_n^H)=AI=A A(q1q1H+⋯+qrqrH+qr+1qr+1H+⋯+qnqnH)=AI=A ,即 A ( q 1 q 1 H + ⋯ + q r q r H ) = A A(q_1q_1^H+\cdots+q_rq_r^H)=A A(q1q1H+⋯+qrqrH)=A

最后得证 正SVD公式, A = P Δ Q H = P ( λ 1 ⋱ λ r ) Q H A=P\Delta Q^H=P\left( \begin{matrix} \sqrt{\lambda_1}&&\\ &\ddots&\\ &&\sqrt{\lambda_r} \end{matrix} \right)Q^H A=PΔQH=P λ1⋱λr QH

分解方法

-

求 A H A A^HA AHA 的特征值, λ 1 ≥ ⋯ , ≥ λ r > 0 \lambda_1\ge\cdots,\ge\lambda_r>0 λ1≥⋯,≥λr>0

正奇值为 λ 1 , ⋯ λ r \sqrt{\lambda_1},\cdots\sqrt{\lambda_r} λ1,⋯λr

-

求 λ 1 , ⋯ , λ r \lambda_1,\cdots,\lambda_r λ1,⋯,λr 的正交特征向量(不必单位化)

-

令列半U阵 Q = ( X 1 ∣ X 1 ∣ , ⋯ , X r ∣ X r ∣ ) , P = ( A X 1 ∣ A X 1 ∣ , ⋯ , A X r ∣ A X r ∣ ) Q=\left(\frac{X_1}{\vert X_1\vert},\cdots,\frac{X_r}{\vert X_r\vert}\right),P=\left(\frac{AX_1}{\vert AX_1\vert},\cdots,\frac{AX_r}{\vert AX_r\vert}\right) Q=(∣X1∣X1,⋯,∣Xr∣Xr),P=(∣AX1∣AX1,⋯,∣AXr∣AXr)

eg

A = ( 1 1 0 0 1 1 ) \begin{aligned} A=\left( \begin{matrix} 1&1\\ 0&0\\ 1&1 \end{matrix} \right) \end{aligned} A= 101101

A H A = ( 2 2 2 2 ) , 由 A H A 为秩 1 矩阵,得 λ = { 4 , 0 } ,正奇值为 λ = 2 而 λ 1 = 4 的特征向量为 X 1 = ( 1 1 ) , 则 Δ = ( 2 ) 令 Q = ( X 1 ∣ X 1 ∣ ) = ( 1 2 1 2 ) , P = ( A X 1 ∣ A X 1 ∣ ) = ( 1 2 0 1 2 ) 则 A 的正 S V D 为 A = P Δ Q H = ( 1 2 0 1 2 ) ( 2 ) ( 1 2 , 1 2 ) \begin{aligned} &A^HA=\left( \begin{matrix} 2&2\\ 2&2 \end{matrix} \right),由A^HA为秩1矩阵,得\lambda=\{4,0\},正奇值为\sqrt{\lambda}=\sqrt{2}\\ &而\lambda_1=4的特征向量为X_1=\left( \begin{matrix} 1\\1 \end{matrix} \right),则\Delta=\left( 2 \right)\\ &令Q=\left(\frac{X_1}{\vert X_1\vert}\right)=\left( \begin{matrix} \frac{1}{\sqrt{2}}\\ \frac{1}{\sqrt{2}} \end{matrix} \right),P=\left( \begin{matrix} \frac{AX_1}{\vert AX_1\vert} \end{matrix} \right)=\left( \begin{matrix} \frac{1}{\sqrt{2}}\\0\\\frac{1}{\sqrt{2}} \end{matrix} \right)\\ &则A的正SVD为A=P\Delta Q^H=\left( \begin{matrix} \frac{1}{\sqrt{2}}\\0\\\frac{1}{\sqrt{2}} \end{matrix} \right)\left(2\right)\left( \frac{1}{\sqrt{2}},\frac{1}{\sqrt{2}} \right) \end{aligned} AHA=(2222),由AHA为秩1矩阵,得λ={4,0},正奇值为λ=2而λ1=4的特征向量为X1=(11),则Δ=(2)令Q=(∣X1∣X1)=(2121),P=(∣AX1∣AX1)= 21021 则A的正SVD为A=PΔQH= 21021 (2)(21,21)

考虑 B = ( 1 0 1 1 0 1 ) B=\left( \begin{matrix} 1&0&1\\1&0&1\\ \end{matrix} \right) B=(110011) 的正SVD

已知 B = A H , 且有 A 的正 S V D , A = P Δ Q H = ( 1 2 0 1 2 ) ( 2 ) ( 1 2 , 1 2 ) B = ( P Δ Q H ) H = Q Δ P H = ( 1 2 1 2 ) ( 2 ) ( 1 2 , 0 , 1 2 ) \begin{aligned} &已知B=A^H,且有A的正SVD,A=P\Delta Q^H=\left( \begin{matrix} \frac{1}{\sqrt{2}}\\0\\\frac{1}{\sqrt{2}} \end{matrix} \right)\left(2\right)\left( \frac{1}{\sqrt{2}},\frac{1}{\sqrt{2}} \right)\\ &B=(P\Delta Q^H)^H=Q\Delta P^H=\left( \begin{matrix} \frac{1}{\sqrt{2}}\\\frac{1}{\sqrt{2}} \end{matrix} \right)\left(2\right)\left( \frac{1}{\sqrt{2}},0,\frac{1}{\sqrt{2}} \right) \end{aligned} 已知B=AH,且有A的正SVD,A=PΔQH= 21021 (2)(21,21)B=(PΔQH)H=QΔPH=(2121)(2)(21,0,21)

b. SVD(将P,Q,D都扩充为方阵)

设 A = A m × n , r ( A ) > 0 , 正奇值 λ 1 , ⋯ , λ r > 0 , 则有分解 A = W Δ V H 其中 D = ( Δ 0 0 0 ) m × n , W m × m = ( P , P 1 ) , V n × n = ( Q , Q 1 ) 可写 S V D 公式 A = W ( Δ 0 0 0 ) V H = P Δ Q H , 其中 ( λ 1 ⋱ λ r ) \begin{aligned} &设A=A_{m\times n},r(A)>0,正奇值\sqrt{\lambda_1},\cdots,\sqrt{\lambda_r}>0,则有分解A=W\Delta V^H\\ &其中D=\left( \begin{matrix} \Delta&0\\ 0&0 \end{matrix} \right)_{m\times n},W_{m\times m}=(P,P_1),V_{n\times n}=(Q,Q_1)\\ &可写SVD公式A=W\left( \begin{matrix} \Delta&0\\ 0&0 \end{matrix} \right)V^H=P\Delta Q^H,其中\left( \begin{matrix} \sqrt{\lambda_1}&&\\ &\ddots&\\ &&\sqrt{\lambda_r} \end{matrix} \right) \end{aligned} 设A=Am×n,r(A)>0,正奇值λ1,⋯,λr>0,则有分解A=WΔVH其中D=(Δ000)m×n,Wm×m=(P,P1),Vn×n=(Q,Q1)可写SVD公式A=W(Δ000)VH=PΔQH,其中 λ1⋱λr

证明:

由正 S V D : A = P Δ Q H , 分别把 P , Q 扩充为 U 阵,即 W = ( P , P 1 ) , V = ( Q , Q 1 ) , V H = ( Q H A 1 H ) , 则 W D V H = ( P , P 1 ) ( Δ 0 0 0 ) ( Q H A 1 H ) = ( P Δ 0 ) ( Q H A 1 H ) = P Δ Q H \begin{aligned} &由正SVD:A=P\Delta Q^H,分别把P,Q扩充为U阵,即W=(P,P_1),V=(Q,Q_1),\\ &V^H=\left( \begin{matrix} Q^H\\ A_1^H \end{matrix} \right),则WDV^H=(P,P_1)\left( \begin{matrix} \Delta&0\\ 0&0 \end{matrix} \right)\left( \begin{matrix} Q^H\\ A_1^H \end{matrix} \right)=\left( \begin{matrix} P\Delta\quad 0\\ \end{matrix} \right)\left( \begin{matrix} Q^H\\ A_1^H \end{matrix} \right)=P\Delta Q^H \end{aligned} 由正SVD:A=PΔQH,分别把P,Q扩充为U阵,即W=(P,P1),V=(Q,Q1),VH=(QHA1H),则WDVH=(P,P1)(Δ000)(QHA1H)=(PΔ0)(QHA1H)=PΔQH

分解方法

-

求 A H A A^HA AHA 的特征值, λ 1 ≥ ⋯ , ≥ λ r > 0 \lambda_1\ge\cdots,\ge\lambda_r>0 λ1≥⋯,≥λr>0

正奇值为 λ 1 , ⋯ λ r \sqrt{\lambda_1},\cdots\sqrt{\lambda_r} λ1,⋯λr

-

求 λ 1 , ⋯ , λ r \lambda_1,\cdots,\lambda_r λ1,⋯,λr 的正交特征向量(不必单位化)

-

令列U半阵 Q = ( X 1 ∣ X 1 ∣ , ⋯ , X r ∣ X r ∣ ) , P = ( A X 1 ∣ A X 1 ∣ , ⋯ , A X r ∣ A X r ∣ ) Q=\left(\frac{X_1}{\vert X_1\vert},\cdots,\frac{X_r}{\vert X_r\vert}\right),P=\left(\frac{AX_1}{\vert AX_1\vert},\cdots,\frac{AX_r}{\vert AX_r\vert}\right) Q=(∣X1∣X1,⋯,∣Xr∣Xr),P=(∣AX1∣AX1,⋯,∣AXr∣AXr) ,则有正SVD: A = P Δ Q H A=P\Delta Q^H A=PΔQH

-

将P,Q扩充为W,V 扩充方法不唯一 由证明可知,不管 P 1 , Q 1 P_1,Q_1 P1,Q1 为何,都会被消去

得SVD公式 A = W D V H A=WDV^H A=WDVH

eg

A = ( 1 1 0 0 1 1 ) \begin{aligned} A=\left( \begin{matrix} 1&1\\ 0&0\\ 1&1 \end{matrix} \right) \end{aligned} A= 101101

扩充为两个 U 阵 V = ( Q , X ) = ( 1 2 1 2 1 2 − 1 2 ) , W = ( P , Y ) = ( 1 2 0 1 2 0 0 0 1 2 0 − 1 2 ) 则有奇异分解 S V D , A = ( 1 2 0 1 2 0 0 0 1 2 0 − 1 2 ) ( 2 0 0 0 0 0 ) ( 1 2 1 2 1 2 − 1 2 ) \begin{aligned} &扩充为两个U阵V=\left(Q,X\right)=\left( \begin{matrix} \frac{1}{\sqrt{2}}&\frac{1}{\sqrt{2}}\\ \frac{1}{\sqrt{2}}&-\frac{1}{\sqrt{2}} \end{matrix} \right),W=\left(P,Y\right)=\left( \begin{matrix} \frac{1}{\sqrt{2}}&0&\frac{1}{\sqrt{2}}\\ 0&0&0\\ \frac{1}{\sqrt{2}}&0&-\frac{1}{\sqrt{2}} \end{matrix} \right)\\ &则有奇异分解SVD,A=\left( \begin{matrix} \frac{1}{\sqrt{2}}&0&\frac{1}{\sqrt{2}}\\ 0&0&0\\ \frac{1}{\sqrt{2}}&0&-\frac{1}{\sqrt{2}} \end{matrix} \right)\left( \begin{matrix} 2&0\\ 0&0\\ 0&0 \end{matrix} \right)\left( \begin{matrix} \frac{1}{\sqrt{2}}&\frac{1}{\sqrt{2}}\\ \frac{1}{\sqrt{2}}&-\frac{1}{\sqrt{2}} \end{matrix} \right) \end{aligned} 扩充为两个U阵V=(Q,X)=(212121−21),W=(P,Y)= 21021000210−21 则有奇异分解SVD,A= 21021000210−21 200000 (212121−21)

A

=

(

2

i

1

1

i

1

i

)

\begin{aligned} A=\left( \begin{matrix} 2i&1\\ 1&i\\ 1&i \end{matrix} \right) \end{aligned}

A=

2i111ii

A

H

A

=

(

−

2

i

1

1

1

−

i

−

i

)

(

2

i

1

1

i

1

i

)

=

(

6

0

0

3

)

,可知正奇值

S

(

A

)

+

=

{

6

,

3

}

λ

1

=

6

,

X

1

=

(

1

0

)

,

A

X

1

=

(

2

i

1

1

)

∣

A

X

1

∣

=

6

;

λ

2

=

3

,

X

2

=

(

0

1

)

,

A

X

2

=

(

1

i

i

)

令

Q

=

(

X

1

,

X

2

)

=

(

1

0

0

1

)

,

P

=

(

A

X

1

∣

A

X

1

∣

,

A

X

2

∣

A

X

2

∣

)

=

(

2

i

6

1

3

1

6

i

3

1

6

i

3

)

则有正

S

V

D

,

A

=

P

Δ

Q

H

=

(

2

i

6

1

3

1

6

i

3

1

6

i

3

)

(

6

3

)

(

1

0

0

1

)

H

可知

S

V

D

,

A

=

W

D

V

=

(

2

i

6

1

3

0

1

6

i

3

1

2

1

6

i

3

−

1

2

)

(

6

3

)

(

1

0

0

1

)

H

\begin{aligned} &A^HA=\left( \begin{matrix} -2i&1&1\\ 1&-i&-i \end{matrix} \right)\left( \begin{matrix} 2i&1\\ 1&i\\ 1&i \end{matrix} \right)=\left( \begin{matrix} 6&0\\ 0&3 \end{matrix} \right),可知正奇值S(A)_+=\{\sqrt{6},\sqrt{3}\}\\ &\lambda_1=6,X_1=\left( \begin{matrix} 1\\0 \end{matrix} \right),AX_1=\left( \begin{matrix} 2i\\1\\1 \end{matrix} \right)\vert AX_1\vert=\sqrt{6};\lambda_2=3,X_2=\left( \begin{matrix} 0\\1 \end{matrix} \right),AX_2=\left( \begin{matrix} 1\\i\\i \end{matrix} \right)\\ &令Q=\left( \begin{matrix} X_1,X_2 \end{matrix} \right)=\left( \begin{matrix} 1&0\\0&1 \end{matrix} \right),P=\left( \begin{matrix} \frac{AX_1}{\vert AX_1\vert},\frac{AX_2}{\vert AX_2\vert} \end{matrix} \right)=\left( \begin{matrix} \frac{2i}{\sqrt{6}}&\frac{1}{\sqrt{3}}\\ \frac{1}{\sqrt{6}}&\frac{i}{\sqrt{3}}\\ \frac{1}{\sqrt{6}}&\frac{i}{\sqrt{3}} \end{matrix} \right)\\ &则有正SVD,A=P\Delta Q^H=\left( \begin{matrix} \frac{2i}{\sqrt{6}}&\frac{1}{\sqrt{3}}\\ \frac{1}{\sqrt{6}}&\frac{i}{\sqrt{3}}\\ \frac{1}{\sqrt{6}}&\frac{i}{\sqrt{3}} \end{matrix} \right)\left( \begin{matrix} \sqrt{6}&\\ &\sqrt{3} \end{matrix} \right)\left( \begin{matrix} 1&0\\0&1 \end{matrix} \right)^H\\ &可知SVD,A=WDV=\left( \begin{matrix} \frac{2i}{\sqrt{6}}&\frac{1}{\sqrt{3}}&0\\ \frac{1}{\sqrt{6}}&\frac{i}{\sqrt{3}}&\frac{1}{\sqrt{2}}\\ \frac{1}{\sqrt{6}}&\frac{i}{\sqrt{3}}&-\frac{1}{\sqrt{2}} \end{matrix} \right)\left( \begin{matrix} \sqrt{6}&\\ &\sqrt{3} \end{matrix} \right)\left( \begin{matrix} 1&0\\0&1 \end{matrix} \right)^H \end{aligned}

AHA=(−2i11−i1−i)

2i111ii

=(6003),可知正奇值S(A)+={6,3}λ1=6,X1=(10),AX1=

2i11

∣AX1∣=6;λ2=3,X2=(01),AX2=

1ii

令Q=(X1,X2)=(1001),P=(∣AX1∣AX1,∣AX2∣AX2)=

62i6161313i3i

则有正SVD,A=PΔQH=

62i6161313i3i

(63)(1001)H可知SVD,A=WDV=

62i6161313i3i021−21

(63)(1001)H

一个SVD解答

A

=

(

i

2

1

i

1

i

)

,求正

S

V

D

与

S

V

D

\begin{aligned} A=\left( \begin{matrix} i&2\\ 1&i\\1&i \end{matrix} \right),求正SVD与SVD \end{aligned}

A=

i112ii

,求正SVD与SVD

∵ A H A = ( − i 1 1 2 − i − i ) ( i 2 1 i 1 i ) = ( 3 0 0 6 ) 为对角阵,令 λ 1 = 3 , λ 2 = 6 A H A 有两个特向 X 1 = ( 1 0 ) , X 2 = ( 0 1 ) ( 互正交 ) ,正奇值为 λ 1 = 3 , λ 2 = 6 A X 1 = ( i 1 1 ) , A X 2 = ( 2 i i ) , ∣ A X 1 ∣ = 3 , ∣ A X 2 ∣ = 6 令 P = ( A X 1 ∣ A X 1 ∣ , A X 2 ∣ A X 2 ∣ ) = ( i 3 2 6 1 3 i 6 i 3 i 6 ) , 则正 S V D A = P Δ Q H = ( i 3 2 6 1 3 i 6 i 3 i 6 ) ( 3 0 0 6 0 0 ) ( 1 0 0 1 ) \begin{aligned} &\because A^HA=\left( \begin{matrix} -i&1&1\\ 2&-i&-i \end{matrix} \right)\left( \begin{matrix} i&2\\ 1&i\\1&i \end{matrix} \right)=\left( \begin{matrix} 3&0\\ 0&6 \end{matrix} \right)为对角阵,令\lambda_1=3,\lambda_2=6\\ &A^HA有两个特向X_1=\left( \begin{matrix} 1\\0 \end{matrix} \right),X_2=\left( \begin{matrix} 0\\1 \end{matrix} \right)(互正交),正奇值为 \sqrt{\lambda_1}=\sqrt{3},\sqrt{\lambda_2}=\sqrt{6}\\ &AX_1=\left( \begin{matrix} i\\1\\1 \end{matrix} \right),AX_2=\left( \begin{matrix} 2\\i\\i \end{matrix} \right),\vert AX_1 \vert=\sqrt{3},\vert AX_2 \vert=\sqrt{6}\\ &令P=\left( \frac{AX_1}{\vert AX_1\vert},\frac{AX_2}{\vert AX_2\vert} \right)=\left( \begin{matrix} \frac{i}{\sqrt{3}}&\frac{2}{\sqrt{6}}\\ \frac{1}{\sqrt{3}}&\frac{i}{\sqrt{6}}\\ \frac{i}{\sqrt{3}}&\frac{i}{\sqrt{6}}\\ \end{matrix} \right),则正SVD\\ &A=P\Delta Q^H=\left( \begin{matrix} \frac{i}{\sqrt{3}}&\frac{2}{\sqrt{6}}\\ \frac{1}{\sqrt{3}}&\frac{i}{\sqrt{6}}\\ \frac{i}{\sqrt{3}}&\frac{i}{\sqrt{6}}\\ \end{matrix} \right)\left( \begin{matrix} \sqrt{3}&0\\ 0&\sqrt{6}\\ 0&0 \end{matrix} \right)\left( \begin{matrix} 1&0\\ 0&1 \end{matrix} \right) \end{aligned} ∵AHA=(−i21−i1−i) i112ii =(3006)为对角阵,令λ1=3,λ2=6AHA有两个特向X1=(10),X2=(01)(互正交),正奇值为λ1=3,λ2=6AX1= i11 ,AX2= 2ii ,∣AX1∣=3,∣AX2∣=6令P=(∣AX1∣AX1,∣AX2∣AX2)= 3i313i626i6i ,则正SVDA=PΔQH= 3i313i626i6i 300060 (1001)

令 W = ( P , P 1 ) = ( i 3 2 6 0 1 3 i 6 1 2 i 3 i 6 − 1 2 ) , 或 ( i 3 2 6 0 1 3 i 6 i 2 i 3 i 6 − i 2 ) , 有 S V D , A = ( i 3 2 6 0 1 3 i 6 1 2 i 3 i 6 − 1 2 ) ( 3 0 0 6 0 0 ) ( 1 0 0 1 ) \begin{aligned} &令W=(P,P_1)=\left( \begin{matrix} \frac{i}{\sqrt{3}}&\frac{2}{\sqrt{6}}&0\\ \frac{1}{\sqrt{3}}&\frac{i}{\sqrt{6}}&\frac{1}{\sqrt{2}}\\ \frac{i}{\sqrt{3}}&\frac{i}{\sqrt{6}}&-\frac{1}{\sqrt{2}}\\ \end{matrix} \right),或\left( \begin{matrix} \frac{i}{\sqrt{3}}&\frac{2}{\sqrt{6}}&0\\ \frac{1}{\sqrt{3}}&\frac{i}{\sqrt{6}}&\frac{i}{\sqrt{2}}\\ \frac{i}{\sqrt{3}}&\frac{i}{\sqrt{6}}&-\frac{i}{\sqrt{2}}\\ \end{matrix} \right),\\ &有SVD,A=\left( \begin{matrix} \frac{i}{\sqrt{3}}&\frac{2}{\sqrt{6}}&0\\ \frac{1}{\sqrt{3}}&\frac{i}{\sqrt{6}}&\frac{1}{\sqrt{2}}\\ \frac{i}{\sqrt{3}}&\frac{i}{\sqrt{6}}&-\frac{1}{\sqrt{2}}\\ \end{matrix} \right)\left( \begin{matrix} \sqrt{3}&0\\ 0&\sqrt{6}\\ 0&0 \end{matrix} \right)\left( \begin{matrix} 1&0\\ 0&1 \end{matrix} \right) \end{aligned} 令W=(P,P1)= 3i313i626i6i021−21 ,或 3i313i626i6i02i−2i ,有SVD,A= 3i313i626i6i021−21 300060 (1001)

c. 当A是向量时

A = ( a 1 ⋮ a n ) ≠ 0 , 则其正 S V D \begin{aligned} &A=\left( \begin{matrix} a_1\\ \vdots\\ a_n \end{matrix} \right)\neq 0,则其正SVD \end{aligned} A= a1⋮an =0,则其正SVD

A H A = ( a 1 ‾ , ⋯ , a n ‾ ) ( a 1 ⋮ a n ) = ∣ a 1 ∣ 2 + ⋯ + ∣ a n ∣ 2 > 0 λ 1 = ∣ a 1 ∣ 2 + ⋯ + ∣ a n ∣ 2 ,令 Δ = ( λ 1 ) , Q = ( 1 ) X 1 = ( 1 ) , P = 1 ∣ a 1 ∣ 2 + ∣ a 2 ∣ 2 + ⋯ + ∣ a n ∣ n ( a 1 ⋮ a n ) , 正 S V D : A = P Δ Q H = 1 ∣ a 1 ∣ 2 + ∣ a 2 ∣ 2 + ⋯ + ∣ a n ∣ n ( a 1 ⋮ a n ) ( ∣ a 1 ∣ 2 + ∣ a 2 ∣ 2 + ⋯ + ∣ a n ) ( 1 ) \begin{aligned} &A^HA=\left(\overline{a_1},\cdots,\overline{a_n}\right)\left( \begin{matrix} a_1\\ \vdots\\ a_n \end{matrix} \right)=\vert a_1\vert^2+\cdots+\vert a_n\vert^2>0\\ &\lambda_1=\vert a_1 \vert^2+\cdots+\vert a_n\vert^2,令\Delta=\left(\sqrt{\lambda_1}\right),Q=(1)\\ &X_1=(1),P=\frac{1}{\sqrt{\vert a_1 \vert^2+\vert a_2 \vert^2+\cdots+\vert a_n \vert^n}}\left( \begin{matrix} a_1\\\vdots\\a_n \end{matrix} \right),\\ &正SVD:A=P\Delta Q^H=\\ &\frac{1}{\sqrt{\vert a_1 \vert^2+\vert a_2 \vert^2+\cdots+\vert a_n \vert^n}}\left( \begin{matrix} a_1\\\vdots\\a_n \end{matrix} \right)\left(\sqrt{\vert a_1 \vert^2+\vert a_2 \vert^2+\cdots+\vert a_n}\right)\left(1\right) \end{aligned} AHA=(a1,⋯,an) a1⋮an =∣a1∣2+⋯+∣an∣2>0λ1=∣a1∣2+⋯+∣an∣2,令Δ=(λ1),Q=(1)X1=(1),P=∣a1∣2+∣a2∣2+⋯+∣an∣n1 a1⋮an ,正SVD:A=PΔQH=∣a1∣2+∣a2∣2+⋯+∣an∣n1 a1⋮an (∣a1∣2+∣a2∣2+⋯+∣an)(1)

d. A H A^H AH与A的SVD只需求一个

若已知正 S V D , A = P Δ Q H , 可得 A H 的正 S V D = ( P Δ Q H ) H 若已知正SVD,A=P\Delta Q^H,可得A^H的正SVD=(P\Delta Q^H)^H 若已知正SVD,A=PΔQH,可得AH的正SVD=(PΔQH)H

A = ( 2 0 0 3 0 0 ) 与 B = A H 的正 S V D 与 S V D \begin{aligned} A=\left( \begin{matrix} 2&0&0\\ 3&0&0 \end{matrix} \right)与B=A^H的正SVD与SVD \end{aligned} A=(230000)与B=AH的正SVD与SVD

文章来源:https://www.toymoban.com/news/detail-405138.html

文章来源:https://www.toymoban.com/news/detail-405138.html

2.1.3 正SVD的等价写法

A = P Δ Q H , Δ = ( s 1 ⋱ s r ) , 令 P = ( A X 1 ∣ A X 1 ∣ , ⋯ , A X r ∣ A X r ∣ ) = ( p 1 , ⋯ , p r ) Q = ( X 1 , ⋯ , X r ) = ( q 1 , ⋯ , q r ) , 则有正 S V D A = s 1 p 1 q 1 H + ⋯ + s r p r q r H \begin{aligned} &A=P\Delta Q^H,\Delta=\left( \begin{matrix} s_1&&\\ &\ddots&\\ &&s_r \end{matrix} \right),令P=\left(\frac{AX_1}{\vert AX_1\vert},\cdots,\frac{AX_r}{\vert AX_r\vert} \right)=\left(p_1,\cdots,p_r\right)\\ &Q=\left(X_1,\cdots,X_r\right)=\left(q_1,\cdots,q_r\right),则有正SVD\\ &A=s_1p_1q_1^H+\cdots+s_rp_rq_r^H \end{aligned} A=PΔQH,Δ= s1⋱sr ,令P=(∣AX1∣AX1,⋯,∣AXr∣AXr)=(p1,⋯,pr)Q=(X1,⋯,Xr)=(q1,⋯,qr),则有正SVDA=s1p1q1H+⋯+srprqrH文章来源地址https://www.toymoban.com/news/detail-405138.html

到了这里,关于【矩阵论】2. 矩阵分解——SVD的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!