目录

安装Elasticsearch

安装Kibana

安装IK分词器

测试IK

安装Elasticsearch

这里说明一下,我们需要在安装Kibana之前先安装Elasticsearch,安装Elasticsearch如下:

docker run -d \

--name es \

-e "ES_JAVA_OPTS=-Xms512m -Xmx512m" \

-e "discovery.type=single-node" \

-v es-data:/usr/share/elasticsearch/data \

-v es-plugins:/usr/share/elasticsearch/plugins \

--privileged \

--network es-net \

-p 9200:9200 \

-p 9300:9300 \

elasticsearch:7.12.1这里一定要看清楚,特别是数据卷的位置,例如输出命令-V后,后面又重新执行命令的时候,就需要先删除你的数据卷,使用docker volume rm 数据卷名,就可以删除数据卷了,要不然后面安装KI分词器的时候,一定是失败的!!!,启动Elasticsearch失败有我自己总结的解决方法,传送门如下

Elasticsearch启动失败及解决

安装Kibana

安装Kibana,命令如下:

docker run -d \

--name kibana \

-e ELASTICSEARCH_HOSTS=http://es:9200 \

--network=es-net \

-p 5601:5601 \

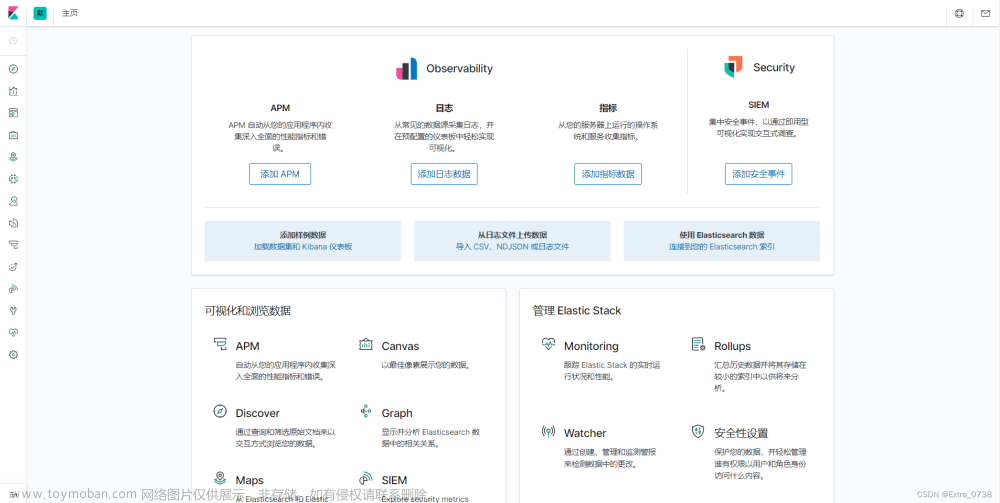

kibana:7.12.1在安装完成kibana后,我们可以看到启动的页面就是这样的

启动成功,我们开始安装IK分词器,这里就会提及刚刚我们说到的挂载数据卷的问题了,因为数据卷出错,是安装不进去的,这里我们直接就使用GitHub下的资源来进行离线下载,就不适用直接拉取文件的方式来解决。

安装IK分词器

输入命令

docker exec -it es /bin/bash这里的es就是Elasticsearch容器的名称

这里我们就进入了Elasticsearch的容器中,这里我们可以看到有plugins这个文件,这个文件中就需要我们将IK分词器安装到此,下面就是直接输入命令就可以下载到里面了

./bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.12.1/elasticsearch-analysis-ik-7.12.1.zip

现在当中已经由IK的文件了

安装完成后,记得exit退出,使用docker restart es,重启Elasticsearch,就可以使用IK分词器了

测试一下

测试IK

我们先测试是否能使用,就先Elasticsearch中的/

现在我们测试一下随便来个看看是怎么进行分词的

这里可以看到,这种分词器是不能够将我们需要的词给分出来的,所以我们使用IK分词器

ik_smart和ik_max_word,结果如下

文章来源:https://www.toymoban.com/news/detail-405442.html

文章来源:https://www.toymoban.com/news/detail-405442.html

从图片可知这两种方式都可以进行分词,但是ik_max_word可以更多量化的提供更多的词汇,所以根据不同的场景,选择不同的分词方式!文章来源地址https://www.toymoban.com/news/detail-405442.html

到了这里,关于Kibana中安装启动IK分词器的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![Docker安装部署[8.x]版本Elasticsearch+Kibana+IK分词器](https://imgs.yssmx.com/Uploads/2024/02/751357-1.png)