在AIGC取得举世瞩目成就的背后,基于大模型、多模态的研究范式也在不断地推陈出新。微软研究院作为这一研究领域的佼佼者,与图灵奖得主、深度学习三巨头之一的Yoshua Bengio一起提出了AIGC新范式——Regeneration Learning。这一新范式究竟会带来哪些创新变革?本文作者将带来他的深度解读。

作者 | 谭旭

AIGC(AI-Generated Content)在近年来受到了广泛关注,基于深度学习的内容生成在图像、视频、语音、音乐、文本等生成领域取得了非常瞩目的成就。不同于传统的数据理解任务通常采用表征学习(Representation Learning)范式来学习数据的抽象表征,数据生成任务需要刻画数据的整体分布而不是抽象表征,需要一个新的学习范式来指导处理数据生成的建模问题。

为此,微软研究院的研究员和深度学习/表征学习先驱Yoshua Bengio一起,通过梳理典型的数据生成任务以及建模流程,抽象出面向数据生成任务的学习范式Regeneration Learning。该学习范式适合多种数据生成任务(图像/视频/语音/音乐/文本生成等),能够为开发设计数据生成的模型方法提供新的洞见和指导。

论文:Regeneration Learning: A Learning Paradigm for Data Generation

链接:https://arxiv.org/abs/2301.08846

为什么是Regeneration Learning?

什么是数据理解与数据生成?

机器学习中一类典型的任务是学习一个从源数据X到目标数据Y的映射,比如在图像分类中X是图像而Y是类别标签,在文本到语音合成中X是文本而Y是语音。根据X和Y含有信息量的不同,可以将这种映射分成数据理解(Data Understanding)、数据生成(Data Generation)以及两者兼有的任务。图1显示了这三种任务以及X和Y含有的相对信息。

图1:机器学习中常见的三种任务类型以及X和Y含有的相对信息量

X和Y的信息差异导致了采用不同的方法来解决不同的任务:

对于数据理解任务,X通常比较高维、复杂并且比Y含有更多的信息,所以任务的核心是从X学习抽象表征来预测Y。因此,深度学习中非常火热的表征学习(Representation Learning,比如基于自监督学习的大规模预训练)适合处理这类任务。

对于数据生成任务,Y通常比较高维、复杂并且比X含有更多的信息,所以任务的核心是刻画Y的分布以及从X生成Y。

对于数据理解和生成兼有的任务,它们需要分别处理两者的问题。

数据生成任务面临的独特挑战

数据生成任务面临独特的挑战包括:

因为Y含有很多X不含有的信息,生成模型面临严重的一对多映射(One-to-Many Mapping)问题,增加了学习难度。比如在图像生成中,类别标签“狗”对应不同的狗的图片,如果没有合理地学习这种一对多的映射,会导致训练集上出现过拟合,在测试集上泛化性很差。

-

对于一些生成任务(比如文本到语音合成,语音到说话人脸生成等),X和Y的信息量相当,会有两种问题,一种是X到Y的映射不是一一对应,会面临上面提到的一对多映射问题,另一种是X和Y含有虚假关联(Spurious Correlation,比如在语音到说话人脸生成中,输入语音的音色和目标说话人脸视频中的头部姿态没有太大关联关系),会导致模型学习到虚假映射出现过拟合。

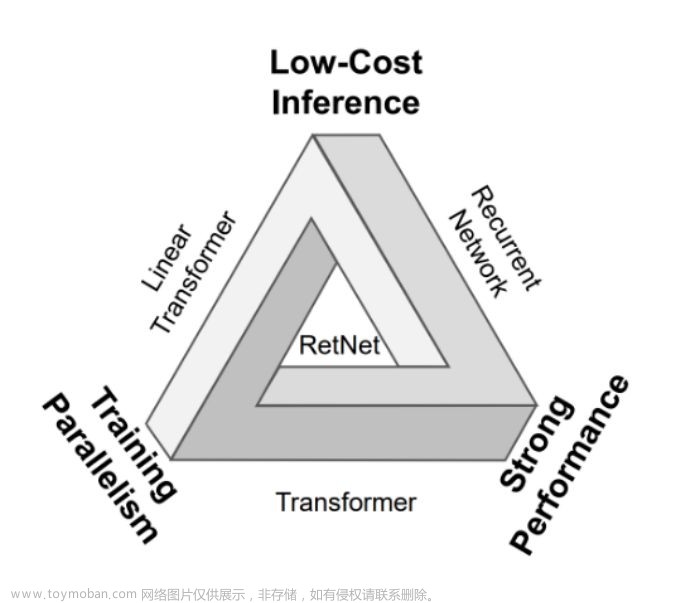

为什么需要Regeneration Learning

深度生成模型(比如对抗生成网络GAN、变分自编码器VAE、自回归模型AR、标准化流模型Flow、扩散模型Diffusion等)在数据生成任务上取得了非常大的进展,在理想情况下可以拟合任何数据分布以实现复杂的数据生成。但是,在实际情况中,由于数据映射太复杂,计算代价太大以及数据稀疏性问题等,它们不能很好地拟合复杂的数据分布以及一对多映射和虚假映射问题。类比于数据理解任务,尽管强大的模型,比如Transformer已经取得了不错的效果,但是表征学习(近年来的大规模自监督学习比如预训练)还是能大大提升性能。数据生成任务也迫切需要一个类似于表征学习的范式来指导建模。

因此,我们针对数据生成任务提出了Regeneration Learning学习范式。相比于直接从X生成Y,Regeneration Learning先从X生成一个目标数据的抽象表征Y’,然后再从Y’生成Y。这样做有两点好处:

X→Y’ 相比于X→Y的一对多映射和虚假映射问题会减轻;

-

Y’→Y的映射可以通过自监督学习利用大规模的无标注数据进行预训练。

Regeneration Learning的形式

Regeneration Learning的基本形式/Regeneration Learning的步骤

Regeneration Learning一般需要三步,包括:

将Y转化成抽象表征Y’。转换方法大体上可分为显式和隐式两种,如表1中Basic Formulation所示:显式转换包括数学变换(比如傅里叶变换,小波变换),模态转换(比如语音文本处理中使用的字形到音形的变换),数据分析挖掘(比如从音乐数据抽取音乐特征或者从人脸图片中抽取3D表征),下采样(比如将256*256图片下采样到64*64图片)等;隐式转换,比如通过端到端学习抽取中间表征(一些常用的方法包括变分自编码器VAE,量化自编码器VQ-VAE和VQ-GAN,基于扩散模型的自编码器Diffusion-AE)。

表1:Y→Y’转换的不同方法

步骤2:从X生成Y’。可以使用任何生成模型或者转换方法,以方便做X→Y’映射。

步骤3:从Y’生成Y。通常采用自监督学习,如果从Y转化为Y’采用的是隐式转换学习比如变分自编码器,那可以使用学习到的解码器来从Y’生成Y。

如表1中Extended Formulation所示,一些方法可以看成是Regeneration Learning的扩展版本,比如自回归模型AR,扩散模型Diffusion,以及迭代式的非自回归模型等。在自回归模型中,Y_{<t}可以看成是Y_{<t+1}的简化表征,在Diffusion模型中,Y_{t+1}可以看成是Y_{t}的简化表征,和基础版的Regeneration Learning不同的是,它们都需要多步生成而不是两步生成。

Regeneration Learning和Representation Learning的关系

图2:Regeneration Learning和Representation Learning的对比

如图2所示,Regeneration Learning可以看成是传统的Representation Learning在数据生成任务中的对应:

Regeneration Learning处理目标数据Y的抽象表征Y’来帮助生成,而传统的Representation Learning处理源数据X的抽象表征X’来帮助理解;

Regeneration Learning中的Y’→Y和Representation Learning中的X→X’ 都可以通过自监督的方式学习(比如大规模预训练);

-

Regeneration Learning中的X→Y’和Representation Learning中的X’→Y都比原来的X→Y更加简单。

Regeneration Learning的方法研究以及实际应用

Regeneration Learning的研究机会

Regeneration Learning作为一种面向数据生成的学习范式,有比较多的研究问题。如表2所示,包括如何从Y获取Y’以及如何更好地学习X→Y’以及Y’→Y等,详细信息可参见论文。

表2:Regeneration Learning的研究问题

Regeneration Learning在数据生成任务中的应用条件

Regeneration Learning在语音、音频、音乐、图像、视频、文本等生成中有着广泛的应用,包括文本到语音合成,语音到文本识别,歌词/视频到旋律生成,语音到说话人脸生成,图像/视频/音频生成等,如表3所示。

表3:一些利用Regeneration Learning的数据生成任务

总的来讲,只要满足以下几点要求,都可以使用Regeneration Learning:

目标数据太高维复杂;

X和Y有比较复杂的映射关系,比如一对多映射和虚假映射;

X和Y缺少足够的配对数据。

最近流行的数据生成模型及其在Regeneration Learning范式下的表示

下面简单梳理了近年来在AIGC内容生成领域的一些典型的模型方法,比如文本到图像生成模型DALL-E 1、DALL-E 2和Stable Diffusion,文本到音频生成模型AudioLM和AudioGen,文本到音乐生成模型MusicLM,文本生成模型GPT-3/ChatGPT,它们都可以被看作是采用了Regeneration Learning类似的思想,如表4所示。

表4:最近比较受关注的数据生成模型及其在Regeneration Learning范式下的表示

机器学习/深度学习依赖于学习范式指导处理各种学习问题,例如传统的机器学习,包括有监督学习、无监督学习、强化学习等学习范式。在深度学习中,有针对数据理解任务的表征学习。微软研究员们和深度学习/表征学习先驱Yoshua Bengio一起面向数据生成任务提出了针对性的学习范式Regeneration Learning,希望能指导解决数据生成任务中的各种问题。微软亚洲研究院机器学习组的研究员们,将Regeneration Learning的思想应用到各类生成任务中,比如文本到语音合成,歌词到旋律生成,语音到说话人脸生成等,详情请见:https://ai-creation.github.io/。

结语

本篇文章介绍了微软亚洲研究院机器学习组在AIGC数据生成方面的研究范式工作,首先指出了数据生成面临的挑战以及新的学习范式的必要性,然后介绍了Regeneration Learning的具体形式、与Representation Learning的关系、当前流行的数据生成模型在该范式下的表示,以及Regeneration Learning潜在的研究机会。希望Regeneration Learning能够很好地指导解决数据生成任务中的各种问题。在这一研究方向上,机器学习组还开展了模型结构和建模方法以及具体的生成任务方面的研究,欢迎继续关注我们的其他文章!

作者简介

谭旭,微软亚洲研究院高级研究员

研究领域为深度学习及AI内容生成。发表论文100余篇,研究工作如预训练语言模型MASS、语音合成模型FastSpeech、AI音乐项目Muzic受到业界关注,多项成果应用于微软产品中。研究主页:https://ai-creation.github.io/文章来源:https://www.toymoban.com/news/detail-406513.html

文章来源地址https://www.toymoban.com/news/detail-406513.html

文章来源地址https://www.toymoban.com/news/detail-406513.html

到了这里,关于微软提出AIGC新“玩法”,图灵奖得主Yoshua Bengio也来了!的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!