系列文章目录

【Nginx一】——Nginx介绍(正向代理 反向代理 负载均衡 动静分离)

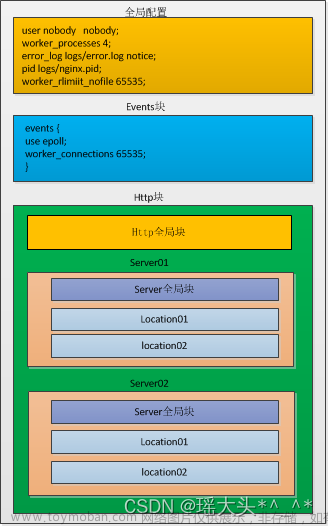

【Nginx二】——Nginx常用命令 配置文件

Nginx如何处理请求

【Nginx三】——Nginx实现反向代理

前言

本篇博客主要介绍Nginx实现负载均衡的多种策略,包括轮询、最少连接、IP哈希、加权轮询、URL哈希。

一、Nginx的负载均衡是什么

Nginx可以通过反向代理实现负载均衡,有策略的分发请求给不同的后端服务器。避免单点故障,增强整个系统的可用性,从而提高系统的并发处理能力。

nginx中的反向代理实现包括HTTP的负载平衡, HTTPS,FastCGI,uwsgi,SCGI,memcached和gRPC。

要为 HTTPS 而不是 HTTP 配置负载平衡,只需使用“https” 作为协议。

为 FastCGI、uwsgi、SCGI、memcached 或 gRPC 设置负载平衡时,请分别使用 fastcgi_pass、uwsgi_pass、scgi_pass、memcached_pass 和 grpc_pass 指令。

二、负载均衡的多种策略

1.轮询(Round Robin):默认策略,将请求按顺序分配到不同的服务器上。

2.最少连接(Least Connections):将请求分配到连接数最少的服务器上。

3.IP 哈希(IP Hash):将请求的 IP 地址作为哈希键,根据哈希值分配到对应的服务器上,

4.加权负载平衡(Weighted Load Balancing):将请求按照预设的权重分配到不同的服务器上,权重越高的服务器获得的请求越多。

5.URL 哈希(URL Hash):将请求的 URL 地址作为哈希键,根据哈希值分配到对应的服务器上,确保相同的 URL 地址的请求分配到同一台服务器上。

1.轮询(Round Robin)

在轮询算法中,多个目标按照固定的顺序依次接收请求或任务。每当一个新的请求或任务到来时,轮询算法会将其分配给下一个目标,直到所有目标都接收到请求或任务,然后再从头开始。

要使用轮询策略将请求分配到不同的服务器上,可以在upstream块中制定round-robin策略:

代码如下(示例):

upstream backend {

server 192.168.60.1;

server 192.168.60.2;

server 192.168.60.3;

}

server {

listen 80;

server_name example.com;

location / {

# 指定使用backend代理请求

proxy_pass http://backend;

}

}

在这个例子中,upstream块定义了3个后端服务器

这3个服务器会按照默认的轮询策略进行负载均衡。

在server块中,配置了请求转发,所有的请求都会被代理到backend服务器组中的一个服务器上。

2.最少连接(Least Connections)

它将请求分配到连接数最少的服务器上,从而平衡服务器的负载。使用最少连接策略可以避免出现某些服务器负载过重的情况。

在 Nginx 中,可以使用

least_conn 策略来实现最少连接的负载平衡。下面是一个使用

least_conn 策略的例子:

代码如下(示例):

upstream backend {

least_conn;

server 192.168.60.1;

server 192.168.60.2;

server 192.168.60.3;

}

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://backend;

}

}

在上面的例子中,我们定义了一个名为

backend 的服务器组,使用

least_conn 策略将请求分配到连接数最少的服务器上。我们也可以在每个

server 配置项中设置权重、最大失败次数、失败超时等参数,例如:

upstream backend {

least_conn;

server 192.168.60.1 weight=2 max_fails=3 fail_timeout=30s;

server 192.168.60.2 weight=3 max_fails=2 fail_timeout=20s;

server 192.168.60.3 max_fails=1 fail_timeout=10s;

}

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://backend;

}

}

在上面的例子中,我们将权重、最大失败次数和失败超时等参数设置在了每个 server 配置项中。这些参数可以根据实际情况进行设置,以达到更好的负载平衡效果。

3.IP 哈希(IP Hash)

IP 哈希(IP Hash)是一种负载均衡策略,它通过对客户端 IP 地址进行哈希运算,将同一个客户端的请求分配到同一台服务器上。使用 IP 哈希策略可以保证同一个客户端的请求始终被分配到同一台服务器上,从而避免因为多台服务器之间的状态不同步而导致的问题。

需要注意的是,使用 IP 哈希策略时,如果服务器组中有服务器被添加或者删除,那么会导致哈希结果发生变化,从而导致之前被分配到该服务器的请求需要重新分配。因此,在使用 IP 哈希策略时需要考虑服务器组的动态变化情况。

下面是一个使用 IP 哈希(IP Hash)策略的 Nginx 配置实例:

upstream backend {

ip_hash;

server 192.168.60.1;

server 192.168.60.2;

server 192.168.60.3;

}

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://backend;

}

}

在上面的配置中,我们定义了一个名为 backend 的服务器组,使用 ip_hash 策略将同一个客户端的请求分配到同一台服务器上。然后,在一个名为 example.com 的虚拟主机中,我们将所有请求都通过反向代理的方式转发到 backend 服务器组中。

假设客户端 A 的 IP 地址为 192.168.0.1,客户端 B 的 IP 地址为 192.168.0.2,客户端 C 的 IP 地址为 192.168.0.3,则它们的请求分配情况可能如下所示:

客户端 A 的请求被分配到了服务器 192.168.60.1 上;

客户端 B 的请求被分配到了服务器 192.168.60.2 上;

客户端 C 的请求被分配到了服务器 192.168.60.3 上。

注意 如果某个客户端的请求被分配到了某台服务器上,那么这个客户端的所有后续请求都将被分配到同一台服务器上,直到服务器组中的服务器发生变化为止。

4.加权负载平衡(Weighted Load Balancing)

它根据服务器的权重值来分配负载。每个服务器都被分配了一个权重值,权重值越高的服务器分配到的请求越多。

在 Nginx 中,可以使用 upstream 模块中的 server 指令的 weight 参数来设置服务器的权重值。例如:

upstream backend {

server 192.168.60.1 weight=10;

server 192.168.60.2 weight=5;

server 192.168.60.3 weight=3;

}

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://backend;

}

}

在上面的例子中,服务器 192.168.60.1的权重值是

10,而服务器 192.168.60.2的权重值是

5,服务器 192.168.60.3 的权重值是 3。当 Nginx 收到请求时,它会按照负载因子策略,以服务器的权重值来分配请求。具体来说,如果服务器的权重值是 W,那么该服务器被分配到的请求比其他服务器多 W 倍。

需要注意的是,在使用负载因子策略时,服务器的性能和负载应该被准确地估计,以便为服务器分配合适的权重值。否则,如果权重值设置不合理,可能会导致某些服务器的负载过高或过低,从而影响整个系统的性能。

5.URL 哈希(URL Hash)

URL 哈希(URL Hash)是 Nginx 负载均衡中的一种策略,它根据请求的 URL 进行哈希运算,并将结果映射到后端服务器。通过这种方式,可以将同一 URL 的请求都分配到同一个后端服务器上,从而实现会话保持(Session Persistence)的效果。

下面是一个使用 URL 哈希策略的 Nginx 配置示例:

upstream backend {

hash $request_uri;

server 192.168.60.1 ;

server 192.168.60.2 ;

server 192.168.60.3 ;

}

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://backend;

}

}

这里我们使用hash指令将哈希算法设置为URL哈希,$request_uri表示使用请求的URL作为哈希值。然后定义3个后端服务器,分别为192.168.60.1和192.168.60.2和192.168.60.3 。

需要注意的是,使用 URL 哈希策略时,如果后端服务器数量发生变化,会导致哈希映射表的变化,从而可能导致一部分请求需要重新分配到其他服务器上,这可能会影响系统的性能。因此,在使用 URL 哈希策略时,应该根据具体情况进行权衡和选择。

补充: nginx的健康检查

Nginx的健康检查是指Nginx服务器通过定期向后端服务器发送检查请求,检查服务器是否能够正常响应,从而判断服务器的健康状况。健康检查对于负载均衡和高可用性非常重要,因为它可以及时发现故障服务器并将流量从故障服务器转移到正常服务器,以保证服务的可靠性和稳定性。文章来源:https://www.toymoban.com/news/detail-407094.html

Nginx提供了两种健康检查的方法:基于HTTP请求的健康检查 基于TCP连接的健康检查文章来源地址https://www.toymoban.com/news/detail-407094.html

到了这里,关于【创作赢红包】Nginx四——Nginx实现负载均衡的多种策略的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!