1. 终端执行JPS命令验证

- master上

Last login: Sun Oct 9 08:44:41 2022 from master

[wangguowei@master ~]$ jps

3616 ResourceManager

4888 Jps

3384 SecondaryNameNode

3163 NameNode

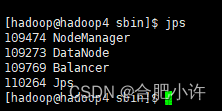

- slave上

Last login: Sun Oct 9 08:44:56 2022 from master

[wangguowei@slave0 ~]$ jps

2529 DataNode

2657 NodeManager

3498 Jps

2. WEB页面监测运行状况

- master:9870

这是Hadoop自带的web监测软件,提供丰富的系统状态信息

自己理解:9870端口用来查看Hadoop中的hdfs运行状态

- master:18088

监测yarn的运行状况

自己理解:18088端口用来查看Hadoop中的yarn运行状态

这个只能看maser的,但是可以在master和slave真机中的浏览器来看

3. 运行MapReduce程序来对hadoop进行最终验证

这个程序是验证hadoop最重要的一环,虽然在1和2的验证中都通过,但也并不意味着系统可以正常工作

[wangguowei@master mapreduce]$ pwd

/home/wangguowei/hadoop-3.1.0/share/hadoop/mapreduce

[wangguowei@master mapreduce]$ ll

总用量 5572

-rw-r--r--. 1 wangguowei wangguowei 610607 9月 30 16:04 hadoop-mapreduce-client-app-3.1.0.jar

-rw-r--r--. 1 wangguowei wangguowei 803660 9月 30 16:04 hadoop-mapreduce-client-common-3.1.0.jar

-rw-r--r--. 1 wangguowei wangguowei 1654130 9月 30 16:04 hadoop-mapreduce-client-core-3.1.0.jar

-rw-r--r--. 1 wangguowei wangguowei 215596 9月 30 16:04 hadoop-mapreduce-client-hs-3.1.0.jar

-rw-r--r--. 1 wangguowei wangguowei 45330 9月 30 16:04 hadoop-mapreduce-client-hs-plugins-3.1.0.jar

-rw-r--r--. 1 wangguowei wangguowei 85388 9月 30 16:04 hadoop-mapreduce-client-jobclient-3.1.0.jar

-rw-r--r--. 1 wangguowei wangguowei 1658663 9月 30 16:04 hadoop-mapreduce-client-jobclient-3.1.0-tests.jar

-rw-r--r--. 1 wangguowei wangguowei 126141 9月 30 16:04 hadoop-mapreduce-client-nativetask-3.1.0.jar

-rw-r--r--. 1 wangguowei wangguowei 98337 9月 30 16:04 hadoop-mapreduce-client-shuffle-3.1.0.jar

-rw-r--r--. 1 wangguowei wangguowei 56745 9月 30 16:04 hadoop-mapreduce-client-uploader-3.1.0.jar

-rw-r--r--. 1 wangguowei wangguowei 316222 9月 30 16:04 hadoop-mapreduce-examples-3.1.0.jar

drwxr-xr-x. 2 wangguowei wangguowei 4096 3月 30 2018 jdiff

drwxr-xr-x. 2 wangguowei wangguowei 4096 3月 30 2018 lib-examples

drwxr-xr-x. 2 wangguowei wangguowei 4096 3月 30 2018 sources

[wangguowei@master mapreduce]$

运行MapReduce的jar包来进行验证

Hadoop集群的基本命令

命令格式hadoop fs -xx [option]

- 创建目录

- 查看文件列表

- 文件上传

- 文件下载

- 查看hdfs中文件的内容

- 删除hdfs中的文件

写在最后

hadoop是一种开源系统,且处于不断地进化中,出现各类问题是很正常的。从某种意义上来说,开发和应用Hadoop大数据生态系统,就是一个不断面对各种问题,需要持续努力和耐心去应对的过程。

文章来源:https://www.toymoban.com/news/detail-408611.html

文章来源:https://www.toymoban.com/news/detail-408611.html

从9月26日开始到2022年10月9日,14天的时间,最后一个pi程序的成功运行,标志着前4章内容的学习彻底完成,感慨万分,心情也非常地激动。这一路学习走来,遇到了各种困难,一路走来,真的是只有自己才知道这个过程有多么的艰辛,自己的计算机水平也更上了一层楼,真的是挑战了对自己很生疏的东西,感谢自己。相信自己通过这一段内容的学习,对自己以后的学习工作生活上都会有巨大帮助。继续努力,加油!

最后一个PI程序运行的成功,我也就变强了

写于2022年10月9日11:34:53文章来源地址https://www.toymoban.com/news/detail-408611.html

到了这里,关于【非常重要】Hadoop成功启动的验证与集群的基本应用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!