关注公众号,发现CV技术之美

笔者言: XPixel的又一力作,作者在各个方面分析了应用在Transformer中使用各种现有对齐方法,进一步说明了保存亚像素信息的重要性,并提出图像补丁对齐方法,在REDS4上达到了32.72db。

作者单位:清华深研院、上海人工智能实验室、悉尼大学等

论文名称:Rethinking Alignment in Video Super-Resolution Transformers

论文链接:https://arxiv.org/pdf/2207.08494.pdf

01

看点

对齐向来是 VSR 中的重要操作,然而自注意机制的进展可能会违背这一常识。本文重新思考了 Transformer VSR 中对齐的作用,并进行了一些反直觉的观察。

实验表明:

Transformer VSR 可以直接使用未对齐的多帧信息

现有的对齐方法可能并不适用 Transformer VSR

观察表明,简单的移除对齐模块并采用更大的注意窗口可以进一步提高 Transformer VSR 的性能。然而,这种设计将大大增加计算负担,并不能处理大的运动。为此,本文提出了一种补丁对齐方法,该方法利用图像补丁代替像素进行对齐以实现SOTA表现。

02

方法

VSR Transformer

本研究中使用的 VSR 骨干网络基于移位窗口机制,如下图所示:

其中,使用一个2维卷积作为特征提取模块,MFSAB 由 SwinIR 中的 RSTB 修改而来。在数据集的选择上,REDS 和 Vimeo-90K 是使用最多的数据集。Vimeo-90K 数据集中的运动通常很小,99%的像素运动幅度小于10 (第4帧到第7帧)。不同的是,REDS 中至少有20%的像素的运动幅度大于10 (第3帧到第5帧)。本文使用 BI 来生成 LR。

对齐方法

现有对齐方法可分为四种,本实验中包含了各自的代表性方法,其中:

图像对齐 是最早最直观的对齐方法。图像对齐依赖于显式计算的帧间光流。根据估计的帧间运动,通过扭曲操作对不同的帧进行对齐。本文使用 SpyNet 来估计光流,并在训练过程中同时对 SpyNet 进行微调,采用 BI 作为重采样方法。

特征对齐 也可以估计光流,但是是对深度特征进行扭曲操作而不是图像。流估计模块仍然使用SpyNet,在训练时进行优化。除了上图中的二维卷积,此处还额外添加了5个残差块来提取深度特征。

变形卷积 方法采用可学习的动态可变形卷积进行对齐。几乎所有最先进的VSR网络都使用可变形卷积来进行对齐。本文以 BasicVSR++ 和 VRT 中使用的流引导变形卷积 (FGDC) 对齐作为代表方法。

无对齐 原始输入直接使用 VSR Transformer 进行处理。

对齐是否总是有利于 VSR Transformers

本文研究了在不同像素运动条件下,有对齐和没有对齐的 VSR Transformer 的性能差异,下图显示了在REDS数据集上测试的结果

首先从(a)可以观察到,像素运动较小时,VSR Transformer 可以在不对齐的情况下取得较好的效果。像素移动的范围与使用的窗口大小有关。由于在处理局部窗口内的像素时不存在局部感应偏差,Transformer可以处理这个范围内的不对齐。随着运动的增加,VSR所需要的信息超出了局部窗口的范围。此时,图像对齐可以提高性能。

本文随后增加了窗口大小,并进行相同的实验。如(b)所示。VSR Transformer 可以处理更大范围的未对齐像素和更大的窗口大小。这表明 VSR Transformer 对未对齐帧的处理能力与窗口大小有关,也意味着这种能力主要依赖于自注意机制。为了研究更好的对齐方法是否能够消除小运动的负面影响,(c)使用特征对齐进行了相同的实验。可以看出,特征对齐缩小了差距,但对小运动仍然有负面影响。

什么样的流更适合VSR?

虽然使用光流对齐可能会产生负面影响,但不同的流也可能导致性能的差异,如下图所示:

在训练 VSR 网络的同时优化流估计器会得到更好的结果,因为此时的流估计器学习优化的是 VSR 的流量。首先观察到,VSR Transformer 倾向于使用平滑流。流评估器 SpyNet 经过了 EPE 损失的预训练,这并不明确地鼓励平滑。

非平滑流会给VSR带来随机噪声,丢失亚像素信息。经过微调的 SpyNet 估计的流量越来越平滑,这体现在平均总变化量的减少上。平滑流保持对齐帧中相邻像素的相对关系,有利于VSR处理。尽管经过微调的流估计器将提高性能,但在RED数据集上进行流微调的图像对齐与不进行对齐之间仍然存在差距。

然而,我们在Vimeo-90K数据集上观察到不同的结果:有流微调的图像对齐几乎与没有对齐相同。这是因为使用Vimeo-90K对图像对齐进行微调时,流量慢慢减少到0。这种现象在VSR-CNN中并没有出现。这个实验很有启发性。一方面,Vimeo-90K数据集中的大多数移动都小于Transformer的窗口大小。经过微调的流量估计器似乎意识到了这一点,并学会了通过强制流量值为所有零来提高性能。

Transformer 是否隐式跟踪未对齐帧之间的运动

本文使用一个可解释性工具来进行可视化。局部归因图 (LAM) 是一种寻找对网络输出有强烈影响的输入像素点的归因方法。首先在输出图像上指定一个目标 patch,然后使用 LAM 生成相应的归因图。通过跟踪模型使用那些信息,查看相邻帧中的哪些像素贡献最大。

下图可以观察到,即使没有对齐模块,VSR Transformer 也可以自动将注意力转移到最相关的像素上。

为什么对齐方法有负面影响

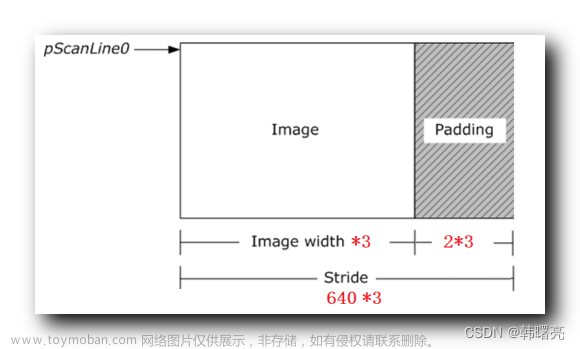

为了理解对对齐产生负面影响的原因,这需要知道 VSR 需要哪些亚像素信息。下采样时,HR帧中的高频信息会丢失,而LR帧中只剩下混叠模式。当HR帧移动时,产生不同的混叠模式。这些模式为VSR提供了额外的约束。然而,不准确的光流和双线性采样操作可能会破坏这些模式。

首先,不准确的流可以看作是地面真实流和随机误差项的组合。使用这种流随机对齐将改变LR模式,并导致信息丢失。其次,双线性重采样运算计算相邻四个像素的加权平均,而权值对于VSR模型是不可理解的。VSR模型只能处理转换后的LR模式,不能访问原始模式,导致信息丢失。

如下图所示,与图像对齐相比,特征对齐通过在亚像素信息被对齐破坏之前提取部分亚像素信息来提高性能。流引导变形卷积 (FGDC) 通过使网络模型几何变换减少对齐的负面影响。

将重采样方法改为最近邻也可以提高性能,因为该方法可以保留相邻像素之间的关系,并在一定程度上忽略流量估计的噪声。可以看出,使用NN重采样方法进行特征对齐的性能与FGDC方法相同,但显著减少了参数的数量。

补丁对齐

该方法的流程如下图所示。这种方法不对齐单个像素,而是将图像视为不重叠的补丁。补丁的分区与Transformer本地窗口的分区一致。我们将patch作为一个整体,对patch内的像素进行相同的操作。这样既保持了像素间的相对关系,又不会破坏补丁内的亚像素信息。

我们基于光流定位物体的运动,但不追求精确的像素级对齐。计算每个patch的平均运动向量,并在每个patch的支持帧中找到相应的patch。然后使用最近邻重采样方法将整个支撑块移动到它们在参考坐标系中的对应位置。最近邻重采样法忽略了光流估计的分数部分,减少了由于流估计不准确而造成的误差。

此外,对整个patch进行裁剪并移动到相应的位置,保留了patch内像素的相对关系,从而保留了亚像素信息。下图中展示了双线性重采样的图像对齐方法和我们提出的patch对齐方法的对比。

可以看到,图像对齐引入模糊和伪影到对齐的图像,破坏亚像素信息。补丁对齐可以保留更多的细节为VSR模型提供额外的信息。由于我们不追求像素级对齐,直接操作补丁将在补丁边界留下不连续的伪影。

但实验表明,这些不连续的影响很小。因为这些不连续不会出现在Transformer的本地窗口中,所以它们不会影响自注意的功能。

03

实验

定量评估

在REDS4上为32.72dB,RVRT为32.75dB。

END文章来源:https://www.toymoban.com/news/detail-408669.html

欢迎加入「超分辨率」交流群👇备注:SR文章来源地址https://www.toymoban.com/news/detail-408669.html

到了这里,关于重新思考 视频超分辨 Transformers 中的对齐的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!