目录

1、linux环境初始化及内核调优

(1)设置主机名、关闭防火墙、配置集群ip映射、关闭selinux

(2)禁用linux的透明大页、标准大页

(3)禁用swap分区

(4)配置集群时间同步,同步阿里云服务器时间

(5)linux内核参数调优

(6)配置ipvs

2、rke2安装k8s

(1)主节点安装执行

(2)从节点安装执行

(3)以上安装完成后在主节点1执行(一台主节点)

(4)主节点1配置启动完成后,在其他主节点执行以下命令进行配置

(5)以上主节点都启动后,接下来在所有从节点的进行以下配置

3、集群kubectl命令行工具优化

4、rke2集群升级问题

Kubernetes在1.20版之后已经废弃了Docker,而是使用Containerd作为容器运行时。

k8s在1.20之后的版本可以使用rke2来辅助部署。单纯使用rke2部署k8s的好处是可以把k8s集群和rancher解耦合。使rancher只负责管理k8s,即使rancher出问题也不影响k8s本身。

1、linux环境初始化及内核调优

注意:在rke2中master节点一定是etcd节点,保证etcd节点的选举有效,master节点一定要是奇数,本文准备3个节点实现k8s的高可用。

以下是每台节点都需要执行的:

(1)设置主机名、关闭防火墙、配置集群ip映射、关闭selinux

#设置主机名

hostnamectl set-hostname bd-rke1.xxxx.com

#设计集群ip映射

vi /etc/hosts

#关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

systemctl disable iptables

systemctl stop iptables

#关闭selinux

getenforce

setenforce 0

sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

getenforce

(2)禁用linux的透明大页、标准大页

在 Linux 中大页分为两种:Huge pages ( 标准大页 ) 和 Transparent Huge pages( 透明大页 ) 。内存是以块即页的方式进行管理的,当前大部分系统默认的页大小为 4096 bytes 即 4K。1MB 内存等于 256 页;1GB 内存等于 256000 页。

echo never > /sys/kernel/mm/transparent_hugepage/defrag

echo never > /sys/kernel/mm/transparent_hugepage/enabled

echo 'echo never > /sys/kernel/mm/transparent_hugepage/defrag' >> /etc/rc.local

echo 'echo never > /sys/kernel/mm/transparent_hugepage/enabled' >> /etc/rc.local

(3)禁用swap分区

echo 0 > /proc/sys/vm/swappiness

echo 'echo 0 > /proc/sys/vm/swappiness' >> /etc/rc.local

swapoff -a

#修改 /etc/fstab文件,注释掉 SWAP 的自动挂载

vi /etc/fstab

cat <<-EOF >> /etc/sysctl.conf

vm.swappiness=0

EOF

sysctl -p

free -h

chmod +x /etc/rc.d/rc.local(4)配置集群时间同步,同步阿里云服务器时间

yum install -y ntp

date

#修改配置文件:

vim /etc/ntp.conf

#注销默认Server

#server 0.rhel.pool.ntp.org iburst

#server 1.rhel.pool.ntp.org iburst

#server 2.rhel.pool.ntp.org iburst

#server 3.rhel.pool.ntp.org iburst

#添加:

server ntp1.aliyun.com prefer #阿里云的服务器时间

#保存退出

#启动ntp

systemctl start ntpd

#设置开启启动

systemctl enable ntpd

systemctl status ntpd(5)linux内核参数调优

#加载网桥过滤模块

modprobe br_netfilter

#查看是否成功

lsmod | grep br_netfilter

#添加网桥过滤和地址转发功能

cat <<- EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

# 下面的内核参数可以解决ipvs模式下长连接空闲超时的问题

net.ipv4.tcp_keepalive_intvl = 30

net.ipv4.tcp_keepalive_probes = 10

net.ipv4.tcp_keepalive_time = 600

EOF

#重新加载配置

sysctl -p

sysctl -p /etc/sysctl.d/k8s.conf(6)配置ipvs

yum install ipset ipvsadm

#需要加载模块写入脚本文件

cat <<EOF > /etc/sysconfig/modules/ipvs.modules

#!/bin/bash

modprobe -- ip_vs

modprobe -- ip_vs_rr

modprobe -- ip_vs_wrr

modprobe -- ip_vs_sh

modprobe -- nf_conntrack_ipv4

modprobe -- br_netfilter

EOF

chmod +x /etc/sysconfig/modules/ipvs.modules

/bin/bash /etc/sysconfig/modules/ipvs.modules

lsmod |grep -e ip_vs -e nf_conntrack_ipv4

lsmod | grep br_netfilter以下仅需要主节点执行:

安装rke2时,需要查看NetworkManager,保证它不会干扰rke2,保证cali*和flannel*的网卡不被NetworkManager管理

#安装rke2时,查看NetworkManager,保证它不会干扰rke2

systemctl is-active NetworkManager

cat <<EOF > /etc/NetworkManager/conf.d/rke2-canal.conf

[keyfile]

unmanaged-devices=interface-name:cali*;interface-name:flannel*

EOF

#cali*和flannel*的网卡不被NetworkManager管理

systemctl daemon-reload

systemctl restart NetworkManager2、rke2安装k8s

(1)主节点安装执行

rke2版本目录https://github.com/rancher/rke2/releases

#安装默认最新版本的rke2

curl -sfL https://get.rke2.io|sh -

#安装指定版本的rke2,这里vx.y.z为rke2版本号

curl -sfL https://get.rke2.io | INSTALL_RKE2_VERSION=vx.y.z sh -(2)从节点安装执行

#安装默认最新版本

curl -sfL https://get.rke2.io | INSTALL_RKE2_TYPE="agent" sh -

#指定版本执行以下命令

curl -sfL https://get.rke2.io | INSTALL_RKE2_TYPE="agent" INSTALL_RKE2_VERSION=vx.y.z sh -

(3)以上安装完成后在主节点1执行(一台主节点)

systemctl start rke2-server

systemctl enable rke2-server

#查看第一次启动后生成的文件

ll /var/lib/rancher/rke2/

ll /var/lib/rancher/rke2/bin/

ll /etc/rancher/rke2/这里的rke2.yaml 相当于admin.conf 谁拥有该文件就有rke2集群控制权

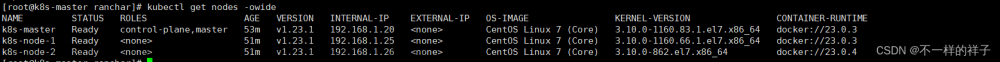

#查看node节点和pod启动情况

export KUBECONFIG=/etc/rancher/rke2/rke2.yaml

/var/lib/rancher/rke2/bin/kubectl get node

/var/lib/rancher/rke2/bin/kubectl get pod -A在主节点1执行上述命令,等待集群启动完成后,接着在该节点执行以下命令进行集群配置

#查看集群的唯一token

cat /var/lib/rancher/rke2/server/node-token复制上述token,vim /etc/rancher/rke2/config.yaml 编辑这个文件

#/var/lib/rancher/rke2/server/node-token文件里面的token复制到这里

token: K102b4dfc868f2a36291d73365bb24aedc831efb7777bec9a9182fb1f62b2ebbc9d::server:ccfb808c305500b889ca2cd4c481b53c

tls-san:

- xxxx.com

node-name: "bd-kb-prd01.xxxx.com" #配置这台节点的名字,和主机名一样

#给主节点打上污点标记,使主节点不执行pod的任务,如果只想从节点执行工作任务,主节点不执行,取消这个注释。

#node-taint:

# - "CriticalAddonsOnly=true:NoExecute"

#打上master标记

node-label:

- "node=Master"

- "bd-kb-prd01.xxxx.com=Master"

#设置阿里云镜像地址,加速下载

system-default-registry: "registry.cn-hangzhou.aliyuncs.com"

#设置etcd快照策略

etcd-snapshot-retention: 2

etcd-snapshot-schedule-cron: '*/5 * * * *'

# 自定义垃圾回收机制,添加到所所节点

kubelet-arg:

- "eviction-hard=nodefs.available<1%,memory.available<10Mi"

- "eviction-soft-grace-period=nodefs.available=30s,imagefs.available=30s"

- "eviction-soft=nodefs.available<5%,imagefs.available<1%"重新加载配置并重启rke2

systemctl daemon-reload

systemctl restart rke2-server

#检查启动情况

/var/lib/rancher/rke2/bin/kubectl get node

/var/lib/rancher/rke2/bin/kubectl get pod -A(4)主节点1配置启动完成后,在其他主节点执行以下命令进行配置

把主节点1的 /etc/rancher/rke2/config.yaml 文件复制其他主节点

并在其他每一个主节点上进行修改,主要把节点名修改成当前节点主机名

vim /etc/rancher/rke2/config.yaml

#这里 bd-kb-prd01.xxxx.com 为主节点1的主机名

server: https://bd-kb-prd01.xxxx.com:9345

token: K102b4dfc868f2a36291d73365bb24aedc831efb7777bec9a9182fb1f62b2ebbc9d::server:ccfb808c305500b889ca2cd4c481b53c

tls-san:

- xxxx.com

node-name: "bd-kb-prd03.xxxx.com"

#node-taint:

# - "CriticalAddonsOnly=true:NoExecute"

node-label:

- "node=Master"

- "bd-kb-prd03.xxxx.com=Master"

#设置阿里云镜像地址,加速下载

system-default-registry: "registry.cn-hangzhou.aliyuncs.com"

#设置etcd快照策略

etcd-snapshot-retention: 2

etcd-snapshot-schedule-cron: '*/5 * * * *'

# 自定义垃圾回收机制,添加到所所节点

kubelet-arg:

- "eviction-hard=nodefs.available<1%,memory.available<10Mi"

- "eviction-soft-grace-period=nodefs.available=30s,imagefs.available=30s"

- "eviction-soft=nodefs.available<5%,imagefs.available<1%"加载配置并启动rke2

systemctl daemon-reload

systemctl start rke2-server

systemctl enable rke2-server等待启动完成,可以切换到主节点1查看其他主节点时候加入集群。

#等待,切换到master1查看状态

systemctl status rke2-server -l

export KUBECONFIG=/etc/rancher/rke2/rke2.yaml

/var/lib/rancher/rke2/bin/kubectl get node

/var/lib/rancher/rke2/bin/kubectl get pod -A(5)以上主节点都启动后,接下来在所有从节点的进行以下配置

把主节点1的 /etc/rancher/rke2/config.yaml 文件复制所有从节点

并在其他每一个从节点上进行修改,主要把从点名修改成当前节点主机名

vim /etc/rancher/rke2/config.yaml

#这里 bd-kb-prd01.xxxx.com 为主节点1的主机名

server: https://bd-rke0.xxxx.com:9345

token: K1095be49da65ea82a388d41720e83b3f68ac8a97cda987d3648939e8c01e252560::server:5e59442937d36c8f06c0b482d967d24e

#这里只需要配置节点名,一般是主机名

node-name: "bd-rke2.xxxx.com"

#给节点打上work的标记

node-label:

- "node=Worker"

- "bd-rke2.xxxx.com=Worker"

#配置阿里云镜像仓库,加速镜像下载

system-default-registry: "registry.cn-hangzhou.aliyuncs.com"

#从节点不需要配置etcd快照策略

# 自定义垃圾回收机制,添加到所所节点

kubelet-arg:

- "eviction-hard=nodefs.available<1%,memory.available<10Mi"

- "eviction-soft-grace-period=nodefs.available=30s,imagefs.available=30s"

- "eviction-soft=nodefs.available<5%,imagefs.available<1%"加载配置并启动rke2工作节点

systemctl daemon-reload

systemctl start rke2-agent

systemctl enable rke2-agent 等待启动完成,可以切换到主节点1查看从节点点时候加入集群的状态。

#等待,切换到master1查看状态

systemctl status rke2-server -l

export KUBECONFIG=/etc/rancher/rke2/rke2.yaml

/var/lib/rancher/rke2/bin/kubectl get node

/var/lib/rancher/rke2/bin/kubectl get pod -A附命令查看本机的containeded启动情况文章来源:https://www.toymoban.com/news/detail-410171.html

/var/lib/rancher/rke2/bin/crictl --runtime-endpoint=unix:///run/k3s/containerd/containerd.sock ps3、集群kubectl命令行工具优化

#设置后使用/var/lib/rancher/rke2/bin/kubectl get node等命令

#就不用export KUBECONFIG=/etc/rancher/rke2/rke2.yaml

mkdir ~/.kube

ln -s /etc/rancher/rke2/rke2.yaml ~/.kube/config

chmod 600 ~/.kube/config

#设置后使用/var/lib/rancher/rke2/bin/crictl --runtime-endpoint=unix:///run/k3s/containerd/containerd.sock ps

#不需要--runtime-endpoint=unix://

ln -s /var/lib/rancher/rke2/agent/etc/crictl.yaml /etc/crictl.yaml

#path设置

vi /etc/profile

export PATH=$PATH:/var/lib/rancher/rke2/bin

source /etc/profile现在就可以直接在该节点上执行kubectl get node命令进行操作了。 文章来源地址https://www.toymoban.com/news/detail-410171.html

4、rke2集群升级问题

########################### rke2升级问题 ############################

# server 升级 再执行

curl -sfL https://get.rke2.io | sh -

# worker 升级

curl -sfL https://get.rke2.io | INSTALL_RKE2_TYPE="agent" sh -

#server指定版本升级

curl -sfL https://get.rke2.io | INSTALL_RKE2_VERSION=vx.y.z sh -

# worker 指定版升级

https://get.rke2.io | INSTALL_RKE2_TYPE="agent" INSTALL_RKE2_VERSION=vx.y.z sh -

到了这里,关于使用rancher的rke2部署高可用的k8s集群的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!