ChatGPT真的“无敌”了吗????

1.简介

我们邀请ChatGPT参加一项关于算法和数据结构的本科计算机科学考试。我们把它的答案手抄到一张考卷上,然后在盲测的情况下,随机选200名参与的学生。我们发现ChatGPT以20.5(满分40分)的成绩勉强通过了考试。这一令人印象深刻的表现表明,ChatGPT确实可以成功完成大学考试等具有挑战性的任务。同时,我们考试中的问题在结构上与其他考试相似,解决的家庭作业题,以及可以在网上找到的教学材料,这些材料可能是ChatGPT训练数据的一部分。因此,从这个实验中得出ChatGPT对计算机科学有任何理解的结论是不充分的。我们也评估了GPT-4带来的改进。我们发现,GPT-4比GPT-3.5多获得17%的考试分数,达到了普通学生的表现。

2.介绍

许多人已经注意到ChatGPT1的功能OpenAI的一种新型聊天机器人模型令人印象深刻,该模型甚至可以成功完成大学考试等具有挑战性的现实任务。事实上,已有证据表明这可能是事实。此外,对模型响应的评估通常不是盲目的,这可能是有问题的,因为众所周知ChatGPT会产生需要解释的奇怪答案。因此,尽管有很多关于这个话题的讨论,到目前为止,关于ChatGPT在大学考试中的能力的系统证据很少。

3.ChatGPT(GPT-4对比GPT-3.5)参加计算机考试实验

我们提出了一个简单但严格的实验的结果,评估的能力。关于算法和数据结构的本科生计算机科学考试。我们在常规大学考试的同时进行了这个实验,这使我们能够在一个盲设置中与学生一起评估模型的反应。我们以简单的标准化格式提出了不同的考试问题,使ChatGPT能够对所有考试问题给出明确的答案。

表1:在我们的考试中,ChatGPT在10个不同的练习中获得的分数,与参加我们考试的200名学生获得的平均分数进行比较。

- 第一行描述了ChatGPT使用GPT-3.5基本模型获得的点。这是本文讨论的主要实验的结果,其中模型反应与学生反应一起盲目评分。ChatGPT-3.5获得了20.5分(满分40分)。

- 第二行描述了ChatGPT使用GPT-4基本模型获得的点。在这里,模型响应根据主实验中使用的相同评分方案进行评分,但评分不是盲目的。我们估计ChatGPT-4将获得约24分,达到平均学生的表现。

- 第三行表示参加考试的200名学生获得的平均分数。

实验的结果是,ChatGPT将以20.5分(满分40分)的成绩侥幸通过考试。这令人印象深刻,但也突出了当前模型版本的局限性。特别是,该模型的表现比参加考试的平均学生的表现更差(平均学生获得约24分,比较表1)。就考试相对标准化而言,ChatGPT的混合表现是有趣的。类似的考试在世界各地都有,并且涵盖了很多关于主题的信息。

我们也评估了GPT-4带来的改进。我们发现,使用GPT-4基础模型的ChatGPT在考试中比使用GPT-3.5基础模型的ChatGPT多获得17%的分数,达到了普通学生的成绩。

4.实验设计

4.1实验介绍

我们考虑一个关于算法和数据结构的入门课程的考试。考试内容包括排序算法、图遍历和动态规划。总的来说,考试涵盖的主题在世界各地都以类似的方式进行教学。考试包含不同类型的问题,包括多项选择题、写小题、写伪代码和画图。进行这个实验的想法并没有把考试中的练习偏向于ChatGPT的能力。

4.2 对ChatGPT提出问题

我们在与模型的19个不同的对话中提出了考试问题,依赖于考试的latex源文件。我们告诉模型,我们正在问计算机科学考试中关于算法的问题,并要求它提供简短、准确的答案,在整个过程中,我们并没有试图设计提示来引导模型走向更好或更差的答案,唯一的目标是,该模型将为所有问题提供明确的答案。

一些考试题目涉及数学、伪代码或图形。在本例中,我们简单地使用来自考试的latex源代码提示模型,如下例所示:

例如,当我们要求模型写一个小的证明时,它会用乳胶方程来回应。类似地,当我们要求模型完成伪代码时,它以有效的方式完成了给定的伪代码。

在与模型进行对话之后,我们将答案手写在一张试卷上,在这样做的过程中,我们当然将模型的所有乳胶输出“渲染”到纸张上。

4.3测试结果

在本节中,我们将讨论GPT-3.5的主要实验结果。所带来的改善GPT-4将在下一节讨论。主要结果是,ChatGPT获得20.5分(满分40分),通过了考试。由于要通过考试至少需要20分,ChatGPT仅以非常微弱的优势通过。

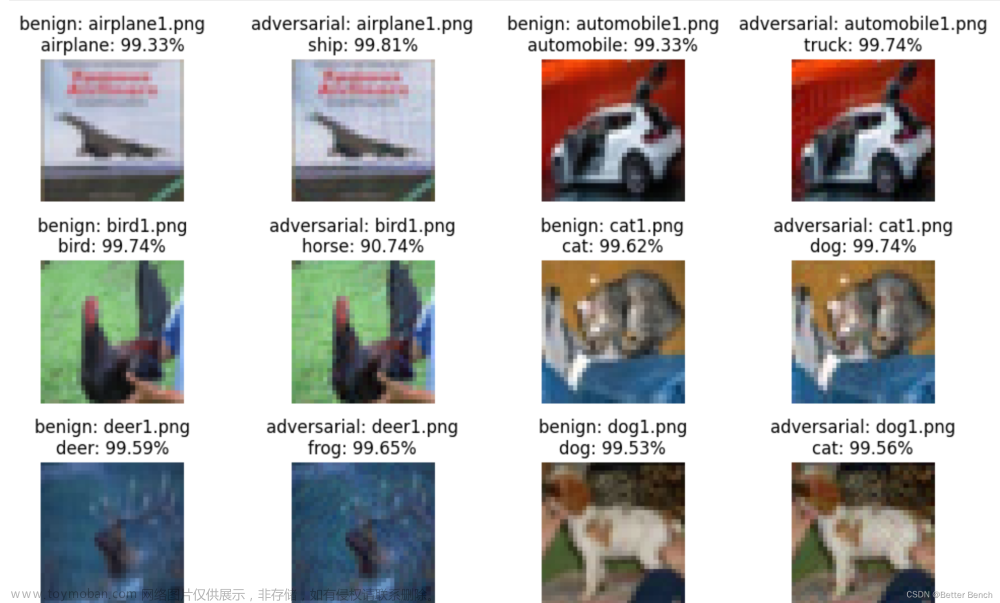

在考试的其他部分,ChatGPT给出了错误的答案,有时甚至是奇怪的答案,(如下图)特别是,该模型在涉及结构化输出(不是伪代码)的所有练习中都遇到了困难。

5. GTP-4

在本节中,除了本文考虑的主要实验外,我们还评估了GPT-4带来的改进。GPT-4技术报告在许多不同的考试中比较了GPT-4和GPT-3.5,并报告了巨大的性能提升(OpenAI, 2023)。然而,由于报告中使用的数据集不可用,因此很难复制和评估这些结果。然而,有人指出,有证据可以对训练数据进行测试。

总的来说,ChatGPT-4获得了24分(满分40分)。这是3.5个百分点,即17%ChatGPT与GPT-3.5基础模型。有趣的是,这意味着ChatGPT-4在我们的考试中与普通学生的表现相当。虽然改进看起来很小,但实际上它确实意味着ChatGPT-4能够回答一些更有挑战性的多项选择题,这些问题是以前版本的模型难以回答的。文章来源:https://www.toymoban.com/news/detail-410195.html

6. 讨论

我们的实验结果与现有的研究一致,这些研究记录了大型语言模型令人印象深刻的能力,以及它们严重的局限性。我们想强调的是,ChatGPT能够通过我们的考试这一事实并不意味着它对计算机科学有任何理解,就像我们可能期望它能够通过考试的人那样。当然可以合理地假设ChatGPT在培训过程中看到了许多与我们考试中相似的练习和解决方案。一般来说,为了了解像ChatGPT这样的模型的能力和局限性,需要进行更多的研究。文章来源地址https://www.toymoban.com/news/detail-410195.html

到了这里,关于【ChatGPT】参加计算机科学考试(GPT-4对比GPT-3.5)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!