前些天发现了一个巨牛的人工智能学习网站,内容通俗易懂、风趣幽默,忍不住想分享一下。对人工智能感兴趣的同学可以去看看哦

点击跳转到网站。

一、ELK日志分析系统概述

(1)传统日志服务器的优点与缺点和为什么要使用ELK日志分析系统

通常来说,日志被分散的存储在各自的不同的设备上,如果说需要管理上百台机器,那么就需要使用传统的方法依次登录这上百台机器进行日志的查阅,这样会使得工作效率即繁琐且效率低下。所以就引出了把日志集中化的管理方法。

例如: 开源的syslog,将所有的日志都放在一台服务器上进行汇总。

下面就是传统日志服务器的优点和缺点:

-

优点:

(1)提高安全性

(2)集中存放日志 -

缺点:

因为是集中存放日志,所有说对日志的分析是比较困难的

由上得知传统日志服务器的缺点就是不方便工作人员进行日志的统计、检索,那么一般工作人员会使用grep、awk和wc等linux命令进行统计和检索,但是对于更高要求的查询、排序、统计,再加上庞大的机器数量,再让工作人员使用这种方法就显得力不从心了。

而ELK日志分析系统就完美的解决了上面的问题。它是一个开源、实时的日志分析系统。

官方网站是: https://www.elastic.co/products

(2)ELK日志分析系统日志的分类

- 系统日志

- 应用程序日志

- 安全日志

日志分析是运维工程师解决系统故障,发现问题的主要手段。系统运维和开发人员可以通过日志了解服务器的软硬件信息,并且可以检查配置过程中的错误以及错误发生的原因。经常分析日志可以了解服务器的负荷,性能安全性,从而及时的采取措施纠正错误。

(3)ELK日志分析系统的分类

ELK日志分析系统是由三个完全开源的软件组合而成: Elasticsearch、Logstash、Kibana

——Elasticsearch:

Elasticsearch是一个开源的分布式搜索引擎, 特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。 它是基于Lucene的搜索服务器,提供了一个分布式多用户能力的全文搜索引擎。java开发,并且作为apache许可条款下的开放源码发布, 是第二流行的企业搜索引擎。设计用于云计算中,能够达到实时搜索,稳定、可靠、快速、安装使用方便。

概念:

- 接近实时:(NRT)

Elasticsearch是一个接近实时的搜索平台,这意味着,从一个索引到一个文档直到这个文档能够被搜索到会有一个轻微的延迟(通常是一秒)

- 集群:(cluster)

一个集群就是由一个或者多个几点组织在一起,它们共同持有整个的数据,并且一期提供索引和搜索功能。集群中会有一个节点作为主节点,这个主节点可以通过选举产生,并提供跨节点的联合索引和搜索的功能。

集群会有一个唯一性的标识名称,默认就是elasticsearch,集群的名称很重要,每个节点都是基于集群名称而加入到指定集群的,因此,必须确保在不同环境中使用不同的集群名称。

一个集群可以只有一个节点。最好在配置elasticsearch的时候,就配置成集群模式

- 节点:(node)

节点就是一台单一的服务器,它是集群的一部分,进行存储数据并且参与集群的索引和搜索功能。

和集群相同,节点也是通过名称来进行标识,默认是在节点启动时随机分配的字符名。也可以进行自定义,该名称用于在集群中识别服务器对应的节点,所以也很重要

- 索引:(index)

一个索引就是一个拥有相似特征的文档的集和。

例如: 就像在网上买东西,如果要买裤子,那么你会搜索裤子,然后就会出现各式各样的关于裤子的商品,或者在网上搜索某个明星的名字,就会出现这个明星相关的信息。

在一个集群中,一个索引由一个名字来进行标识,这个名称必须全部都是小写字母,也可以自定义索引。

索引相当于关系型数据库的库索引(库)——类型(表)——文档(数据)

- 类型:(type)

在一个索引中,用户可以定义一种或者多种类型,一个类型是你的索引的一个逻辑上的分类分区,其语义会完全由用户来定义。

通常来说,会为具有一组共同字段的文档定义一个类型。

例如: 上面说的要买裤子,这个时候如果搜索的是牛仔裤、休闲裤,这种的,其实就是加了一个类型。

类型相当于关系型数据库的表索引(库)——类型(表)——文档(数据)

- 文档:(document)

一个文档是一个可以被索引的基础信息单元。

例如: 搜索牛仔裤,出来的各式各样的牛仔裤,就可以看作是一个个信息。

在一个索引和类型里面,只要用户需要,可以存储任意多的文档,但是,虽然一个文档在物理上位于一个索引中,实际上一个文档必须在一个索引内被索引和给这个文档分配一个类型

文档相当于关系型数据库的数据索引(库)——类型(表)——文档(数据)

- 分片和副本:(shards and replicas)

分片: 在实际情况下,索引存储的数据可能超过单个节点的硬件限制,例如:存储10亿个文档需要1tb的空间,1tb的空间可能不适合存储在单个节点的磁盘上,或者说10亿个文档在单个节点的搜索请求太慢了。而为了解决这个问题,elasticsearch提供将索引分成多个分片的功能,当在创建索引时,可以自定义想要分片的数量,每一个分片就是一个全功能的独立的索引,可以位于集群中的任何节点上。

分片的两个最主要的原因:

(1)水平分割扩展,增大存储量

(2)分布式并行跨分片操作,提高了性能和吞吐量

副本: 分布式分片的机制和搜索请求的文档如何汇总完全是由elasticsearch控制的,这些对于用户而言是透明的。为了防止网络问题和其他的各种问题在任何时候的不请自来,一些用户建议要有一个故障切换机制,来应对任何故障而导致的分片或者节点的不可用。为此,elasticsearch让用户将索引分片进行复制一份或者多分,而这个就称之为分片副本或者副本。

副本的两个最主要的原因:

(1)高可用性,以应对分片或者节点出现故障,因为这个原因,分片副本要在不同的节点上

(2)增大吞吐量,搜索可以并行在所有副本上执行

总的来说,每个索引可以被分成多个分片,一个索引也可以被复制0次(即没有复制)或者多次,一旦复制了,每个索引就有了主分片 (即作为复制源的原来的分片) 和复制分片 (即主分片的拷贝) 的分别。 (也就是 说只要索引被复制了一次,那么就会产生主分片和复制分片也就是两个分片)

分片和副本的数量可以在索引创建的时候指定,在索引创建之后,用户可以在任何时候动态的改变副本的数量,但是之后用户无法改变分片的数量。

默认情况下,Elasticsearch中的每个索引都被分片成5个主分片和1个副本,这意味着,如果用户的集群中至少有两个节点,那么你的索引将会有5个主分片和另外5个副本分片还有一个索引的完全拷贝,这样的化每个索引总共就有10个分片

——Logstash:

Logstash是一个完全开源的工具,它可以对你的日志进行收集、过滤并且将其进行存储。 它是由JRuby语言编写,基于消息(message-based)的简单架构,并且运行在java虚拟机上(即JVM),不同于分离的代理段(agent)或者主机端(server),LogStash可以配置单一的代理段(agent)于其他开源软件结合,来实现不同的功能。

其实Logstash的理念很简单,只做三件事情:

(1)Collect:数据输入

(2)Enrich:数据加工,例如:过滤、改写等

(3)Transport:数据输出

别看Logstash只做三件事情,但是通过组合输入和输出,可以变化出多种架构从而实现各种需求。

Logstash主要组件:

- Shipper:

日志收集者,负责监控本地日志文件的变化,及时把日志文件的最新内容收集起来。通常,远程代理端(agent)只需要运行这个组件即可

- Indexer:

日志存储者,负责接收日志并且写入到本地文件

- Broker:

日志Hub(中心转发器), 负责连接多个Shipper和多个Indexer

- Search and Storage:

运行对事件进行搜索和存储

- Web Interface:

基于Web的展示界面

正因为上面的组件在Logstash架构中可以独立部署,才提供了更好的集群扩展性

Logstash主机分类

-

代理主机(agent host):

作为事件的传递着(Shipper),将各种日志数据发送至中心主机,只需要运行logstash代理程序(agent) -

中心主机(central host):

可以运行包括中间转发器(Broker)、索引器(Indexer)、搜索和存储器(Search and Storage)、Web界面端(Web interface)在内的各个组件,以实现对日志数据的接收、处理和存储。

——Kibana:

Kiabna是一个完全开源的工具,它可以为Logstash和Elasticsearch提供可视化的web界面。 并且可以帮助用户进行汇总、分析和搜索重要的数据日志。使用Kibana,可以通过各种图表进行高级数据分析以及展示。它让海量数据更容易理解,操作简单,基于浏览器的用户界面可以快速创建仪表盘(dashboard,一种图表)实时显示Elasticsearch查询动态。设置Kibana非常简单,无需编写代码,几分钟之内就可以完成Kibana的安装并且启动Elasticsearch索引监测。

Kibana主要功能:

-

Elasticsearch无缝之集成:

Kibana架构为Elasticsearch定制,可以将任何结构化和非结构化数据加入Elasticsearch索引。它还充分利用了Elasticsearch强大的搜索和分析功能 -

整合数据:

Kibana能够更好的处理海量的数据,并且创建柱形图、折线图、直方图等各种图表 -

复杂数据分析:

Kibana提升了Elasticsearch的分析能力,能够更加智能的分析数据,执行数学转换并且根据要求对数据切割分块 -

让更多团队成员收益:

强大的数据库可视化接口让各个业务岗位都能够从数据集和中收益 -

接口灵活,分享更容易:

使用Kibana可以更加方便的创建、保存、分享数据,并且将可视化数据进行快速交流 -

配置简单,可视化多数据源:

KIbana可以非常方便的把来自Logstash、ES-Hadoop、Beats或者第三方技术的数据整合到Elasticsearch,支持的第三方技术包括apache flume、fluentd等 -

简单数据导出:

Kibana可以方便的导出用户感兴趣的数据,并且与其他数据集和、融合后快速建模分析,发现新结果

(4)日志处理的步骤

Logstash收集AppServer产生的log,并且存放到ElasticSearch集群中,而Kibana则从ES集群中查询数据并且生成图表,再返回给Browser。总的来说,整个的过程需要进行以下几个步骤:

(1)将日志进行集中化管理(2)将日志格式化(Logstash)并且输出到Elasticsearch(3)对格式化后的数据进行索引和存储(Elasticsearch)(4)前端数据的展示(Kibana)

二、部署ELK日志分析系统

(1)实验环境

本次实验全部采用centos7.*系统

| 主机名称 | ip地址 | 扮演角色 | 内存 |

|---|---|---|---|

| node1 | 192.1683.100.1 | node节点 | >=2G建议4G |

| node2 | 192.168.100.2 | node节点 | >=2G建议4G |

-

node1部署:

(1)elasticsearch:端口 9200

(2)elasticsearch——head插件:端口 9100

(2)Kibana 日志分析平台: 端口 5601 -

node部署:

(1)elasticsearch:端口 9200

(2)logstash——日志采集

(2)实验目的

- 配置ELK日志分析集群

- 使用logstash收集日志

- 使用Kibana查看分析日志

(3)实验步骤

1、node1配置

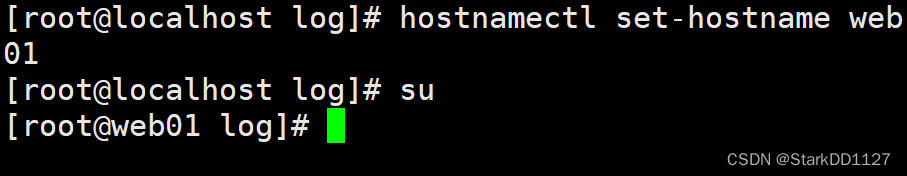

******(1)先做基础配置

[root@Centos7 ~]# hostnamectl set-hostname node1

[root@Centos7 ~]# su

[root@node1 ~]# systemctl stop firewalld

[root@node1 ~]# setenforce 0

setenforce: SELinux is disabled

[root@node1 ~]# mount /dev/cdrom /mnt/

mount: /dev/sr0 写保护,将以只读方式挂载

mount: /dev/sr0 已经挂载或 /mnt 忙

/dev/sr0 已经挂载到 /mnt 上

******(2)添加地址到hosts文件,可以解析elk-2主机

[root@node1 ~]# echo '192.168.100.1 elk-1' >> /etc/hosts

[root@node1 ~]# echo '192.168.100.2 elk-2' >> /etc/hosts

[root@node1 ~]# cat /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.100.1 node1

192.168.100.2 node2

[root@node1 ~]# bash (换一个bash环境更新配置)

2、node2配置

******(1)先做基础配置

[root@Centos7 ~]# hostnamectl set-hostname node2

[root@Centos7 ~]# su

[root@node2 ~]# systemctl stop firewalld

[root@noded2 ~]# setenforce 0

setenforce: SELinux is disabled

[root@node2 ~]# mount /dev/cdrom /mnt/

mount: /dev/sr0 写保护,将以只读方式挂载

mount: /dev/sr0 已经挂载或 /mnt 忙

/dev/sr0 已经挂载到 /mnt 上

******(2)添加地址到hosts文件,可以解析elk-1主机

[root@node2 ~]# echo '192.168.100.1 node1' >> /etc/hosts

[root@node2 ~]# echo '192.168.100.2 node2' >> /etc/hosts

[root@node2 ~]# cat /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.100.1 node1

192.168.100.2 node2

[root@node2 ~]# bash

3、node1和node2共同配置

******(1)安装java环境

[root@node1 ~]# yum -y install java

。。。。。。

完毕!

[root@node1 ~]# java -version

openjdk version "1.8.0_131"

OpenJDK Runtime Environment (build 1.8.0_131-b12)

OpenJDK 64-Bit Server VM (build 25.131-b12, mixed mode)

******(2)上传软件包并且安装

[root@node1 ~]# ll

总用量 69660

-rw-------. 1 root root 1264 1月 12 18:27 anaconda-ks.cfg

-rw-r--r-- 1 root root 33396354 3月 30 22:08 elasticsearch-5.5.0.rpm

-rw-r--r-- 1 root root 37926436 3月 30 22:08 elasticsearch-head.tar.gz

[root@node1 ~]# rpm -ivh elasticsearch-5.5.0.rpm (使用rpm安装)

。。。。。。

******(3)加载系统服务

[root@node1 ~]# systemctl daemon-reload

[root@node1 ~]# systemctl enable elasticsearch.service

Created symlink from /etc/systemd/system/multi-user.target.wants/elasticsearch.service to /usr/lib/systemd/system/elasticsearch.service.

******(4)更改主配置文件

[root@node1 ~]# cp /etc/elasticsearch/elasticsearch.yml /etc/elasticsearch/elasticsearch.yml.bak (先做一个备份)

[root@node1 ~]# vim /etc/elasticsearch/elasticsearch.yml

。。。。。。

16 #

17 cluster.name: my-elk-cluster #集群名称

18 #

。。。。。。

22 #

23 node.name: node1 #节点服务器名称,node2写node2即可

24 #

。。。。。。

32 #

33 path.data: /data/elk_data #数据存放路径

34 #

。。。。。。

36 #

37 path.logs: /var/log/elasticsearch/ #日志存放路径

38 #

。。。。。。

42 #

43 bootstrap.memory_lock: false #在启动时不锁定内存

44 #

。。。。。。

54 #

55 network.host: 0.0.0.0 #提供服务绑定的ip地址,0.0.0.0表示所有地址

56 #

。。。。。。

58 #

59 http.port: 9200 #侦听端口

60 #

。。。。。。

67 #

68 discovery.zen.ping.unicast.hosts: ["node1", "node2"] #集群发现通过单播传输实现

69 #

保存退出

******(5)利用scp传输到node2主机,修改部分内容即可

[root@node1 ~]# scp /etc/elasticsearch/elasticsearch.yml root@192.168.100.2:/etc/elasticsearch/elasticsearch.yml

The authenticity of host '192.168.100.2 (192.168.100.2)' can't be established.

ECDSA key fingerprint is SHA256:VhTZ5YxS5af2rHtfCvyc6ehXh3PD2A8KY2MyE6rHjiU.

ECDSA key fingerprint is MD5:e8:41:d2:8a:7e:e9:a9:47:a3:f0:29:be:e9:6d:df:51.

Are you sure you want to continue connecting (yes/no)? yes

Warning: Permanently added '192.168.100.2' (ECDSA) to the list of known hosts.

root@192.168.100.2's password:

elasticsearch.yml 100% 2853 3.7MB/s 00:00

******(6)创建数据存放路径并且授权

[root@node1 ~]# mkdir -p /data/elk_data

[root@node1 ~]# chown elasticsearch.elasticsearch /data/elk_data/

******(7)启动elasticsearch并且查看是否成功开启

[root@node1 ~]# systemctl start elasticsearch.service

[root@node1 ~]# netstat -anpt | grep 9200

tcp6 0 0 :::9200 :::* LISTEN 15622/java

现在就可以使用客户机先验证一下,访问:http://192.168.100.1:9200

查看集群的健康状态,显示:status:‘green’ 则节点健康运行,访问:http://192.168.100.1:9200/_cluster/health?pretty

查看集群状态信息,访问:http://192.168.100.1:9200/_cluster/state?pretty

因为这种查看方式及其不方便,所以可以考虑安装elasticsearch-head插件,方便管理集群

4、安装elasticsearch-head插件——node1和node2

可以先等node1安装完这个插件之后,node2在安装,安装时过程较长,node2可以先做上面的步骤

—————————————————————————————————扩展———————————————————————————————————

elasticsearch在5.0版本之后,elasticsearch-head插件需要作为独立服务进行安装

需要使用npm安装,并且需要提前安装node和phantomjs

node:基于chrome V8引擎和javascript运行环境

phantomjs:基于webkit的javascriptAPI。这个可以理解为一个隐形的浏览器,可以做到webkit浏览器的作用

————————————————————————————————————————————————————————————————————————

******(1)编译安装node,需要四十分钟左右

[root@node1 ~]# ll (上传node和phantomjs的软件包)

总用量 122152

-rw-------. 1 root root 1264 1月 12 18:27 anaconda-ks.cfg

-rw-r--r-- 1 root root 33396354 3月 30 22:08 elasticsearch-5.5.0.rpm

-rw-r--r-- 1 root root 37926436 3月 30 22:08 elasticsearch-head.tar.gz

-rw-r--r-- 1 root root 30334692 3月 30 23:13 node-v8.2.1.tar.gz

-rw-r--r-- 1 root root 23415665 3月 30 23:13 phantomjs-2.1.1-linux-x86_64.tar.bz2

[root@node1 ~]# tar xf node-v8.2.1.tar.gz

[root@node1 ~]# cd node-v8.2.1

[root@node1 node-v8.2.1]# ./configure && make && make install (时间较长,大约半小时左右)

******(2)安装phantomjs

[root@node1 ~]# ll

总用量 122156

-rw-------. 1 root root 1264 1月 12 18:27 anaconda-ks.cfg

-rw-r--r-- 1 root root 33396354 3月 30 22:08 elasticsearch-5.5.0.rpm

-rw-r--r-- 1 root root 37926436 3月 30 22:08 elasticsearch-head.tar.gz

drwxr-xr-x 10 502 games 4096 3月 30 23:45 node-v8.2.1

-rw-r--r-- 1 root root 30334692 3月 30 23:13 node-v8.2.1.tar.gz

-rw-r--r-- 1 root root 23415665 3月 30 23:13 phantomjs-2.1.1-linux-x86_64.tar.bz2

[root@node1 ~]# tar xf phantomjs-2.1.1-linux-x86_64.tar.bz2 -C /usr/src/

[root@node1 ~]# cp /usr/src/phantomjs-2.1.1-linux-x86_64/bin/phantomjs /usr/local/bin/

******(3)安装elasticsearch-head

[root@node1 ~]# tar xf elasticsearch-head.tar.gz -C /usr/src/ (解压)

[root@node1 ~]# cd /usr/src/elasticsearch-head/

[root@node1 elasticsearch-head]# npm install (使用npm安装)

npm WARN optional SKIPPING OPTIONAL DEPENDENCY: fsevents@^1.0.0 (node_modules/karma/node_modules/chokidar/node_modules/fsevents):

npm WARN network SKIPPING OPTIONAL DEPENDENCY: request to https://registry.npmjs.org/fsevents failed, reason: getaddrinfo ENOTFOUND registry.npmjs.org registry.npmjs.org:443

npm WARN elasticsearch-head@0.0.0 license should be a valid SPDX license expression

up to date in 2.707s

[root@node1 elasticsearch-head]# cd

******(4)修改elasticsearch主配置文件

[root@node1 ~]# vim /etc/elasticsearch/elasticsearch.yml

。。。。。。

末尾添加

http.cors.enabled: true #开启跨域访问支持,默认为false,所以需要改成true

http.cors.allow-origin: "*" #跨域访问允许所有的域名地址

保存退出

[root@node1 ~]# systemctl restart elasticsearch (重启服务)

******(5)启动elasticsearch-head服务

————————————————————注意!!!!—————————————————

此操作必须在解压的目录下启动,进程会读取目录中的gruntfile.js文件,否则可能会失败

监听端口为:9100

————————————————————————————————————————————————

[root@node1 ~]# cd /usr/src/elasticsearch-head/ (进入解压目录)

[root@node1 elasticsearch-head]# ll Gruntfile.js (查看指定文件)

-rw-r--r-- 1 root root 2231 7月 27 2017 Gruntfile.js

[root@node1 elasticsearch-head]# npm start & (挂到后台启动)

[1] 61130

[root@node1 elasticsearch-head]#

> elasticsearch-head@0.0.0 start /usr/src/elasticsearch-head

> grunt server

Running "connect:server" (connect) task

Waiting forever...

Started connect web server on http://localhost:9100

[root@node1 elasticsearch-head]# netstat -anpt | grep 9100 (检查是否成功启动)

tcp 0 0 0.0.0.0:9100 0.0.0.0:* LISTEN 61140/grunt

[root@node1 elasticsearch-head]# netstat -anpt | grep 9200

tcp6 0 0 :::9200 :::* LISTEN 1154/java

使用浏览器进行访问:http://192.168.100.1:9100

在最上面输入http://192.168.100.1:9200,点击连接,就可以看到node1节点了

******(6)插入索引,进行测试,索引名称为index-demo,类型为test

[root@node1 elasticsearch-head]# curl -XPUT '192.168.100.1:9200/index-demo/test/1?pretty&pretty' -H 'Content-Type:application/json' -d'{"aaa":"bbb","ccc":"ddd"}'

{

"_index" : "index-demo",

"_type" : "test",

"_id" : "1",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"created" : true

}

———————————————————选项——————————————————————

-X 指定命令,默认的命令是get

-P 通过ftp进行传输

-U 指定上传用户和密码

-T 指定上传

-H http协议的头部信息

-d 提交的数据信息

—————————————————————————————————————————————

使用浏览器查看

点击数据浏览,就会看到添加的索引 这个0-4就是五个分片

这个0-4就是五个分片

5、node2配置——安装logstash

Logstash使用管道方式进行日志的搜集处理和输出,有点像linux系统中的管道符"|",即执行完一个执行下一个

在Logstash中,包括了三个阶段:

输入input——处理filter(不是必须的)——输出output

这三个阶段都会有很多的插件来配置,比如:file、elasticsearch、redis等

每个阶段也可以指定多种方式,比如输出既可以输出到elasticsearch中,也可以指定到stdout在控制台打印,由于这种插件式的组织方式,使得logstash变得易于扩展和定制

logstash常用命令:

-f 通过这个命令可以指定logstash的配置文件,根据配置文件来配置logstash

-e 后面跟着字符串,该字符串可以被当作logstash的配置,如果是""则默认使用stdin作为输入,stdout作为输出

-t 测试配置文件是否正确,然后退出

******(1)安装logstash,安装这个需要java环境,之前两台node已经装过了

[root@node2 ~]# ll (上传logstash的rpm包)

总用量 161612

-rw-------. 1 root root 1264 1月 12 18:27 anaconda-ks.cfg

-rw-r--r-- 1 root root 33396354 3月 30 22:08 elasticsearch-5.5.0.rpm

-rw-r--r-- 1 root root 37926436 3月 30 22:08 elasticsearch-head.tar.gz

-rw-r--r-- 1 root root 94158545 3月 30 23:17 logstash-5.5.1.rpm

[root@node2 ~]# rpm -ivh logstash-5.5.1.rpm (使用rpm安装)

警告:logstash-5.5.1.rpm: 头V4 RSA/SHA512 Signature, 密钥 ID d88e42b4: NOKEY

准备中... ################################# [100%]

正在升级/安装...

1:logstash-1:5.5.1-1 ################################# [100%]

Using provided startup.options file: /etc/logstash/startup.options

OpenJDK 64-Bit Server VM warning: If the number of processors is expected to increase from one, then you should configure the number of parallel GC threads appropriately using -XX:ParallelGCThreads=N

Successfully created system startup script for Logstash

[root@node2 ~]# systemctl start logstash.service (开启服务)

[root@node2 ~]# ln -s /usr/share/logstash/bin/logstash /usr/local/bin/ (添加软连接,优化命令执行路径)

******(2)输入采用标准输入,输出采用标准输出

[root@node2 ~]# logstash -e 'input{stdin{}}output{stdout{}}'

。。。。。。

等待一段时间,当下面这段文字出现后再进行操作

The stdin plugin is now waiting for input:

01:47:27.213 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {:port=>9600}

www.baidu.com (手动输入)

2021-03-30T17:51:24.294Z node2 www.baidu.com (这个就是标准输出)

www.sina.com (手动输入)

2021-03-30T17:51:28.962Z node2 www.sina.com (标准输出)

Ctrl+C退出

******(3)使用rubydebug显示详细输出,dodec是一种编码器

[root@node2 ~]# logstash -e 'input { stdin{} } output { stdout { codec=>rubydebug } }'

。。。。。。

再次等待一段时间,出现下面字段后进行操作

01:56:30.916 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {:port=>9600}

www.baidu.com (标准输入)

{

"@timestamp" => 2021-03-30T17:56:36.133Z, (这个就是处理过后的输出)

"@version" => "1",

"host" => "node2",

"message" => "www.baidu.com"

}

Ctrl+C退出

******(4)使用logstash将信息写入到elasticsearch中,并且远程主机192.168.100.1:9200

[root@node2 ~]# [root@node2 ~]# logstash -e 'input { stdin{} } output { elasticsrch { hosts=>["192.168.100.1:9200"] } }'

。。。。。。

02:01:27.882 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {:port=>9600}

www.baidu.com (三个标准输入,会发现没有进行输出,这是因为发送到了elasticsearch中了)

www.sina.com

www.aaa.com

浏览http://192.168.100.1:9100查看结果

点击数据浏览,就会看到

******(5)编辑logstash配置文件,收集系统日志,输出到elasticsearch中

————————————————————————————————华丽分割线————————————————————————————————————

logstash配置文件基本上是由三部分组成的,input、output以及用户需要时才添加的filter

标准的配置文件格式为:

input{。。。。}

filter{。。。。}

output{。。。。}

在每个部分中,可以指定多个访问方式,例如:想要指定两个日志来源文件,那么就可以这样写,指定多个也是这种格式即可

input {

file { path => "/var/log/messages" type => "sylog" }

file { path => "/var/log/apache/access.log" type => "apache" }

}

—————————————————————————————————————————————————————————————————————————————

[root@node2 ~]# ll /var/log/messages

-rw-------. 1 root root 1184764 3月 31 02:06 /var/log/messages

[root@node2 ~]# chmod o+r /var/log/messages (给系统日志添加其他用户的只读权限)

[root@node2 ~]# ll /var/log/messages

-rw----r--. 1 root root 1185887 3月 31 02:07 /var/log/messages

[root@node2 ~]# ls /etc/logstash/conf.d/

[root@node2 ~]# vim /etc/logstash/conf.d/system.conf (编写一个新文件)

input {

file { #从文件中读取

path => "/var/log/messages" #文件路径

type => "system"

start_position => "beginning" #是否从头开始读取

}

}

output {

elasticsearch { #输出到elasticsearch中

hosts => ["192.168.100.1:9200"] #指定elasticsearch的主机地址和端口

index => "system-%{+YYYY.MM.dd}" #索引名称,这个是日期

}

}

保存退出

[root@node2 ~]# systemctl restart logstash (重启服务)

浏览器访问http://192.168.100.1:9100进行验证,查看是否有系统日志存在

6、node1安装Kibana

******(1)使用rpm方式安装kibana

[root@node1 ~]# ll kibana-5.5.1-x86_64.rpm (上传rpm包)

-rw-r--r-- 1 root root 52255853 3月 31 02:22 kibana-5.5.1-x86_64.rpm

[root@node1 ~]# rpm -ivh kibana-5.5.1-x86_64.rpm

。。。。。。

[root@node1 ~]# systemctl enable kibana (设置为开机自启)

Created symlink from /etc/systemd/system/multi-user.target.wants/kibana.service to /etc/systemd/system/kibana.service.

******(2)配置kibana主配置文件

[root@node1 ~]# vim /etc/kibana/kibana.yml

。。。。。。

2 server.port: 5601 #打开kibana的端口

3

。。。。。。

7 server.host: "0.0.0.0" #kibana侦听的地址,0.0.0.0为侦听所有

8

。。。。。。

21 elasticsearch.url: "http://192.168.100.1:9200" #和elasticsearch的主机建立连接,指定地址和端口

22

。。。。。。

30 kibana.index: ".kibana" #再elasticsearch中添加.kibana索引

31

。。。。。。

保存退出

******(3)启动Kibana服务

[root@node1 ~]# systemctl start kibana

[root@node1 ~]# netstat -anpt | grep 5601

tcp 0 0 0.0.0.0:5601 0.0.0.0:* LISTEN 1373/node

浏览器访问http://192.168.100.1:5601,进入kibana控制台

第一次登录需要添加一个elasticsearch索引,添加前面的索引即可

依次点击:

management——index patterns——create index patternindex name or pattern选项是索引名称,随便起就行,我这里添加system*time filter field name选项是设置时间过滤,选择I don't want to use the time filter

填写完后点击Create

点击Discover进行查看

可以点击这些选项进行筛选,想要筛选什么就点击该选项的”add“即可,然后会进行筛选

如果添加后想要取消这个筛选条件,点击指定选项的×号即可

三、扩展——添加apache日志

要求:将apache服务器的日志添加到elasticsearch并且通过kibana显示

添加一个主机,用于安装apache

| apache | 192.168.100.3 | 安装httpd和logstash |

|---|

-步骤

******(1)先做基础配置

[root@Centos7 ~]# hostnamectl set-hostname apache

[root@Centos7 ~]# su

[root@apache ~]# systemctl stop firewalld

[root@apache ~]# setenforce 0

setenforce: SELinux is disabled

[root@apache ~]# mount /dev/cdrom /mnt/

mount: /dev/sr0 写保护,将以只读方式挂载

mount: /dev/sr0 已经挂载或 /mnt 忙

/dev/sr0 已经挂载到 /mnt 上

******(2)安装摇晃httpd,并且写一个网页

[root@apache ~]# yum -y install httpd

。。。。。。

完毕!

[root@apache ~]# systemctl enable httpd

Created symlink from /etc/systemd/system/multi-user.target.wants/httpd.service to /usr/lib/systemd/system/httpd.service.

[root@apache ~]# systemctl start httpd

[root@apache ~]# echo "<h1>aaaaaaa</h1> " > /var/www/html/index.html

******(3)安装java

[root@apache ~]# yum -y install java

。。。。。。

完毕!

[root@apache ~]# java -version

openjdk version "1.8.0_131"

OpenJDK Runtime Environment (build 1.8.0_131-b12)

OpenJDK 64-Bit Server VM (build 25.131-b12, mixed mode)

******(4)上传logstash的rpm包,进行安装、配置

[root@apache ~]# ls

anaconda-ks.cfg logstash-5.5.1.rpm

[root@apache ~]# rpm -ivh logstash-5.5.1.rpm

[root@apache ~]# systemctl daemon-reload

[root@apache ~]# systemctl enable logstash.service

Created symlink from /etc/systemd/system/multi-user.target.wants/logstash.service to /etc/systemd/system/logstash.service.

[root@apache ~]# vim /etc/logstash/conf.d/apache_log.conf

input {

file {

path => "/etc/httpd/logs/access_log"

type => "access"

start_position => "beginning"

}

file {

path => "/etc/httpd/logs/error_log"

type => "error"

start_position => "beginning"

}

}

output {

if [type] == "access" {

elasticsearch {

hosts => ["192.168.100.1:9200"]

index => "apache_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error" {

elasticsearch {

hosts => ["192.168.100.1:9200"]

index => "apache_error-%{+YYYY.MM.dd}"

}

}

}

保存退出

[root@apache ~]# ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

[root@apache ~]# logstash -f /etc/logstash/conf.d/apache_log.conf

。。。。。。

03:07:07.932 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {:port=>9600}

www.aaaa.com (随便输入几个域名)

www.bbbbb.com

abc.www.com

-验证

登录kibana,访问http://192.168.100.1:9100查看索引是否存在

登录kibana界面添加索引,访问http://192.168.100.1:5601

和上面相同的方法,添加一个新的apache索引

文章来源:https://www.toymoban.com/news/detail-410236.html

文章来源:https://www.toymoban.com/news/detail-410236.html

至此,ELK日志分析平台搭建完成!!!!!文章来源地址https://www.toymoban.com/news/detail-410236.html

到了这里,关于运维必备——ELK日志分析系统的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!