问题简述

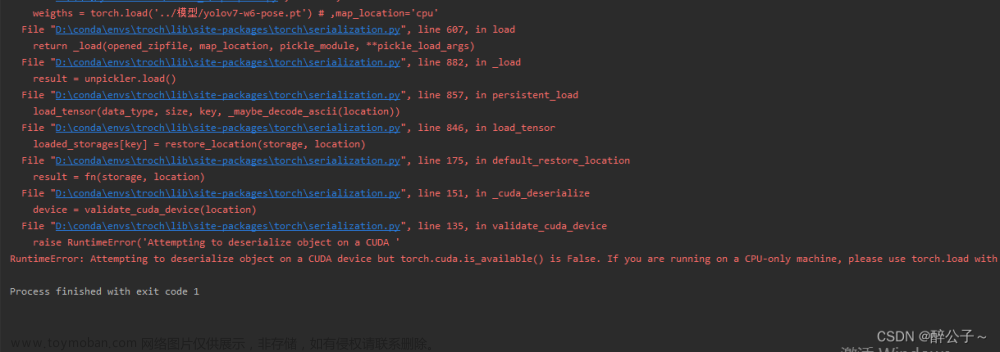

笔者在安装了CUDA、cuDNN、Torch后,发现仍无法调用GPU;

print(torch.cuda.is_available())始终返回false,查阅了网上各种方法都无效;

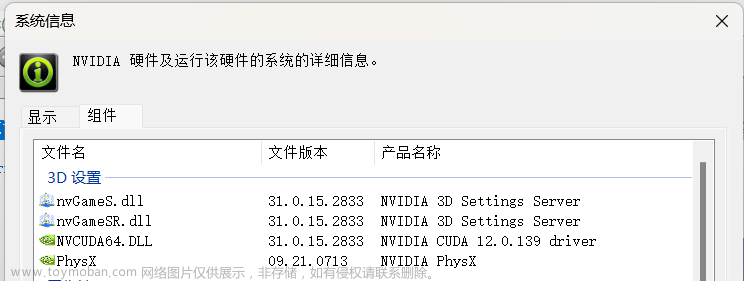

NVIDIA控制面板

nvidia-smi

CUDA支持版本

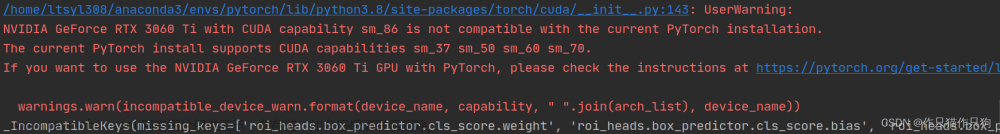

检查了CUDA版本、cuDNN版本也都正确;

解决方案

直到一次偶然,我在Pycharm中检查torch版本时,

import torch

print(torch.__version__)返回的居然是:

x.x.x+cpu遂恍然大悟,我原来装了个CPU版本的torch!这里提醒小伙伴,不要直接在pycharm里的PyPI里装torch,这里装的只是CPU版本。

读者可以复制这段代码自查:print(torch.__version__)。如果返回也是CPU版本,那么笔者建议按照以下步骤正确装入GPU版本torch:

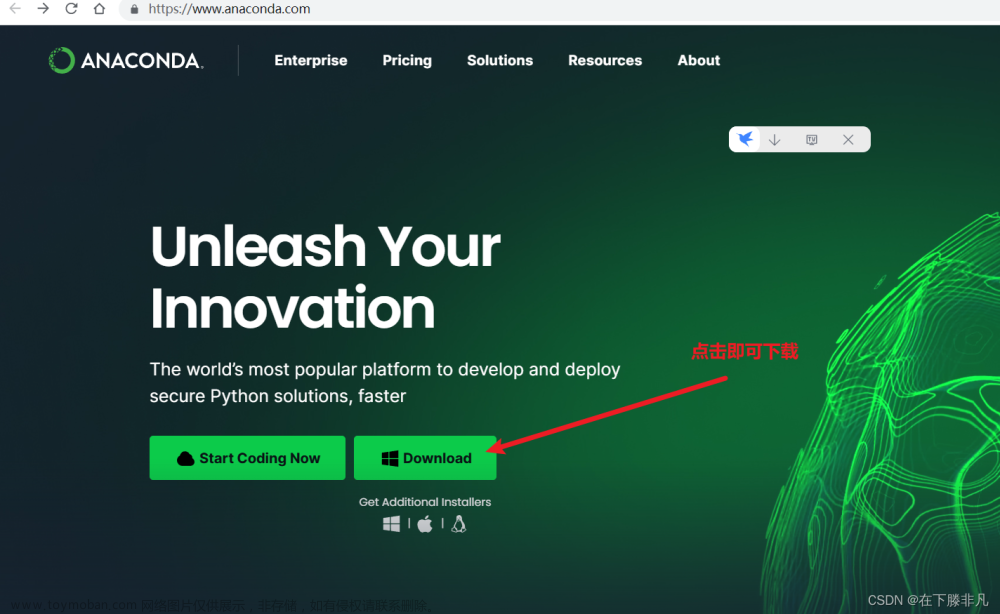

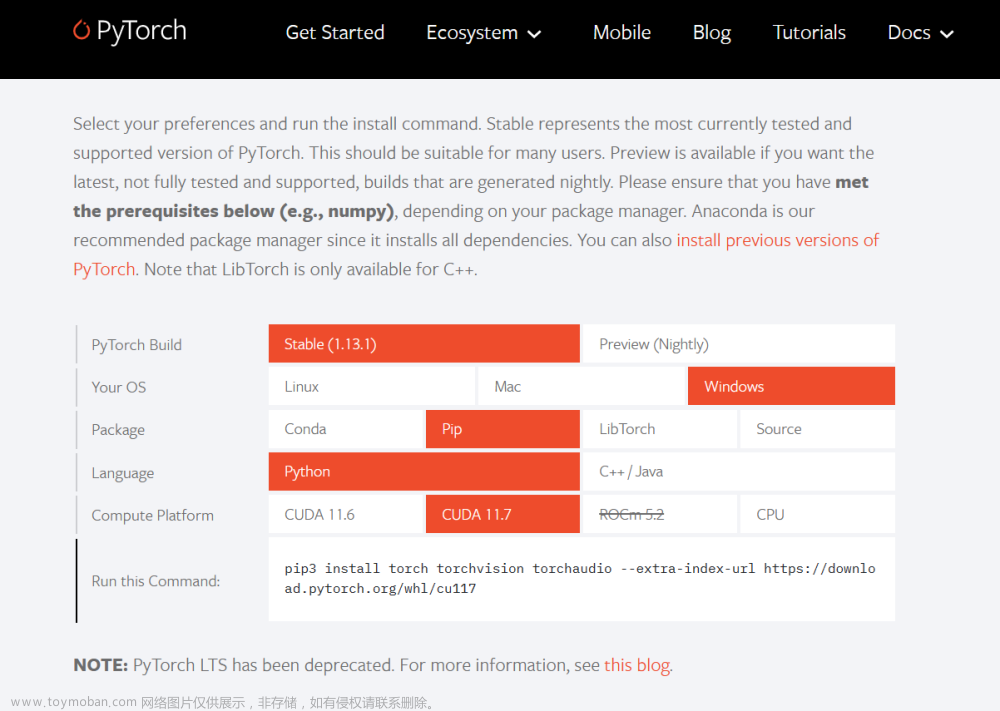

进入官网

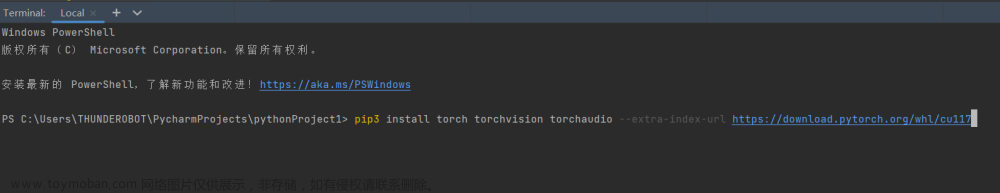

选择对应的版本pip指令

复制pip指令安装torch

验证

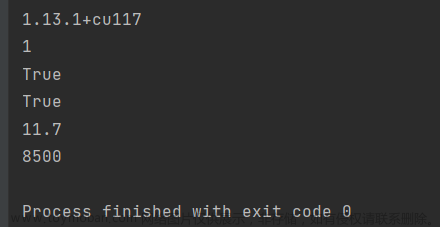

import torch

from torch.backends import cudnn

print(torch.__version__)

print(torch.cuda.device_count())

print(torch.cuda.is_available())

print(torch.backends.cudnn.is_available())

print(torch.cuda_version)

print(torch.backends.cudnn.version())结果:文章来源:https://www.toymoban.com/news/detail-410736.html

返回True ~文章来源地址https://www.toymoban.com/news/detail-410736.html

到了这里,关于解决print(torch.cuda.is_available())返回false的问题的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

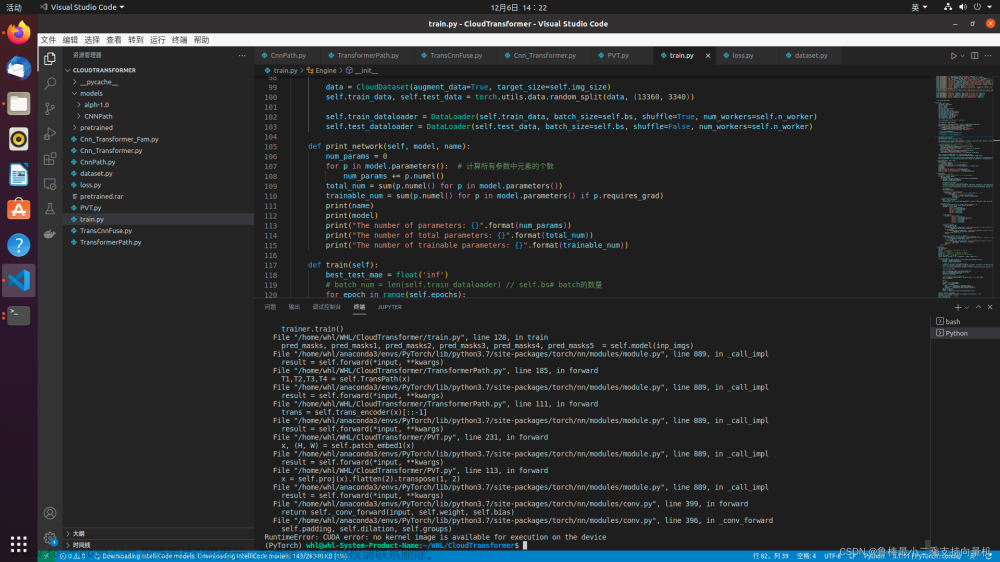

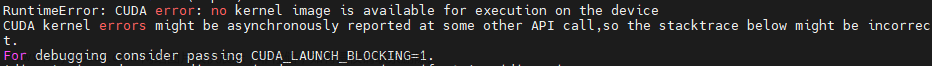

![[已解决]RuntimeError: CUDA error: no kernel image is available for execution on the device](https://imgs.yssmx.com/Uploads/2024/02/782952-1.png)