🍉零、引言

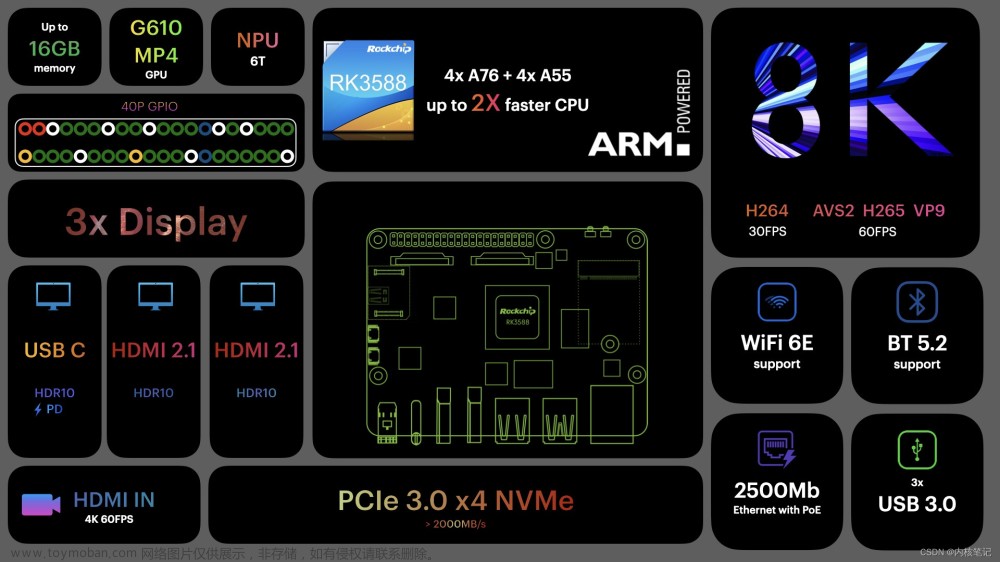

本文完成于2022-07-02 20:21:55。博主在瑞芯微RK3588的开发板上跑了deepsort跟踪算法,从IP相机中的server拉取rtsp视频流,但是fps只有1.2,和放PPT一样卡顿,无法投入实际应用。本来想使用tensorrt进行加速推理,但是前提需要cuda,rk的板子上都是Arm的手机gpu,没有Nvidia的cuda,所以这条路行不通。那么转过来,使用开发板自带的NPU进行加速推理,岂不是更加可行,而且它本身就是深度学习嵌入式板子,不用NPU真的可惜。文章来源:https://www.toymoban.com/news/detail-411650.html

🏅问题来了:怎么使用NPU?在开发板上还是在自己的PC上?要安装什么环境?怎么安装?这些问题都需要依次考虑清楚。因为我在此之前也没有接触过NPU,所以为此做了很多功课,看了很多教程,总计有10h以上。然后今天自己成功实践了下转换rknn模型,并使用npu推理。为了让后面的同学少走弯路,特此花1个h记录下这个使用过程,因为官方教程真的很不详细,很多地方都需要自己踩坑然后填好,那么开始正题!文章来源地址https://www.toymoban.com/news/detail-411650.html

到了这里,关于rk3588使用npu进行模型转换和推理,加速AI应用落地的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!