epoll 就绪队列应该使用什么数据结构?为什么?

在 Nginx 中,就绪队列通常使用链表来实现。具体来说,就绪队列是一个双向链表,其中每个节点都包含了一个 ngx_event_t 结构体,用于表示一个已经准备就绪的事件。当 epoll 检测到某个文件描述符上有 I/O 事件发生时,就会将相应的 ngx_event_t 对象加入到就绪队列中,并将其标记为已准备就绪。应用程序可以通过遍历就绪队列来获取所有已经准备好进行 I/O 操作的文件描述符,并进行相应的处理。

链表是一种非常高效的数据结构,它可以快速地插入、删除和遍历节点。在 Nginx 中,就绪队列通常是一个双向链表,这样可以方便地在队列头和队列尾进行插入和删除操作。另外,链表还可以动态地调整大小,从而适应不同的负载情况。因此,链表是一种非常适合用于实现就绪队列的数据结构。

需要注意的是,在多线程环境下,链表的插入、删除和遍历操作可能会存在竞争条件,从而导致程序的不稳定性和安全性。因此,在实际应用中,需要采取相应的措施来避免竞争条件的发生,例如使用互斥锁或读写锁来保护链表的操作。

关于如何使用互斥锁或读写锁来保护链表的操作

下面分别举例说明如何使用互斥锁和读写锁来保护链表的操作。

使用互斥锁

互斥锁是一种最基本的锁机制,它可以保证同一时间只有一个线程可以访问共享资源。在 Nginx 中,可以使用互斥锁来保护链表的操作,例如插入、删除和遍历操作。下面是一个简单的例子,演示了如何使用互斥锁来保护链表的操作:

#include <pthread.h>

#include <stdio.h>

#include <stdlib.h>

typedef struct node {

int data;

struct node *next;

} node_t;

node_t *head = NULL;

pthread_mutex_t mutex = PTHREAD_MUTEX_INITIALIZER;

void insert(int data) {

node_t *new_node = malloc(sizeof(node_t));

new_node->data = data;

new_node->next = NULL;

pthread_mutex_lock(&mutex);

if (head == NULL) {

head = new_node;

} else {

node_t *cur = head;

while (cur->next != NULL) {

cur = cur->next;

}

cur->next = new_node;

}

pthread_mutex_unlock(&mutex);

}

void delete(int data) {

pthread_mutex_lock(&mutex);

if (head == NULL) {

pthread_mutex_unlock(&mutex);

return;

}

if (head->data == data) {

node_t *tmp = head;

head = head->next;

free(tmp);

} else {

node_t *cur = head;

while (cur->next != NULL && cur->next->data != data) {

cur = cur->next;

}

if (cur->next != NULL) {

node_t *tmp = cur->next;

cur->next = cur->next->next;

free(tmp);

}

}

pthread_mutex_unlock(&mutex);

}

void traverse() {

pthread_mutex_lock(&mutex);

node_t *cur = head;

while (cur != NULL) {

printf("%d ", cur->data);

cur = cur->next;

}

printf("\n");

pthread_mutex_unlock(&mutex);

}

int main() {

insert(1);

insert(2);

insert(3);

traverse();

delete(2);

traverse();

return 0;

}

在上面的例子中,我们使用了一个互斥锁来保护链表的操作。具体来说,当需要插入、删除或遍历链表时,我们先获取互斥锁,然后进行相应的操作,最后释放互斥锁。这样可以保证同一时间只有一个线程可以访问链表,从而避免竞争条件的发生。

- 使用读写锁

读写锁是一种特殊的锁机制,它可以同时支持多个读操作和单个写操作。在 Nginx 中,可以使用读写锁来保护链表的操作,例如遍历操作。下面是一个简单的例子,演示了如何使用读写锁来保护链表的遍历操作:

#include <pthread.h>

#include <stdio.h>

#include <stdlib.h>

typedef struct node {

int data;

struct node *next;

} node_t;

node_t *head = NULL;

pthread_rwlock_t rwlock = PTHREAD_RWLOCK_INITIALIZER;

void insert(int data) {

node_t *new_node = malloc(sizeof(node_t));

new_node->data = data;

new_node->next = NULL;

pthread_rwlock_wrlock(&rwlock);

if (head == NULL) {

head = new_node;

} else {

node_t *cur = head;

while (cur->next != NULL) {

cur = cur->next;

}

cur->next = new_node;

}

pthread_rwlock_unlock(&rwlock);

}

void traverse() {

pthread_rwlock_rdlock(&rwlock);

node_t *cur = head;

while (cur != NULL) {

printf("%d ", cur->data);

cur = cur->next;

}

printf("\n");

pthread_rwlock_unlock(&rwlock);

}

int main() {

insert(1);

insert(2);

insert(3);

traverse();

return 0;

}

在上面的例子中,我们使用了一个读写锁来保护链表的遍历操作。具体来说,当需要遍历链表时,我们先获取读锁,然后进行遍历操作,最后释放读锁。这样可以允许多个线程同时读取链表,从而提高程序的并发性能。当需要插入、删除或修改链表时,我们需要获取写锁。

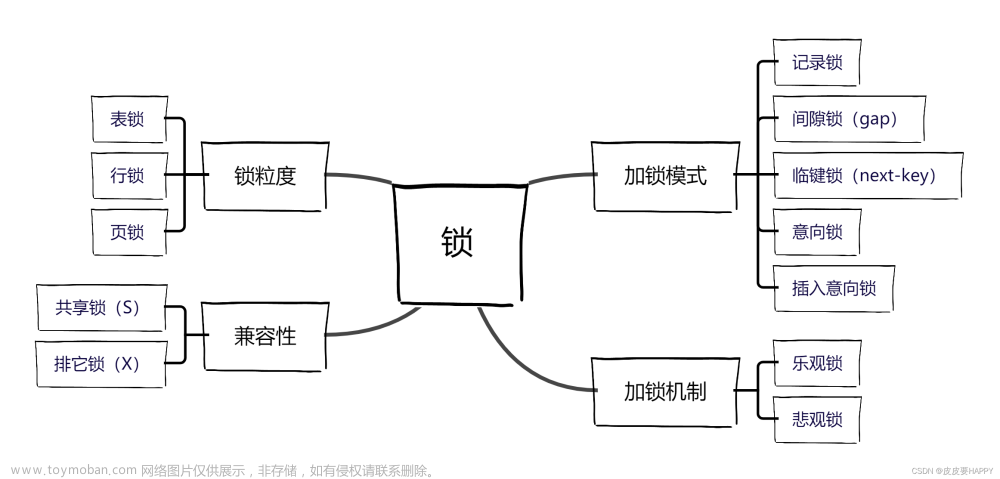

读写锁的粒度是不是比互斥锁的粒度会更小一些?

是的,读写锁的粒度比互斥锁的粒度要小一些。

互斥锁是一种最基本的锁机制,它可以保证同一时间只有一个线程可以访问共享资源。在使用互斥锁时,需要将整个临界区域都加锁,从而保证同一时间只有一个线程可以访问共享资源。这样会导致其他线程在等待锁的时候被阻塞,从而降低程序的并发性能。

读写锁是一种特殊的锁机制,它可以同时支持多个读操作和单个写操作。在使用读写锁时,可以将读操作和写操作分别加锁,从而提高程序的并发性能。具体来说,当需要进行读操作时,可以获取读锁,允许多个线程同时读取共享资源;当需要进行写操作时,需要获取写锁,此时其他线程都被阻塞,直到写操作完成。这样可以避免多个线程同时写入共享资源,从而提高程序的并发性能。

因此,读写锁的粒度比互斥锁的粒度要小一些,可以更细粒度地控制对共享资源的访问。但是,需要注意的是,在使用读写锁时需要考虑到读写锁本身的开销,以及读写锁的使用场景是否适合。如果读操作远远多于写操作,那么使用读写锁可以提高程序的并发性能;如果写操作比较频繁,那么使用互斥锁可能更为合适。

还有什么比较优势的锁机制吗?

除了互斥锁和读写锁之外,还有一些比较优势的锁机制,例如自旋锁、条件变量和信号量等。

自旋锁

自旋锁是一种特殊的锁机制,它可以避免线程的上下文切换,从而提高程序的并发性能。在使用自旋锁时,线程会一直循环等待锁的释放,直到获取到锁为止。如果锁被其他线程持有,那么当前线程会一直循环等待,直到锁被释放。自旋锁适用于锁的持有时间比较短的场景,例如对共享变量的读写操作。

条件变量

条件变量是一种特殊的同步机制,它可以让线程在满足特定条件时才进行操作。在使用条件变量时,线程会等待某个条件的满足,如果条件不满足,线程会进入等待状态,直到条件满足为止。条件变量通常与互斥锁一起使用,以避免竞争条件的发生。条件变量适用于需要等待某个事件发生的场景,例如等待网络连接的建立或者等待某个资源的释放。

信号量

信号量是一种特殊的同步机制,它可以控制对共享资源的访问。在使用信号量时,可以设置一个计数器,用于表示当前可用的资源数量。当线程需要访问共享资源时,需要先获取信号量,如果当前可用的资源数量为 0,那么线程会进入等待状态,直到有资源可用为止。当线程访问完共享资源后,需要释放信号量,以便其他线程可以继续访问共享资源。信号量适用于需要控制对共享资源的访问的场景,例如限制并发访问数量或者控制资源的分配。

自旋锁资源开销还是比较大的,虽然减少了上线文切换,但是一直占用cpu与内存,有什么优化方案?

自旋锁的资源开销比较大,因为它会一直占用 CPU 和内存,直到获取到锁为止。因此,在使用自旋锁时需要考虑到锁的持有时间和锁的竞争情况,以避免浪费系统资源。

自旋锁适用于锁的持有时间比较短的场景,例如对共享变量的读写操作。在这种情况下,线程等待锁的时间比较短,自旋锁可以避免线程的上下文切换,从而提高程序的并发性能。但是,如果锁的持有时间比较长,那么自旋锁会一直占用 CPU 和内存,从而降低程序的性能。

为了避免自旋锁的资源浪费,可以采用以下几种方法:

-

调整自旋次数

自旋锁通常会设置一个自旋次数,当自旋次数达到一定的阈值时,线程会放弃自旋,进入睡眠状态,等待锁的释放。通过调整自旋次数,可以避免自旋锁的资源浪费,提高程序的性能。 -

使用适当的优化选项

现代的编译器通常会提供一些优化选项,例如指令重排、内联函数等,可以优化自旋锁的性能。通过使用适当的优化选项,可以减少自旋锁的资源开销,提高程序的性能。文章来源:https://www.toymoban.com/news/detail-412093.html -

使用更高级别的同步机制

如果自旋锁的资源开销比较大,可以考虑使用更高级别的同步机制,例如条件变量、信号量等。这些同步机制可以更好地控制对共享资源的访问,避免竞争条件的发生,从而提高程序的性能。文章来源地址https://www.toymoban.com/news/detail-412093.html

到了这里,关于epoll准备就绪列表保护机制,引发的锁问题讨论的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!