说明:这是一个机器学习实战项目(附带数据+代码+文档+视频讲解),如需数据+代码+文档+视频讲解可以直接到文章最后获取。

1.项目背景

灰狼优化算法(GWO),由澳大利亚格里菲斯大学学者 Mirjalili 等人于2014年提出来的一种群智能优化算法。灵感来自于灰狼群体捕食行为。优点:较强的收敛性能,结构简单、需要调节的参数少,容易实现,存在能够自适应调整的收敛因子以及信息反馈机制,能够在局部寻优与全局搜索之间实现平衡,因此在对问题的求解精度和收敛速度方面都有良好的性能。缺点:存在着易早熟收敛,面对复杂问题时收敛精度不高,收敛速度不够快。

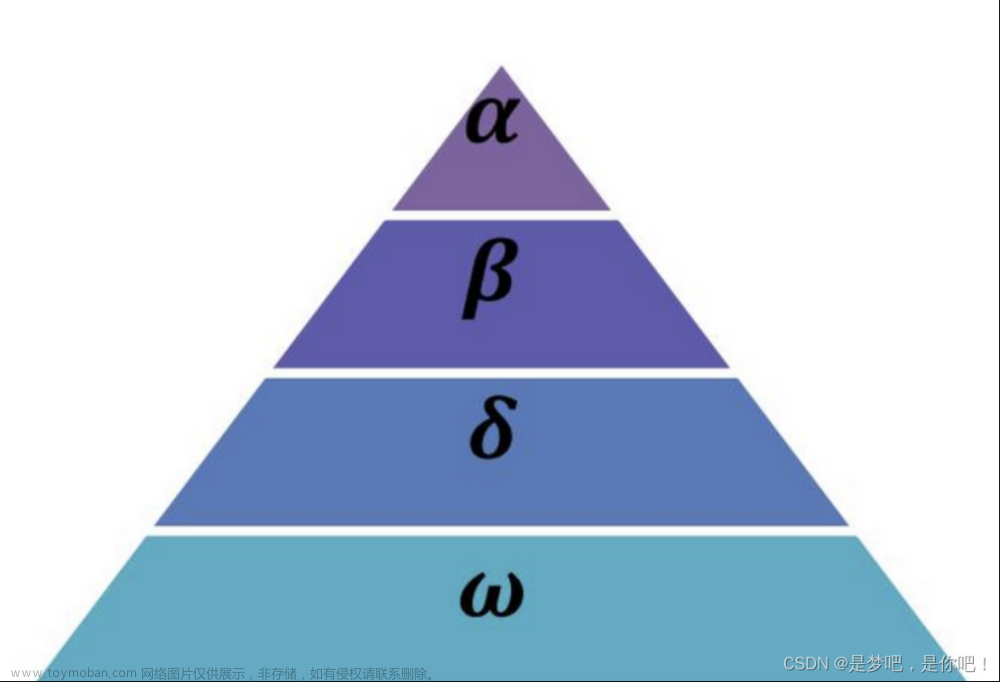

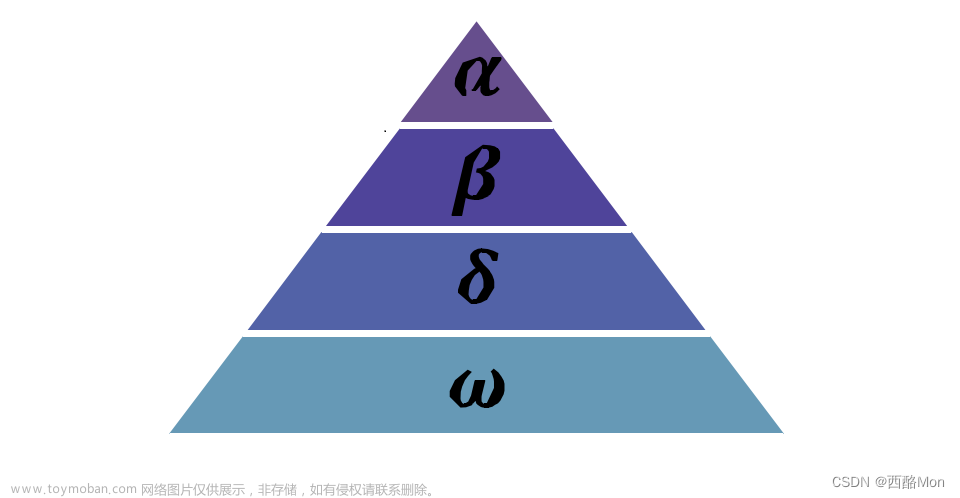

灰狼群体中有严格的等级制度,一小部分拥有绝对话语权的灰狼带领一群灰狼向猎物前进。灰狼群一般分为4个等级:αβδω(权利从大到小)模拟领导阶层。集体狩猎是灰狼的一种社会行为,社会等级在集体狩猎过程中发挥着重要的作用,捕食的过程在α的带领下完成。主要包括三个步骤:

- 跟踪和接近猎物

- 骚扰、追捕和包围猎物,直到它停止移动

- 攻击猎物

本项目通过GWO灰狼优化算法优化XGBoost分类模型。

2.数据获取

本次建模数据来源于网络(本项目撰写人整理而成),数据项统计如下:

数据详情如下(部分展示):

3.数据预处理

3.1 用Pandas工具查看数据

使用Pandas工具的head()方法查看前五行数据:

关键代码:

3.2数据缺失查看

使用Pandas工具的info()方法查看数据信息:

从上图可以看到,总共有10个变量,数据中无缺失值,共1000条数据。

关键代码:

3.3数据描述性统计

通过Pandas工具的describe()方法来查看数据的平均值、标准差、最小值、分位数、最大值。

关键代码如下:

4.探索性数据分析

4.1 y变量柱状图

用Matplotlib工具的plot()方法绘制直方图:

4.2 y=1样本x1变量分布直方图

用Matplotlib工具的hist()方法绘制直方图:

4.3 相关性分析

从上图中可以看到,数值越大相关性越强,正值是正相关、负值是负相关。

5.特征工程

5.1 建立特征数据和标签数据

关键代码如下:

5.2 数据集拆分

通过train_test_split()方法按照80%训练集、20%测试集进行划分,关键代码如下:

6.构建GWO灰狼优化算法优化XGBoost分类模型

主要使用GWO灰狼优化算法优化XGBClassifier算法,用于目标分类。

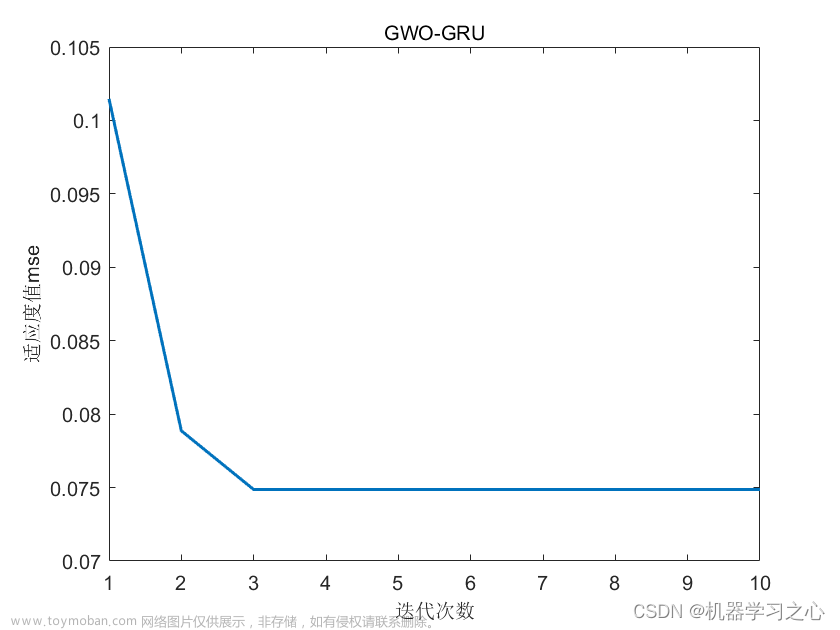

6.1 GWO灰狼优化算法寻找的最优参数

关键代码:

每次迭代的过程数据:

最优参数:

| ----------------4. 最优结果展示----------------- The best n_estimators is 100 The best learning_rate is 0.05 |

6.2 最优参数值构建模型

7.模型评估

7.1评估指标及结果

评估指标主要包括准确率、查准率、查全率、F1分值等等。

从上表可以看出,F1分值为0.8691,说明模型效果比较好。

关键代码如下:

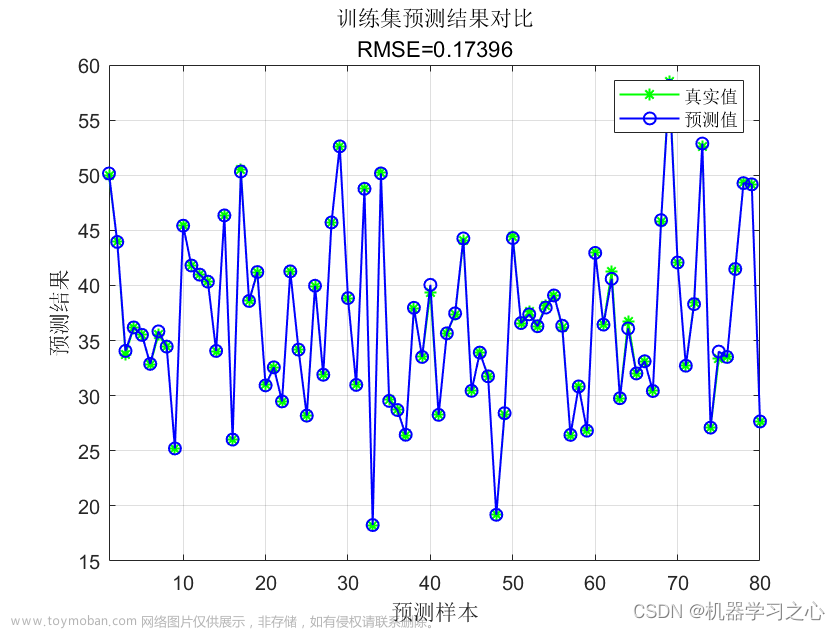

7.2 查看是否过拟合

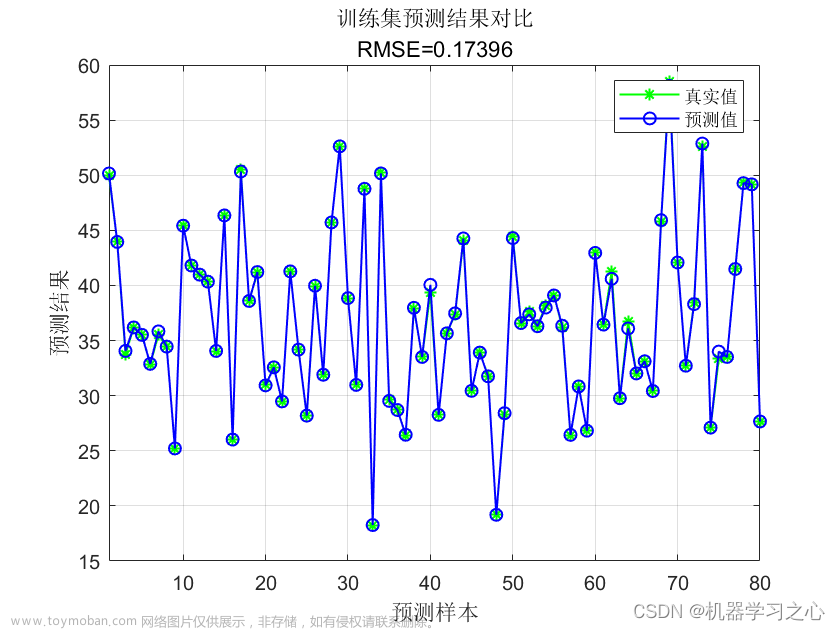

从上图可以看出,训练集和测试集分值相当,无过拟合现象。

7.3 分类报告

从上图可以看出,分类为0的F1分值为0.88;分类为1的F1分值为0.87。

7.4 混淆矩阵

从上图可以看出,实际为0预测不为0的 有13个样本;实际为1预测不为1的 有12个样本,整体预测准确率良好。

8.结论与展望

综上所述,本文采用了GWO灰狼优化算法寻找XGBoost分类算法的最优参数值来构建分类模型,最终证明了我们提出的模型效果良好。此模型可用于日常产品的预测。

# 本次机器学习项目实战所需的资料,项目资源如下:

# 项目说明:

# 链接:https://pan.baidu.com/s/1b75WXn1We2fezyp1-jnIEA

# 提取码:t5ib

更多项目实战,详见机器学习项目实战合集列表:文章来源:https://www.toymoban.com/news/detail-412476.html

机器学习项目实战合集列表_机器学习实战项目_胖哥真不错的博客-CSDN博客文章来源地址https://www.toymoban.com/news/detail-412476.html

到了这里,关于Python实现GWO智能灰狼优化算法优化XGBoost分类模型(XGBClassifier算法)项目实战的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!