一、前提

已经安装好Hadoop、Hive(可以启动hiveserver2)、Zeppelin

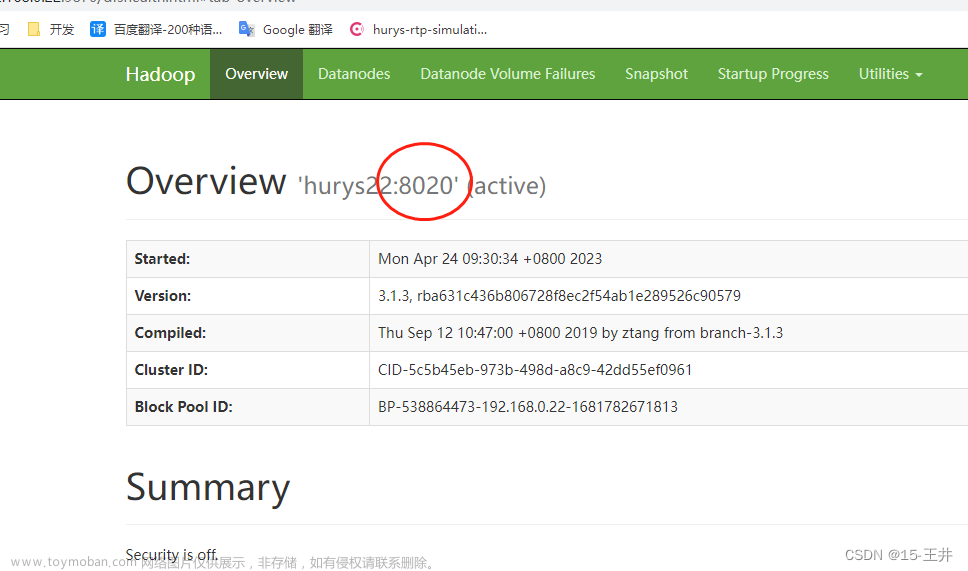

1.启动Hadoop

[root@hurys24 ~]# start-all.sh

2.启动hiveserver2

[root@hurys24 ~]# cd /opt/soft/hive312/conf/

[root@hurys24 conf]# nohup ../bin/hive --service hiveserver2 &

[1] 27593

[root@hurys24 conf]# nohup: ignoring input and appending output to ‘nohup.out’

[root@hurys24 conf]# beeline -u jdbc:hive2://hurys24:10000/ -n root

Connecting to jdbc:hive2://hurys24:10000/

Connected to: Apache Hive (version 3.1.2)

Driver: Hive JDBC (version 3.1.2)

Transaction isolation: TRANSACTION_REPEATABLE_READ

Beeline version 3.1.2 by Apache Hive

0: jdbc:hive2://hurys24:10000/>

3.启动Zeppelin

[root@hurys24 ~]# cd /opt/soft/zepplin090/bin/

[root@hurys24 bin]# ./zeppelin-daemon.sh start

Zeppelin start [ OK ]

三个都启动好后jps查看一下

二、登录Zeppelin页面

三、创建并配置 Interpreter

第一步,点击页面右侧anonymous——Interpreter注释器

第二步,点击Create创建新的注释器

第三步,在Interpreter Name中输入注释器的名字(自己随意,我这里填的是hive)

在Interpreter group中选择jdbc

第四步,在Properties部分

在default url jdbc:hive2://hurys24:10000 (这个根据自己服务器地址和端口号修改)

在default user root

在default driver org.apache.hive.jdbc.HiveDriver (这个必须一样)

第五步,在Dependencies

注意:在连接Hive1.1.0版本时是不需要配置这部分的,但是Hive3.1.2版本是一定要配置这部分的

Hive2.X的版本也需要配置这部分jar包(在一篇博客上看到过)

这些jar在自己Hive的安装路径的lib目录下都可以找到

主要分为7类jar包:一是jdbc;二是service;三是common;四是guava;五是exec; 六是cli;七是serde

(其中六与七是我看其他博客后来加上去的,一到五我自己测试过没问题,不过油多不坏菜,多加点jar包也不是坏事)

Hive3.1.2需要配置的jar包如下

/opt/soft/hive312/lib/hive-jdbc-3.1.2.jar

/opt/soft/hive312/lib/hive-jdbc-handler-3.1.2.jar

/opt/soft/hive312/lib/hive-service-3.1.2.jar

/opt/soft/hive312/lib/hive-service-rpc-3.1.2.jar

/opt/soft/hive312/lib/hive-common-3.1.2.jar

/opt/soft/hive312/lib/guava-27.0-jre.jar

/opt/soft/hive312/lib/hive-exec-3.1.2.jar

/opt/soft/hive312/lib/hive-cli-3.1.2.jar

/opt/soft/hive312/lib/hive-serde-3.1.2.jar

jar包配置好后,点击save保存即可

第六步,保存好后退出查看,hive注释器为绿色,说明已准备好

四、创建note

第一步,点击Notebook——Create new note

第二步,在Note Name输入hive0414(自己可以修改)

在Default Interpreter选择我们刚才新建的hive注释器

填好后,点击Create

五、测试并使用note

note一创建好就会直接进入,先写条SQL语句测试一下,注意没有分号

%hive

show databases

如果能够成功运行SQL,说明Zeppelin成功连接Hive312!!!

一定要注意创建Interpreter注释器Dependencies的jar包配置,很多博客都没有这部分,结果坑惨了!!!文章来源:https://www.toymoban.com/news/detail-413180.html

乐于奉献共享,帮助你我他!!!文章来源地址https://www.toymoban.com/news/detail-413180.html

到了这里,关于Zeppelin0.9.0 连接 Hive 3.1.2(踩坑,亲测有效)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[WinError 10061] 由于目标计算机积极拒绝,无法连接 亲测有效](https://imgs.yssmx.com/Uploads/2024/02/762162-1.png)