【ChatGLM】在电脑部署属于自己的人工智能

1、 前言

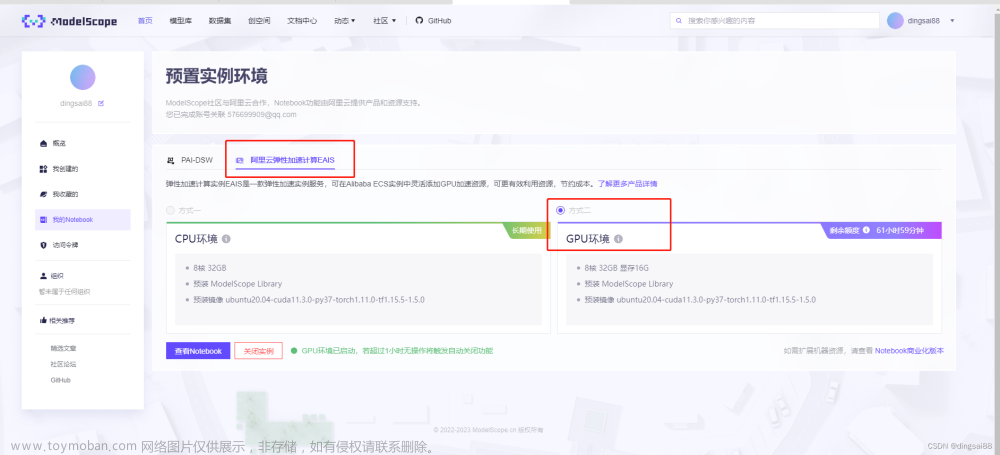

本文能实现在自己的电脑或云服务器上部署属于自己的语言AI——ChatGLM-6B,可以离线使用,也可以生成web网页在线发给朋友尝试。

ChatGLM-6B 是一个由清华大学的团队开源的、支持中英双语问答的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。本文旨在介绍如何在电脑部署属于自己的人工智能/可离线/可发布。这是一个有趣而有意义的项目,可以让你体验到人工智能的魅力,也可以让你拥有一个自己定制的智能助手。详情点击参考ChatGLM开发者博客

GPT 模型目前只有 GPT-2 的小规模版本(1.5 亿参数)是开源的,其它版本都是闭源的,只能通过 OpenAI 的 API 来访问。ChatGLM-6B 是完全开源的,可以在Github下载和使用。GPT 模型的可用性受到限制,需要申请权限和付费才能使用。ChatGLM-6B 的可用性更高,可以在本地部署和修改。

ChatGLM-6B 和 GPT 模型对比

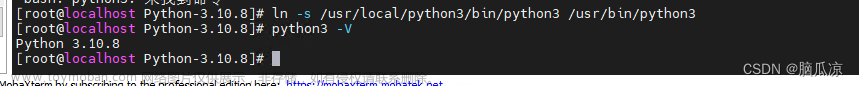

2、虚拟环境搭建

要搭建 conda 虚拟环境,你需要先安装 conda ,它是一个用于管理 Python 和其他语言的包和环境的工具。你可以从 https://www.anaconda.com/products/individual 下载并安装 Anaconda 或 Miniconda。

创建一个虚拟环境,并且指定其中的 Python 版本,这里使用了python3.10:conda create --name myenv python=3.10( myenv 是你想要给这个环境起的名字)。

激活这个虚拟环境:conda activate myenv,这样你就可以在这个环境中安装和使用包了。

3、下载安装所需的依赖

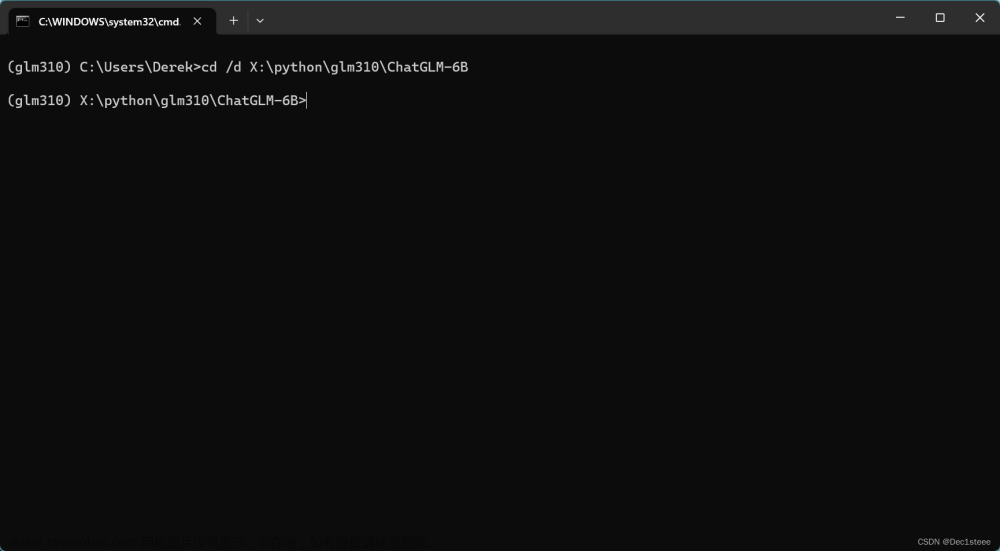

点击前往GitHub下载作者开源的文件接着进入创建好的conda虚拟环境中,进入开源文件所下载到的文件夹,例如我存放在X:\python\glm310\ChatGLM-6B中。用以下命令 cd /d X:\python\glm310\ChatGLM-6B进入

接着输入pip install -r requirements.txt安装所需要的依赖项

由于安装的依赖项中的torch模块是only cpu的,即不能把模型放进显卡运算的版本,所以我们在下载完毕后,在控制台输入pip uninstall torch卸载torch。点击进入pytorch官网翻到主页下端根据自己安装的cuda版本选择下载对应的torch-gpu。

如何查看cuda版本与显卡信息在控制台输入nvidia-smi即可。

如果没有安装cuda的请参考 在conda虚拟环境中配置cuda+cudnn+pytorch深度学习环境(新手必看!简单可行!),cuda版本推荐cuda 11.7。

4、ChatGLM模型下载与修改

点击进入作者的网盘下载模型

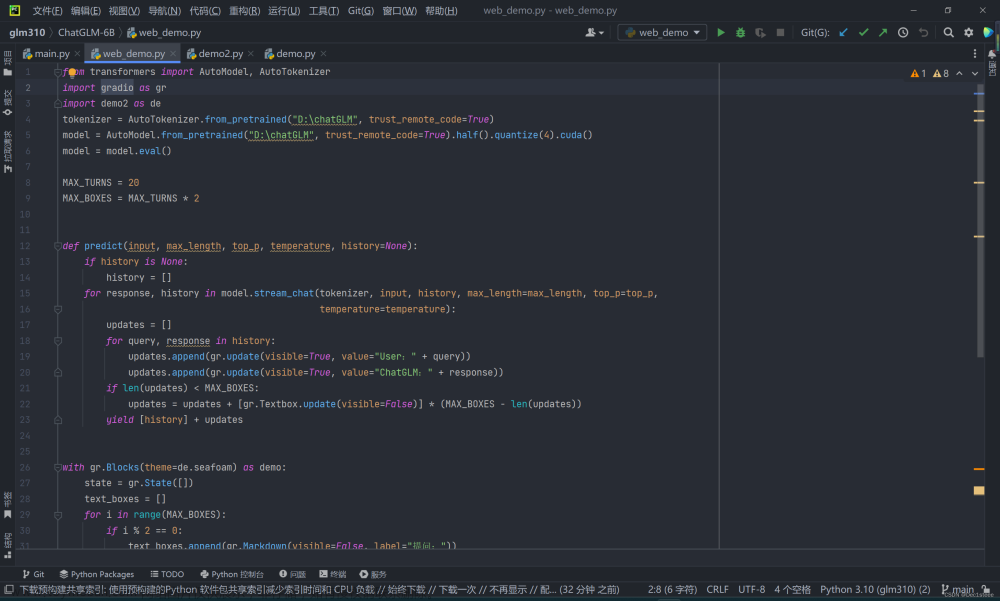

把他们下载到电脑,例如我存放在D:\ChatGLM-6B中。进入刚开始下载开源文件的文件夹打开web_demo.py文件,修改模型。

修改模型加载路径为模型下载的地址

tokenizer = AutoTokenizer.from_pretrained("D:\chatGLM", trust_remote_code=True)

model = AutoModel.from_pretrained("D:\chatGLM", trust_remote_code=True).half().quantize(4).cuda()

model = model.eval()

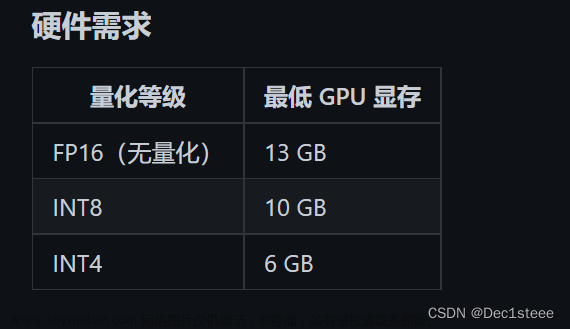

根据自身的显存修改模型,例如我的电脑显存为6G,即修改为

`# 按需修改,目前只支持 4/8 bit 量化

model = AutoModel.from_pretrained("D:\chatGLM", trust_remote_code=True).half().quantize(4).cuda()

`

若要在线发布,把web_demo.py中最后一段代码的share=False改成Ture即可

demo.queue().launch(share=True, inbrowser=True)

5、美化与发布

美化生成的界面,最简单的方法就是在以下这行代码增加主题参数,gradio模块预设了多种不同的生成web的主题,详情可参考gradio官网

`with gr.Blocks(theme=Soft()) as demo:`

最后点击运行即可

顺便提一句:在控制台输入nvidia-smi -l 1可以即时监控gpu显存使用情况

效果图

生成在线链接发送给到微信打开效果图

参考文献

A. Zeng等, 《GLM-130B: An Open Bilingual Pre-trained Model》, 发表于 The Eleventh International Conference on Learning Representations, 2月 2023. 见于: 2023年3月30日. [在线]. 载于: https://openreview.net/forum?id=-Aw0rrrPUF文章来源:https://www.toymoban.com/news/detail-414990.html

开发者GitHub:https://github.com/THUDM/ChatGLM-6B文章来源地址https://www.toymoban.com/news/detail-414990.html

到了这里,关于【ChatGLM】在电脑部署属于自己的人工智能/ChatGPT平替/可离线/可发布的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!