1.解压Hadoop,解压到任意盘,路径不要带中文路径

进入保存后的bin目录,查看,是否解压成功

2.解压spark,到任意位置,路径不要带有中文

3. 打开pycharm,把Hadoop,spark环境变量配置到pycharm中。

3.1新建项目

3.2在项目中创建一个python文件

3.3把Hadoop_home,python_home,pythonpath添加到Pycharm中.

1.HADOOP_HOME

2.SPARK_HOME

3.PYTHONPATH

4.注意!!!

PYTHONPATH路径要添加到D:\spark\spark-2.4.6-bin-hadoop2.7\python\lib\py4j-0.10.7-src.zip下

3.4 检查是否有以下软件包

3.4.1 如果没有请按照以下教程下载,后期需要

3.4.2安装py4j

3.4.3安装pyspark推荐2.4.6版本

3.4.4安装pip

3.5安装findspark

4.把winutils.exe插件放到Hadoop解压后的/bin目录下面

5.把以下代码,复制到4.2步骤中,新建的python文件中

#添加此代码

import findspark

findspark.init()

#在spark前,添加此代码

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("WordCount").getOrCreate()

spark.sparkContext.textFile("file:///D:/Hadoop/hadoop-2.7.7/README.txt")\

.flatMap(lambda x: x.split(' '))\

.map(lambda x: (x, 1))\

.reduceByKey(lambda x, y: x + y)\

.foreach(print)

5.1必须要有这句话在spark前面!!!

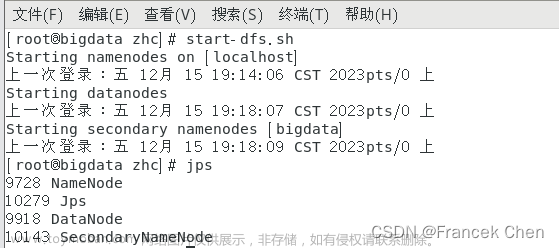

6.测试

文章来源:https://www.toymoban.com/news/detail-417969.html

文章来源:https://www.toymoban.com/news/detail-417969.html

文章来源地址https://www.toymoban.com/news/detail-417969.html

文章来源地址https://www.toymoban.com/news/detail-417969.html

出现以上内容,表示pycharm连接spark成功。

到了这里,关于pycharm连接spark的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[Spark、hadoop]Spark Streaming整合kafka实战](https://imgs.yssmx.com/Uploads/2024/01/809934-1.png)