1、xpath的基本使用

创建一个简单的HTML:

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<title>Title</title>

</head>

<body>

<ul>

<li>北京</li>

<li>上海</li>

<li>深圳</li>

<li>武汉</li>

</ul>

<ul>

<li>大连</li>

<li>锦州</li>

<li>沈阳</li>

</ul>

</body>

</html>创建一个python文件:

如果解析本地文件使用etree.parse

如果解析服务器响应文件使用etree.HTML()

from lxml import etree

# xpath解析

# (1)本地文件 etree.parse

# (2)服务器的响应数据 response.read().decode('utf-8')******* 应用较多 etree.HTML()

tree=etree.parse('shangguigu.html')

print(tree)

运行:

会报错

lxml.etree.XMLSyntaxError: Opening and ending tag mismatch: meta line 4 and head, line 6, column 8

原因是 xpath 严格遵守HTML规范

解决方法:

在meta标签中加入 /

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8"/>

<title>Title</title>

</head>

<body>

<ul>

<li>北京</li>

<li>上海</li>

<li>深圳</li>

<li>武汉</li>

</ul>

<ul>

<li>大连</li>

<li>锦州</li>

<li>沈阳</li>

</ul>

</body>

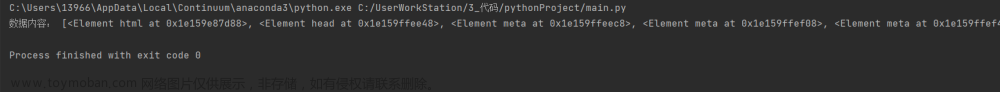

</html>再次运行:

xpath基本语法:

# 查找ul下面的li

from lxml import etree

# xpath解析

# (1)本地文件 etree.parse

# (2)服务器的响应数据 response.read().decode('utf-8')******* 应用较多 etree.HTML()

tree=etree.parse('shangguigu.html')

print(tree)

# tree.xpath('xpath路径')

# 查找ul下面的li

li_list=tree.xpath('//body/ul/li')

# 判断列表的长度

print(li_list)

print(len(li_list))

# 查早所有id的属性的li标签

HTML中添加分别在北京和上海中添加 id='1' id='2'

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8"/>

<title>Title</title>

</head>

<body>

<ul>

<li id="1">北京</li>

<li id="2">上海</li>

<li>深圳</li>

<li>武汉</li>

</ul>

<!--<ul>-->

<!-- <li>大连</li>-->

<!-- <li>锦州</li>-->

<!-- <li>沈阳</li>-->

<!--</ul>-->

</body>

</html>from lxml import etree

# xpath解析

# (1)本地文件 etree.parse

# (2)服务器的响应数据 response.read().decode('utf-8')******* 应用较多 etree.HTML()

tree=etree.parse('shangguigu.html')

print(tree)

# tree.xpath('xpath路径')

# # 查找ul下面的li

# li_list=tree.xpath('//body/ul/li')

# # 判断列表的长度

# print(li_list)

# print(len(li_list))

# 查早所有id的属性的li标签

li_list=tree.xpath('//ul/li[@id]')

print(li_list)

print(len(li_list))

# text()获取标签中的内容

from lxml import etree

# xpath解析

# (1)本地文件 etree.parse

# (2)服务器的响应数据 response.read().decode('utf-8')******* 应用较多 etree.HTML()

tree=etree.parse('shangguigu.html')

print(tree)

# tree.xpath('xpath路径')

# # 查找ul下面的li

# li_list=tree.xpath('//body/ul/li')

# # 判断列表的长度

# print(li_list)

# print(len(li_list))

# 查早所有id的属性的li标签

# text()获取标签中的内容

li_list=tree.xpath('//ul/li[@id]/text()')

print(li_list)

print(len(li_list))

# 找到id为l1的标签

HTML:

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8"/>

<title>Title</title>

</head>

<body>

<ul>

<li id="l1">北京</li>

<li id="2">上海</li>

<li>深圳</li>

<li>武汉</li>

</ul>

<!--<ul>-->

<!-- <li>大连</li>-->

<!-- <li>锦州</li>-->

<!-- <li>沈阳</li>-->

<!--</ul>-->

</body>

</html>Python:

from lxml import etree

# xpath解析

# (1)本地文件 etree.parse

# (2)服务器的响应数据 response.read().decode('utf-8')******* 应用较多 etree.HTML()

tree=etree.parse('shangguigu.html')

print(tree)

# tree.xpath('xpath路径')

# # 查找ul下面的li

# li_list=tree.xpath('//body/ul/li')

# # 判断列表的长度

# print(li_list)

# print(len(li_list))

# 查早所有id的属性的li标签

# text()获取标签中的内容

# li_list=tree.xpath('//ul/li[@id]/text()')

# 找到id为l1的标签

li_list=tree.xpath('//ul/li[@id="l1"]/text()')

print(li_list)

print(len(li_list))

HTML:

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8"/>

<title>Title</title>

</head>

<body>

<ul>

<li id="l1" class="c1">北京</li>

<li id="2">上海</li>

<li>深圳</li>

<li>武汉</li>

</ul>

<!--<ul>-->

<!-- <li>大连</li>-->

<!-- <li>锦州</li>-->

<!-- <li>沈阳</li>-->

<!--</ul>-->

</body>

</html>Python:

from lxml import etree

# xpath解析

# (1)本地文件 etree.parse

# (2)服务器的响应数据 response.read().decode('utf-8')******* 应用较多 etree.HTML()

tree=etree.parse('shangguigu.html')

print(tree)

# tree.xpath('xpath路径')

# # 查找ul下面的li

# li_list=tree.xpath('//body/ul/li')

# # 判断列表的长度

# print(li_list)

# print(len(li_list))

# 查早所有id的属性的li标签

# text()获取标签中的内容

# li_list=tree.xpath('//ul/li[@id]/text()')

# 找到id为l1的标签

# li_list=tree.xpath('//ul/li[@id="l1"]/text()')

# 查找到id为l1的li标签的class的属性值

li_list=tree.xpath('//ul/li[@id="l1"]/@class')

print(li_list)

print(len(li_list))

2、获取百度网站的百度一下

定位:

右键——检查——点击左上角小箭头——点击百度一下 即可快速定位

右键定位后的代码——Copy——Copy xPath

文章来源:https://www.toymoban.com/news/detail-420437.html

文章来源:https://www.toymoban.com/news/detail-420437.html

# 1 获取网页源码

# 2 解析 解析的服务器响应的文件 etree.HTML

# 3 打印

import urllib.request

url='https://www.baidu.com/'

headers={

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/109.0.0.0 Safari/537.36'

}

# 请求对象的定制

request =urllib.request.Request(url=url,headers=headers)

#模拟浏览器访问服务器

response =urllib.request.urlopen(request)

#获取网页源码

content=response.read().decode('utf-8')

# print(content)

# 解析网页源码 来获取我们想要的数据

from lxml import etree

#解析服务器响应的文件

tree=etree.HTML(content)

# 获取想要的数据 xpath默认返回一个列表

result=tree.xpath('//input[@id="su"]/@value')[0]

print(result) 文章来源地址https://www.toymoban.com/news/detail-420437.html

文章来源地址https://www.toymoban.com/news/detail-420437.html

到了这里,关于尚硅谷爬虫(解析_xpath的基本使用)笔记的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[ tool ] Xpath选择器和selenium工具基本使用](https://imgs.yssmx.com/Uploads/2024/01/811824-1.png)