大语言模型(LLM)现在非常流行,可惜ChatGPT等都不开源。大家没法搭建一个自己的环境来感受以下。幸好Meta开源了LLama,这是LLama的介绍:

https://ai.facebook.com/blog/large-language-model-llama-meta-ai/

具体技术细节请看论文:

LLaMA: Open and Efficient Foundation Language Models

以 Meta 开源 LLaMA(直译为「大羊驼」)系列模型为起点,斯坦福大学等机构的研究人员先后在其上进行「二创」,开源了基于 LLaMA 的 Alpaca(羊驼)、Alpaca-Lora、Luotuo(骆驼)等轻量级类 ChatGPT 模型,大大降低了这类模型的研究、应用门槛,训练、推理成本一再降低。

近日,来自加州大学伯克利分校、卡内基梅隆大学、斯坦福大学、加州大学圣迭戈分校的研究者们又提出了一个新的模型 ——Vicuna(小羊驼)。这个模型也是基于 LLaMA,不过用到的是 13B 参数量的版本。

这个项目有趣的地方在于,作者在评测环节并没有通过某种「标准化考试」来测定模型性能(因为他们认为这些问题测不出模型在对话中的变通能力),而是让 GPT-4 当「考官」,看看 GPT-4 更倾向于 Vicuna-13B 还是其他基线模型的答案。结果显示,GPT-4 在超过 90% 的问题中更倾向于 Vicuna,并且 Vicuna 在总分上达到了 ChatGPT 的 92%。

经过他们优化后,大家也可以在自己的CPU环境上体验一下了。

LLama共有4种模型:

一般的笔记本也就只能玩得起7B和13B两种了。下面是我在CPU环境上的搭建过程。

模型下载地址:

eachadea/ggml-vicuna-13b-4bit · Hugging Face

运行程序可以使用LLAMA.cpp, github地址:

https://github.com/ggerganov/llama.cpp

可以直接下载编译后的程序:

https://github.com/ggerganov/llama.cpp/releases

随便选一个编译的解压(我用的llama-master-698f7b5-bin-win-avx2-x64.zip)并把模型文件放在同一个目录下

然后为了方便每次使用,写一个bat文件,内容如下:

@echo off

".\main.exe" -ins -m .\ggml-vicuna-13b-4bit-rev1.bin直接执行这个Bat文件或者命令行执行这个命令都行。

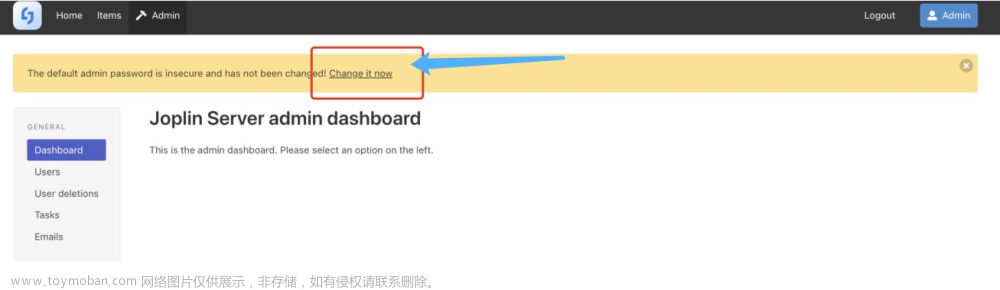

效果如图:

文章来源:https://www.toymoban.com/news/detail-421835.html

文章来源:https://www.toymoban.com/news/detail-421835.html

7B的与13B的类似,就不重复说了。文章来源地址https://www.toymoban.com/news/detail-421835.html

到了这里,关于建立自己的ChatGPT:LLama私有化部署及测试的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!