网上的普遍太久远,不太适配,记录自己的完美搭建

一、配置spark

1.配置maven(注意选择版本为3.6.3)

参考:https://blog.csdn.net/huo920/article/details/82082403

但这一步是多余的

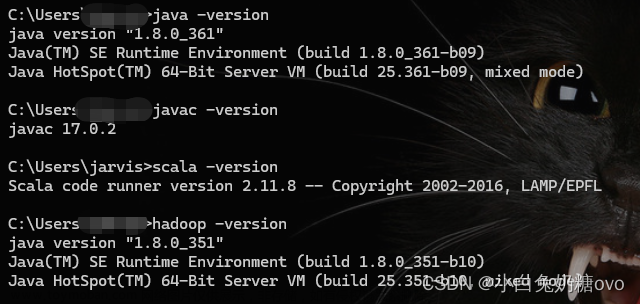

2.下载scala(注意版本对应为2.12)

查看scala版本:scala -version

查看对应关系:https://mvnrepository.com/artifact/org.apache.spark/spark-core

安装scala参考:https://cloud.tencent.com/developer/article/1733776

官网:https://www.scala-lang.org/download/

然后选择特定的版本

3.下载spark(注意版本选择3.1.3)

不要太新了,否则spark-shell会报错,需要降低版本

https://zhuanlan.zhihu.com/p/149469688

检验:cmd中spark-shell

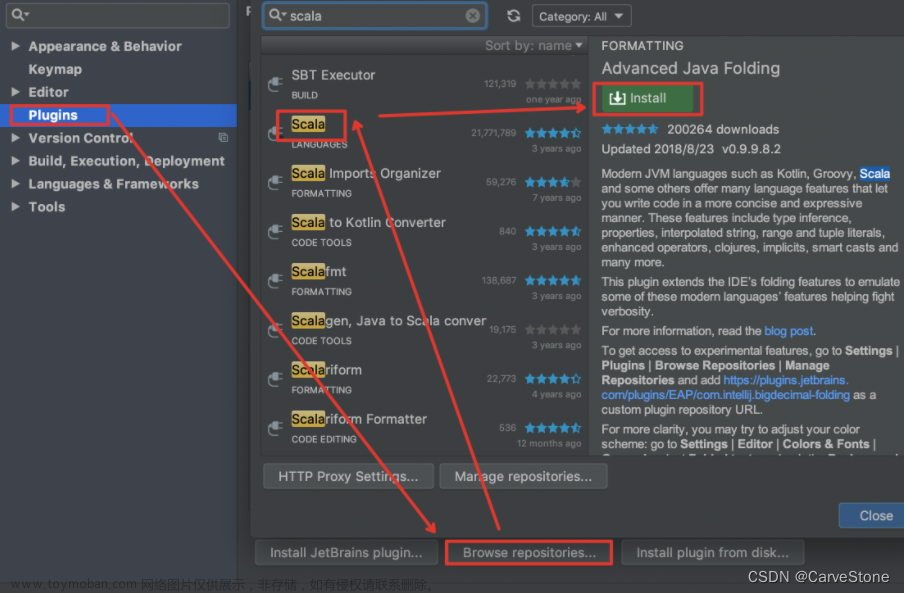

二、搭建idea项目

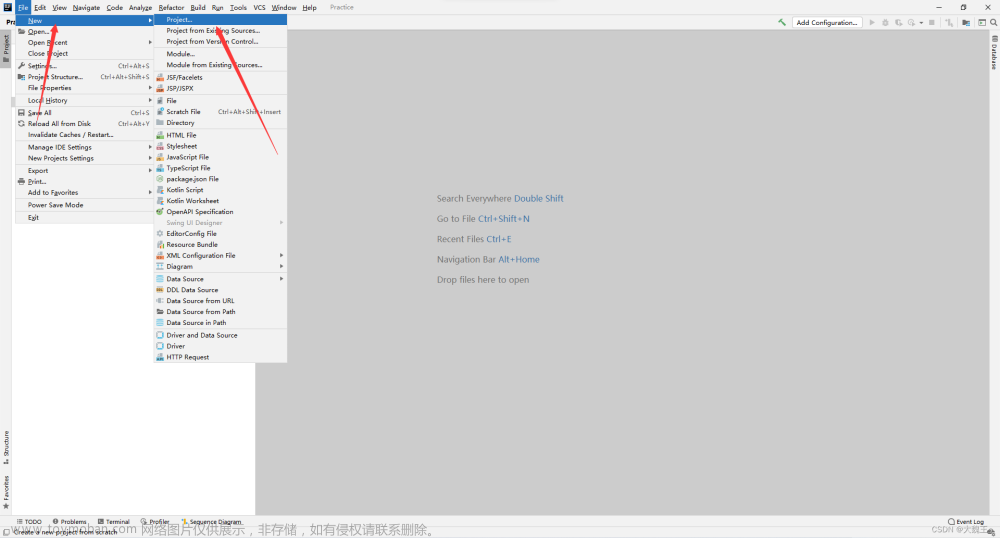

1.创建项目

由于版本较新,maven版本配置全靠自己琢磨,可惜自己没琢磨透

感谢好友@玥的热心帮助,通过直接创建项目解决问题

参考:https://blog.csdn.net/github_38924695/article/details/118510289?utm_source=app&app_version=5.3.1&code=app_1562916241&uLinkId=usr1mkqgl919blen

注意:点击IDEA右上角放大镜左边的按钮(Project Structure),或者快捷键ctrl + shift + alt + S,点击Modules:

(要包括scala-sdk和spark的jars包:D:\Programs\pyspark\spark-3.1.3-bin-hadoop3.2\jars)

2.导包解决爆红

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.sql.{Dataset, SparkSession}

3.成果展示

4.附上测试代码

注意!!package和object test1 为自己的哈

package main.scala

object test1 {

def main(args: Array[String]): Unit = {

println("Hello Scala")

}

}

三、心得

完结撒花,仙女落泪QAQ文章来源:https://www.toymoban.com/news/detail-424578.html

有问题可以发评论区,我看到会回复

折腾三天,理论把坑踩遍了hhh文章来源地址https://www.toymoban.com/news/detail-424578.html

到了这里,关于配置spark,并在idea中搭建项目的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!