音频情感识别意义与背景

- 这里的音频是指人类能够听到的声音,音频中包含丰富情感;

- 应用在电话服务、医学研究(抑郁、压力–发现情绪波动)、谎言分析(检测声音相关参数,例如紧张程度)、机器人中(情感理解+ 情感生成);

- 现在研究更多侧重于人的情感识别;

- 音频情感识别优点: 采集容易,不用可穿戴设备,更有效保护隐私。

研究现状与进展

-

80-90年代,根据韵律(how to say, 情感激动程度,能量等参数)控制人机对话的过程;

-

90年代后期模式识别(高斯混合、SVM、HMM等)

-

目前, DL(受限于数据规模较小)

-

国外研究团队

英国贝尔法斯特女王大学的情感语音组

收集并创建了第一个大规模的高自然度情感数据库,Roddy Cowie和 Ellen Douglas-Cowie 教授,重点研究心理学和语音分析。美国MIT媒体实验室情感计算研究所

Rosalind Picard 教授90年代初开始进行情感语音研究

(http://affect.media.mit.edu)美国南加州大学语音情感组

Shri Narnyana教授,情感语音的声学分析、合成和识别,以及有关笑声合成研究(http://sail.usc.edu/emotion/index.php)爱尔兰都柏林大学

Nick Campbell教授,从事自然情感语音合成以色列Nemesysco公司

实际应用以分层声音分析技术(LVA)在安全、商业和个人娱乐领域为客户提供解决方案。创业公司 Beyond Verbal以通过识别音域变化,从而分析出愤怒、焦虑、幸福或满足等情绪,其中包括11个类别, 400个复杂情绪的变量。英国的初创企业EI Technologies

可以分析人声的音调,识别高兴、悲伤、害怕、愤怒及无感情等5种用户的基本情绪。识别的准确率约为70-80%左右,这个数字要高于人类60%的平均水平,而受过训练的心理学家的判断准确率约为70%。日本SGI研究院能感知人类情感:KOTOHANA

(http://www/.sgi/co/jp/solutions/bbu/ST/index/html) -

国内研究团队

中科院自动化所模式识别国家重点实验室

东南大学无线电工程系

清华大学计算机科学与技术系

台湾大同大学资讯工程学系

中国公司Emotibot竹间智能科技、清帆科技EduBrain(专注教育领域技术创新)

其他:中国社科院语言研究所,西北工业大学、中国人民大学、哈工大,浙大,华南理工、中科大,南京师范大学、江苏大学等

音频情感数据库

-

语音情感数据库建立的四个原则

-

真实性,尽量不要诱发,如果采用诱发的方式,也要尽可能真实;

-

交互性,在人与人交户中产生;

-

连续性,动态建模,要多种情感转移;

-

丰富性,尽可能包含多包含多媒体信息。

- 获取语音情感数据库的方法

- 演员表演(最差情况):刻意模仿的情感显得比较夸大;

- 引导情感(较差情况):设计情景,比如讲个高兴的事,看个恐怖电影;

- 取自媒体(较好情况):从广播或者影视节目中截取片段;

- 现实生活(理想情况):比较难获得,有些数据库基于电影电视剧片段进行类似。

-

音频情感识别语料库

Belfast 英语情绪语料库

引导情感:由50位说话人根据引导文本,表达愤怒、恐惧、高兴、悲伤和中性五种情感

自然语料:从电视访谈节目中选取剪辑的125位说话人的多种情感柏林(EMO-DB)情感数据库

引导情感:日常交流中常用的十个德语语句,共800语句,含七种情感:中性、愤怒、恐惧、高兴、悲伤、厌恶和惊奇FAU AIBO儿童德语情感语音库

自然情感:录制51儿童(10-13岁,21男30女)与索尼公司生产的电子宠物AIBO游戏过程中的自然语音,保留情感信息明显的语料,共9.2小时,包括48401单词汉语普通话语音数据库

演员表演:中科院自动化所研制,由演员模仿情感进行录制,共9600条语音,包括6中情感:高兴、生气、惊奇、控制、悲伤、平静

演员表演:东南大学研制,表演性情感语音,由10名男性话者对4个语句分别用喜、怒、惊、悲四种情感录制480句CREST情绪语料库

自然情感:日本的国际电气通信基础研究所(ATR)录制,包含完全自然状态下的1000小时情感语音,60%是日语,汉语和英语各占20%丹麦情感语音库

演员表演:含5种情感:高兴、生气、惊奇、悲伤、平静。共260条CHEAVD 数据库

取自媒体:由中科院自动化所从32部中文电影、79集电视剧、20期综艺节目中剪辑出2629个音视频情感片段,共计时长141分钟,共包括238位发音人。Semaine数据库

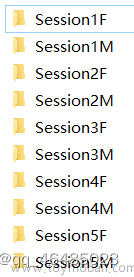

引导情感:面向自然人机交互和人工智能研究的数据库,20 个用户(22 岁-60 岁,8 男12 女)被要求与性格迥异的4个机器角色进行交谈.这4 个角色分别是:1) 温和而智慧的Prudence;2) 快乐而外向的Poppy;3) 怒气冲冲的Spike 和4) 悲伤而抑郁的Obadiah

语音情感识别

- 语音特征,人类的发生器官由肺、气管、声带、鼻、口和唇等组成。

- 声带长短和张力决定声音的基频;

- 声音强度取决于气流的大小和强度;

- 声音经过形状变化的口腔、鼻腔等共振,最后经唇部辐射传出;

- 声音的共振过程形成了共振峰,各共振峰的频率由共振腔的大小和形状决定。

-

韵律特征: 最主要的语音特征,如语速、音量和音调,振幅、基音频率,持续时间等;

-

语速:语音可以反应出说话者的情绪状态:当人的情绪比较激动的时候,比如处于愤怒状态,语言的表达速度明显加快,相反在人的情绪比较低落时,比如处于悲伤状态,语言的表达速度则明显较慢。

-

时长:语句的发音持续时间指每一情感语句从开始到结束的持续时间,与感知的语速相对应,情感语音的时长构造主要着眼于不同情感语音发话时间构造的差别,时长分析常采用音节、句子为单元来测量。

-

停顿:停顿也反映了情感信息,停顿指的是前一个音节与下一个音节之间无声的时间。

分析

语速: 语速的变化是表达情感的一个重要手段。它反映一个人在不同环境,不同情感下说话时的心情急切度。人在焦虑和愤怒状态下,说话速度很快;惊奇和喜悦次之;而悲伤情感下说话速度最慢。

停顿和时长: 不管是男性还是女性,不同情感下,其停顿和时长对于基本类型的情感变化有一定的一致性,对于微妙复杂的情感两者的变化有一定的差异。

性别的不同,也会引起一些情感之间特征的变化差异性。比如男性说话人在放松和温顺情感下的时长变化略不同于女性说话人,停顿分析中惊奇与喜悦情感在不同性别中的变化稍有不同。 -

音强

能量表现为语音的音量的高低,而音量的高低又是通过声音的响度大小来反映。

不管是男性还是女性说话人,其中中性、放松、温顺情感的能量基本在同一水平,总体能量较低,其次是轻蔑和悲伤能量相近,惊奇、喜悦和恐惧能量处于一个水平,能量最强的属于愤怒情感。

不管是男性还是女性说话人,其中中性、放松、温顺情感的能量基本在同一水平,总体能量较低,其次是轻蔑和悲伤能量相近,惊奇、喜悦和恐惧能量处于一个水平,能量最强的属于愤怒情感。

- 音质

- 基频

在发出浊音时,声门波形成的周期性脉冲,即声带的振动周期被称作是浊音的基音周期,基音频率即为其倒数,简称基频,通常用F0表示。基频值取决于声带大小、厚薄、松紧程度以及声门上下之间的气压差效应等。

基音频率体现出以下规律:处在激动情绪下如愤怒的人所表达出的语音的基频较高,变化范围较大;处于低落情绪如悲伤的人所表达的语音的基频较低,变化范围较小,处于平静情绪下的人所表达出的语音的基频则相对稳定。

- 共振峰

共振峰是反映声道特性的一个重要参数。不同情感发音的共振峰的位置不同。分析时首先用LPC法求出声道的功率谱包络,在用峰值检出法算出个共振峰的频率。

- 基频抖动

焦虑语音会出现“F0抖动”现象。Jitter是基频值的变化程度。

F0 Jitter是由生理器官的作用才产生,比如情感的变化会导致声带肌肉紧张度,气流的体积速度,声道表面的坚硬或柔软等发生变化,从而产生基频抖动现象。

- 频谱

-

线性预测倒谱系数(LPCC)

LPCC是基于语音信号为自回归信号的假设,利用线性预测分析获得倒谱系数。

不同情感的发音会使声道有不同的变化,进而引起声道传输函数倒谱的变化。 -

Mel频域倒谱系数(MFCC)

考虑了人耳对不同频带的分辨率不同,充分融合人耳的听觉特性。

- 系统框架

- 语音情感识别本质上属于模式识别

局部特征 & 全局特征

多类特征融合(还可以融合副语言,如笑声、叹息)

-

神经网络

-

高斯混合模型(GMM)

混合高斯模型是只有一个状态的模型,在这个状态里具有多个高斯分布函数。

P k = ∑ i = 1 N w i f i ( Y ) P_{k}=\; \sum_{i\; =\; 1}^{N}{w_{i}f_{i}\left( Y \right)} Pk=i=1∑Nwifi(Y)其中 f i f_i fi是一个高斯分布函数,不同高斯分布之间的加权系数 w i w_i wi满足 ∑ i = 1 N w i = 1 \sum_{i\; =1}^{N}{w_{i}\; =\; 1} ∑i=1Nwi=1

每一个情感类型训练一个高斯混合函数,高斯函数的输入参数为语音的情感特征参数。 -

HMM

HMM是一种基于转移概率和观测概率的随机模型,它既能用短时模型(状态)解决声学特征相对稳定段的描述,又能用状态转移规律刻画稳定段之间的时变过程 -

支持向量机

基于结构风险最小化和统计学习理论提出了一种名为支持向量机(SVM)的机器学习方法,该方法在诸如函数拟合、非线性模式识别。小样本等领域都极具优势。 -

混合模型

混合高斯模型-支持向量机:该方法不仅拥有混合高斯模型统计能力强的优点,而且同时有支持向量机分类能力强的优点。隐马尔科夫模型-人工神经网络模型:首先用隐马尔科夫模型对情感特征向量进行整合,再用人工神经网络进行最终分类识别。

采用投票机制将支持向量机、K最近邻算法、人工神经网络种分类器进行融合。

-

深度神经网络

DNN:原始语音信号分段输入到网络中,提取局部的情感信息,然后经过处理得到全局情感特征,送到分类器中,得到预测的概率类别。输入一段语音情感信号,可以得到每一段对每个情感类别的预测概率值。CNN:卷积神经网络广泛应用到语音情感识别中,包括局部不变特征学习模块、情感区分特征分析模块和支持向量机模块三个部分。这种模型结构能够抽取出具有区分性的情感特征。

RNN:能够有效融合上下文信息进行音频情感建模。

CNN- RNN:联合了CNN模型的音频信息表征能力和RNN模型的情感时序建模能力。

胶囊网络:利用胶囊网络,考虑音频特征在声谱图中的空间关系,为获取语音全局特征提供了一种有效的汇聚方法。

基于端到端的音频识别:直接将语谱图或时域波形点作为输入,具有特征自学习能力的优势

其性能依赖于数据规模。注意力机制:有效挖掘不同音频片段对当前情感状态的贡献度。

多任务学习:不同维度情感状态存在依存关系,利用多任务学习机制实现维度情感模型的协同优化。

融合功能副语言信息检测的识别模型:对副语言段和语音段进行区分性建模,有效利用副语言先验信息。

融合说话人信息和文本信息的识别模型:对音频信息、识别的文本信息、说话人信息进行时空融合。

融合区分性训练准则的识别模型:利用三元损失函数解决不同情感状态边界模糊的问题文章来源:https://www.toymoban.com/news/detail-424595.html

展望

- 语料

- 语料很重要,但目前规模较小;

- 采集整理工作难;

- 关注跨数据库展现(如考虑文化、语种差异)。

- 语音情感特征

- 找新特征,获取更高识别率;

- 多特征融合(不能通过向量特征拼接形成高维度的形式);

- 在高维情况下分类器的泛化性能反而更弱,要针对性进行特征降维和选择。

- 语义理解

- 利用语义的语音情感识别,如文字、声音线索、视频线索;

- 语音语义识别同情感识别相结合。

参考:国科大-情感计算课件文章来源地址https://www.toymoban.com/news/detail-424595.html

到了这里,关于情感计算-音频情感识别的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!