1. 引言

在当今的互联网时代,流媒体传输技术在人们的日常生活中扮演着越来越重要的角色。从在线教育到实时娱乐,流媒体技术已经渗透到了生活的方方面面。在这篇博客中,我们将从C++语言的角度,探讨流媒体传输技术的重要性,为什么选择RTMP协议以及RTMP协议的发展与应用。

1.1 流媒体传输技术的重要性

流媒体传输技术是指将音频、视频等多媒体数据实时传输到终端设备的技术。与传统的文件下载方式相比,流媒体传输技术具有更高的传输效率,实时性更强,可以大大提高用户的观看体验。此外,随着5G、云计算等新技术的普及,流媒体传输技术的应用场景也在不断扩大,从而进一步推动了流媒体行业的快速发展。

1.2 为什么选择RTMP协议

RTMP(Real-Time Messaging Protocol,实时消息传输协议)是一种基于TCP的网络协议,用于实现音视频数据的实时传输。RTMP协议在流媒体传输领域得到了广泛应用,具有以下优点:

- 低延迟:RTMP协议提供了稳定的连接和较低的延迟,使其成为实时互动场景的理想选择,如直播、在线游戏等。

- 跨平台性:RTMP协议支持多种平台和设备,包括Windows、macOS、Linux、Android、iOS等,使得开发者可以方便地为不同平台提供统一的流媒体服务。

- 可扩展性:RTMP协议具有良好的可扩展性,可以通过使用不同的数据格式和传输方式实现多种应用场景。

- 广泛的支持:由于RTMP协议的广泛应用,许多开源库和工具已经支持了RTMP协议,使得开发者可以更轻松地开发基于RTMP的应用程序。

1.3 RTMP协议的发展与应用

RTMP协议最早由Macromedia公司(后被Adobe收购)开发,目的是解决Flash播放器中的实时音视频传输问题。随着Flash播放器的普及,RTMP协议也逐渐成为流媒体传输领域的主流标准之一。尽管近年来,随着HTML5的推广和Flash的逐渐淘汰,RTMP协议在某些方面受到了挑战,但在许多场景中,尤其是实时互动场景,RTMP仍然是首选协议。

RTMP协议在许多领域都有广泛的应用,以下是一些典型的例子:

- 直播平台:直播平台通常会采用RTMP协议作为推流和拉流的技术基础,以确保用户可以实时观看到直播内容。

- 在线教育:在线教育中的实时课堂、远程教育等场景需要实时的音视频传输和互动,RTMP协议可以很好地满足这些需求。

- 视频会议:视频会议对音视频数据的传输实时性要求较高,采用RTMP协议可以降低延迟,提高通信效果。

- 远程监控:远程监控系统需要实时传输高质量的音视频数据,RTMP协议能够在保证实时性的同时,保证画质。

通过以上介绍,我们可以看到RTMP协议在流媒体传输领域的重要地位以及其广泛的应用场景。在接下来的博客文章中,我们将深入讨论如何使用C++语言实现基于RTMP协议的流媒体传输功能,以及如何在实际项目中应用这些知识。

2. RTMP协议基础

在本节中,我们将详细介绍RTMP协议的基本概念、与其他流媒体协议的比较以及组成与工作原理。

2.1 RTMP协议简介

RTMP(Real-Time Messaging Protocol,实时消息传输协议)是一种基于TCP的应用层协议,用于实现多媒体数据的实时传输。RTMP协议通过在客户端和服务器之间建立持久连接,提供稳定、低延迟的音视频传输服务。RTMP协议广泛应用于直播、在线教育、视频会议等实时互动场景。

2.2 RTMP协议与其他流媒体协议的比较

RTMP协议并非唯一的流媒体传输协议,其他常见的流媒体协议还有HLS(HTTP Live Streaming)、DASH(Dynamic Adaptive Streaming over HTTP)、MPEG-TS(MPEG Transport Stream)等。以下是RTMP协议与这些协议的简要比较:

- RTMP与HLS:HLS是一种基于HTTP的流媒体协议,将媒体文件切片后,通过HTTP传输给客户端。HLS具有良好的跨平台性和兼容性,但相较于RTMP,其延迟较高。因此,对实时性要求较高的场景,如直播、在线游戏等,RTMP协议可能更为合适。

- RTMP与DASH:DASH与HLS类似,也是一种基于HTTP的自适应流媒体协议。DASH与HLS相比具有更好的自适应性和灵活性,但仍存在较高延迟的问题。在实时互动场景中,RTMP仍具有优势。

- RTMP与MPEG-TS:MPEG-TS是一种通用的传输协议,既可以基于TCP也可以基于UDP。虽然MPEG-TS在某些方面具有优势,如广播场景,但其在实时互动应用方面,RTMP仍具有更低延迟和更好的跨平台特性。

2.3 RTMP协议的组成与工作原理

RTMP协议主要由以下三个部分组成:

- 握手阶段:在RTMP连接建立之初,客户端与服务器通过握手过程来确认双方的协议版本以及交换随机数等信息。握手成功后,双方将建立起稳定的连接。

- 消息传输:在握手成功之后,RTMP协议将音视频数据、命令消息等封装成消息进行传输。RTMP协议支持多种消息类型,包括音频、视频、数据消息、命令消息等。为保证消息的有序传输,RTMP还引入了流ID、消息ID等概念来对消息进行管理。

- 块传输:RTMP协议采用分块传输机制来提高传输效率。将消息划分为一系列较小的块(chunks),每个块的大小可配置。这种分块传输机制可以降低延迟,提高实时性。

RTMP协议的工作原理可概括为以下几个步骤:

- 客户端与服务器建立TCP连接。

- 双方通过握手过程确认协议版本及交换随机数等信息。

- 客户端发送连接命令(connect)到服务器。

- 服务器响应连接命令,返回连接结果。

- 客户端与服务器建立流(stream)进行音视频数据传输。

- 在传输过程中,双方可以发送控制命令,如播放(play)、暂停(pause)等。

- 当连接关闭时,双方结束消息传输并断开连接。

通过以上介绍,我们对RTMP协议的基本概念、与其他流媒体协议的比较以及组成与工作原理有了一个初步的了解。在接下来的部分中,我们将探讨如何使用C++语言实现RTMP协议的相关功能,以及在实际项目中如何应用这些知识。

RTMP数据块(Chunk) - RTMP流控制和命令消息

3. RTMP协议详解

在本节中,我们将更深入地探讨RTMP协议的核心组成部分,包括数据单元(Message)、数据块(Chunk)以及流控制和命令消息。

3.1 RTMP数据单元(Message)

RTMP数据单元(Message)是RTMP协议中用于封装音频、视频、命令和数据等信息的基本单位。一个RTMP数据单元包含以下部分:

- 类型:用于标识数据单元的类型,例如音频、视频、数据消息、命令消息等。

- 长度:数据单元的有效负载长度,以字节为单位。

- 时间戳:数据单元产生的相对时间,以毫秒为单位。时间戳用于同步音视频播放以及计算延迟。

- 流ID:标识数据单元所属的流。一个RTMP连接上可以有多个并发的流。

3.2 RTMP数据块(Chunk)

RTMP数据块(Chunk)是RTMP协议的基本传输单位,用于在客户端和服务器之间传输数据单元。RTMP协议将数据单元划分为大小可配置的数据块,这样可以有效降低延迟,提高实时性。一个RTMP数据块包含以下部分:

- 块头:包含块类型、块长度、时间戳、流ID等信息。块头的长度取决于块类型及所包含的字段。

- 负载:数据单元的一部分,其长度由块长度字段确定。

RTMP数据块根据块头的不同,分为4种格式:

- 类型0:包含完整的块头信息,用于传输一个新的数据单元。

- 类型1:省略了流ID字段,用于传输与上一个数据块相同类型和流ID的数据单元。

- 类型2:仅包含时间戳字段,用于传输与上一个数据块完全相同的数据单元。

- 类型3:没有块头,表示与上一个数据块完全相同,仅负载部分不同。

3.3 RTMP流控制和命令消息

RTMP协议支持多种流控制和命令消息,用于实现流媒体播放、暂停、拖动等功能。以下是一些常见的命令消息:

- connect:客户端发起连接请求。

- createStream:客户端创建一个新的流。

- play:客户端请求播放指定的流。

- pause:客户端请求暂停或恢复播放。

- seek:客户端请求跳转到指定时间点进行播放。

除了上述命令消息外,RTMP协议还支持其他命令和数据消息,例如:

- publish:客户端开始推送一个新的流。

- deleteStream:客户端删除一个流。

- receiveVideo 和 receiveAudio:客户端指示是否接收视频或音频数据。

- onStatus:服务器向客户端发送状态信息,如播放开始、播放结束等。

流控制和命令消息通常通过RTMP的控制流(默认为流ID为0的流)进行传输,以确保消息的优先级高于音视频数据。

3.4 RTMP事务与命令消息

RTMP事务用于在客户端和服务器之间进行交互,通常涉及到发送命令消息和接收相应的返回消息。每个事务都有一个独立的事务ID,用于唯一标识该事务。在客户端发送命令消息时,会生成一个递增的事务ID,服务器会在响应消息中返回相同的事务ID,以匹配请求和响应。以下是RTMP事务与命令消息的详细介绍。

3.4.1 命令消息格式

RTMP命令消息通常采用AMF(Action Message Format)编码,AMF是一种用于序列化和反序列化ActionScript对象的二进制格式。一个典型的RTMP命令消息包括以下组成部分:

- 命令名:一个字符串,表示要执行的命令,如 “connect”、“play” 等。

- 事务ID:一个数字,用于标识此次事务。客户端发送请求时生成,服务器在响应时返回相同的事务ID。

- 命令对象:一个对象,包含执行命令所需的参数,例如流名、客户端信息等。这个对象采用AMF编码。

- 可选参数:根据不同命令,可能还包含其他参数。

3.4.2 常见命令消息

以下是一些常见的RTMP命令消息及其功能:

- connect:客户端向服务器发起连接请求。命令对象中包含客户端信息、协议版本等参数。

- createStream:客户端请求创建一个新的流。命令对象为空。

- play:客户端请求播放指定的流。命令对象中包含流名等参数。

- pause:客户端请求暂停或恢复播放。命令对象中包含暂停/恢复标志等参数。

- seek:客户端请求跳转到指定时间点播放。命令对象中包含时间点参数。

- publish:客户端开始推送一个新的流。命令对象中包含流名、发布类型等参数。

- closeStream:客户端关闭一个流。命令对象为空。

3.4.3 响应消息

服务器在收到命令消息后,会返回一个响应消息。响应消息通常包括以下组成部分:

- 响应名:一个字符串,表示响应的类型,如 “result"(成功)或 " error”(失败)。

- 事务ID:一个数字,与请求消息中的事务ID相同,用于匹配请求和响应。

- 响应对象:一个对象,包含响应的详细信息,如状态码、描述信息等。

通过理解RTMP事务与命令消息,我们可以实现客户端与服务器之间的双向交互。接下来,我们将深入探讨如何使用C++语言实现RTMP协议的相关功能,以及在实际项目中如何应用这些知识。

3.5 使用C++实现RTMP协议

要使用C++实现RTMP协议,我们需要首先构建一个基于TCP的通信框架,处理RTMP协议的握手过程,实现数据单元和数据块的封装与解析,并支持事务与命令消息的发送和接收。以下是一些关键步骤和注意事项:

- 创建TCP套接字:RTMP协议基于TCP,因此我们需要创建一个TCP套接字用于客户端与服务器之间的通信。

- 实现握手过程:在客户端与服务器建立连接后,需要进行RTMP握手过程,以确认双方的协议版本并交换随机数等信息。

- 封装与解析数据单元与数据块:实现将音频、视频、命令和数据等信息封装成数据单元,并将数据单元切分成数据块。在接收端,我们需要实现数据块的解析与组合,以还原成数据单元。

- 实现事务与命令消息:构建一个事务管理模块,用于生成事务ID、发送命令消息和处理响应消息。实现对命令消息的AMF编码与解码。

- 处理音视频数据:实现对音频和视频数据的接收、发送和同步处理。这可能涉及到解码和编码器的集成,以支持不同格式的音视频数据。

- 实现流控制和其他功能:根据具体需求,实现播放、暂停、拖动等流控制功能,并支持多路复用、自适应码率等高级特性。

在实际项目中,你可以选择使用现有的开源库如librtmp或FFmpeg等来实现上述功能,这些库提供了对RTMP协议的丰富支持,可帮助你快速搭建起一个稳定、高效的流媒体系统。

通过以上介绍,我们已经对RTMP协议有了全面的了解,包括其基本概念、工作原理、数据单元与数据块、事务与命令消息以及如何使用C++实现相关功能。希望这些信息能够帮助你在实际项目中更好地应用RTMP协议。

3.6 RTMP Chunk Stream与分块传输

RTMP协议采用分块传输机制来提高传输效率并降低延迟。在本节中,我们将详细讨论RTMP Chunk Stream的概念及其分块传输原理。

3.6.1 RTMP Chunk Stream

RTMP Chunk Stream是一种用于在客户端和服务器之间传输数据单元的机制。一个RTMP连接上可以有多个并发的Chunk Stream,每个Chunk Stream具有一个唯一的ID,称为CSID(Chunk Stream ID)。根据RTMP协议规范,CSID取值范围为1到65599。

RTMP协议将数据单元(如音频、视频和命令消息等)划分为较小的块,称为Chunk,用于在Chunk Stream上进行传输。这种分块传输机制可以有效降低延迟并提高实时性。

3.6.2 分块传输原理

在RTMP协议中,每个数据单元会被划分为一个或多个Chunk进行传输。Chunk由以下两部分组成:

- Chunk Header:包含有关Chunk的元信息,如块类型、块长度、时间戳、CSID等。Chunk Header的长度取决于块类型及所包含的字段。

- Payload:数据单元的一部分,其长度由块长度字段确定。

RTMP协议通过将数据单元切分为较小的Chunk,可以在不影响实时性的前提下有效地传输大量音视频数据。在接收端,这些Chunk会被重新组合为完整的数据单元进行处理。

RTMP协议为了进一步降低延迟和减少冗余,支持多种类型的Chunk Header,根据Chunk Header的不同,分为4种格式:

- Type 0:包含完整的Chunk Header信息,用于传输一个新的数据单元。

- Type 1:省略了流ID字段,用于传输与上一个Chunk相同类型和CSID的数据单元。

- Type 2:仅包含时间戳字段,用于传输与上一个Chunk完全相同的数据单元。

- Type 3:没有Chunk Header,表示与上一个Chunk完全相同,仅负载部分不同。

通过以上介绍,我们对RTMP Chunk Stream及其分块传输原理有了更深入的了解。在实际项目中,应用这些知识可帮助你更好地实现高效、低延迟的流媒体传输。

4.RTMP握手与连接建立

在客户端和服务器建立RTMP连接之前,需要进行一系列的握手过程,以确保双方能够正常通信。本节将详细介绍RTMP握手过程和连接建立过程中的参数交换。

4.1 RTMP握手过程详解

RTMP握手过程主要包括以下三个阶段:

- C0和S0:客户端和服务器分别发送一个字节的版本号(C0和S0),表示双方的RTMP协议版本。通常情况下,这个版本号是0x03。

- C1和S1:接下来,客户端发送一个2048字节的数据包(C1),其中包括4字节的时间戳、4字节的零填充数据和随机填充的剩余字节。服务器接收到C1后,也会发送一个类似的数据包(S1),包括4字节的时间戳、4字节的客户端时间戳回显(即C1中的时间戳)和随机填充的剩余字节。

- C2和S2:最后,客户端和服务器互相发送确认数据包(C2和S2),包括4字节的对方发送的时间戳(服务器发给客户端的是S1中的时间戳,客户端发给服务器的是C1中的时间戳),以及4字节的对方接收到的时间戳(服务器发给客户端的是S1中的客户端时间戳回显,客户端发给服务器的是C1中的时间戳)和随机填充的剩余字节。

在完成这三个阶段的握手过程后,客户端和服务器就可以开始传输RTMP数据了。

4.2 客户端与服务器的连接建立与参数交换

在握手过程完成之后,客户端和服务器之间需要建立一个连接。建立连接的过程主要包括以下几个步骤:

- 发送connect命令:客户端向服务器发送一个connect命令消息,其中包含连接的参数,如应用名称、协议版本、客户端信息等。

- 服务器响应:服务器收到connect命令后,会进行验证并返回一个 “result"(成功)或 " error”(失败)的响应消息。响应消息中包含一个事务ID,用于与客户端的请求消息匹配,以及一个对象,其中包含服务器的相关信息,如版本、应用名称等。

- 交换控制消息:客户端和服务器可以在连接建立后互相发送控制消息,如窗口大小消息(Window Acknowledgement Size)、设置对等带宽消息(Set Peer Bandwidth)等,以调整通信参数。

- 创建流:客户端在连接建立后需要创建一个或多个流,用于传输音频、视频或数据。创建流的过程包括以下几个步骤:

- 发送createStream命令:客户端向服务器发送一个createStream命令消息,请求创建一个新的流。该消息中包含一个事务ID,用于与服务器的响应消息匹配。

- 服务器响应:服务器收到createStream命令后,会分配一个唯一的流ID并返回一个 “result"(成功)或 " error”(失败)的响应消息。响应消息中包含客户端发送的事务ID以及分配的流ID。

- 播放或发布流:客户端在创建流后可以选择播放或发布流。播放流的过程包括发送play命令并接收音视频数据,发布流的过程包括发送publish命令并发送音视频数据。客户端还可以发送其他命令,如暂停、停止等,来控制流的播放和发布。

通过以上步骤,客户端与服务器之间的连接建立完成,并且完成了参数交换。此时,客户端和服务器可以开始进行音视频数据的传输和播放。

4.3 发布与播放流的代码实现与示例

在本节中,我们将简要介绍如何使用C++实现发布与播放流。为了简化讨论,我们假设已经建立了RTMP连接,并已创建了流。在实际项目中,你可以选择使用现有的开源库,如librtmp或FFmpeg等来实现这些功能。

发布流

以下是发布流的简化步骤和示例代码:

-

发送publish命令:

void send_publish_command(RTMPConnection& connection, uint32_t stream_id, const std::string& stream_name) { RTMPMessage message; message.set_type(RTMPMessageType::COMMAND_AMF0); message.set_stream_id(stream_id); message.set_timestamp(0); AMFObject command; command["command_name"] = "publish"; command["transaction_id"] = 0.0; // 发布操作无需事务ID command["command_object"] = AMFNull(); command["stream_name"] = stream_name; command["stream_type"] = "live"; // 例如,设置为"live"表示实时直播 message.set_payload(encode_amf0(command)); connection.send_message(message); } -

发送音视频数据:

void send_av_data(RTMPConnection& connection, uint32_t stream_id, const AVPacket& packet) { RTMPMessage message; if (packet.is_audio()) { message.set_type(RTMPMessageType::AUDIO_DATA); } else if (packet.is_video()) { message.set_type(RTMPMessageType::VIDEO_DATA); } else { // 非音视频数据,跳过 return; } message.set_stream_id(stream_id); message.set_timestamp(packet.timestamp); message.set_payload(packet.data); connection.send_message(message); }

播放流

以下是播放流的简化步骤和示例代码:

- 发送play命令:

void send_play_command(RTMPConnection& connection, uint32_t stream_id, const std::string& stream_name) {

RTMPMessage message;

message.set_type(RTMPMessageType::COMMAND_AMF0);

message.set_stream_id(stream_id);

message.set_timestamp(0);

AMFObject command;

command["command_name"] = "play";

command["transaction_id"] = 0.0; // 播放操作无需事务ID

command["command_object"] = AMFNull();

command["stream_name"] = stream_name;

message.set_payload(encode_amf0(command));

connection.send_message(message);

}

- 接收音视频数据:

void receive_av_data(RTMPConnection& connection, AVPacketCallback callback) {

while (true) {

RTMPMessage message = connection.receive_message();

if (message.type() == RTMPMessageType::AUDIO_DATA || message.type() == RTMPMessageType::VIDEO_DATA) {

AVPacket packet;

packet.timestamp = message.timestamp();

packet.data = message.payload();

if (message.type() == RTMPMessageType::AUDIO_DATA) {

packet.set_audio();

} else {

packet.setvideo();

}

// 调用回调函数处理音视频数据

callback(packet);

}

}

}

在实际项目中,你可能还需要处理其他类型的消息,如控制消息、元数据消息等。此外,音视频数据通常需要解码和渲染,以实现播放功能。这些实现细节可能依赖于具体的编解码库和渲染库,如FFmpeg和SDL等。

本节提供了发布和播放流的简化代码实现和示例。在实际项目中,你可能需要根据具体需求进行调整和优化。希望这些示例能帮助你更好地理解RTMP协议的实现方式,以实现高效、低延迟的流媒体传输。

5.RTMP发布与播放流

本节将重点讲述RTMP发布与播放流的过程与实现。发布流通常用于将音视频数据传输到服务器,而播放流则用于从服务器接收音视频数据。通过实现发布与播放流,可以满足各种场景的实时音视频传输需求,如直播、点播等。

RTMP发布流的过程与实现

在实现RTMP发布流之前,我们需要确保已经建立了RTMP连接并创建了流。以下是RTMP发布流的主要过程和实现要点:

- 发送publish命令:客户端向服务器发送一个publish命令,其中包含需要发布的流名称和类型。类型可以是"live"(实时直播)、“record”(录制直播)或"append"(追加直播)。

- 处理服务器响应:客户端需要处理服务器对publish命令的响应,以确保服务器已成功接收到该命令。服务器可能会返回一个“NetStream.Publish.Start”事件,表示开始发布流;或者返回一个“NetStream.Publish.BadName”事件,表示流名称冲突或其他错误。

- 发送音视频数据:客户端需要发送音频和视频数据。音频数据使用RTMPMessageType::AUDIO_DATA类型的消息发送,视频数据使用RTMPMessageType::VIDEO_DATA类型的消息发送。这些消息应包含音视频数据的时间戳,以便服务器正确同步音视频播放。

- 发送元数据:如果需要,客户端可以发送一个元数据消息,包含音视频的相关信息,如分辨率、帧率、编码格式等。这有助于服务器和其他客户端了解流的属性。

- 关闭发布流:当需要停止发布流时,客户端可以发送一个FCPublish命令,告诉服务器关闭流。服务器可能会返回一个“NetStream.Unpublish.Success”事件,表示流已成功关闭。

实现发布流时,可以使用现有的开源库,如librtmp或FFmpeg,这些库为RTMP协议提供了广泛的支持。在实际项目中,你可能还需要处理其他类型的消息,如控制消息、用户控制事件等。

RTMP播放流的过程与实现

在实现RTMP播放流之前,我们需要确保已经建立了RTMP连接并创建了流。以下是RTMP播放流的主要过程和实现要点:

-

发送play命令:客户端向服务器发送一个play命令,其中包含需要播放的流名称。服务器会根据流名称找到对应的音视频数据,并开始发送给客户端。

void send_play_command(RTMPConnection& connection, uint32_t stream_id, const std::string& stream_name) { RTMPMessage message; message.set_type(RTMPMessageType::COMMAND_AMF0); message.set_stream_id(stream_id); message.set_timestamp(0); AMFObject command; command["command_name"] = "play"; command["transaction_id"] = 0.0; // 播放操作无需事务ID command["command_object"] = AMFNull(); command["stream_name"] = stream_name; message.set_payload(encode_amf0(command)); connection.send_message(message); } - 处理服务器响应:客户端需要处理服务器对play命令的响应,以确保服务器已成功接收到该命令。服务器可能会返回一个“NetStream.Play.Start”事件,表示开始播放流;或者返回一个“NetStream.Play.StreamNotFound”事件,表示找不到指定的流。

- 接收元数据:在开始播放流之前,客户端可能会收到一个元数据消息,其中包含了音视频流的相关信息,如分辨率、帧率、编码格式等。客户端应处理这些信息,以便正确解码和渲染音视频数据。

-

接收音视频数据:客户端需要接收并处理服务器发送的音频和视频数据。音频数据使用RTMPMessageType::AUDIO_DATA类型的消息接收,视频数据使用RTMPMessageType::VIDEO_DATA类型的消息接收。这些消息包含音视频数据的时间戳,以便客户端正确同步音视频播放。

void receive_av_data(RTMPConnection& connection, AVPacketCallback callback) { while (true) { RTMPMessage message = connection.receive_message(); if (message.type() == RTMPMessageType::AUDIO_DATA || message.type() == RTMPMessageType::VIDEO_DATA) { AVPacket packet; packet.timestamp = message.timestamp(); packet.data = message.payload(); if (message.type() == RTMPMessageType::AUDIO_DATA) { packet.set_audio(); } else { packet.set_video(); } // 调用回调函数处理音视频数据 callback(packet); } } } - 控制播放流:在播放过程中,客户端可以发送其他命令来控制流的播放,如pause、resume、seek等。服务器会相应地调整音视频数据的发送。

- 关闭播放流:当需要停止播放流时,客户端可以发送一个closeStream命令,告诉服务器关闭流。服务器可能会返回一个“NetStream.Play.Stop”事件,表示流已成功关闭。

实现播放流时,可以使用现有的开源库,如librtmp或FFmpeg,这些库为RTMP协议提供了广泛的支持。在实际项目中,你可能还需要处理其他类型的消息,如控制消息、用户控制事件等。

音视频数据通常需要解码和渲染,以实现播放功能。这些实现细节可能依赖于具体的编解码库和渲染库,如FFmpeg和SDL等。

void play_stream(RTMPConnection& connection, uint32_t stream_id, const std::string& stream_name, AVPacketCallback callback) {

// 发送play命令

send_play_command(connection, stream_id, stream_name);

// 接收音视频数据

receive_av_data(connection, callback);

}

本节讲解了RTMP发布与播放流的过程与实现,包括命令消息、音视频数据消息、元数据消息等。这些知识可以帮助你更好地理解和实现RTMP协议,以在实际项目中实现高效、低延迟的流媒体传输。

发布与播放流的代码实现与示例

本节将提供一个简化的C++代码示例,演示如何使用RTMP协议实现发布与播放流。为简化说明,我们将使用伪代码表示,并假设已经实现了RTMPConnection类及其他相关类。

发布流代码示例

假设已经建立了RTMP连接并创建了流,以下是发布音视频流的简化代码示例:

void send_publish_command(RTMPConnection& connection, uint32_t stream_id, const std::string& stream_name) {

// ...省略发送publish命令的实现...

}

void send_av_data(RTMPConnection& connection, uint32_t stream_id, const AVPacket& packet) {

// ...省略发送音视频数据的实现...

}

void publish_stream(RTMPConnection& connection, uint32_t stream_id, const std::string& stream_name, AVPacketSource source) {

// 发送publish命令

send_publish_command(connection, stream_id, stream_name);

// 发送音视频数据

AVPacket packet;

while (source.get_next_packet(packet)) {

send_av_data(connection, stream_id, packet);

}

}

播放流代码示例

假设已经建立了RTMP连接并创建了流,以下是播放音视频流的简化代码示例:

void send_play_command(RTMPConnection& connection, uint32_t stream_id, const std::string& stream_name) {

// ...省略发送play命令的实现...

}

void receive_av_data(RTMPConnection& connection, AVPacketCallback callback) {

// ...省略接收音视频数据的实现...

}

void play_stream(RTMPConnection& connection, uint32_t stream_id, const std::string& stream_name, AVPacketCallback callback) {

// 发送play命令

send_play_command(connection, stream_id, stream_name);

// 接收音视频数据

receive_av_data(connection, callback);

}

在实际项目中,你可能还需要处理其他类型的消息,如控制消息、元数据消息等。此外,音视频数据通常需要解码和渲染,以实现播放功能。这些实现细节可能依赖于具体的编解码库和渲染库,如FFmpeg和SDL等。

6. RTMP性能优化与扩展

RTMP延迟优化

尽管RTMP协议本身具有低延迟的特点,但在实际应用中仍需要关注性能优化以保持更低的延迟。以下是一些RTMP延迟优化的方法:

- 减少关键帧间隔:关键帧(I帧)是视频编码中完整的图像帧,播放过程中需要等待下一个关键帧到达才能开始播放。减小关键帧间隔可以缩短等待时间,从而降低延迟。然而,过于频繁的关键帧会导致视频质量下降,因此需要在延迟和质量之间取得平衡。

- 降低分块大小:RTMP协议采用分块传输,将数据分成多个较小的块进行发送。减小分块大小可以缩短数据发送的时间,提高传输速率。然而,过小的分块大小会导致传输效率降低,因此需要权衡分块大小和传输效率。

- 优化TCP套接字缓冲区:RTMP协议基于TCP协议传输数据,调整TCP套接字缓冲区大小可以影响数据发送和接收的速度。在高速网络环境下,增大缓冲区大小可能会提高传输速率,从而降低延迟。

- 使用更快的编解码器:音视频数据需要经过编解码处理才能进行传输和播放。使用更快的编解码器可以缩短处理时间,从而降低延迟。实际选择时,可以考虑支持硬件加速的编解码器。

- 启用时钟同步:RTMP协议的时间戳是以毫秒为单位的相对时间。确保发送端和接收端的时钟同步可以降低延迟,提高音视频播放的连贯性。

- 减少网络中转节点:RTMP数据在发送端和接收端之间可能经过多个网络节点。减少中转节点可以降低网络延迟,提高传输速率。为此,可以优化网络拓扑或采用更高效的路由策略。

RTMP协议扩展

虽然RTMP协议已经相当成熟,但根据实际需求,我们仍可以对其进行扩展以满足特定场景下的需求。以下是一些可能的RTMP协议扩展:

- 安全性增强:RTMP协议的安全性可以通过使用RTMPS、RTMPE和RTMPT等变种来增强。例如,RTMPS通过在RTMP上使用SSL/TLS加密来提供安全传输,而RTMPE和RTMPT则分别为加密传输和HTTP隧道传输提供支持。在实际应用中,可以根据需要选择适当的安全协议。

- 自适应码率调整:实时调整视频质量以适应网络条件可以带来更好的观看体验。在RTMP协议中,可以通过实现自定义命令或扩展数据消息来实现自适应码率调整。通过实时监控网络状况并调整码率,可以在保证流畅播放的同时提高视频质量。

- 多码率支持:对于点播场景,提供多个不同码率的视频流可以让用户根据自己的网络环境和设备选择合适的视频质量。可以通过在服务器端实现多码率转码和切片,然后使用RTMP协议的扩展功能来选择和切换不同的码率。

- 双向音视频通信:虽然RTMP协议主要用于音视频直播和点播,但它也可以支持双向音视频通信,如视频会议。为实现此功能,可以扩展RTMP协议,使其支持同时接收和发送音视频数据。

- 内容分发网络(CDN)整合:为实现大规模直播和点播业务,可以将RTMP协议与内容分发网络(CDN)结合使用。这可以通过将RTMP服务器配置为CDN的边缘节点来实现,从而实现更快速、更可靠的音视频传输。

- 跨平台支持:随着移动互联网和物联网的发展,支持不同平台的RTMP客户端变得越来越重要。可以通过扩展现有的RTMP库,使其支持更多操作系统和硬件平台,从而满足不同应用场景的需求。

总之,通过对RTMP协议的优化和扩展,我们可以实现更低延迟、更高质量、更安全可靠的流媒体传输。在实际项目中,应根据具体需求和场景选择合适的优化和扩展方法,以实现最佳的音视频传输效果。

RTMP传输速率控制与优化

在实际应用中,音视频传输的速率受到多种因素的影响,例如网络状况、编解码器性能以及播放设备等。为了确保流畅的播放体验,我们需要对RTMP传输速率进行有效地控制和优化。以下是一些RTMP传输速率控制与优化的方法:

- 自适应码率调整:根据实时的网络状况动态调整音视频流的码率,可以确保在不同网络环境下都能保持较好的播放体验。自适应码率调整可以通过监测网络带宽和延迟等指标来实现。在网络状况较好时,提高码率以获得更高的画质;在网络状况较差时,降低码率以减少卡顿和延迟。

- 缓冲区策略:通过调整发送端和接收端的缓冲区大小,可以对RTMP传输速率进行更细致的控制。较大的缓冲区可以减少因网络波动造成的卡顿,但会增加播放延迟。反之,较小的缓冲区可以降低延迟,但可能导致播放不稳定。因此,在实际应用中需要根据具体场景和需求选择合适的缓冲区策略。

- 速率限制:在某些场景下,为确保网络资源的公平分配或避免过高的带宽消耗,我们可能需要对RTMP传输速率进行限制。速率限制可以通过在服务器端设置传输速率上限或调整编码参数来实现。

- 选择合适的编码器:编码器的选择会影响到音视频传输的速率和质量。不同的编码器具有不同的压缩效率,高效的编码器可以在保证画质的前提下降低传输速率。例如,H.264和H.265编码器通常比MPEG-2和VP8编码器具有更高的压缩效率。

- 负载均衡和内容分发网络(CDN):在大规模的直播和点播场景下,负载均衡和内容分发网络(CDN)可以有效地优化RTMP传输速率。通过在不同地域部署服务器节点并采用负载均衡策略,可以降低网络延迟,提高传输速率和稳定性。

- 网络优化:优化网络拓扑结构、调整路由策略以及提高链路质量等手段都可以对RTMP传输速率产生积极影响。通过优化网络设备的配置,例如调整TCP窗口大小和拥塞控制算法,可以改善数据传输性能。同时,确保网络设备的稳定运行和及时升级也是提高传输速率的重要手段。

- 统计与监控:实时收集RTMP传输速率、延迟、丢包率等关键指标,可以帮助我们更好地了解实际网络状况,并为优化措施提供数据支持。结合实际需求,可以通过定期报告、可视化面板等形式展现统计结果,以便进行实时监控和故障排查。

- 多码率支持:在实际应用中,为满足不同网络环境和终端设备的需求,可以提供多个不同码率的音视频流。用户可以根据自己的网络状况和设备性能选择合适的码率,从而获得更好的观看体验。此外,可以结合自适应码率技术实现更加智能的码率切换。

- 协议优化与扩展:针对特定场景,可以考虑对RTMP协议进行优化或扩展。例如,增强RTMP协议的安全性、实现双向音视频通信、提供更高效的时钟同步机制等。这些优化和扩展可以帮助提高RTMP传输速率,同时提升整体性能和用户体验。

总之,通过采用这些策略和方法,我们可以对RTMP传输速率进行有效的控制和优化。在实际项目中,应根据具体需求和场景选择合适的优化措施,以实现更流畅、更高质量的音视频传输。

7. RTMP应用实践

搭建自己的RTMP服务器:Nginx与SRS等

在实际应用中,搭建一个自己的RTMP服务器可以帮助我们更好地控制和优化音视频流的传输。以下介绍两个常见的开源RTMP服务器:Nginx和SRS(Simple-RTMP-Server)。

Nginx

Nginx 是一款高性能的Web服务器和反向代理服务器,通过安装和配置RTMP模块,可以轻松地搭建RTMP服务器。以下是使用Nginx搭建RTMP服务器的基本步骤:

- 安装Nginx:首先需要在服务器上安装Nginx。安装方法取决于你使用的操作系统,可以参考官方文档的安装指南。

- 安装RTMP模块:RTMP模块并未包含在Nginx的标准发行版中,需要从源代码中单独编译和安装。可以从这里下载RTMP模块的源代码,然后按照文档中的指引进行编译和安装。

- 配置Nginx:在

nginx.conf配置文件中,需要为RTMP模块添加一些基本配置。以下是一个简单的例子:

上述配置将在1935端口上创建一个名为“live”的RTMP应用。客户端可以通过rtmp { server { listen 1935; application live { live on; } } }rtmp://<server_address>:1935/live/<stream_key>来发布和播放音视频流。 - 启动Nginx:完成配置后,重新启动Nginx以使配置生效。

SRS(Simple-RTMP-Server)

SRS(Simple-RTMP-Server)是一个专为流媒体传输而设计的高性能开源服务器,支持RTMP、HLS、HTTP-FLV等协议。以下是使用SRS搭建RTMP服务器的基本步骤:

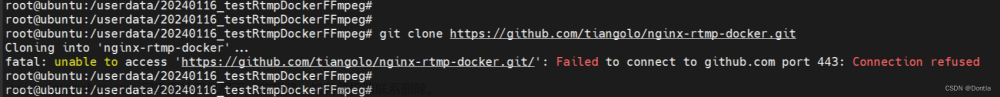

- 安装SRS:从SRS的GitHub仓库下载源代码,然后按照文档中的说明进行编译和安装。

- 配置SRS:在

srs.conf配置文件中,需要为RTMP模块添加一些基本配置。以下是一个简单的例子:

上述配置将在1935端口上创建一个名为“live”的RTMP应用。客户端可以通过listen 1935; max_connections 1000; srs_log_tank file; srs_log_file ./objs/srs.log; http_server { enabled on; listen 8080; dir ./objs/nginx/html; } rtmp { server { listen 1935; chunk_size 4000 buflen 1000; application live { live on; } } }rtmp://<server_address>:1935/live/<stream_key>来发布和播放音视频流。此外,还开启了一个HTTP服务器,用于提供网页播放器等资源。 - 启动SRS:完成配置后,使用

./objs/srs -c <path_to_srs.conf>命令启动SRS。

无论是选择Nginx还是SRS作为RTMP服务器,都可以在搭建过程中根据实际需求进行个性化配置,例如支持多应用、提供录制功能、集成CDN等。在实际应用中,搭建和维护自己的RTMP服务器可以为音视频流的传输提供更多的灵活性和控制力。

利用FFmpeg进行RTMP推流与拉流

FFmpeg 是一款开源的多媒体处理工具,它可以用于对音视频文件进行转码、裁剪、合并等操作。同时,FFmpeg也可以用于实现RTMP推流(发布)与拉流(播放)。

以下是使用FFmpeg进行RTMP推流与拉流的基本操作:

命令行推流(发布)

假设你已经搭建了一个RTMP服务器,并获得了服务器地址(<server_address>)和流密钥(<stream_key>),可以使用以下命令将本地文件(例如input.mp4)推送到RTMP服务器:

ffmpeg -re -i input.mp4 -c:v libx264 -preset veryfast -maxrate 3000k -bufsize 6000k -vf "format=yuv420p" -g 50 -c:a aac -b:a 160k -ac 2 -ar 44100 -f flv rtmp://<server_address>/live/<stream_key>

上述命令将:

- 使用

-re参数以实时速度读取输入文件。 - 将输入文件的视频流使用libx264编码器进行转码,并设置预设为

veryfast,最大码率为3000kbps,缓冲区大小为6000kbps。 - 将视频格式转换为yuv420p。

- 将输入文件的音频流使用AAC编码器进行转码,设置音频比特率为160kbps,通道数为2,采样率为44100Hz。

- 最后将转码后的音视频流以FLV格式推送到指定的RTMP地址。

命令行拉流(播放)

使用FFmpeg从RTMP服务器拉取音视频流并播放,可以使用以下命令:

ffplay rtmp://<server_address>/live/<stream_key>

这个命令将使用FFmpeg内置的播放器(ffplay)播放RTMP流。你也可以将RTMP流保存为本地文件或转发到其他服务器等。

需要注意的是,FFmpeg的功能非常丰富,上述命令只是一个基本示例。在实际应用中,可以根据需要调整参数或添加其他功能,例如实现自适应码率、添加水印、进行视频滤镜处理等。

要在C++程序中使用FFmpeg库进行RTMP推流和拉流,首先需要安装FFmpeg库并配置相关头文件和库文件。在编写代码之前,请确保已正确安装和配置FFmpeg库。

以下示例展示了如何在C++中使用FFmpeg库实现RTMP推流和拉流功能:

C++ 编写推流(发布)

#include <iostream>

#include <cstdio>

#include <cstring>

extern "C" {

#include <libavformat/avformat.h>

#include <libavcodec/avcodec.h>

#include <libavutil/opt.h>

#include <libavutil/imgutils.h>

}

int main(int argc, char *argv[]) {

const char *input_file = "input.mp4";

const char *rtmp_url = "rtmp://<server_address>/live/<stream_key>";

// Register FFmpeg components

av_register_all();

avformat_network_init();

// Open input file

AVFormatContext *input_format_ctx = nullptr;

if (avformat_open_input(&input_format_ctx, input_file, nullptr, nullptr) < 0) {

std::cerr << "Cannot open input file: " << input_file << std::endl;

return -1;

}

if (avformat_find_stream_info(input_format_ctx, nullptr) < 0) {

std::cerr << "Cannot find input stream information" << std::endl;

return -1;

}

int video_stream_index = -1;

for (int i = 0; i < input_format_ctx->nb_streams; i++) {

if (input_format_ctx->streams[i]->codecpar->codec_type == AVMEDIA_TYPE_VIDEO) {

video_stream_index = i;

break;

}

}

if (video_stream_index == -1) {

std::cerr << "Cannot find video stream" << std::endl;

return -1;

}

// Open output RTMP stream

AVFormatContext *output_format_ctx = nullptr;

if (avformat_alloc_output_context2(&output_format_ctx, nullptr, "flv", rtmp_url) < 0) {

std::cerr << "Cannot create output context" << std::endl;

return -1;

}

if (!(output_format_ctx->oformat->flags & AVFMT_NOFILE)) {

if (avio_open2(&output_format_ctx->pb, rtmp_url, AVIO_FLAG_WRITE, nullptr, nullptr) < 0) {

std::cerr << "Cannot open output URL: " << rtmp_url << std::endl;

return -1;

}

}

AVStream *output_stream = avformat_new_stream(output_format_ctx, nullptr);

if (!output_stream) {

std::cerr << "Cannot create output stream" << std::endl;

return -1;

}

output_stream->time_base = input_format_ctx->streams[video_stream_index]->time_base;

if (avcodec_parameters_copy(output_stream->codecpar, input_format_ctx->streams[video_stream_index]->codecpar) < 0) {

std::cerr << "Cannot copy codec parameters" << std::endl;

return -1;

}

output_stream->codecpar->codec_tag = 0;

if (avformat_write_header(output_format_ctx, nullptr) < 0) {

std::cerr << "Cannot write header" << std::endl;

return -1;

}

// Main loop to read input file and write to output RTMP stream

AVPacket packet;

av_init_packet(&packet);

packet.data = nullptr;

packet.size = 0;

while (av_read_frame(input_format_ctx, &packet) >= 0) {

// Check if the packet belongs to the video stream

if (packet.stream_index == video_stream_index) {

packet.pts = av_rescale_q_rnd(packet.pts, input_format_ctx->streams[video_stream_index]->time_base,

output_stream->time_base, static_cast<AVRounding>(AV_ROUND_NEAR_INF | AV_ROUND_PASS_MINMAX));

packet.dts = av_rescale_q_rnd(packet.dts, input_format_ctx->streams[video_stream_index]->time_base,

output_stream->time_base, static_cast<AVRounding>(AV_ROUND_NEAR_INF | AV_ROUND_PASS_MINMAX));

packet.duration = av_rescale_q(packet.duration, input_format_ctx->streams[video_stream_index]->time_base,

output_stream->time_base);

packet.pos = -1;

packet.stream_index = 0;

if (av_interleaved_write_frame(output_format_ctx, &packet) < 0) {

std::cerr << "Error while writing video frame" << std::endl;

break;

}

}

av_packet_unref(&packet);

}

// Flush any remaining packets and write trailer

av_write_trailer(output_format_ctx);

// Close input and output formats and clean up

avformat_close_input(&input_format_ctx);

if (output_format_ctx && !(output_format_ctx->oformat->flags & AVFMT_NOFILE)) {

avio_closep(&output_format_ctx->pb);

}

avformat_free_context(output_format_ctx);

return 0;

}

C++ 编写拉流(播放)

为了在C++代码中实现RTMP拉流并播放,可以使用SDL库创建窗口和渲染器。请确保已正确安装和配置SDL库。此外,本示例仅包含视频播放,不包括音频播放。

#include <iostream>

#include <cstdio>

#include <cstring>

extern "C" {

#include <libavformat/avformat.h>

#include <libavcodec/avcodec.h>

#include <libavutil/imgutils.h>

#include <libavutil/time.h>

#include <libswscale/swscale.h>

#include <SDL.h>

}

int main(int argc, char *argv[]) {

const char *rtmp_url = "rtmp://<server_address>/live/<stream_key>";

// Register FFmpeg components

av_register_all();

avformat_network_init();

// Initialize SDL

if (SDL_Init(SDL_INIT_VIDEO | SDL_INIT_AUDIO | SDL_INIT_TIMER)) {

std::cerr << "Cannot initialize SDL: " << SDL_GetError() << std::endl;

return -1;

}

// Open RTMP stream

AVFormatContext *format_ctx = nullptr;

if (avformat_open_input(&format_ctx, rtmp_url, nullptr, nullptr) < 0) {

std::cerr << "Cannot open input stream: " << rtmp_url << std::endl;

return -1;

}

if (avformat_find_stream_info(format_ctx, nullptr) < 0) {

std::cerr << "Cannot find stream information" << std::endl;

return -1;

}

int video_stream_index = -1;

for (int i = 0; i < format_ctx->nb_streams; i++) {

if (format_ctx->streams[i]->codecpar->codec_type == AVMEDIA_TYPE_VIDEO) {

video_stream_index = i;

break;

}

}

if (video_stream_index == -1) {

std::cerr << "Cannot find video stream" << std::endl;

return -1;

}

AVCodecParameters *codecpar = format_ctx->streams[video_stream_index]->codecpar;

AVCodec *codec = avcodec_find_decoder(codecpar->codec_id);

if (!codec) {

std::cerr << "Cannot find decoder" << std::endl;

return -1;

}

AVCodecContext *codec_ctx = avcodec_alloc_context3(codec);

if (!codec_ctx) {

std::cerr << "Cannot allocate codec context" << std::endl;

return -1;

}

if (avcodec_parameters_to_context(codec_ctx, codecpar) < 0) {

std::cerr << "Cannot copy codec parameters to codec context" << std::endl;

return -1;

}

if (avcodec_open2(codec_ctx, codec, nullptr) < 0) {

std::cerr << "Cannot open codec" << std::endl;

return -1;

}

// Initialize SDL window and renderer

SDL_Window *window = SDL_CreateWindow("RTMP Player",

SDL_WINDOWPOS_UNDEFINED, SDL_WINDOWPOS_UNDEFINED,

codec_ctx->width, codec_ctx->height,

SDL_WINDOW_OPENGL | SDL_WINDOW_RESIZABLE);

if (!window) {

std::cerr << "Cannot create SDL window: " << SDL_GetError() << std::endl;

return -1;

}

SDL_Renderer *renderer = SDL_CreateRenderer(window, -1, SDL_RENDERER_ACCELERATED | SDL_RENDERER_PRESENTVSYNC);

if (!renderer) {

std::cerr << "Cannot create SDL renderer: " << SDL_GetError() << std::endl;

return -1;

}

SDL_Texture *texture = SDL_CreateTexture(renderer, SDL_PIXELFORMAT_YV12, SDL_TEXTUREACCESS_STREAMING,

codec_ctx->width, codec_ctx->height);

if (!texture) {

std::cerr << "Cannot create SDL texture: " << SDL_GetError() << std::endl;

return -1;

}

// Main loop to read and display frames

AVFrame *frame = av_frame_alloc();

AVFrame *frame_yuv = av_frame_alloc();

uint8_t *out_buffer = (uint8_t *) av_malloc(av_image_get_buffer_size(AV_PIX_FMT_YUV420P, codec_ctx->width, codec_ctx->height, 1));

av_image_fill_arrays(frame_yuv->data, frame_yuv->linesize, out_buffer, AV_PIX_FMT_YUV420P, codec_ctx->width, codec_ctx->height, 1);

SwsContext *sws_ctx = sws_getContext(codec_ctx->width, codec_ctx->height, codec_ctx->pix_fmt,

codec_ctx->width, codec_ctx->height, AV_PIX_FMT_YUV420P,

SWS_BICUBIC, nullptr, nullptr, nullptr);

AVPacket packet;

av_init_packet(&packet);

packet.data = nullptr;

packet.size = 0;

while (av_read_frame(format_ctx, &packet) >= 0) {

if (packet.stream_index == video_stream_index) {

if (avcodec_send_packet(codec_ctx, &packet) >= 0) {

while (avcodec_receive_frame(codec_ctx, frame) >= 0) {

sws_scale(sws_ctx, frame->data, frame->linesize, 0, codec_ctx->height, frame_yuv->data, frame_yuv->linesize);

// Update the texture and display the frame

SDL_UpdateYUVTexture(texture, nullptr,

frame_yuv->data[0], frame_yuv->linesize[0],

frame_yuv->data[1], frame_yuv->linesize[1],

frame_yuv->data[2], frame_yuv->linesize[2]);

SDL_RenderClear(renderer);

SDL_RenderCopy(renderer, texture, nullptr, nullptr);

SDL_RenderPresent(renderer);

}

}

}

av_packet_unref(&packet);

}

// Clean up

sws_freeContext(sws_ctx);

av_frame_free(&frame);

av_frame_free(&frame_yuv);

av_packet_unref(&packet);

avcodec_close(codec_ctx);

avcodec_free_context(&codec_ctx);

avformat_close_input(&format_ctx);

SDL_DestroyTexture(texture);

SDL_DestroyRenderer(renderer);

SDL_DestroyWindow(window);

SDL_Quit();

return 0;

}

这段代码将从RTMP服务器拉取视频流并在SDL窗口中进行播放。请确保将<server_address>和<stream_key>替换为实际的RTMP服务器地址和流密钥。

C++ 开发基于RTMP协议的直播与点播系统

在设计一个基于C++和RTMP协议的直播与点播系统时,需要考虑如下设计思想、架构和所需头文件。

设计思想

- 模块化: 将系统划分为多个模块,例如推流、拉流、视频处理、音频处理、网络通信等。这样可以将不同的功能分开,提高代码的可读性和可维护性。

- 易扩展性: 架构应易于扩展,以便支持更多的功能,如新的协议或编解码器,以及对性能的优化。

- 高性能: 使用异步I/O、多线程等技术来提高性能。对于多核处理器系统,需要充分利用其并行处理能力。

- 跨平台: 考虑跨平台的兼容性,使系统可以在不同的操作系统(如Windows,Linux和MacOS)上运行。

架构

基于上述设计思想,可以将直播与点播系统划分为以下几个主要模块:

- 网络通信: 使用RTMP协议进行推流和拉流操作。可以考虑使用C++的Boost.Asio库实现异步I/O操作,以提高性能。

- 视频处理: 对视频流进行编解码、缩放、裁剪等操作。可使用FFmpeg库实现。

- 音频处理: 对音频流进行编解码、重采样、混音等操作。可使用FFmpeg库实现。

- 多媒体容器: 处理多媒体容器格式,如FLV、MP4等。可使用FFmpeg库实现。

- 存储与分发: 实现将视频和音频流存储到磁盘上,以便进行点播。同时,实现将直播流分发到多个观众。

- 用户接口: 提供命令行或图形用户界面,使用户可以进行推流、拉流、设置参数等操作。

8.RTMP与HTML5

HTML5视频技术与RTMP的对比

HTML5视频技术:HTML5引入了<video>元素,使得在浏览器中播放视频变得简单且无需安装任何插件。HTML5视频支持多种编码格式,如H.264、VP8、VP9等。HTML5视频技术的优势包括:

- 跨平台兼容性:HTML5视频可以在各种浏览器和设备上播放,包括移动设备。

- 无需插件:HTML5视频无需Flash插件即可在浏览器中播放,减少了安全风险和兼容性问题。

- 与Web技术的集成:HTML5视频可以方便地与其他Web技术(如CSS、JavaScript)集成,实现丰富的用户体验。

RTMP(Real-Time Messaging Protocol):RTMP是一种用于实时音视频传输的协议,最初由Macromedia(后被Adobe收购)开发。RTMP依赖于Adobe Flash Player进行视频播放,因此需要安装Flash插件。RTMP的优势包括:

- 低延迟:RTMP协议专为实时传输而设计,提供较低的延迟。

- 高性能:RTMP可以在各种网络环境下提供稳定的音视频传输。

- 广泛应用:RTMP协议曾是网络直播和视频传输的主流选择,尤其在Adobe Flash Player的高峰期。

然而,随着HTML5视频技术的普及和Adobe Flash Player的逐渐淘汰,RTMP协议的使用也在减少。现在,许多开发者和企业更倾向于使用HTML5视频技术。

利用WebRTC实现RTMP到WebRTC的转换

WebRTC(Web Real-Time Communication)是一种基于浏览器的实时通信技术,允许进行点对点的音视频通话和数据传输。WebRTC可以实现低延迟的实时音视频传输,并且无需安装插件。

要将RTMP流转换为WebRTC,可以使用以下步骤:

- 使用媒体服务器(如Wowza、Janus、Kurento等)接收RTMP流。

- 将RTMP流解码为原始音视频帧。

- 将原始音视频帧编码为WebRTC支持的格式(如VP8、VP9、H.264)。

- 使用媒体服务器将编码后的音视频帧通过WebRTC传输到客户端。

RTMP协议与HTML5视频技术的融合应用

尽管RTMP协议的使用逐渐减少,但在某些特定场景中,将RTMP协议与HTML5视频技术融合仍具有一定的价值和应用前景。例如:

- 实时直播:在实时直播领域,RTMP协议的低延迟特性仍然具有优势。通过将RTMP协议与HTML5视频技术结合,可以提供更好的跨平台兼容性和用户体验。同时,结合WebRTC技术可以实现低延迟、无插件的实时音视频传输。

- 旧系统的逐步升级:对于仍在使用RTMP协议的旧系统,可以考虑逐步将RTMP协议与HTML5视频技术融合。这样可以在保持原有功能的基础上,逐步过渡到现代Web技术,提高系统的兼容性和可维护性。

- 混合应用场景:在某些混合应用场景中,如需要同时支持实时直播和点播功能,将RTMP协议与HTML5视频技术融合可以实现更丰富的功能和更好的用户体验。

总之,将RTMP协议与HTML5视频技术融合可以在特定场景中发挥各自的优势,实现更高效、更兼容的音视频应用。随着Web技术的不断发展,未来可能会出现更多的融合应用和新的技术方案。

9. RTMP协议在现实场景中的应用案例

RTMP(Real-Time Messaging Protocol)协议是一种实时消息传输协议,主要应用于音视频直播和点播场景。尽管HTML5和WebRTC等技术的发展已经逐渐替代了RTMP协议的部分应用,但RTMP协议在某些现实场景中仍具有一定的应用价值。以下是一些RTMP协议在现实场景中的应用案例:

- 在线直播平台:在线直播平台(如Twitch、YouTube Live、Facebook Live等)使用RTMP协议作为其音视频传输的基础,从而实现低延迟、高性能的实时直播。主播可以通过各种直播编码器(如OBS、XSplit等)将音视频流推送至直播平台,观众则可以通过各种播放器或浏览器观看直播内容。

- 远程教育与在线课堂:RTMP协议在远程教育和在线课堂中发挥重要作用。教师可以利用RTMP协议进行实时教学,学生可以通过浏览器或专用的学习软件观看直播课程。RTMP协议保证了实时性和稳定性,使得远程教育成为可能。

- 企业会议与远程协作:企业会议和远程协作也是RTMP协议的应用场景之一。企业可以通过RTMP协议搭建内部的视频会议系统,实现多方实时音视频通信。此外,远程协作工具(如Zoom、Microsoft Teams等)也可以利用RTMP协议进行实时通信。

- 视频监控系统:RTMP协议在视频监控系统中也具有一定的应用。通过将监控摄像头捕捉的音视频流通过RTMP协议传输,管理员可以实时查看远程摄像头的画面。RTMP协议的低延迟和高性能特点保证了视频监控系统的实时性和稳定性。

- 媒体服务器与CDN:媒体服务器和内容分发网络(CDN)也是RTMP协议的应用场景。使用RTMP协议,可以将实时音视频流从源服务器传输到全球各地的边缘服务器,从而实现低延迟的全球范围内的内容分发。

10.总结与展望

RTMP协议的优势与局限性

在本文中,我们讨论了RTMP协议。在此,我们总结一下RTMP协议的优势和局限性。

优势:

- 低延迟:RTMP协议专为实时音视频传输设计,提供较低的延迟,适用于实时直播等场景。

- 高性能:RTMP在各种网络环境下都可以提供稳定的音视频传输性能。

- 广泛应用:RTMP协议曾是网络直播和视频传输的主流选择,在某些领域和行业中仍具有较高的普及率。

局限性:

- 对Flash插件的依赖:RTMP协议依赖于Adobe Flash Player进行视频播放,需要用户安装插件。随着HTML5视频技术的普及,越来越多的浏览器和设备不再支持Flash插件,导致RTMP协议的使用范围受限。

- 跨平台兼容性:相较于HTML5视频技术,RTMP协议的跨平台兼容性较差,尤其在移动设备上的支持较弱。

- 与Web技术的集成:RTMP协议与现代Web技术(如CSS、JavaScript)的集成相对较复杂,不如HTML5视频技术简单易用。

展望未来,随着HTML5视频技术和WebRTC等实时通信技术的不断发展,RTMP协议的使用将可能继续减少。然而,在某些特定场景和行业中,将RTMP协议与HTML5视频技术融合仍具有一定的价值和应用前景。为了实现更高效、更兼容的音视频应用,开发者和企业需要关注新的技术发展趋势,并灵活地运用和整合各种技术方案。

RTMP协议在现实场景中的应用案例

RTMP(Real Time Messaging Protocol)是一种实时消息传输协议,主要用于在 Flash 播放器和服务器之间传输音视频数据和元数据。以下是 RTMP 协议在现实场景中的一些应用案例:

- 实时直播:RTMP 协议在实时直播领域有广泛应用,尤其是在 Flash 技术盛行时期。实时直播平台可以使用 RTMP 协议将现场活动、体育赛事、游戏直播等实时传输到观众的设备上。由于 RTMP 协议的低延迟和实时性特点,观众可以享受到流畅的直播体验。

- 视频会议:RTMP 协议也可以应用于多人视频会议场景,实现实时音视频传输。参与者可以通过支持 RTMP 的客户端软件实时接收和发送音视频数据,实现高质量的远程沟通。

- 在线教育:RTMP 协议在在线课堂和远程教育系统中具有一定的应用。教师可以使用支持 RTMP 的直播工具将讲解画面实时传输给学生,学生则可以通过支持 RTMP 的播放器观看实时视频流。

- 网络电视和广播:RTMP 协议在网络电视和广播中也有一定的应用。电视台和广播电台可以通过 RTMP 协议将节目实时传输到互联网上,观众和听众可以通过支持 RTMP 的客户端软件收听和收看。

- 社交媒体:一些社交媒体平台支持使用 RTMP 协议进行实时视频分享。用户可以使用支持 RTMP 的直播工具将自己的生活瞬间实时分享给好友和粉丝。

需要注意的是,随着 Flash 技术的逐渐淘汰,以及 HTML5、WebRTC、HLS 等技术的普及,RTMP 协议的应用范围已经有所减少。不过,在某些特定场景下,RTMP 仍然具有一定的应用价值。

结语

从心理学的角度来看,RTMP(实时消息传输协议)在现实生活中的应用,在监控、直播、会议以及远程教育等场景对人们的心理需求产生了重要影响。以下是从心理学的角度对 RTMP 博客的总结:文章来源:https://www.toymoban.com/news/detail-425661.html

- 社交互动:RTMP 协议在实时直播和视频会议场景中使得人们可以实时地进行音视频互动,满足了人类在社交和沟通方面的心理需求。在疫情期间,这种实时互动的方式帮助人们跨越地理障碍,保持社交联系,缓解孤独感。

- 自主学习:在在线教育和远程教育系统中,RTMP 协议为人们提供了更多自主学习的机会。学生可以根据自己的需求和进度选择课程,实现个性化学习。此外,实时互动的特点有助于增加学生的学习动力和参与度,提高学习效果。

- 归属感和认同感:RTMP 协议在社交媒体平台上的应用,使得人们可以实时分享自己的生活瞬间,与好友和粉丝进行实时互动。这种实时分享和交流有助于满足人们对归属感和认同感的需求,增强社交纽带。

- 实时信息获取:通过网络电视和广播的 RTMP 协议传输,观众和听众可以实时获取新闻、娱乐和教育等方面的信息。这种实时获取信息的方式,满足了人们对信息渴求的心理需求,使得人们能够及时了解世界动态和趋势。

- 适应性:RTMP 协议在各种场景下的应用,表明了人类在技术进步和环境变化面前的适应性。在现代社会,人们需要面对快速发展的技术和不断变化的生活方式。尽管 RTMP 协议受到 HTML5 和其他技术的挑战,但在某些场景下仍具有一定的应用价值,反映了人们在适应新技术发展过程中的心理调适能力。

总之,从心理学角度来看,RTMP 协议在现实生活中的应用对人们的心理需求产生了积极影响。通过满足人们在社交互动、自主学习、归属感、实时信息获取和适应性等方面的需求.文章来源地址https://www.toymoban.com/news/detail-425661.html

到了这里,关于RTMP协议深度解析:从原理到实践,掌握实时流媒体传输技术的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!