1.首先

这个问题时由于GTX16xx系列显卡导致的,只要是使用GTX16xx系列显卡跑yolo系列算法的时候基本上都会遇到这个问题,真是搞得我头大,当我第一次遇到这个问题的时候,我只是简单地认为是学习率过大导致梯度爆炸,但是后来我上网查资料才发现问题出现在我的显卡上面,我的是GTX1650(还能再战),GTX16xx系列显卡在cuda使用较新版本时会出现该问题。导致了PyTorch里面一些CUDA代码有些问题,就是fp16(float16)数据类型在卷积等一些运算的时候会出现nan值。导致了训练时候出现了nan值。

2.解决方法

解决方法一:

我在网上查询资料发现,这个问题用CPU跑的时候不会出现问题,但是使用CPU跑的速度可以说是比蜗牛还慢。

把PyTorch版本降为1.10.1和CUDA 10.2,这是我在网上查到的第一个解决问题的方案,我尝试过确实能解决问题,但是训练时长长了很多,而且现在PyTorch官方已经不怎么支持使用CUDA 10.2版本了。不推荐此方案,详情可点击点这里

解决方法二:

yolo算法存在nan值,及说明在训练的时候就出现问题了,所以我们要train.py里面作出修改,

一,在train.py中使用Crtl+F搜索amp把amp = check_amp(model)直接注释掉然后在下面把amp赋值为False,如下图:

这样就可以解决问题了,如果还是有问题,那你只能尝试方案一了。我就是这样解决问题了,

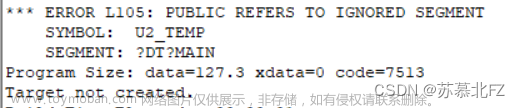

贴图:这是未解决问题之前: 文章来源:https://www.toymoban.com/news/detail-426202.html

文章来源:https://www.toymoban.com/news/detail-426202.html

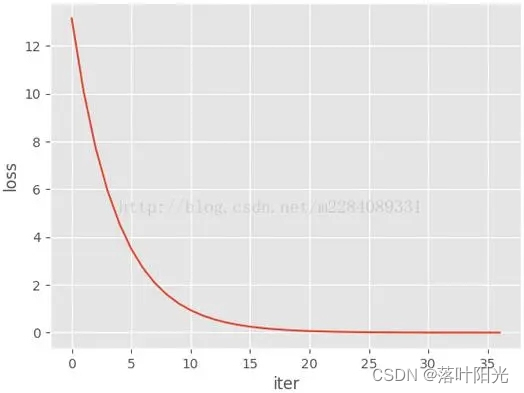

这是解决问题之后:

可以看到loss再不断减小,问题已解决文章来源地址https://www.toymoban.com/news/detail-426202.html

到了这里,关于yolo系列算法训练时loss出现nan值,解决办法(GTX16xx系列显卡的问题)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!