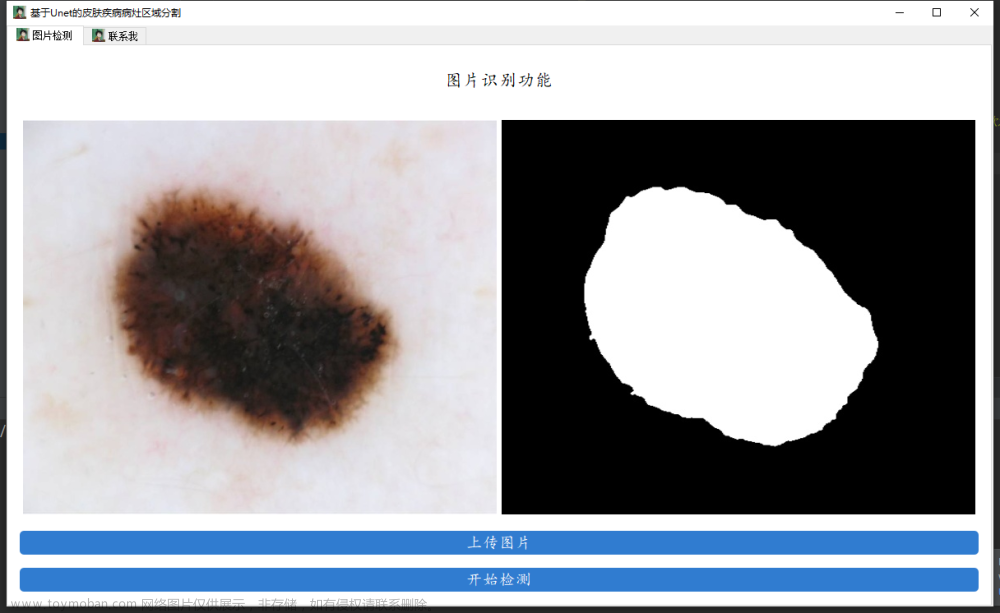

0. 介绍

文章: Exploiting Temporality for Semi-Supervised Video Segmentation

代码: https://github.com/mhashas/Exploiting-Temporality-For-Semi-Supervised-Video-Segmentation

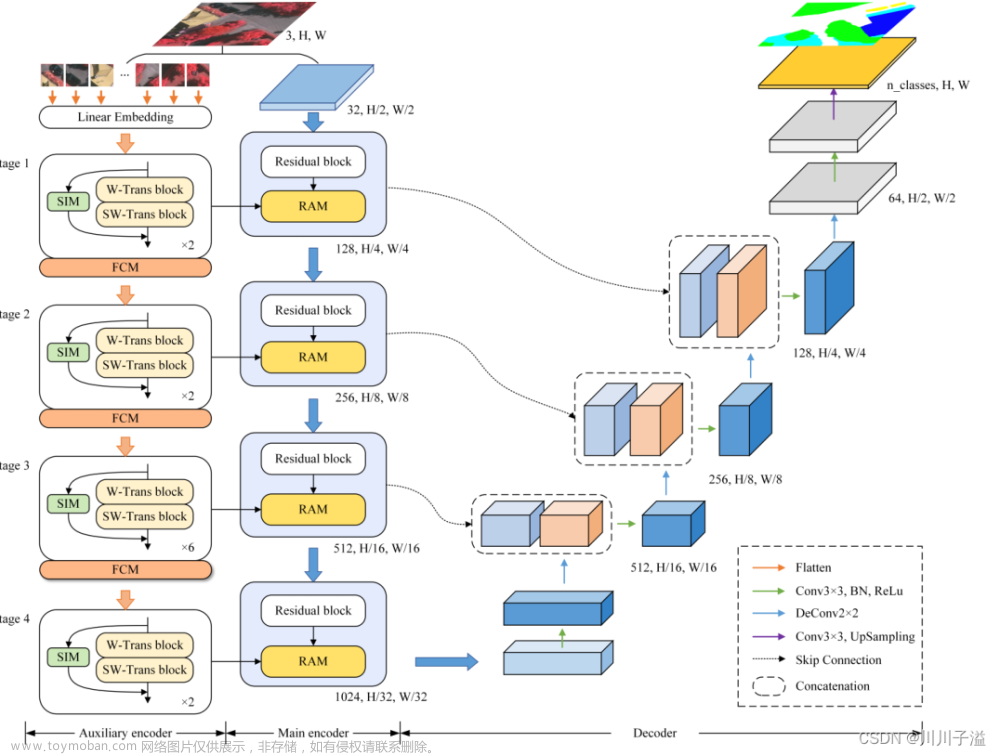

理解: 使用单帧标注,对视频进行分割。利用时间维度信息来推断空间信息。将传统FCN转化成时间-空间FCN。

方法: 通过FCN语义分割网络,对时间信息建模。

框架:

时间建模: 通常将FCN+Lstm进行结合,对时间信息进行建模。一般学习时间信息的Lstm是将CHW的特征进行一维展品。这会导致空间信息的丢失。因此通过使用ConVLSTM可以保存维度不变。

数据集: 对CityScapes的每个数据选取30帧,其中,仅第20帧具有相对应的标签 。

训练输入:输入四幅连续的图像(第14、16、18、20帧),其中第20帧含有标签。

1. ConvLstm

1.1 Lstm

http://colah.github.io/posts/2015-08-Understanding-LSTMs/

https://blog.csdn.net/u013398034/article/details/112789084

RNN: 在距离相距不大时,可以通过RNN利用之前的信息。当距离变大,记忆衰减,无法建立上下文信息的连接

RNN的理解:https://zhuanlan.zhihu.com/p/30844905

在LSTM和GRU中,内部的各种门多采用sigmoid激活函数,因为需要确定“0-1”的各种状态;而隐状态的激活函数多采用tanh。

RNN的每个时间步的权重是相同的,bp过程相当于权重的连续相乘,因此比CNN更容易出现梯度消失和梯度爆炸,因此采用tanh比较多。tanh也会出现梯度消失和梯度爆炸,但是相比于Sigmoid好很多了。理论上ReLU+梯度裁切也可以。

4个time-steps:

LSTM: LSTM可以解决短期记忆问题

相对于RNN的重复模块(单个tanh层),LSTM具有四个交互层

f(t)表示遗忘,σ代表sigmoid,输出的值为0-1,即f(t)的值趋于+∞时,结果趋于1,反之则为0,这个表示对上一状态遗忘了多少。

这一步表示储存,其中的σ用来决定更新值,tanh用来创建一个新的候选值,

这一步用来更新掉旧的值,并添加新的信息。C(t-1)通过f(t)将旧信息遗忘,通过上一步更新为新的值。

这一步决定输出哪些信息。σ决定输出哪些信息。首先,上一步更新的值输入到tanh然后乘以一个σ的输出,最后就输出决定要输出的部分。

1.2 ConvLstm

https://www.jianshu.com/p/a82c0ad728f1

https://blog.csdn.net/m0_50539226/article/details/121779369

https://arxiv.org/pdf/1506.04214v1.pdf

ConvLstm基于Lstm,但Lstm只能获取时间维度上的信息。由于采用了卷积核,有了聚合空间上信息的能力

与LSTM不同之处

- 将fully-connect layer改成convolutional layer

- input是3D tensor

- 核大小越大能够捕获更快的动作,否则捕获慢动作

- 实现端到端的操作,能够处理边界问题,以及效果优于光流

- 模型的输入:(batch_size, timestep, channel_dim, height, weight)

细节分析:传统的Lstm是一种特殊的ConvLstm, 传统的Lstm的核大小是整个图像或者输入。

ConvLstm使用卷积核得到的输出,会受限于卷积核的大小,步长,为保证输出的大小一致,因此需要进行填充。其填充部分类似于给未来的预测提供预留通道。即预测的结果慢慢的向内部聚拢。文章来源:https://www.toymoban.com/news/detail-426613.html

把Lstm中矩阵相乘的地方替换成卷积。 文章来源地址https://www.toymoban.com/news/detail-426613.html

文章来源地址https://www.toymoban.com/news/detail-426613.html

到了这里,关于【图像分割】Unet-ConvLstm利用时序信息进行视频分割的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!