用chatgpt解释chagpt自己的实现原理和机制,是一种什么体验?

1. GPT-1(Improving Language Understanding by Generative Pre-Training)

1.0 用中文详细解释下这篇文章的Abstract

这篇文章的Abstract部分主要介绍了Generative Pre-Training方法的研究背景、目标和贡献。具体来说,Abstract部分包括以下几个方面:

-

研究背景:首先,Abstract部分介绍了自然语言理解领域中的一个重要问题,即如何在缺乏标记数据的情况下提高模型性能。虽然大量未标记文本数据是可用的,但是针对特定任务的标记数据却很少,这使得训练有监督模型变得困难。

-

目标和方法:接着,Abstract部分介绍了Generative Pre-Training方法的目标和方法。Generative Pre-Training方法旨在通过预训练语言模型和Fine-tuning微调,在缺乏标记数据的情况下提高自然语言理解任务的性能。具体来说,该方法使用大量未标记文本数据进行预训练,并使用Fine-tuning微调技术将预训练模型应用于特定任务。

-

贡献:最后,Abstract部分总结了Generative Pre-Training方法在多个自然语言理解任务上取得的显著性能提升,并强调了该方法对于缺乏标记数据情况下自然语言处理领域的重要意义。

总之,Abstract部分简明扼要地介绍了Generative Pre-Training方法的研究背景、目标和贡献,为读者快速了解该方法提供了帮助。

1.1 introduction

这篇文章的Introduction主要介绍了一种新的自然语言理解方法——Generative Pre-Training,该方法可以通过预训练语言模型来提高自然语言理解的性能。文章首先指出了自然语言理解在文本蕴含、问答、语义相似度评估和文档分类等任务中的广泛应用,并强调了这些任务所面临的挑战,即缺乏针对特定任务的标记数据。

为了解决这个问题,作者提出了一种新的方法——Generative Pre-Training。该方法利用大量未标记的文本进行预训练,并使用特定任务的输入转换进行微调,以实现对各种自然语言理解任务的有效转移。Generative Pre-Training可以显著提高文本蕴含、问答、语义相似度评估和文档分类等任务的性能。

接着,文章介绍了Generative Pre-Training方法与其他相关方法不同之处,并概述了文章后续部分的结构和内容。最后,作者总结了Generative Pre-Training方法在自然语言理解领域中具有重要意义,并指出未来研究方向。整个Introduction部分简明扼要地介绍了文章主题和内容,并引起读者对Generative Pre-Training方法及其应用前景的兴趣。

1.2 Related Work

这篇文章的Related Work部分主要介绍了与Generative Pre-Training方法相关的其他自然语言处理方法和技术。首先,文章介绍了基于循环神经网络(RNN)和卷积神经网络(CNN)的语言模型,这些模型可以用于文本分类、情感分析等任务。然而,这些模型需要大量标记数据进行训练,并且在处理长文本序列时存在一定的局限性。

接着,文章介绍了一些基于预训练语言模型的自然语言处理方法,例如ELMo、ULMFiT和GPT等。这些方法利用大量未标记的文本进行预训练,并通过Fine-tuning微调来适应特定任务。虽然这些方法在自然语言理解任务中取得了良好的性能,但是它们仍然存在一些局限性,例如需要大量计算资源和时间来进行预训练和Fine-tuning微调,并且可能会出现过拟合等问题。

最后,文章介绍了一些基于迁移学习的自然语言处理方法,例如Multi-Task Learning和Cross-Lingual Transfer Learning等。这些方法可以将不同任务或不同语种之间的知识进行共享和迁移,从而提高模型性能。虽然这些方法在某些情况下可以取得良好的效果,但是它们仍然存在一些限制,例如需要大量标记数据来进行训练,并且可能会出现任务之间的干扰等问题。

总之,Related Work部分介绍了Generative Pre-Training方法与其他自然语言处理方法和技术的异同之处,并为读者提供了更全面的背景知识。这些方法和技术为自然语言理解领域的研究提供了重要参考。

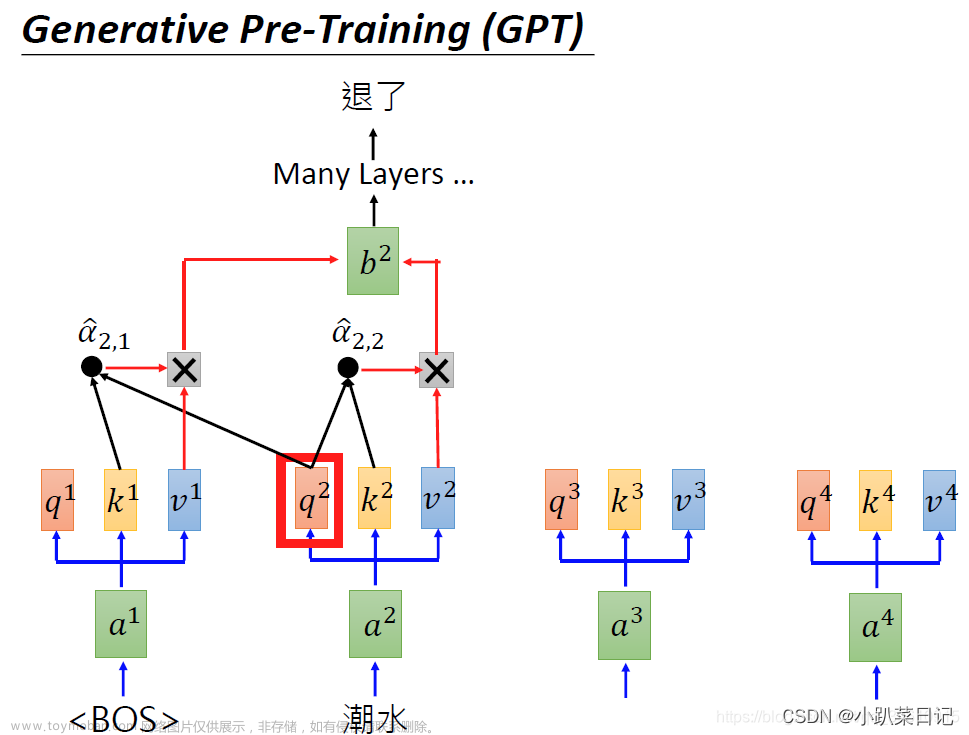

1.3 Framework

这篇文章的Framework部分主要介绍了Generative Pre-Training方法的实现过程和技术细节。具体来说,Framework部分包括以下几个方面:

-

预训练语言模型:首先,使用量未标记的文本语料库来预训练一个语言模型。这个语言模型可以是基于循环神经网络(RNN)或变换器(Transformer)等结构,用于学习文本序列中的概率分布。

-

Fine-tuning微调:接着,使用特定任务的标记数据对预训练好的语言模型进行Fine-tuning微调。Fine-tuning微调是指在特定任务上对预训练好的模型进行有监督学习,以适应该任务的特定要求。在Fine-tuning微调过程中,可以使用不同的输入转换技术来提高性能。

-

输入转换技术:输入转换技术是指将原始输入转换为更适合特定任务的形式。例如,在问答任务中,可以将问题和答案拼接成一个序列,并在序列之间添加分隔符;在文本蕴含任务中,可以将前提和假设拼接成一个序列,并添加特殊标记来表示前提和假设之间的关系。

-

无监督学习:Generative Pre-Training方法还可以通过无监督学习来进一步提高性能。例如,在预训练阶段,可以使用掩码语言模型(Masked Language Model)来预测文本序列中的缺失部分,以提高模型对文本序列的理解能力。

总之,Framework部分详细介绍了Generative Pre-Training方法的实现过程和技术细节。通过预训练语言模型和Fine-tuning微调,Generative Pre-Training方法可以在不同的自然语言理解任务中取得良好的性能。同时,输入转换技术和无监督学习等技术也可以进一步提高模型的性能。Framework部分为读者提供了一个清晰的实现框架,使得读者可以更好地理解Generative Pre-Training方法的工作原理和优势。

1.4 Experiments

这篇文章的Experiments部分主要介绍了Generative Pre-Training方法在多个自然语言理解任务上的实验结果。具体来说,Experiments部分包括以下几个方面:

-

实验设置:首先,文章介绍了实验所使用的数据集和评估指标。数据集包括文本蕴含、问答、语义相似度评估和文档分类等任务,评估指标包括准确率、F1值、Pearson相关系数等。

-

实验结果:接着,文章详细介绍了Generative Pre-Training方法在各个任务上的实验结果。实验结果表明,Generative Pre-Training方法可以显著提高自然语言理解任务的性能,在多个数据集上取得了最新的最佳性能。

-

对比实验:为了进一步验证Generative Pre-Training方法的有效性,文章还进行了与其他自然语言处理方法和技术的对比实验。对比实验包括基于循环神经网络(RNN)和卷积神经网络(CNN)的语言模型、基于预训练语言模型的自然语言处理方法(如ELMo、ULMFiT等)以及基于迁移学习的自然语言处理方法(如Multi-Task Learning和Cross-Lingual Transfer Learning等)。对比实验结果表明,Generative Pre-Training方法在多个任务上均取得了最佳性能。

-

分析和讨论:最后,文章对实验结果进行了分析和讨论。分析结果表明,Generative Pre-Training方法可以有效地捕捉文本序列中的长距离依赖关系,并且可以将这种知识成功地转移到各种自然语言理解任务中。此外,文章还探讨了Generative Pre-Training方法的一些局限性和未来

1.5 Analysis

这篇文章的Analysis部分主要对Generative Pre-Training方法的实验结果进行了深入的分析和讨论。具体来说,Analysis部分包括以下几个方面:

-

模型性能:首先,文章对Generative Pre-Training方法在各个自然语言理解任务上的性能进行了详细的分析。实验结果表明,Generative Pre-Training方法可以显著提高自然语言理解任务的性能,在多个数据集上取得了最新的最佳性能。此外,文章还探讨了模型性能与数据集规模、Fine-tuning微调次数等因素之间的关系。

-

输入转换技术:接着,文章对输入转换技术在Generative Pre-Training方法中的作用进行了分析。输入转换技术是指将原始输入转换为更适合特定任务的形式。实验结果表明,使用不同的输入转换技术可以显著提高模型在特定任务上的性能。

-

无监督学习:除此之外,文章还探讨了无监督学习在Generative Pre-Training方法中的作用。无监督学习是指使用未标记数据来预训练语言模型以提高模型性能。实验结果表明,在预训练阶段使用掩码语言模型(Masked Language Model)可以进一步提高模型性能。

-

模型分析:最后,文章对Generative Pre-Training方法的模型结构和参数进行了分析。实验结果表明,Generative Pre-Training方法可以有效地捕捉文本序列中的长距离依赖关系,并且可以将这种知识成功地转移到各种自然语言理解任务中。此外,文章还探讨了模型结构和参数对模型性能的影响。

总之,Analysis部分对Generative Pre-Training方法的实验结果进行了深入的分析和讨论,从多个角度探讨了该方法的优势和局限性。这些分析和讨论为进一步提高模型性能、探索更多输入转换技术和无监督学习技术等提供了有益的启示和建议。同时,这些分析也为读者更好地理解Generative Pre-Training方法的工作原理和优势提供了帮助。

1.6 Conclusion

这篇文章的Conclusion部分主要总结了Generative Pre-Training方法的优势和贡献,并提出了一些未来研究方向。具体来说,Conclusion部分包括以下几个方面:

-

优势和贡献:首先,文章总结了Generative Pre-Training方法的优势和贡献。Generative Pre-Training方法通过预训练语言模型和Fine-tuning微调,可以在多个自然语言理解任务上取得最新的最佳性能。与其他自然语言处理方法和技术相比,Generative Pre-Training方法具有更好的泛化能力、更高的效率和更少的标记数据需求。

-

未来研究方向:接着,文章提出了一些未来研究方向。其中包括进一步提高模型性能、探索更多的输入转换技术、扩展到其他语种和领域、探索更多无监督学习技术等。

-

结论:最后,文章强调了Generative Pre-Training方法在自然语言理解领域中的重要性,并呼吁学术界和工业界共同努力推动该领域的发展。

总之,Conclusion部分对Generative Pre-Training方法进行了全面而深入的总结,并为未来相关研究提供了有益的启示和建议。

2. GPT-2(Language Models are Unsupervised Multitask Learners)

2.0 Abstract

这篇文章的Abstract部分是对全文的简要概括。作者们指出,自然语言处理任务(如问答、机器翻译、阅读理解和摘要等)通常是通过在特定数据集上进行有监督学习来解决的。然而,这种方法需要大量标记数据,并且对于每个任务都需要单独的数据集和模型。为了解决这个问题,本文提出了一种无监督多任务学习的语言模型,该模型可以在没有显式监督的情况下学习自然语言处理任务。

作者们使用一个名为WebText的大规模未标记文本数据集来训练这个语言模型,并展示了该模型在多项自然语言处理任务上取得很好的性能。当给定一个文档和问题时,该模型生成的答案在CoQA数据集上达到了55 F1分数,与3个基线系统相当或超过其性能,而不使用127,000多个训练示例。

总之,Abstract部分简要介绍了本文提出的无监督多任务学习方法以及使用WebText数据集训练语言模型并在多项自然语言处理任务上取得很好性能的结果。

2.1 introduction

这篇文章的介绍部分主要讨论了自然语言处理任务的传统方法,即在特定数据集上进行有监督学习。这种方法需要大量标记数据,而且对于每个任务都需要单独的数据集和模型。然而,这种方法存在一些限制,例如需要大量人工标注、难以扩展到新任务等。

为了解决这些问题,本文提出了一种无监督多任务学习的语言模型。该模型使用一个新的数据集WebText进行训练,该数据集包含数百万个网页,并且没有任何显式监督。通过这种方式,语言模型可以开始学习自然语言处理任务而不需要特定的数据集或显式监督。

此外,本文还展示了如何通过增加语言模型容量来进一步提高其性能,并提供了WebText语言模型在多项自然语言处理任务上的零-shot表现。最后,本文总结了无监督多任务学习是一种有效的方法来训练自然语言处理模型,并且可以通过增加容量来进一步提高性能。

2.2 Approach

这篇文章的Approach部分介绍了本文提出的无监督多任务学习方法的基本原理。该方法的核心是语言建模,即从一组由变长符号序列(s1,s2,…,sn)组成的示例(x1,x2,…,xn)中估计无监督分布。由于语言具有自然的顺序性,因此通常将联合概率分解为符号上的条件概率乘积(Jelinek&Mercer,1980)(Bengio等人,2003):

p(x) = ∏i=1^n p(sn|s1,…,sn-1) (1)

这种方法允许从p(x)和任何形式为p(sn-k,…,sn|s1,…,sn-k-1)的条件中进行可行的采样和估计。

总之,Approach部分介绍了本文提出的无监督多任务学习方法是如何使用语言建模来估计无监督分布,并且可以从中进行可行的采样和估计。

2.3 Experiments

这篇文章的Experiments部分介绍了作者们进行的实验。首先,他们使用WebText数据集训练了一个语言模型,并在多项自然语言处理任务上进行了测试,包括问答、机器翻译、阅读理解和摘要等。结果表明,该语言模型可以在这些任务上取得很好的性能,而且不需要特定的数据集或显式监督。

接下来,作者们展示了如何通过增加语言模型容量来进一步提高其性能。他们使用了两种不同的方法来增加容量:增加隐藏层大小和增加训练数据量。结果表明,在所有任务中,随着容量的增加,性能也会相应地提高。

最后,作者们还比较了无监督多任务学习和有监督学习之间的差异。他们发现,在给定足够大的语言模型时,无监督多任务学习可以在某些任务上达到与有监督学习相当甚至更好的性能。但是,在某些其他任务上,有监督学习仍然是更好的选择。

总之,Experiments部分展示了作者们如何使用WebText数据集训练语言模型,并通过实验展示了无监督多任务学习和有监督学习之间的差异。

2.4 Generalization vs Memorization

这篇文章的Generalization vs Memorization部分主要讨论了机器学习系统中的泛化和记忆问题。作者们指出,最近在计算机视觉领域的研究表明,常见的图像数据集中包含大量近似重复的图像。例如,CIFAR-10数据集在训练和测试图像之间有3.3%的重叠(Barz&Denzler,2019)。这导致机器学习系统过度报告泛化性能。随着数据集大小的增加,这个问题变得越来越普遍,这表明类似现象可能也会发生在WebText数据集上。因此,分析测试数据在训练数据中出现的频率非常重要。

总之,Generalization vs Memorization部分提醒我们,在进行机器学习时需要注意泛化和记忆问题,并且需要对测试数据和训练数据之间的重叠进行分析。

2.5 Related Work和Discussion

这篇文章的Related Work部分主要介绍了与本文相关的其他研究工作。作者们指出,以前的研究主要集中在使用更大的语言模型和更大的数据集来提高自然语言处理任务的性能。但是,这些方法需要大量标记数据,并且对于每个任务都需要单独的数据集和模型。相比之下,本文提出了一种无监督多任务学习的语言模型,该模型可以在没有显式监督的情况下学习自然语言处理任务。

Discussion部分总结了本文的贡献和限制,并讨论了未来可能的研究方向。作者们指出,无监督多任务学习是一种有效的方法来训练自然语言处理模型,并且可以通过增加容量来进一步提高性能。此外,他们还展示了如何使用WebText数据集来训练语言模型,并在多项自然语言处理任务上进行测试。但是,作者们也承认本文存在一些限制,例如WebText数据集可能存在偏差和噪声等问题。未来可能需要更好地理解这些问题并开发更好的方法来解决它们。

总之,Related Work部分介绍了与本文相关的其他研究工作,而Discussion部分总结了本文贡献和限制,并探讨了未来可能的研究方向。

2.6 Conclusion

这篇文章的Conclusion部分总结了本文的主要贡献和结论。作者们指出,本文提出了一种无监督多任务学习的语言模型,该模型可以在没有显式监督的情况下学习自然语言处理任务,并且可以通过增加容量来进一步提高性能。他们使用WebText数据集训练了这个语言模型,并在多项自然语言处理任务上进行了测试,结果表明该模型可以取得很好的性能。

此外,作者们还比较了无监督多任务学习和有监督学习之间的差异,并发现在某些任务上无监督多任务学习可以达到与有监督学习相当甚至更好的性能。但是,在某些其他任务上,有监督学习仍然是更好的选择。

总之,本文提出了一种新颖的无监督多任务学习方法来训练自然语言处理模型,并展示了该方法在多项自然语言处理任务上取得很好的性能。这个方法不需要特定的数据集或显式监督,并且可以通过增加容量来进一步提高性能。未来可能需要更好地理解这个方法并开发更好的技术来解决其中存在的问题。

3. GPT-3(Language Models are Few-Shot Learners)

3.0 Abstract

这篇文章的摘要主要介绍了最近在自然语言处理(NLP)任务和基准测试中,通过对大量文本进行预训练,然后在特定任务上进行微调所取得的显著进展。虽然这种方法通常在架构上是任务无关的,但仍需要数千个或数万个示例的特定任务微调数据集。

相比之下,人类通常可以从仅有几个示例或简单指令中执行新的语言任务,而当前的NLP系统在这方面仍然存在很大挑战。

本文展示了通过扩大语言模型规模可以极大地提高任务无关、少样本学习性能,有时甚至达到先前最先进的微调方法竞争力。

具体来说,作者们训练了一个名为GPT-3的自回归语言模型,其参数数量达到了1750亿个,是任何以前非稀疏语言模型的10倍,并测试了它在少样本情况下的性能表现。

3.1 Introduction

这篇文章的引言部分主要介绍了自然语言处理(NLP)中的一个重要问题,即如何让计算机像人类一样理解和处理自然语言。

目前,大多数NLP系统都需要大量的数据和计算资源来进行训练和微调,而且它们通常只能在特定任务上表现出色。相比之下,人类可以从很少的示例或简单指令中学习新的语言任务,并且可以在不同的任务之间灵活转换。

为了解决这个问题,近年来出现了一种新的方法,即使用预训练语言模型来进行少样本学习。这种方法通过对大量文本进行预训练,使得模型能够理解自然语言中的常见模式和结构,并在特定任务上进行微调以实现更好的性能。

本文旨在探讨这种方法的有效性,并介绍最新的研究成果和挑战。

3.2 Approach

这篇文章的方法部分主要介绍了使用预训练语言模型进行少样本学术。

首先,作者们使用大量的文本数据对语言模型进行预训练,以使其能够理解自然语言中的常见模式和结构。

然后,他们使用特定任务的数据集对模型进行微调,以实现更好的性能。在微调过程中,作者们采用了一种称为“零样本学习”的技术,即在没有任何特定任务数据的情况下对模型进行微调。这种技术通过在微调过程中引入一些辅助信息来帮助模型学习新任务,并且可以大大减少需要用于微调的数据量。

此外,作者还介绍了一些其他技术和策略,如多任务学习、动态掩码等,以进一步提高模型性能和泛化能力。

总之,这篇文章提供了一个全面而系统的方法框架,可以帮助研究人员设计和实现高效、准确、通用的NLP系统。

3.3 Results

这篇文章的结果部分主要介绍了使用预训练语言模型进行少样本学习的实验结果。

作者们使用了一个名为GPT-3的自回归语言模型,该模型具有1750亿个参数,是以前任何非稀疏语言模型的10倍。作者们在多个NLP任务上对GPT-3进行了测试,包括语言建模、填空、闭卷式问答和翻译等任务。

实验结果表明,GPT-3在少样本情况下表现出色,并且有时甚至可以达到先前最先进的微调方法竞争力。

此外,作者还对GPT-3进行了一些进一步的分析和评估,如测试集污染研究、人类质量评估等。

总之,这些实验结果表明预训练语言模型可以作为一种有效的少样本学习方法,并且具有广泛的应用前景。

3.4 Measuring and Preventing Memorization Of Benchmarks

这篇文章的“Measuring and Preventing Memorization Of Benchmarks”部分主要介绍了在使用预训练语言模型进行少样本学习时可能出现的一个问题,即模型可能会记忆训练集中的示例而不是真正理解任务。

为了解决这个问题,作者们提出了一种新的评估方法,称为“检测和防止基准测试的记忆化”。该方法通过在测试集中添加一些随机噪声来破坏模型对特定示例的记忆,并评估模型在这些扰动数据上的性能。

实验结果表明,大多数现有的语言模型都存在着不同程度的记忆化问题,并且这种问题会导致模型在真实场景下表现不佳。为了解决这个问题,作者们提出了一些防止记忆化的策略,如增加噪声、使用更多样本、限制模型容量等。

总之,“检测和防止基准测试的记忆化”是一个非常重要和实用的评估方法,可以帮助研究人员更好地理解和改进预训练语言模型。

3.5 Limitations

这篇文章的“Limitations”部分主要介绍了使用预训练语言模型进行少样本学习时可能存在的一些限制。

首先,由于训练数据集是从互联网上获取的,因此模型可能会在一些基准测试集上进行过拟合,这是一个新领域的研究,目前还没有确定的最佳实践方法。

其次,虽然GPT-3在少样本情况下表现出色,但它仍然需要大量的预训练数据才能达到这种性能水平。因此,在提高预训练样本效率方面仍有很多工作需要做。

最后,虽然GPT-3在某些任务上表现出色,但它并不是完美的,并且在某些情况下可能会出现错误或不准确的结果。

总之,“Limitations”部分提醒我们,在使用预训练语言模型进行少样本学习时需要注意这些限制,并且需要进一步研究和改进这些方法以提高其性能和泛化能力。

3.6 Broader Impacts

这篇文章的“Broader Impacts”部分主要介绍了使用预训练语言模型可能会带来的广泛影响。作者指出,预训练语言模型的应用前景非常广泛,可以用于自然语言处理、对话系统、智能问答等多个领域。

然而,这些模型也存在一些潜在的问题和风险。作者重点关注了两个主要问题:

- 第一个是GPT-3等语言模型被恶意利用的潜在风险;

- 第二个是这些模型中存在偏见、公平性和代表性等问题。

此外,作者还简要讨论了能源效率方面的问题。总之,“Broader Impacts”部分提醒我们,在使用预训练语言模型时需要注意这些潜在问题,并且需要采取措施来研究和缓解这些风险,以确保这些技术能够为人类带来更多益处。

3.7 Related Work

这篇文章的“Related Work”部分主要介绍了与预训练语言模型相关的一些研究工作。

作者首先介绍了一些早期的预训练语言模型,如ELMo和ULMFiT等,这些模型采用了不同的预训练策略和技术,并在自然语言处理任务中取得了良好的性能。

然后,作者介绍了一些最新的预训练语言模型,如BERT、GPT-2和XLNet等,这些模型采用了更加先进的预训练策略和技术,并在多个自然语言处理任务中取得了最新的最佳结果。

此外,作者还介绍了一些与本文相关的研究工作,如少样本学习、基准测试集记忆化等方面的研究。

总之,“Related Work”部分提供了一个对预训练语言模型领域相关研究工作进行概述和回顾的视角,为读者提供更全面、深入地理解该领域发展历程和现状。

3.8 Conclusion

这篇文章的“Conclusion”部分主要总结了本文的主要贡献和结论。作者指出,本文提出了一种新的评估方法,即“检测和防止基准测试的记忆化”,用于评估预训练语言模型在少样本学习中可能存在的记忆化问题。

实验结果表明,大多数现有的预训练语言模型都存在不同程度的记忆化问题,并且这种问题会导致模型在真实场景下表现不佳。为了解决这个问题,作者提出了一些防止记忆化的策略,如增加噪声、使用更多样本、限制模型容量等。

此外,作者还讨论了预训练语言模型可能带来的广泛影响和潜在风险,并提出了一些应对措施。

总之,“Conclusion”部分强调了预训练语言模型领域中一个重要而实用的评估方法,并提供了一些有益的建议和思考方向,以促进该领域更好地发展和应用。

4. GPT-4(Technical Report)

4.0 Abstract

这篇文章的Abstract部分介绍了GPT-4的开发和性能表现。GPT-4是一种大规模多模态模型,可以接受图像和文本输入并生成文本输出。虽然在许多实际场景中不如人类,但在各种专业和学术基准测试中表现出人类水平的性能,例如通过模拟律师考试并获得了约排名前10%的成绩。

GPT-4是基于Transformer的模型,预先训练以预测文档中下一个标记。通过后训练对齐过程,可以提高GPT-4在事实性和符合期望行为等方面的表现。该项目的核心组件是开发基础设施和优化方法,以在各种规模下表现可预测。

总之,Abstract部分简要介绍了GPT-4作为一种大规模多模态语言模型的开发和性能表现,并强调了其在专业和学术基准测试中达到人类水平的成就。

4.1 Introduction

Introduction部分介绍了GPT-4的开发和应用。GPT-4是一种大规模多模态模型,可以接受图像和文本输入并生成文本输出。这种模型在对话系统、文本摘要和机器翻译等领域有着广泛的应用前景,因此近年来受到了广泛的关注和研究。

文章介绍了GPT-4是一个基于Transformer的模型,预先训练以预测文档中下一个标记。通过后训练对齐过程,可以提高GPT-4在事实性和符合期望行为等方面的表现。该项目的核心组件是开发基础设施和优化方法,以在各种规模下表现可预测。

此外,文章还提到,在使用不到GPT-4计算能力1/1000的训练模型时,可以准确预测GPT-4性能的某些方面。

总之,Introduction部分主要介绍了GPT-4作为一种大规模多模态语言模型的开发和应用前景,并简要介绍了其技术特点和性能表现。

4.2 Scope and Limitations of this Technical Report

Scope and Limitations of this Technical Report部分介绍了本技术报告的范围和限制。该报告主要关注GPT-4的能力、限制和安全属性。GPT-4是一种基于Transformer的模型,预先训练以预测文档中下一个标记,使用了公开可用数据(如互联网数据)和从第三方提供商获得的数据进行训练。然后使用强化学习从人类反馈中进行微调。

由于大规模模型如GPT-4的竞争环境和安全影响,本报告不包含有关架构(包括模型大小)、硬件、训练计算、数据集构建、训练方法或类似内容的进一步详细信息。

总之,Scope and Limitations of this Technical Report部分明确了本技术报告所关注的内容范围和限制,并说明了在某些方面缺乏详细信息的原因。

4.3 Predictable Scaling

Predictable Scaling部分介绍了GPT-4项目的一个重要方面,即构建一个可预测扩展的深度学习堆栈。这是因为对于像GPT-4这样的大规模训练运行,进行广泛的模型特定调整是不可行的。为了解决这个问题,我们开发了基础设施和优化方法,在多个规模上具有非常可预测的行为。这些改进使我们能够从使用1,000倍到10,000倍较少计算资源训练的较小模型中可靠地预测GPT-4性能的某些方面。

此外,Predictable Scaling部分还提到,经过适当训练的大型语言模型的最终损失被认为可以很好地近似于用于训练模型所需计算量的幂律函数。参考文献包括[35, 36, 2, 14, 15]等。

4.4 Capabilities

Capabilities部分介绍了GPT-4作为一种大规模多模态语言模型的能力。GPT-4可以接受图像和文本输入,并生成文本输出。该模型在专业和学术基准测试中表现出人类水平的性能,例如通过模拟律师考试并获得了约排名前10%的成绩。

此外,Capabilities部分还提到,GPT-4是基于Transformer的模型,预先训练以预测文档中下一个标记。通过后训练对齐过程,可以提高GPT-4在事实性和符合期望行为等方面的表现。

总之,Capabilities部分主要介绍了GPT-4作为一种大规模多模态语言模型的能力,并强调了其在专业和学术基准测试中达到人类水平的成就。

4.5 Limitations

Limitations部分介绍了GPT-4作为一种大规模多模态语言模型的限制。该模型在某些领域仍存在能力不足的问题,例如生成的结果可能过于模糊而无法使用,或者可能会产生不实际的解决方案,或者容易出现事实错误等问题。此外,当红队员要求多步骤指导工程放射性装置或生化化合物时,该模型更容易生成含糊或不准确的响应。

总之,Limitations部分主要介绍了GPT-4作为一种大规模多模态语言模型的限制,并列举了一些可能存在的问题和局限性。

4.6 Risks & mitigations

Risks & mitigations部分介绍了GPT-4的风险和缓解措施。该部分列出了多个可能存在的风险,包括幻觉、有害内容、虚假信息和影响操作、隐私、网络安全等。为了减少这些风险,GPT-4项目采取了一系列技术缓解措施和政策执行杠杆,例如使用技术手段来减少偏见和不可靠内容的产生,并制定政策来规范模型的使用。

此外,Risks & mitigations部分还提到,专家们对GPT-4进行了早期定性红队演练,并识别出了一些初始风险。通过技术缓解措施和政策执行杠杆的组合,我们在许多已识别领域中减少了风险;然而,仍存在许多风险。我们预计随着时间的推移会进一步了解这些和其他类别的风险。

总之,Risks & mitigations部分主要介绍了GPT-4的风险和缓解措施,并强调了早期定性红队演习在识别初始风险方面的重要性。

4.7 Conclusion

Conclusion部分对GPT-4项目进行了总结。该部分指出,GPT-4是一种大规模多模态语言模型,具有人类水平的性能,并在多个自然语言处理任务上表现出色。该模型基于Transformer架构,可以接受图像和文本输入,并生成文本输出。此外,Predictable Scaling部分介绍了GPT-4项目的一个重要方面,即构建一个可预测扩展的深度学习堆栈。

然而,Limitations部分也指出了GPT-4作为一种大规模多模态语言模型的限制和可能存在的问题。为了减少这些风险,Risks & mitigations部分列出了一系列技术缓解措施和政策执行杠杆。文章来源:https://www.toymoban.com/news/detail-429463.html

总之,Conclusion部分强调了GPT-4作为一种大规模多模态语言模型的优点和局限性,并提供了对该项目未来发展方向的展望。文章来源地址https://www.toymoban.com/news/detail-429463.html

到了这里,关于让chatgpt解读自己--(GPT1/2/3/4)论文解读的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!