和ChatGPT一起学习!

因果语言建模(Causal Language Modeling,简称CLM)和条件生成(Conditional Generation)是自然语言处理(NLP)和深度学习中的两个相关概念。尽管它们在某种程度上有所重叠,但它们在目标和方法上有一定的区别。

- 因果语言建模(Causal Language Modeling):

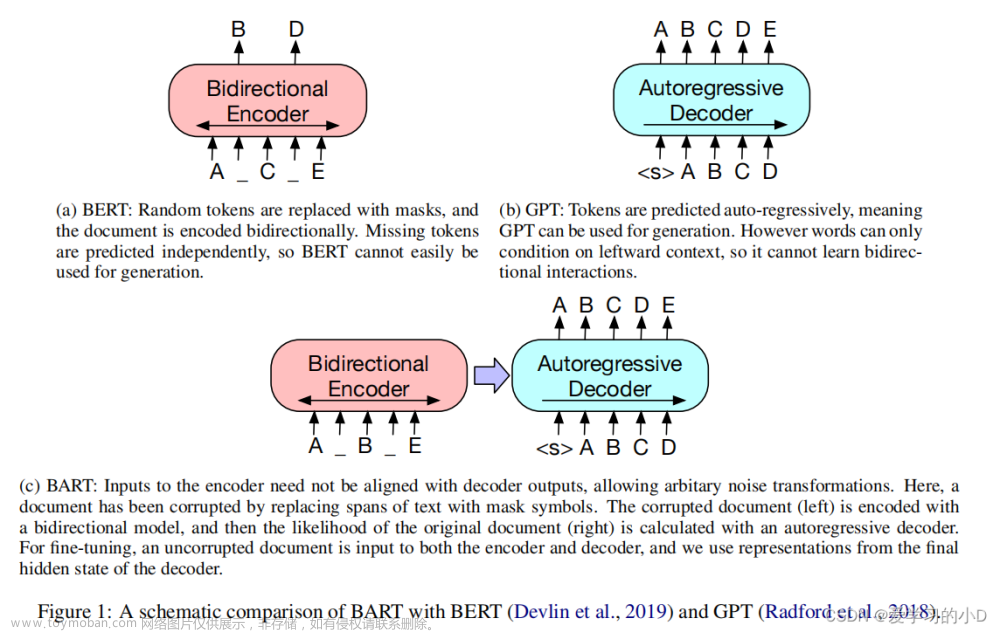

因果语言建模关注于根据给定的上下文生成文本序列。在这种建模方法中,模型试图预测给定上下文中的下一个单词,该上下文通常包括在当前单词之前的所有单词。这种建模方法遵循因果原则,即当前单词只受到其前面单词的影响,而不受后面单词的影响。

因果语言建模的一个经典应用是GPT(如GPT-2和GPT-3),它主要用于生成连贯的文本。在这种建模方法中,模型接收一个输入序列,然后生成一个自然且语法正确的输出序列。

代表模型:GPT2、Bloom、OPT、GPT-Neo、GPT-J、LLaMA、ChatGLM。

- 条件生成(Conditional Generation):

条件生成关注于生成满足特定条件或约束的文本序列。在这种建模方法中,模型根据给定的输入(可能是文本、图片等)生成符合条件的输出。与因果语言建模不同,条件生成不仅仅关注于给定上下文的连贯性,还关注于满足预定的任务要求。

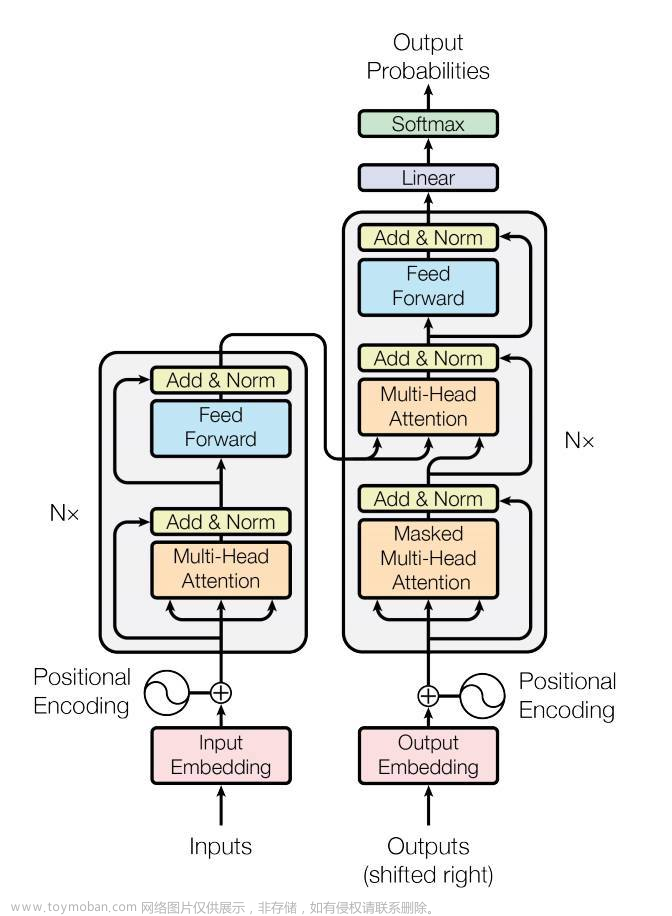

条件生成的应用包括但不限于机器翻译、文本摘要、图像描述等。这些任务通常需要模型在输入和输出之间建立复杂的映射关系。在这种建模方法中,模型可以是一个encoder-decoder结构,如序列到序列(seq2seq)模型,也可以是基于自回归的方法,如T5模型。

代表模型:BART、T5。

总之,因果语言建模主要关注于生成连贯、自然的文本,而条件生成关注于生成满足特定条件或任务要求的文本。这两种建模方法在某些场景下可能会互相使用和结合,以实现更复杂的自然语言处理任务。

文章来源:https://www.toymoban.com/news/detail-429958.html

文章来源:https://www.toymoban.com/news/detail-429958.html

文章来源地址https://www.toymoban.com/news/detail-429958.html

到了这里,关于Causal Language Modeling和Conditional Generation有什么区别的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!