从文本中“看”出主题分布:LDA模型原理、应用和实践

LDA(Latent Dirichlet Allocation)模型是一种主题建模算法,是自然语言处理(NLP)领域中最重要的技术之一。随着互联网和社交媒体的迅速发展,数据中心化和信息过载的问题变得越来越严重。面对海量的文本数据,如何从中挖掘有用的信息和知识成为了亟待解决的问题。在这样的背景下,LDA模型的应用逐渐受到关注。

通过学习LDA模型,可以了解到如何对海量文本数据进行处理和分析,并从中挖掘出潜在的主题和关键信息。LDA模型可以帮助发现文本数据的内在结构和模式,揭示出数据背后的含义和规律。具体而言,LDA模型可以用于文本分类、文本聚类、信息检索、情感分析、广告推荐等领域,是实现自然语言处理和文本分析的重要基础。

1. LDA模型的提出、发展和原理

1.1 LDA模型介绍

LDA(Latent Dirichlet Allocation)模型是一种基于概率图模型的文本主题分析方法。它最早由Blei等人在2003年提出,旨在通过对文本数据进行分析,自动发现其隐藏的主题结构。LDA模型的核心思想是将文本表示为一组概率分布,其中每个文档由多个主题混合而成,每个主题又由多个单词组成。

LDA模型的基本原理是先假设一个文本集合的生成过程:首先,从主题分布中随机选择一个主题;然后,从该主题的单词分布中随机选择一个单词;重复上述过程,直到生成整个文本。具体来说,LDA模型的生成过程包括以下三个步骤:

- 选择文档的主题分布:从狄利克雷分布(Dirichlet Distribution)中随机选择一个主题分布。

- 选择文档的主题:对于文档中的每个位置,从主题分布中随机选择一个主题。

- 选择单词:对于文档中的每个位置,从所选主题的单词分布中随机选择一个单词。

通过对这个过程进行反推,可以得到LDA模型的参数估计方法。具体来说,我们需要通过文本数据中观察到的单词来估计每个主题的单词分布以及每个文档的主题分布,然后通过这些参数来推断文本的主题结构。

1.2 LDA模型原理

-

生成模型:

LDA模型基于生成模型,即假设每篇文档都是由若干个主题混合生成的,并且每个主题又由若干个单词混合生成的。具体来说,LDA模型假设有K个主题,每个主题包含了一组单词分布。对于每篇文档,先从主题分布中随机选择一个主题,然后根据该主题的单词分布随机选择一个单词,并重复该过程直到生成完整篇文档。 -

参数估计:

LDA模型的参数估计可以通过最大似然估计或贝叶斯估计等方法进行。具体来说,需要对每篇文档中每个单词的主题进行估计,以及对每个主题中每个单词的概率分布进行估计。其中,估计文档中每个单词的主题可以通过Gibbs采样或变分推断等方法进行,而估计主题中每个单词的概率分布则可以通过矩阵分解等方法进行。 -

推断:

在LDA模型中,推断指的是对于给定的文档,估计其主题分布。通常可以使用Gibbs采样或变分推断等方法进行推断。具体来说,对于给定的文档,可以通过先验分布和文档中单词的分布推断出其主题分布,从而得到文档的主题表示。

1.3 LDA模型参数估计方法

LDA模型中的参数包括主题-词语分布参数 ϕ k \phi_{k} ϕk、文档-主题分布参数 θ d \theta_{d} θd和主题个数 K K K。估计这些参数的方法有多种,下面介绍两种常用的方法。

-

Gibbs采样方法

Gibbs采样是LDA模型中常用的参数估计方法之一。通过多轮的迭代,Gibbs采样可以得到模型参数的近似后验分布。在每轮迭代中,Gibbs采样根据当前估计的模型参数,随机采样生成下一个参数估计。最终,可以根据多个采样得到的参数,计算出模型参数的均值、标准差等统计量。 -

变分推断方法

变分推断是LDA模型中另一种常用的参数估计方法。它通过最大化似然函数来估计模型参数。具体来说,变分推断先假设潜在变量(即主题和单词)的后验分布为某个参数化的分布族,然后通过最大化变分下界来估计这些分布的参数。最终,可以得到主题-词语分布参数 ϕ k \phi_{k} ϕk和文档-主题分布参数 θ d \theta_{d} θd的近似估计。

需要注意的是,Gibbs采样和变分推断在估计模型参数时都存在一定的误差,尤其是在数据集规模较大时。此时,可以采用多轮采样或者并行计算等方法,来提高模型参数的准确性和稳定性。

1.4 主题个数确定方法

LDA模型中主题的个数是需要人为设定的一个超参数,通常用符号 K K K表示。确定主题个数的方法多种多样,下面介绍几种常用的方法:

-

经验设定法:根据实际问题和语料库的规模,给定一个主题个数的经验值。这种方法的缺点是不够科学和客观,可能会导致主题个数的选择不合理。

-

主题一致性评价法:利用主题模型中的主题一致性评价指标,比如C_V指标、UMass指标等,通过人工观察和分析,选择最优的主题个数。这种方法相对较为科学,但是需要大量的人工参与和分析,成本较高。

-

贝叶斯方法:利用贝叶斯模型选择最优的主题个数。具体地,可以通过贝叶斯信息准则(Bayesian Information Criterion, BIC)或者学习曲线(Learning Curve)等方法进行选择。这种方法相对较为客观和科学,但是计算量较大,需要较长的运行时间。

需要注意的是,主题个数的选择并不是一定有最优解的,一般需要结合实际问题和语料库特点,根据经验和分析进行选择。同时,为了保证结果的可靠性,应该进行多次实验,比较不同主题个数下的模型效果,选择最优的结果。

1.5 Gibbs采样原理

Gibbs采样是LDA模型中用于参数估计和主题推断的一种常用方法。其基本思想是在给定某个单词的主题和其他单词的主题分布的情况下,对该单词的主题进行重新采样。

具体来说,Gibbs采样需要对文档中的每个单词进行处理,重复以下步骤:

- 随机初始化该单词的主题为 k k k;

- 对于当前单词

w

w

w,计算去除该单词的主题后,文档中所有单词对应的主题分布:

p ( z i = k ∣ w , z − i , α , β ) ∝ n k , − i + α n . , − i + K α × n w , k , − i + β n k , − i + V β p(z_i = k | {\bf w}, {\bf z}{-i}, \alpha, \beta) \propto \frac{n{k,-i} + \alpha}{n_{.,-i} + K \alpha} \times \frac{n_{w,k,-i} + \beta}{n_{k,-i} + V \beta} p(zi=k∣w,z−i,α,β)∝n.,−i+Kαnk,−i+α×nk,−i+Vβnw,k,−i+β

其中, n k , − i n_{k,-i} nk,−i表示在当前文档中除去第 i i i个单词之外,主题 k k k被分配的单词数; n . , − i n_{.,-i} n.,−i表示在当前文档中除去第 i i i个单词之外,所有单词被分配的主题数; n w , k , − i n_{w,k,-i} nw,k,−i表示在当前文档中除去第 i i i个单词之外,单词 w w w被分配到主题 k k k的次数; V V V表示语料库中不同单词的总数。 - 根据上一步计算得到的主题分布,重新采样该单词的主题。

- 重复上述步骤,直到所有单词的主题均收敛为止。

Gibbs采样的优点是简单易用,同时也有较好的收敛性能。但是,在处理大规模数据时,Gibbs采样的计算复杂度较高,需要消耗大量的时间和计算资源。此时,可以考虑使用其他的算法,如变分推断等。

1.6 LDA模型其他细节介绍

-

模型的参数设置。在LDA模型中,需要设置多个参数,例如主题数、迭代次数、alpha和beta参数等。其中,主题数是一个需要根据数据集和应用场景进行选择的参数,通常可以通过主题的连贯性、主题的区分度等指标进行选择。而迭代次数、alpha和beta参数则需要根据数据集和计算资源进行调整,通常可以通过实验进行选择。

-

数据预处理。LDA模型对于输入的文本数据需要进行预处理,包括分词、去停用词、去数字和标点符号等。同时,LDA模型也需要将文本转换为词袋模型或其他文本表示方法,以便进行计算和分析。

-

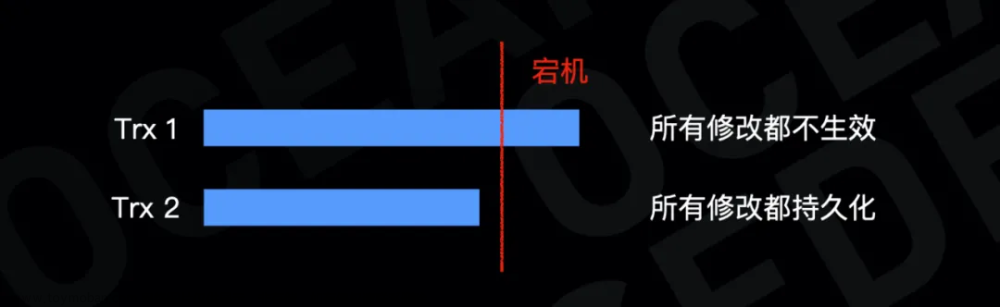

模型的训练。在LDA模型中,通常使用Gibbs采样或变分推断等方法进行参数估计和主题建模。在进行训练时,需要对模型的参数进行初始化,并通过迭代更新参数,直到模型收敛为止。同时,需要对模型进行调优,以提高模型的效果和可解释性。

-

模型的评估。LDA模型的评估可以从多个方面进行,例如主题连贯性、主题区分度、主题覆盖度等指标。同时,也可以通过实验进行主题分析、主题分类、主题推断等任务的评估。在评估LDA模型时,需要根据应用场景选择相应的评估指标和实验方法。

2. LDA模型的相关学习资料

LDA模型的相关学习资料比较丰富,下面列举几个常用的教材和论文:

- 《Latent Dirichlet Allocation》:LDA模型的原始论文,由Blei等人在2003年发表于Journal of Machine Learning Research。

- 《Probabilistic Topic Models》:一本关于主题模型的教材,作者为Blei,包括LDA模型在内的多个主题模型。

- 《文本挖掘与信息检索》:一本介绍文本挖掘和信息检索的教材,其中涉及LDA模型的原理和应用。

3. LDA模型应用场景

LDA模型在文本挖掘、社交网络分析、推荐系统等领域得到了广泛的应用,尤其在文本挖掘领域具有重要的作用。下面列举几个常见的应用场景:

- 文本主题分析:通过LDA模型可以自动发现文本数据中隐藏的主题结构,可以应用于文本分类、文本聚类、文本推荐等任务。

- 社交网络分析:通过LDA模型可以挖掘社交网络中用户的兴趣和话题,可以应用于社交网络推荐、舆情分析等任务。

- 推荐系统:通过LDA模型可以挖掘用户的兴趣和话题,可以应用于个性化推荐、商品推荐等任务。

除了在应用领域的广泛应用之外,LDA模型本身的研究也在不断进展。近年来,研究者们通过改进LDA模型的参数估计方法、引入外部知识等手段,提高了LDA模型的效果和可解释性。同时,研究者们也将LDA模型与其他机器学习算法、深度学习方法等进行结合,探索更加复杂的文本表示和主题建模方法。

4. LDA模型案例展示

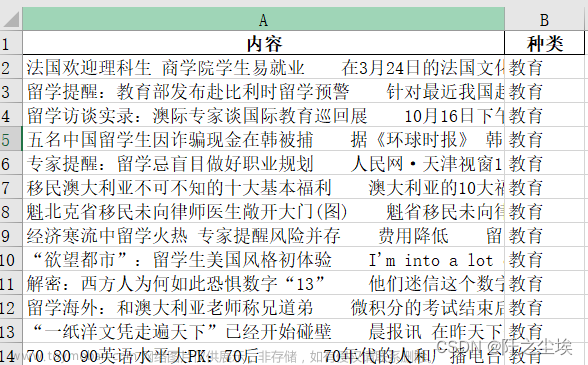

下面通过Python代码实现LDA模型,并结合一个新闻文本数据集进行实验。

首先,我们需要导入相关的库和数据集:

import numpy as np

import pandas as pd

import jieba

from gensim import corpora, models

# 导入新闻数据集

news_df = pd.read_csv('news.csv')

news_content = news_df['content']

接着,我们需要对文本进行预处理,包括分词、去停用词、去数字等:

# 定义停用词和标点符号

stopwords = [line.strip() for line in open('stopwords.txt', encoding='utf-8').readlines()]

punctuations = [',', '。', '!', '?', '、', ';', ':', '“', '”', '(', ')', '【', '】', '—', '…']

# 对新闻文本进行分词、去停用词、去数字和标点符号

news_words = []

for content in news_content:

content = str(content)

words = jieba.cut(content)

words = [word for word in words if word not in stopwords and word not in punctuations and not word.isdigit()]

news_words.append(words)

接下来,我们需要将文本转换为词袋模型,并通过LDA模型进行主题建模:

# 构建词袋模型

dictionary = corpora.Dictionary(news_words)

corpus = [dictionary.doc2bow(words) for words in news_words]

# 运行LDA模型

lda = models.ldamodel.LdaModel(corpus=corpus, id2word=dictionary, num_topics=10)

最后,我们可以输出每个主题的前10个关键词,并对每篇新闻文本进行主题推断:文章来源:https://www.toymoban.com/news/detail-430368.html

# 输出每个主题的前10个关键词

for topic in lda.print_topics(num_topics=10, num_words=10):

print(topic)

# 对每篇新闻文本进行主题推断

for i, doc in enumerate(corpus):

topic = sorted(lda[doc], key=lambda x: x[1], reverse=True)[0][0]

print('文本编号:{},主题编号:{}'.format(i, topic))

通过以上代码,我们可以得到每个主题的前10个关键词,并对每篇新闻文本进行主题推断。文章来源地址https://www.toymoban.com/news/detail-430368.html

到了这里,关于从文本中“看”出主题分布:LDA模型原理、应用和实践的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!