前言:

🏘️🏘️个人简介:以山河作礼。

🎖️🎖️:Python领域新星创作者,CSDN实力新星认证

📝📝第一篇文章《1.认识网络爬虫》获得全站热榜第一,python领域热榜第一。

🧾 🧾第四篇文章《4.网络爬虫—Post请求(实战演示)》全站热榜第八。

🧾 🧾第八篇文章《8.网络爬虫—正则表达式RE实战》全站热榜第十二。

🧾 🧾第十篇文章《10.网络爬虫—MongoDB详讲与实战》全站热榜第八领域热榜第二

🧾 🧾第十三篇文章《13.网络爬虫—多进程详讲(实战演示)》全站热榜第十二。

🧾 🧾第十四篇文章《14.网络爬虫—selenium详讲》测试领域热榜第二十。

🧾 🧾第十六篇文章《16.网络爬虫—字体反爬(实战演示)》全站热榜第二十五。

🧾 🧾第十九篇文章《19.网络爬虫—照片管道》全站综合热榜第十二。

🎁🎁《Python网络爬虫》专栏累计发表二十篇文章,上榜八篇。欢迎免费订阅!欢迎大家一起学习,一起成长!!

💕💕悲索之人烈焰加身,堕落者不可饶恕。永恒燃烧的羽翼,带我脱离凡间的沉沦。

🎁🎁:文章末尾扫描二维码可以加入粉丝交流群。

Redis的安装与使用

下载地址:

https://github.com/tporadowski/redis/releases

🧾 🧾Redis 支持 32 位和 64 位。这个需要根据你系统平台的实际情况选择,这里我们下载 Redis-x64-xxx.zip压缩包到 D 盘,解压后,将文件夹重新命名为 redis。

打开一个 cmd 窗口 使用 cd 命令切换目录到 C:\redis 运行:

redis-server.exe redis.windows.conf

🧾 🧾如果想方便的话,可以把 redis 的路径加到系统的环境变量里,这样就省得再输路径了,后面的那个 redis.windows.conf 可以省略,如果省略,会启用默认的。输入之后,会显示如下界面:

分布式概念和作用

分布式:一个业务分拆多个子业务,部署在不同的服务器上; 是一种将任务分布在不同地方的工作方式。

作用:提高安全性和效率

分布式爬虫

🧾 🧾分布式爬虫是一种利用多个计算机节点协作进行网页数据抓取的技术。传统的爬虫一般是单机或者集群爬虫,而分布式爬虫将爬虫任务分配到多个节点上进行并行处理,从而提高爬取效率和速度。

🧾 默认情况下,我们使用scrapy框架进行爬虫时使用的是单机爬虫,就是说它只能在一台电脑上运行,因为爬虫调度器当中的队列queue去重和set集合都只能在本机上创建的,其他电脑无法访问另外一台电脑上的内存和内容。

分布式爬虫实现了多台电脑使用一个共同的爬虫程序,它可以同时将爬虫任务部署到多台电脑上运行,这样可以提高爬虫速度,实现分布式爬虫。

分布式爬虫特点

🧾 🧾分布式爬虫一般具有以下特点:

-

分布式协作:通过分布式协作技术,将爬虫任务拆分成多个小任务,分配到不同的节点上进行处理,从而提高爬取效率和速度。

-

网络通信:多个节点之间需要进行网络通信,以确保任务的协调和数据的传输。

-

数据一致性:由于分布式爬虫是在多个节点上进行的,因此需要考虑如何确保爬取的数据一致性。

-

难度复杂:分布式爬虫需要涉及到分布式架构、负载均衡、任务调度等技术,需要具备一定的技术水平和经验。

🧾 🧾分布式爬虫的优点主要有以下几点:

-

更快的爬取速度:分布式爬虫可以利用多个节点并行处理任务,从而提高爬取效率和速度。

-

更好的可扩展性:分布式爬虫可以通过增加节点数量来扩展系统的容量和性能,具有更好的可扩展性。

-

更好的稳定性:由于分布式爬虫具有节点冗余机制,系统的稳定性更高,即使某些节点发生故障,也不会影响整个系统的运行。

-

更好的数据一致性:分布式爬虫可以通过数据一致性机制来确保爬取的数据准确、完整、一致。

-

更好的资源利用率:分布式爬虫可以利用多个节点的计算能力和存储能力,更好地利用系统资源,降低成本。

当然,分布式爬虫也存在一些挑战和限制,比如节点之间的通信和协作问题,节点故障造成的影响,数据一致性问题等,需要通过技术手段来解决。

redis的使用

🎯修改redis.windows.conf

bind 127.0.0.1 -> bind 0.0.0.0

🎯关闭安全模式,可以远程访问redis

把protected-mode yes改为protected-mode no

Redis 操作/启动

启动服务器

redis-server.exe

启动数据库

启动文件redis-cli.exe

# 伪分布式

bind 127.0.0.1

启动分布式

lpush key:value url

注意:使用时,记得提前在redis中添加。例如:

lpush db:start_urls https://movie.douban.com/top250

Redis Desktop Manager下载

🧾 🧾这是一个redis的桌面工具,可以图形化界面操作redis数据库

1,redis需要打开

2,是否已经创建链接,如果已经创建,双击数据库进行链接

3,如果没有就点击下面的connect to redis server ,输入数据库名称例如root,输入host,如127.0.0.1

特点和架构

🧾 🧾scrapy_redis是一个基于Redis的Scrapy组件,用于scrapy项目的分布式部署和开发。

🎯特点:分布式爬取

可以启动多个spider对象,互相之间共享有一个redis的request队列。最适合多个域名的广泛内容的爬取。

🎯分布式数据处理:

爬取到的item数据被推送到redis中,这意味着你可以启动尽可能多的item处理程序。

安装和使用

- 一般通过pip安装Scrapy-redis:

pip install scrapy-redis # 下载模块

- scrapy-redis的使用非常简单,几乎可以并不改变原本scrapy项目的代码,只用做少量设置

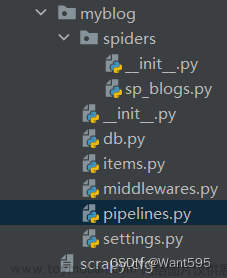

Scrapy-redis 代码部署

spider文件

🧾 类继承 RedisSpider (原来是继承scrapy.Spider)

from scrapy_redis.spiders import RedisSpider # 让爬虫继承新的爬虫模块

🧾 注释strat_urls 设置 redis_key = “db:start_urls” 开启爬虫钥匙

settings文件

# 使用scrapy_redis组件自己的调度器 必须

SCHEDULER = "scrapy_redis.scheduler.Scheduler"

# 确保所有spider通过redis共享相同的重复过滤。 必须

DUPEFILTER_CLASS = "scrapy_redis.dupefilter.RFPDupeFilter"

# 可选 不清理redis队列,允许暂停/恢复抓取。 允许暂定,redis数据不丢失

SCHEDULER_PERSIST = True

# REDIS 主机和端口 必须

REDIS_HOST = '127.0.0.1' # 写自己电脑的ip地址

REDIS_PORT = 6379

#公共管道

#如果你希望数据后期统一处理,则可以增加’scrapy_redis.pipelines.RedisPipeline’: 300

#ITEM_PIPELINES = {

# 'scrapy_redis.pipelines.RedisPipeline':300, #为了写的redis

#}

👉👉本专栏所有文章是博主学习笔记,仅供学习使用,爬虫只是一种技术,希望学习过的人能正确使用它。

博主也会定时一周三更爬虫相关技术更大家系统学习,如有问题,可以私信我,没有回,那我可能在上课或者睡觉,写作不易,感谢大家的支持!!🌹🌹🌹文章来源:https://www.toymoban.com/news/detail-430743.html

文章来源地址https://www.toymoban.com/news/detail-430743.html

到了这里,关于20.网络爬虫—Scrapy-Redis分布式爬虫的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[爬虫]3.2.2 分布式爬虫的架构](https://imgs.yssmx.com/Uploads/2024/02/597077-1.jpg)