1.实验内容:

- 根据qq音乐获取的信息,对某一首歌曲的评论内容进行处理。

- 分析评论中的词性分布。

- 统计高频词,画出词云。

2.实验步骤:

1. 文本信息初处理:

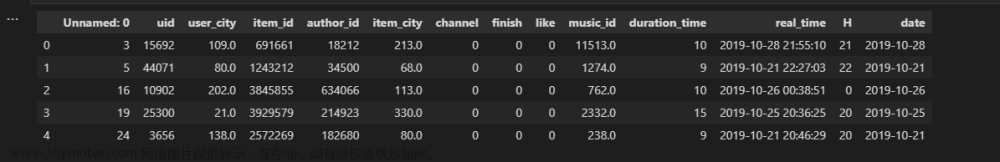

根据实验二QQ音乐抓取周杰伦的前五首歌曲评论等信息筛查晴天这首歌的相关信息存为“晴天-周杰伦”的文本文件方便后续数据读取。

文本信息节选展示:

2. 编写词云绘制,词频统计以及词性分析代码:

首先打开文件进行读取信息,去掉长度为一的词存下来并统计频率最高的三十个词打印输出词和词出现的次数。获取信息进行文本切割以后进行词云的相关绘制。进行词性分析,统计评论中词的词性并打印输出各类词性的数量。

词频统计节选展示:

词性分析节选展示:

词云如图:

词云背景图:

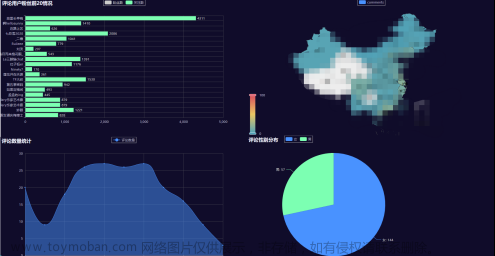

3. 编写词性分析数据可视化代码:

利用2步骤中的切割好的信息绘制条形图,设置纵轴横轴名称和数据获取绘制以及大小等。

运行展示:

条状图如下:

3.实验总结:

本次实验进行实验二信息的数据分析和可视化操作,在实操中学会了很多,特别是在词云绘制和词性条状图绘制中学会了很多绘制技巧的基本内容,实验难点是在做文本信息切割存储的时候需要考虑词的长度以及各类非汉字字符的去除等需要特别注意。总之本次实验学习和实践了评论的数据分析词性分析等可视化的绘制词云绘制词性条状图的内容,加深了对数据分析可视化的理解,难点痛点还需要多加理解和实践。

4.实验源码:

源码一:(进行词频统计和词性分析以及词云的绘制)文章来源:https://www.toymoban.com/news/detail-433477.html

#词云绘制及词性、词频统计分析

import jieba,wordcloud,re

import jieba.posseg as pseg

import imageio

#统计出现频率最高的前三十个词并输出

txt = open("晴天-周杰伦","r",encoding="utf-8").read()

words = jieba.lcut(txt)

counts = {}

#去掉长度为1的词

for word in words:

if len(word) == 1:

continue

else:

counts[word] = counts.get(word,0) + 1

items = list(counts.items())

items.sort(key = lambda x:x[1],reverse=True)

print("统计高频词汇如下:")

print("词语 出现次数\n")

for i in range(30):

word,count = items[i]

print("{0:<10}{1:>5}".format(word,count))

#'''除去文本中的非汉字字符

# for ch in r'●━━━━━━───────⇆◁❚❚☞▷↻「」~🦠\

# 🦘1234567890”`~!@#$%^&*()-_=+[]{}\\|;\

# :\'\",./<>?·~!@#¥%……&*()——+-=【】{}、|;:\‘\“,。《》?qwertyuiop\

# asdfghjklzxcvbnmQAZXSWEDCVFRTGBNHYUJMKIOLP年月日':'''

#定义去除掉文本中的非汉字字符的函数

def find_chinese(file):

pattern = re.compile(r'[^\u4e00-\u9fa5]')

chinese = re.sub(pattern,'', file)

return chinese

#获取文件文本

def getText():

txt = open("晴天-周杰伦","r",encoding="utf-8").read()

txt = find_chinese(txt)

return txt

#获取文本信息并进行切割

txt = getText()

txt = jieba.lcut(txt)

#创建列表存入长度大于1的词语

words = []

for word in txt:

if len(word) == 1:

continue

else:

words.append(word)

txt = words

color_mask =imageio.v2.imread("b.jpg")#词云背景图

txt = " ".join(txt)

w = wordcloud.WordCloud(width = 390, height = 390,\

background_color = "black",\

font_path = "msyh.ttc",\

contour_color= "green",\

contour_width= 2,\

mask=color_mask,\

mode="RGB")

w.generate(txt)

w.to_file("词云.png")

txt = open("晴天-周杰伦","r",encoding="utf-8").read()

words = pseg.lcut(txt)

counts = {}

for word in words:

counts[word.flag] = counts.get(word.flag,0) + 1

items = list(counts.items())

items.sort(key = lambda x:x[1],reverse=True)

print("经过统计和分析文件,\n其中的评论含有的词种类以及数量如下所示:")

print("词性 数量\n")

for i in range(len(counts)):

flag,count = items[i]

print("{0:<10}{1:>5}".format(flag,count))

源码2:词性分析可视化 文章来源地址https://www.toymoban.com/news/detail-433477.html

import jieba.posseg as pseg

import matplotlib.pyplot as plt

from collections import Counter

txt = open("晴天-周杰伦","r",encoding="utf-8").read()

words = pseg.lcut(txt)

word_list=[]

flag_list=[]

for word,flag in words:

if(word!=' ')and(flag!='x'):

word_list.append(word)

flag_list.append(flag)

print(word_list)

print(flag_list)

word_dict = Counter(flag_list)

print(word_dict)

# 画条状图

key_list = list(word_dict.keys())

value_list = list(word_dict.values())

plt.figure(figsize=(25, 30), dpi=100) # 设置大小

plt.barh(key_list, value_list) # 画图

plt.rcParams["font.sans-serif"] = ["SimHei"] # 设置中文字体

plt.xlabel("数量")

plt.ylabel("词性英文简称")

plt.title("评论词频统计")

plt.xticks([i for i in range(0, 301, 25)])

plt.savefig("词性分析.png") # 保存文件

plt.show() # 画图'''到了这里,关于Python文本数据及其可视化的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!