0. 数据源

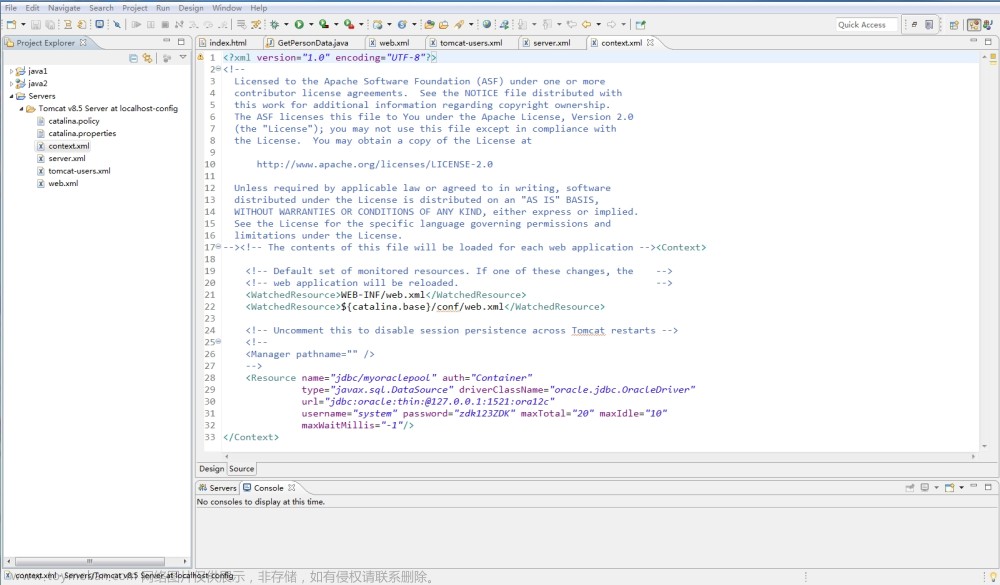

student.sql文件。

/*

Navicat Premium Data Transfer

Source Server : localhost_3306

Source Server Type : MySQL

Source Server Version : 80016

Source Host : localhost:3306

Source Schema : testdb

Target Server Type : MySQL

Target Server Version : 80016

File Encoding : 65001

Date: 02/05/2023 20:52:22

*/

SET NAMES utf8mb4;

SET FOREIGN_KEY_CHECKS = 0;

-- ----------------------------

-- Table structure for student

-- ----------------------------

DROP TABLE IF EXISTS `student`;

CREATE TABLE `student` (

`num` int(11) NOT NULL COMMENT '学号',

`name` varchar(10) CHARACTER SET utf8mb4 COLLATE utf8mb4_0900_ai_ci NOT NULL DEFAULT 'zhang' COMMENT '姓名',

`score` float NULL DEFAULT NULL,

PRIMARY KEY (`num`) USING BTREE

) ENGINE = MyISAM AUTO_INCREMENT = 109 CHARACTER SET = utf8mb4 COLLATE = utf8mb4_0900_ai_ci ROW_FORMAT = Dynamic;

-- ----------------------------

-- Records of student

-- ----------------------------

INSERT INTO `student` VALUES (101, 'zhang', 98);

INSERT INTO `student` VALUES (102, 'han', 69);

INSERT INTO `student` VALUES (103, 'hui', 72);

INSERT INTO `student` VALUES (104, 'fang', 100);

INSERT INTO `student` VALUES (105, 'li', 88);

INSERT INTO `student` VALUES (106, 'cheng', NULL);

SET FOREIGN_KEY_CHECKS = 1;

mysql> select * from student;

+-----+-------+-------+

| num | name | score |

+-----+-------+-------+

| 101 | zhang | 98 |

| 102 | han | 69 |

| 103 | hui | 72 |

| 104 | fang | 100 |

| 105 | li | 88 |

| 106 | cheng | NULL |

+-----+-------+-------+

6 rows in set (0.00 sec)

1. 作用

MySQL提供一些查询功能,可以对获取的数据进行分析和报告。这些函数的功能有:计算数据表中记录行数的总数、计算某个字段列下的数据的总和,以及计算表中某个字段下的最大值、最小值或者平均值。

或者可以这么理解:它主要是将一列数据作为一个整体,然后进行纵向计算。

| 函数 | 作用 |

|---|---|

| AVG() | 返回某列的平均值 |

| COUNT() | 返回某列的行数 |

| MAX() | 返回某列的最大值 |

| MIN() | 返回某列的最小值 |

| SUM() | 返回某列的和 |

1.1 COUNT()

CONUT()函数统计数据表中包含的记录行的总数,或者根据查询结果返回列中包含的数据行数。

mysql> select * from student;

+-----+-------+-------+

| num | name | score |

+-----+-------+-------+

| 101 | zhang | 98 |

| 102 | han | 69 |

| 103 | hui | 72 |

| 104 | fang | 100 |

| 105 | li | 88 |

| 106 | cheng | NULL |

+-----+-------+-------+

6 rows in set (0.00 sec)

mysql> select COUNT(*) from student;

+----------+

| COUNT(*) |

+----------+

| 6 |

+----------+

1 row in set (0.00 sec)

mysql> select COUNT(name) from student;

+-------------+

| COUNT(name) |

+-------------+

| 6 |

+-------------+

1 row in set (0.00 sec)

mysql> select COUNT(score) from student;

+--------------+

| COUNT(score) |

+--------------+

| 5 |

+--------------+

1 row in set (0.00 sec)

根据以上测试结果可以看出:COUNT(*)是计算表中的所有的行数,不管某列有数值或者为空值。

而COUNT(字段名)则是计算指定列下的总的行数,计算时将会忽略空值的行。

1.2 SUM()

返回指定列的值的总和。

同样,SUM()函数在计算时,忽略列值为NULL的行。

mysql> select * from student;

+-----+-------+-------+

| num | name | score |

+-----+-------+-------+

| 101 | zhang | 98 |

| 102 | han | 69 |

| 103 | hui | 72 |

| 104 | fang | 100 |

| 105 | li | 88 |

| 106 | cheng | NULL |

+-----+-------+-------+

6 rows in set (0.00 sec)

mysql> select SUM(score) AS total from student;

+-------+

| total |

+-------+

| 427 |

+-------+

1 row in set (0.37 sec)

# demo

# 统计处num>=103 && num<=106的所有学生的成绩之和;

# 分析, 首先获取满足条件的所有学生集合:select * from student where num between 103 and 106;

# 接着, 再对返回的列当中的score字段进行聚合查询, 即 select SUM(score) from student where num between 103 and 106;

# 这样, 便求出满足条件的所有学生的成绩之和了。

mysql> select * from student where num between 103 and 106;

+-----+-------+-------+

| num | name | score |

+-----+-------+-------+

| 103 | hui | 72 |

| 104 | fang | 100 |

| 105 | li | 88 |

| 106 | cheng | NULL |

+-----+-------+-------+

4 rows in set (0.00 sec)

mysql> select SUM(score) from student where num between 103 and 106;

+------------+

| SUM(score) |

+------------+

| 260 |

+------------+

1 row in set (0.00 sec)

1.3 AVG()

返回指定列的值的总和的平均值。

同样,SUM()函数在计算时,忽略列值为NULL的行。

mysql> select AVG(score) AS average from student;

+---------+

| average |

+---------+

| 85.4 |

+---------+

1 row in set (0.00 sec)

如上所示,根据测试结果(总和/个数),其中的个数为5个,AVG()会启动忽略列值为NULL的行。

1.4 MAX()

返回指定列中的最大值。

同样,MAX()函数在计算时,忽略列值为NULL的行。文章来源:https://www.toymoban.com/news/detail-435291.html

mysql> select MAX(score) AS maximum from student;

+---------+

| maximum |

+---------+

| 100 |

+---------+

1 row in set (0.04 sec)

1.5 MIN()

返回指定列中的最小值。

同样,MIN()函数在计算时,忽略列值为NULL的行。文章来源地址https://www.toymoban.com/news/detail-435291.html

mysql> select MIN(score) AS minimum from student;

+---------+

| minimum |

+---------+

| 69 |

+---------+

1 row in set (0.00 sec)

到了这里,关于MySQL查询之聚合函数查询的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!