提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

前言

提示:这里可以添加本文要记录的大概内容:

下面是一个关于自适应粒子群优化(Adaptive Particle Swarm Optimization,APSO)的博客,希望可以帮助您。

提示:以下是本篇文章正文内容,下面案例可供参考

一、自适应粒子群优化

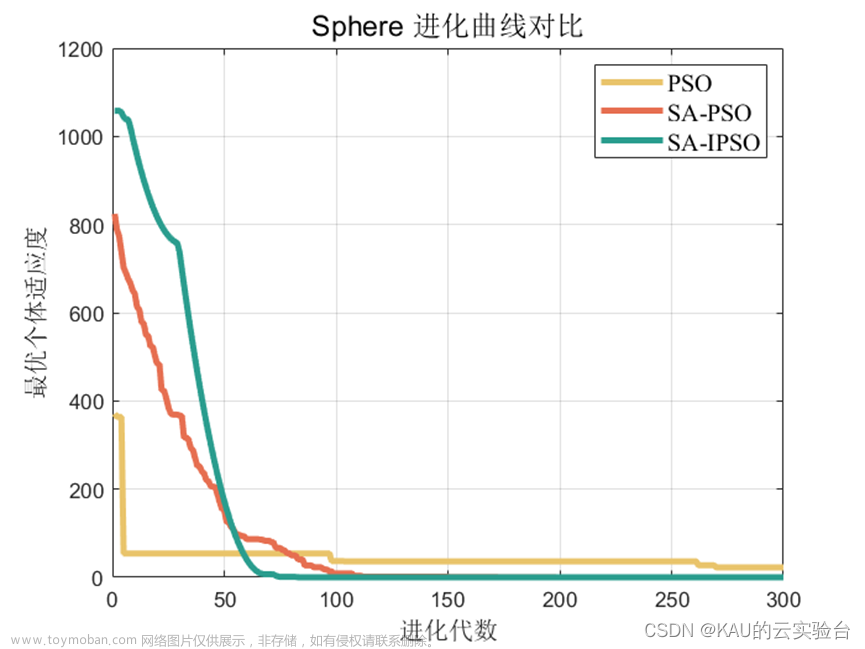

自适应粒子群优化是一种优化算法,它是粒子群优化(Particle Swarm Optimization,PSO)的一种变体。与传统的PSO不同,APSO使用自适应策略来调整算法的参数,以提高算法的性能和收敛速度。

APSO的主要思想是根据群体的收敛情况动态调整算法的参数。APSO的核心算法与PSO类似,由粒子的速度和位置更新规则组成。每个粒子通过与局部最优解和全局最优解比较来更新自己的位置和速度。在APSO中,速度和位置的更新公式如下:

v i , j t + 1 = ω t v i , j t + ϕ p u p , j t ( x p , j t − x i , j t ) + ϕ g u g , j t ( x g , j t − x i , j t ) v_{i,j}^{t+1} = \omega^{t} v_{i,j}^{t} + \phi_{p} u_{p,j}^{t} (x_{p,j}^{t} - x_{i,j}^{t}) + \phi_{g} u_{g,j}^{t} (x_{g,j}^{t} - x_{i,j}^{t}) vi,jt+1=ωtvi,jt+ϕpup,jt(xp,jt−xi,jt)+ϕgug,jt(xg,jt−xi,jt)

x i , j t + 1 = x i , j t + v i , j t + 1 x_{i,j}^{t+1} = x_{i,j}^{t} + v_{i,j}^{t+1} xi,jt+1=xi,jt+vi,jt+1

其中,

v

i

,

j

t

v_{i,j}^{t}

vi,jt是第

i

i

i个粒子在第

t

t

t代的第

j

j

j个维度上的速度,

x

i

,

j

t

x_{i,j}^{t}

xi,jt是第

i

i

i个粒子在第

t

t

t代的第

j

j

j个维度上的位置,

u

p

,

j

t

u_{p,j}^{t}

up,jt和

u

g

,

j

t

u_{g,j}^{t}

ug,jt是两个随机数,

ω

t

\omega^{t}

ωt是惯性权重,

ϕ

p

\phi_{p}

ϕp和

ϕ

g

\phi_{g}

ϕg是学习因子。

x

p

,

j

t

x_{p,j}^{t}

xp,jt和

x

g

,

j

t

x_{g,j}^{t}

xg,jt分别表示第

i

i

i个粒子在第

t

t

t代的最优解和全局最优解的第

j

j

j个维度上的位置。

与传统的PSO不同,APSO的惯性权重是根据迭代次数

t

t

t动态调整的:

ω t = ω m a x − ( ω m a x − ω m i n ) × t T \omega^{t} = \omega_{max} - \frac{(\omega_{max} - \omega_{min}) \times t}{T} ωt=ωmax−T(ωmax−ωmin)×t

其中, ω m a x \omega_{max} ωmax和 ω m i n \omega_{min} ωmin分别是惯性权重的上下限, T T T是最大迭代次数。当迭代次数 t t t接近 T T T时,惯性权重逐渐减小,以便更好地收敛到最优解。

APSO的另一个关键之处是学习因子的自适应调整。在每个迭代中,APSO会计算每个粒子的适应度值。如果适应度值的方差较小,则学习因子的值会变小,以便更加收敛到最优解。相反,如果适应度值的方差较大,则学习因子的值会变大,以便更好地探索解空间。

二、使用步骤

代码

代码如下(示例):

import random

import math

class Particle:

def __init__(self, dim, minx, maxx):

self.position = [random.uniform(minx, maxx) for i in range(dim)]

self.velocity = [0.0 for i in range(dim)]

self.pbest = list(self.position)

self.pbestfit = float('inf')

def update_velocity(self, gbest, omega, phip, phig):

for i in range(len(self.velocity)):

rp = random.uniform(0, 1)

rg = random.uniform(0, 1)

cognitive = phip * rp * (self.pbest[i] - self.position[i])

social = phig * rg * (gbest[i] - self.position[i])

self.velocity[i] = omega * self.velocity[i] + cognitive + social

def update_position(self, bounds):

for i in range(len(self.position)):

self.position[i] += self.velocity[i]

if self.position[i] < bounds[i][0]:

self.position[i] = bounds[i][0]

self.velocity[i] *= -1

elif self.position[i] > bounds[i][1]:

self.position[i] = bounds[i][1]

self.velocity[i] *= -1

class APSO:

def __init__(self, costfunc, dim, size, minx, maxx, maxiter):

self.costfunc = costfunc

self.dim = dim

self.size = size

self.minx = minx

self.maxx = maxx

self.maxiter = maxiter

self.swarm = [Particle(dim, minx, maxx) for i in range(size)]

self.gbest = list(self.swarm[0].position)

self.gbestfit = self.swarm[0].fitness

self.c1 = 1.49618

self.c2 = 1.49618

self.wmax = 0.9

self.wmin = 0.4

self.vmax = 6.0

self.vmin = -6.0

def evolve(self):

for i in range(self.maxiter):

for j in range(self.size):

self.swarm[j].update_velocity(self.gbest, self.calculate_inertia_weight(i), self.c1, self.c2)

self.swarm[j].update_position([(self.minx, self.maxx)] * self.dim)

self.swarm[j].evaluate(self.costfunc)

if self.swarm[j].fitness < self.gbestfit:

self.gbest = list(self.swarm[j].position)

self.gbestfit = self.swarm[j].fitness

self.maxiter

def sphere(x):

return sum([xi ** 2 for xi in x])

if __name__ == '__main__':

apso = APS

总结

在上面的代码中,n_particles表示粒子的数量,n_dimensions表示解空间的维度,max_iterations表示迭代次数,objective_function表示优化的目标函数。

在__init__方法中,我们初始化了粒子群的位置和速度,并将每个粒子的位置作为其最优解,将其适应度值初始化为正无穷。我们还初始化了学习因子和惯性权重的参数。

在run方法中,我们迭代了max_iterations次,计算每个粒子的适应度值和最优解。然后,我们根据适应度值的方差来调整学习因子的值。最后,我们更新每个粒子的速度和位置,直到达到最大迭代次数。

在get_global_best_position和get_global_best_value方法中,我们返回全局最优解的位置和适应度值。

当我们使用APSO优化一个目标函数时,我们可以创建一个APSO对象并传入目标函数的定义。然后,我们可以调用run方法来运行优化算法,最后调用get_global_best_position和get_global_best_value方法来获取最优解的位置和适应度值。文章来源:https://www.toymoban.com/news/detail-435655.html

完整代码https://download.csdn.net/download/weixin_52026057/87492019文章来源地址https://www.toymoban.com/news/detail-435655.html

到了这里,关于自适应粒子群优化(Adaptive Particle Swarm Optimization,APSO的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!