爬虫是一种自动获取网页内容的程序,它可以帮助我们从网络上快速收集大量信息。在本文中,我们将学习如何使用 Python 编写一个简单的爬虫框架。

一、请求网页

首先,我们需要请求网页内容。我们可以使用 Python 的 requests 库来发送 HTTP 请求。在使用之前,请确保已安装该库:

pip install requests

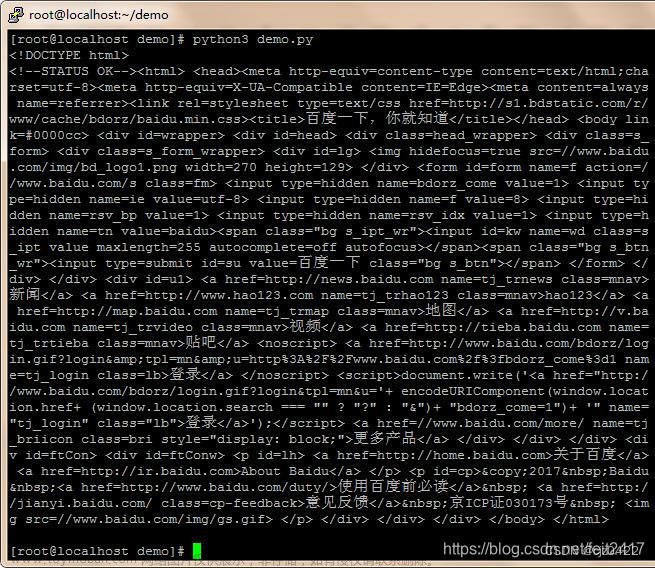

然后,我们可以使用以下代码请求网页内容:

import requests

url = “https://example.com”

response = requests.get(url)

if response.status_code == 200:

print(response.text)

else:

print(“请求失败”)

二、解析 HTML

接下来,我们需要解析 HTML 以提取所需的数据。BeautifulSoup 是一个非常流行的 HTML 解析库,我们可以使用它来简化解析过程。首先安装库:

pip install beautifulsoup4

然后,我们可以使用以下代码解析 HTML:

from bs4 import BeautifulSoup

html = response.text

soup = BeautifulSoup(html, ‘html.parser’)

提取网页标题

title = soup.title.string

print(“网页标题:”, title)

三、构建爬虫框架

现在我们已经掌握了请求网页和解析 HTML 的基本知识,我们可以开始构建爬虫框架。首先,我们需要定义一个函数来处理每个网页:

def process_page(url):

# 请求网页

response = requests.get(url)

if response.status_code == 200:

# 解析 HTML

soup = BeautifulSoup(response.text, 'html.parser')

# 处理网页数据

process_data(soup)

else:

print("请求失败")

接下来,我们需要编写 process_data 函数来处理网页数据:

def process_data(soup):

# 提取并处理所需数据

pass

最后,我们可以使用以下代码开始爬虫:

start_url = “https://example.com”

process_page(start_url)

至此,我们已经构建了一个简单的爬虫框架。您可以根据需要扩展 process_data 函数以处理特定的网页数据。此外,您还可以考虑使用多线程、代理服务器等技术来提高爬虫的性能和效率。文章来源:https://www.toymoban.com/news/detail-436804.html

python文章来源地址https://www.toymoban.com/news/detail-436804.html

到了这里,关于使用 Python 实现简单的爬虫框架的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!