大家好,我是带我去滑雪!

本期使用爬取到的有关房价数据集data.csv,使用支持向量回归(SVR)方法预测房价。该数据集中“y1”为响应变量,为房屋总价,而x1-x9为特征变量,依次表示房屋的卧室数量、客厅数量、面积、装修情况、有无电梯、、房屋所在楼层位置、有无地铁、关注度、看房次数共计9项。

(ps,往期出过一个利用SVR预测房价,但代码没有分开讲,许多童鞋复制代码运行,总会出现各种问题,所以应童鞋要求,出一篇更为仔细的博客,大部分博主讲解SVR都采用python自带波士顿房价数据集,但很多童鞋大多都需要用到自己的数据集进行SVR建模,我想这也许对部分童鞋有一定帮助)

(1)导入所需模块

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

from sklearn import preprocessing

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import KFold,StratifiedKFold

from sklearn.model_selection import GridSearchCV

from sklearn.svm import LinearSVR

from sklearn.svm import SVR

from sklearn.ensemble import RandomForestRegressor

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error

from sklearn.metrics import mean_absolute_error

from sklearn.metrics import r2_score

get_ipython().run_line_magic('matplotlib', 'inline')

plt.rcParams['font.sans-serif'] = ['SimHei']

plt.rcParams['axes.unicode_minus'] = False

from IPython.core.interactiveshell import InteractiveShell

InteractiveShell.ast_node_interactivity = 'all'

import warnings

如果是第一次运行上述模块,报错 ModuleNotFoundError:Nomodulenamed'xxx'情况,需安装相应xxx名称的库,若使用jupyter notebook可以使用pip install xxx,若使用pycharm可以在设置里的packages里安装对应的包或者在控制台里使用pip install xxx。若都不行,可以上网浏览一下其他方法。

(2)导入数据集

data=pd.read_csv('data.csv')

data输出结果:

x1 x2 x3 x4 x5 x6 x7 x8 x9 y1 0 2 2 78.60 0 1 2 1 58 14 210.0 1 4 2 98.00 0 1 0 1 2337 18 433.0 2 2 1 58.10 2 1 1 1 25 18 255.0 3 4 2 118.00 3 0 1 0 2106 6 195.0 4 3 1 97.70 2 0 2 0 1533 7 150.0 ... ... ... ... ... ... ... ... ... ... ... 2979 3 2 132.51 0 1 1 0 28 5 375.0 2980 2 1 80.30 2 1 1 1 8 0 375.0 2981 2 2 64.81 2 1 1 1 2 0 268.0 2982 2 1 57.26 0 0 0 1 0 0 235.0 2983 2 1 75.38 2 1 2 0 0 0 300.0 2984 rows × 10 columns

本文采用 “pd.read_csv” 导入数据,也可以采用 ”pd.read_excel“ 。使用pd.read_csv('data.csv')表示在工作路径直接读取data.csv文件,所以需要提前将数据集放入工作路径中。若不好找工作路径,也可以使用data = pd.read_csv(r'E:\工作\硕士\博客\博客19-SVR预测房价\data.csv')读取数据,效果是一样的。

data = pd.read_csv(r'E:\工作\硕士\博客\博客19-SVR预测房价\data.csv')

data输出结果:

x1 x2 x3 x4 x5 x6 x7 x8 x9 y1 0 2 2 78.60 0 1 2 1 58 14 210.0 1 4 2 98.00 0 1 0 1 2337 18 433.0 2 2 1 58.10 2 1 1 1 25 18 255.0 3 4 2 118.00 3 0 1 0 2106 6 195.0 4 3 1 97.70 2 0 2 0 1533 7 150.0 ... ... ... ... ... ... ... ... ... ... ... 2979 3 2 132.51 0 1 1 0 28 5 375.0 2980 2 1 80.30 2 1 1 1 8 0 375.0 2981 2 2 64.81 2 1 1 1 2 0 268.0 2982 2 1 57.26 0 0 0 1 0 0 235.0 2983 2 1 75.38 2 1 2 0 0 0 300.0 2984 rows × 10 columns

(3)随机划分70%训练集与30%测试集

y=data.y1#将响应变量y1赋值给y

data_train,data_test,y_train,y_test=train_test_split(data,y,test_size=0.3,random_state=1)

(4)对划分后的训练集和测试集中的特征变量进行数据标准化

由于特征变量的取值范围不尽相同,使用sklearn的StandardScaler类,将训练集和测试集中的所有特征变量进行标准化(即,均值为0,标准差为1)。"values.reshape(-1,1)"是将数据中的所有元素按照一列的形式重新排列,其中,-1 表示自动计算行数,1 表示只有一列。

scaler = StandardScaler()

scaler.fit(data_train)

data_train_s=scaler.fit_transform(data_train)#对训练集中的特征变量进行标准化

data_test_s=scaler.fit_transform(data_test)#对测试集的特征变量进行标准化

(5)进行支持向量回归

使用sklearn的SVR类分别进行径向核(rbf)、二次多项式核(poly,2)、三次多项式核(poly,3)、S型核进行支持向量回归。使用 fit()方法对SVR进行估计,在这里使用默认参数”epsilon=0.1“,即SVR的调节参数为0.1。使用score()方法,计算测试集的拟合优度。

model=SVR(kernel='rbf')#使用径向核(rbf)

model.fit(data_train_s,y_train)#模型估计

model.score(data_test_s,y_test)#计算拟合优度输出结果:

0.28217697180917056model=SVR(kernel='poly',degree=2)#使用二次多项式核

model.fit(data_train_s,y_train)#模型估计

model.score(data_test_s,y_test)#计算拟合优度输出结果:

0.35607964447352425model=SVR(kernel='poly',degree=3)#使用三次多项式核

model.fit(data_train_s,y_train)#模型估计

model.score(data_test_s,y_test)#计算拟合优度输出结果:

0.5944110925400512model=SVR(kernel='sigmoid')#使用S型核

model.fit(data_train_s,y_train)#模型估计

model.score(data_test_s,y_test)#计算拟合优度输出结果:

0.7219197626971094

| 本模型采用不同核的测试集拟合优度表 | ||||

| 径向核 | 二次多项式核 | 三次多项式核 | S型核 | |

| 测试集拟合优度 | 0.2821 | 0.3561 | 0.5944 | 0.7219 |

通过对比,我们发现采用S型核效果最好,测试集的拟合优度达到0.7219,故本文采取S型核。由于截至目前,超参数都是选用,默认的设置,下面选择最优超参数组合,进一步提升模型效果。

(6)使用交叉验证选择最优的超参数组合(C,epsilon,r)

param_grid={'C':[0.01,0.1,1,10,50,100,150],'epsilon':[0.01,0.1,1,10],'gamma':[0.01,0.1,1,10]}#定义参数网格

kfold=KFold(n_splits=10,shuffle=True,random_state=1)#定义10折随机分组

model=GridSearchCV(SVR(),param_grid,cv=kfold)

model.fit(data_train_s,y_train)

model.best_params_输出结果:

{'C': 150, 'epsilon': 10, 'gamma': 0.01}

结果显示,最优参数组合为C=150, epsilon=10, gamma=0.01。

(7)结合最优超参数组合,重新定义model为最优模型,展示支持向量数目

model1=model.best_estimator_#结合最优超参数,重新定义最优model

len(model1.support_)#展示支持向量数目

data_train_s.shape#展示训练集形状输出结果:

270 (2088, 10)model1.score(data_test_s,y_test)#计算测试集拟合优度

输出结果:

0.984653838741239

结果显示,模型采用最优参数组合后,共有270个支持向量,测试集的拟合优度也由原来的0.7219提高到了0.9847。

(8)模型预测

sigmoid_pred=model1.predict(data_test_s)#使用测试集预测房价

sigmoid_pred.shape#展示输出预测值形状输出结果:

(896,)

(9)计算模型预测效果评价指标

model1_rmse = np.sqrt(mean_squared_error(y_test,sigmoid_pred)) #RMSE

model1_mae = mean_absolute_error(y_test,sigmoid_pred) #MAE

model1_r2 = r2_score(y_test, sigmoid_pred) # R2

print("The RMSE of RBF_SVR: ", model1_rmse)

print("The MAE of RBF_SVR: ",model1_mae)

print("R^2 of RBF_SVR: ",model1_r2)输出结果:

The RMSE of RBF_SVR: 28.973562943677987 The MAE of RBF_SVR: 11.142043434442739 R^2 of RBF_SVR: 0.984653838741239

(10)保存预测值与真实值到excel

sigmoid_pred_true=pd.concat([pd.DataFrame(sigmoid_pred),pd.DataFrame(y_test)],axis = 1)#axis=1 表示按照列的方向进行操作,也就是对每一行进行操作。

sigmoid_pred_true.columns=['predictvalues', 'realvalues']

sigmoid_pred_true.to_excel(r'E:\工作\硕士\博客\博客19-SVR预测房价\预测值与真实值.xlsx',index = False)输出结果:

链接:https://pan.baidu.com/s/1p4HDhBH4QNtFLv-1UIoZ9Q?pwd=7qc5

提取码:7qc5

博主保存预测值与真实值时发现 ,真实值在excel里一列里没有连续保存,导致真实值与预测值没有一一对应,所以需要将数据处理一下,选中realvalues列,复制到新表里,然后按住ctrl+G,定位条件选择空白行,点击确定,在选中空白行删除,则将真实值变为连续序列,在复制回去与真实值一一对应。

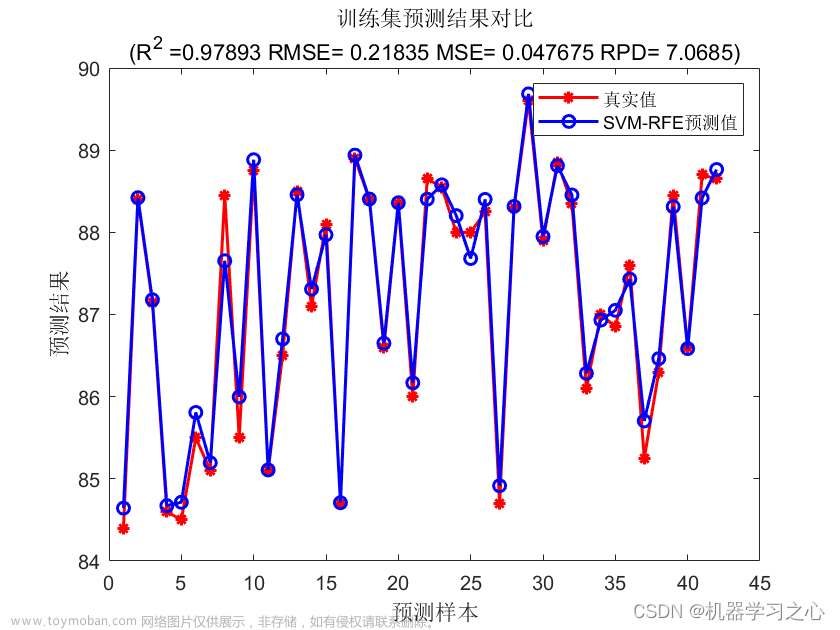

(11)绘制预测值与真实值比较图

data1= pd.read_csv(r'E:\工作\硕士\博客\博客19-SVR预测房价\data1.csv')#导入真实值与预测值数据

plt.subplots(figsize=(10,5))

plt.xlabel('896套房', fontsize =10)

plt.ylabel('房价', fontsize =10)

plt.plot(data1.predictvalues, color = 'b', label = '预测值')

plt.plot(data1.realvalues, color = 'r', label = '真实值')

plt.legend(loc=0)

plt.savefig("squares.png",

bbox_inches ="tight",

pad_inches = 1,

transparent = True,

facecolor ="w",

edgecolor ='w',

dpi=300,

orientation ='landscape')输出结果:

更多优质内容持续发布中,请移步主页查看。

若有问题可邮箱联系:1736732074@qq.com

博主的WeChat:TCB1736732074

点赞+关注,下次不迷路!

文章来源地址https://www.toymoban.com/news/detail-440028.html文章来源:https://www.toymoban.com/news/detail-440028.html

到了这里,关于机器学习之支持向量回归(SVR)预测房价—基于python的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!