快速认识大牛

- 1984年,出生于广东

- 2003年,何恺明凭借全国物理竞赛一等奖被保送进清华大学机械工程及其自动化专业。6月,他选择继续参加高考,获得满分900分的成绩,成为当年广东省9位满分状元之一

- 2003~2007,读于清华大学数理基础科学班,学士毕业

- 2007~2011,香港中文大学,师从AI名人汤晓鸥,博士毕业

- 2011~2016,微软亚洲研究院研究员,MSRA视觉计算组,实习导师为孙剑,从事计算机视觉和深度学习的研究工作

- 2015年的ImageNet图像识别大赛中,何恺明和他的团队凭借152层深度残差网络ResNet-152,击败谷歌、英特尔、高通等业界团队,荣获第一。目前ResNets也已经成为计算机视觉领域的流行架构,同时也被用于机器翻译、语音合成、语音识别和AlphaGo的研发上。

- 2016至今,Facebook FAIR 研究科学家

- 2018年获得CVPR大会PAMI青年研究者奖

- 2022年入选AI 2000人工智能全球最具影响力学者榜单,综合排名第一

少年英才

何恺明是家中独子,父母均在企业里从事管理工作,从小就接触到优良的教学环境。实际上,能从众多学子中脱颖而出,除了教学环境之外,更多的是靠自己的努力。

何恺明年少时就被送到少年宫学习绘画,有时一待就是大半天,这也不断使他练就出沉稳的性格。同绘画一样,他对于文化课的钻研也十分耐得住性子,学习成绩优秀而且稳定。在老师的心目中,他是一个“性格比较内向”但是“目标明确”的学生,“从小就立志上清华”。

高中时,何恺明凭借全国物理竞赛一等奖被保送进清华大学机械工程及其自动化专业。不过,他却依然选择继续参加考试,并凭借着扎实的基本功和轻松的心态一举成为2003年的广东省高考状元。

凭实力进入清华的何恺明,放弃了原本保送的专业,转而选择了更有挑战性的基础科学班。成立于1998年的基础科学班是清华大学设立的一个跨系跨学科的尖子班,本科学生不仅要学习物理系、数学系的大部分基础课程,还要接受一定的科学研究的实际训练。

大学期间,何恺明继续着自己沉稳而优秀的表现,不仅连续3年获得清华奖学金,2007年,还未毕业的他就进入了微软亚洲研究院(MSRA)实习。

本科毕业后,他进入香港中文大学攻读研究生,师从AI名人汤晓鸥。同时继续参与MSRA的工作。2009年,他的第一篇论文“Single ImageHaze RemovalusingDark Channel Prior”被计算机视觉领域顶级会议CVPR接收并被评为年度最佳论文,这是CVPR创办25年来华人学者第一次获此殊荣,也使何恺明在CV领域声名鹊起。

CVPR最佳论文展露头角,去雾算法扬名天下

在MSRA实习时,他并未选择自己擅长的物理和数学工作组,而是根据自己的研究兴趣选择了形象计算组。尽管他曾在大学的时候选修过计算机图形图像的相关课程,但是并非科班出身的他,兴趣也难以支撑工作的需要。

背景知识的缺乏使他在入门的路上举步维艰。回忆起那段时光,何恺明曾表示,自己在阅读文章的时候,常常都不知道哪些是大家都在用的方法,哪些才是作者的贡献。一切对他来说都是新的。

尽管有导师孙剑这样的学术大牛带着他进行课题研究,自身稳定而刻苦的品格也推动着他不断挑战困难,但在换过多次课题后,全部都以失败告终。

虽然结果对何恺明来说是残酷的,但是他也从中学习到了很多,尤其是多个研究课题的经历使他尝试了许多不同的方向,而MSRA轻松自由的研究方向也为他日后的科研奠定了牢固的基础。

虽然是最佳论文,但看它的思路,其实如果认真听过图像处理课并不难理解。它的两个关键步,一是局部找颜色通道的最小值,一是再从局部图像块上找最小值。两个合并起来,称为黑通道先验。为什么要在颜色通道找最小值呢?如果学过彩色图像处理这一章,就知道,饱和度的概念,和这个是一致的。饱和度越高,颜色越鲜明,它渗杂雾的可能性就越小,它被阴影遮住的可能性也越小。所以,认真学好图像处理,你会更好地理解作者提出这一去雾模型的动机。

其中,何恺明花了大量时间研究的image matting问题 (半透明物体边界提取),就为他日后研究的“去雾算法”带来很大帮助。在刚开始研究去雾的时候,何恺明发现雾的方程和matting的方程非常相似,而之前所研究的matting框架可以给去雾带来帮助。利用这个框架,只需要找到一个能局部估算雾的浓度的方法就足够了。

他在2009年获“CVPR最佳论文奖”的那篇论文,研究的正是图像的去雾技术,它可以还原图像的颜色和能见度,同时也能利用雾的浓度来估计物体的距离,这些在计算机视觉上都有重要应用(例如三维重建,物体识别)。

难以想象的是,他最初对去雾研究的灵感竟是来源于电脑游戏。何恺明发现,3D游戏里有很多带有雾的场景,但这些场景都是虚构的不实在的东西。计算机生成的3D图像会与自然图像的统计规律有很大区别,但人的视觉系统却仍然能感觉到虚拟图像中存在的雾。这让他相信,人的视觉系统一定有一种有效的机制来感知有雾的图像,而且这种机制一定与现存的去雾方法不一样。

与之前的方法不同,何恺明把注意力放到了无雾图像的统计特征上。在无雾图像中,每一个局部区域都很有可能会有阴影,或者是纯颜色的东西,又或者是黑色的东西。因此,每一个局部区域都很有可能有至少一个颜色通道会有很低的值。他把这个统计规律叫做Dark Channel Prior。

即使有了想法和实验结果,第一次写文章也使何恺明觉得非常困难。他经常陷入自己和自己吵架的角色当中。在每一段话写好之后,常常会质问自己事情到底是不是这样的,这其中有没有漏洞。他也会思考,如果自己是评委,或者是读者,能看懂这篇文章吗,怎么写才能让思路更加流畅?

就在这样的挣扎中,何恺明的一稿通常要写好几天。每当他把自己说服了,孙剑还是总能提出新的质疑。就在这样的循环中,终于有一天孙剑说文章已经写得不错了,他才开始具体的修改。正是这样的苛刻要求,才会有后来高质量的文章。

残差网络轰动业界

ResNet 在 2015 年的 ILSVRC(ImageNet Large Scale Visual Recognition Challenge)中取得了图像分类、检测、定位三个冠军。2016 年 CVPR 论文:《Deep Residual Learning for Image Recognition》就介绍了 ResNet,该论文截至当前 (2020.1.3) 已被引用超过 36500 次。

残差⽹络(RESNET) 残差神经网络(ResNet) 是由微软研究院的何恺明、张祥雨、任少卿、孙剑等人提出的。

残差神经网络的主要贡献是发现了 “退化现象(Degradation)”,并针对退化现象发明了“快捷连接(Shortcut connection)”(或者跳过连接),极大的消除了深度过大的神经网络训练困难问题。神经网络的 “深度” 首次突破了 100 层、最大的神经网络甚至超过了 1000 层。

何凯明和贾扬清

何凯明和贾扬清都是清华校友中的两大人工智能大牛,两个大牛都不超过35岁,现在都在Facebook FAIR工作,据说这里的薪水极高,百万美金。

贾扬清是深度学习框架Caffe的作者,TensorFlow的作者之一。Google学术引用32326次。有关Cafee的这篇论文被引超9000次。清华自动化系2006年学士,2008硕士,2013年伯克利博士。在Google Brain工作三年,2016年跳槽Facebook,担任AI 平台的主管Leader。

何凯明Google Schoolar 引用43827次,H指数38,2018年被引次数超过两万,以后超五万,六万都是很容易的,CVPR2016年单篇论文引用14379次,是谷歌学术2018年中被引用最多的学术论文(之一?),9篇论文引用过千次,而且, CVPR 2009, CVPR 2016, ICCV 2017 最佳论文,ICCV 2017 最佳学生论文, ECCV 2018最佳论文提名,PAMI Young Researcher Award in 2018。

何凯明现在的引用已经超过中国所有的计算机方面大学教授,这些教授很多是靠学生文章或者团队的文章牛起来的,何凯明几乎所有高引论文都是第一作者。

何凯明的几年之后就可能会成为计算机视觉、图像方面,谷歌学术引用华人第一人,超过他的导师合作者孙剑和斯坦福的李飞飞和UIUC的Thomas Huang。

机器视觉三剑客:何凯明、孙剑与汤晓鸥

何凯明、汤晓鸥、孙剑,实际上也是人工智能界少有的三位著名学者。何凯明是2003年的广东高考状元。汤晓鸥和孙剑都曾是微软亚洲研究院的同事,后来汤于2014年创立了商汤科技,孙则于2016年加入旷视科技。在国内人工智能企业里,形成了所谓“南商汤、北旷视”的局面。

商汤科技与旷视科技、依图科技、云从科技并称为计算机视觉四小龙,俗称“AI四小龙”。

这位大神其实与旷视科技Face++的还大有联系,他们曾经都是一个坑的战友,在微软亚洲研究院还是一个小组,他们还有共同的成绩:“残差网络”。对于这个成绩,

孙剑在接受采访时,曾这样表示:

“要说一下做出这个残差网络完全是团队,何凯明、张祥雨、任少卿和我的集体智慧结晶,缺少任何一人都不敢说能走得到这一步,中间经历很多的失败和曲折。我深感能把我们 4 个不同技能的人凑在一起,打下一个「大怪兽」的幸运;和他们在一起忘我的研究过程是我研究生涯中最难忘的经历之一。”

与孙剑的选择不同,何凯明貌似还走得是那条学院路。并且,进一步地发扬光大。

他选择了去Facebook,担任其AI 实验室研究科学家,选择了进一步走学术之路。

在Facebook AI 实验室研究期间,何凯明仍然醉心于研究,而且颇有建树。

现在,他的最新研究成果MaskR-CNN公布,这是一个概念上简单,灵活,而且通用的对象实例分割框架,在 COCO 的实例分割,边界框对象检测,人物关键点检测 3个任务上均优于现有的单一模型。

除了图像去雾这个领域的成就,何凯明还在默默地继续耕耘。在今年的ICCV中,Facebook有15篇论文被收录,其中五分之一都有何恺明的名字,有多达三篇论文被收录。

2022年6月14日,北四环融科资讯中心A座3层的旷视科技公司里,一把板正的黑色工学椅,在14日凌晨永远失去了它的主人。一代天才科学家孙剑,就此陨落。

何凯明治学方法

TODO,这是我最想写的,苦于暂时没找到合适的材料。日后补充之。

研究成果与代表作

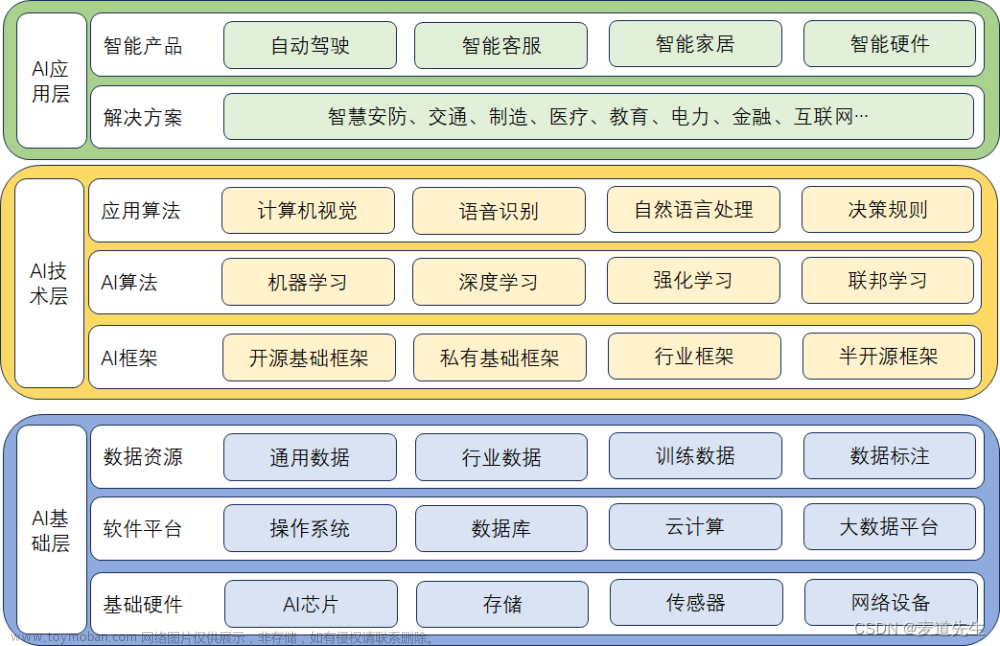

何恺明的研究兴趣大致分成这么几个阶段:

-

传统视觉时代:Haze Removal(3篇)、Image Completion(2篇)、Image Warping(3篇)、Binary Encoding(6篇)

-

深度学习时代:Neural Architecture(11篇)、Object Detection(7篇)、Semantic Segmentation(11篇)、Video Understanding(4篇)、Self-Supervised(8篇)

代表作:

- 2009 CVPR best paper Single Image Haze Removal Using Dark Channel Prior

利用实验观察到的暗通道先验,巧妙的构造了图像去雾算法 。现在主流的图像去雾算法还是在Dark Channel Prior的基础上做的改进。

- 2016 CVPR best paper Deep Residual Learning for Image Recognition

通过残差连接,可以训练非常深的卷积神经网络 。不管是之前的CNN,还是最近的ViT、MLP-Mixer架构,仍然摆脱不了残差连接的影响。

- 2017 ICCV best paper Mask R-CNN

2017年3月,何恺明和同事公布了其最新的研究Mask R-CNN,提出了一个概念上简单、灵活和通用的用于目标实例分割(objectinstance segmentation)框架,能够有效地检测图像中的目标,同时还能为每个实例生成一个高质量的分割掩码。同年,凭借《利用焦点损失提升物体检测效果》这篇论文,他一举夺下了另一个计算机视觉顶级会议ICCV最佳论文奖。

在Faster R-CNN的基础上,增加一个实例分割分支,并且将RoI Pooling替换成了RoI Align,使得实例分割精度大幅度提升。虽然最新的实例分割算法层出不穷,但是精度上依然难以超越Mask R-CNN。

- 2017 ICCV best student paper Focal Loss for Dense Object Detection

构建了一个One-Stage检测器RetinaNet,同时提出Focal Loss来处理One-Stage的类别不均衡问题,在目标检测任务上首次One-Stage检测器的速度和精度都优于Two-Stage检测器。近些年的One-Stage检测器(如FCOS、ATSS),仍然以RetinaNet为基础进行改进。文章来源:https://www.toymoban.com/news/detail-441828.html

- 2020 CVPR Best Paper Nominee Momentum Contrast for Unsupervised Visual Representation Learning

19年末,NLP领域的Transformer进一步应用于Unsupervised representation learning,产生后来影响深远的BERT和GPT系列模型,反观CV领域,ImageNet刷到饱和,似乎遇到了怎么也跨不过的屏障。就在CV领域停滞不前的时候,Kaiming He带着MoCo横空出世,横扫了包括PASCAL VOC和COCO在内的7大数据集,至此,CV拉开了Self-Supervised研究新篇章。文章来源地址https://www.toymoban.com/news/detail-441828.html

参考

- https://blog.51cto.com/u_15274944/5043286

- Kaiming He, Jian Sun, Xiaoou Tang. Single Image Haze Removal Using Dark Channel Prior. CVPR 09, 最佳论文

- Kaiming He, Xiangyu Zhang, Shaoqing Ren, Jian Sun. Deep Residual Learning for Image Recognition. CVPR 16, 最佳论文

- 《数字图像处理》

- 《高级机器学习》

到了这里,关于人工智能大神何凯明往事与风华岁月的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!