羊驼实战系列索引

博文1:本地部署中文LLaMA模型实战教程,民间羊驼模型(本博客)

博文2:本地训练中文LLaMA模型实战教程,民间羊驼模型

博文3:精调训练中文LLaMA模型实战教程,民间羊驼模型

简介

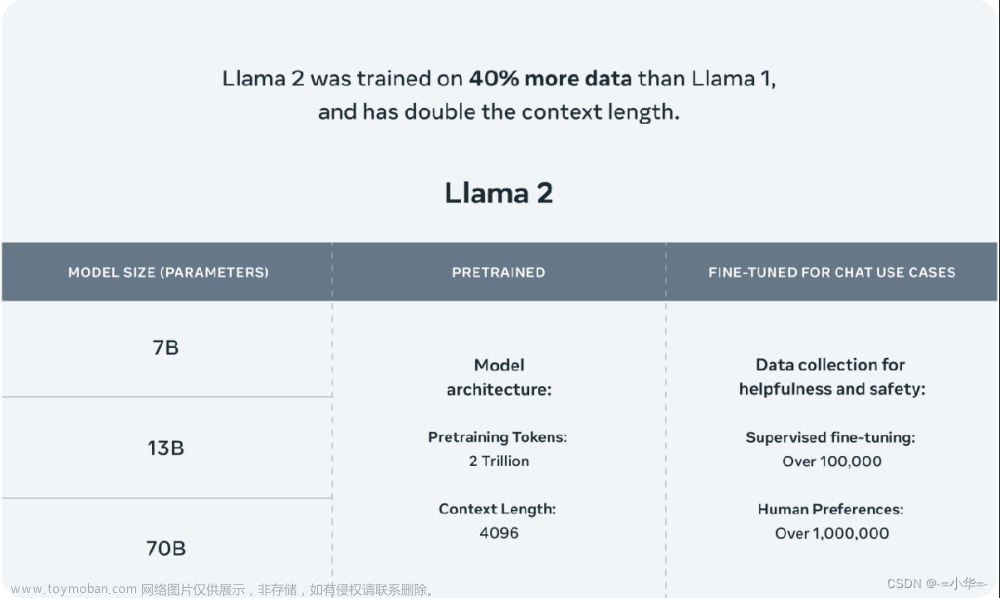

LLaMA大部分是英文语料训练的,讲中文能力很弱。如果我们想微调训练自己的LLM模型,基于一个大规模中文语料预训练的模型比较好。目前开源项目很多,理想的项目要有以下特点:

模型开源、训练代码开源、代码结构简单、环境容易安装、文档清晰。

经过寻找与试验,我找到了一个比较好的项目。

https://github.com/ymcui/Chinese-LLaMA-Alpaca

本博文要点如下:

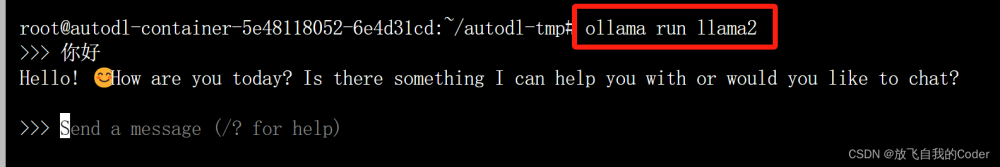

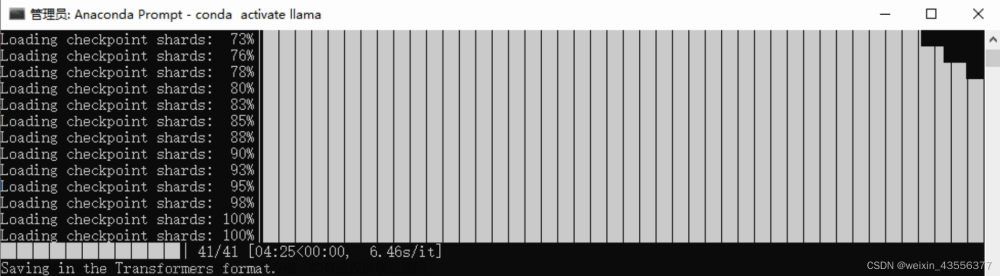

1 实战部分:模型下载与参数合并、模型命令行加载测试、模型部署为web网页(解决了一些报错问题)

2 代码走读:模型参数合并、词表扩充

3 原理分析:预训练与指令精调文章来源:https://www.toymoban.com/news/detail-442951.html

实战

系统环境

系统:Ubuntu 20.10

CUDA Version: 11.8 (我推荐11.7)

GPU: RTX3090 24G

内存: 64 G

anaconda(python版本文章来源地址https://www.toymoban.com/news/detail-442951.html

到了这里,关于本地部署中文LLaMA模型实战教程,民间羊驼模型的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!