spark启动不成功

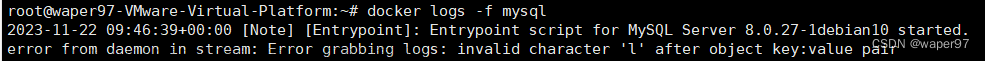

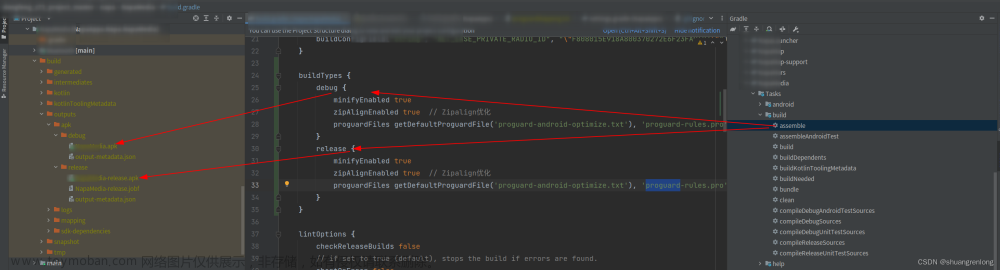

1.查看报错信息

2.原因分析:

这种情况一般是在同一节点启动多个spark master(worker)

3.解决方案:

1>首先应该去停止dfs和yarn,使用命令

stop-all.sh

2> 停止之后使用命令查看当前进程

jps

3> 发现停止之后还是有master,使用命令杀死该进程即可

kill -9 3564在通过jps查看当前进程

jps4>另外两个节点同理,slave01通过jps查看当前进程

杀死该节点的worker

kill -9 2787

5>slave02 同上

6> 在master节点重新启动dfs和yarn

start-dfs.sh

start-yarn.sh7>通过jps命令查看进程

8> 重新启动spark,便可进入spark中文章来源:https://www.toymoban.com/news/detail-446236.html

sbin/start-all.sh

bin/spark-shell  文章来源地址https://www.toymoban.com/news/detail-446236.html

文章来源地址https://www.toymoban.com/news/detail-446236.html

到了这里,关于spark启动不成功的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!