目录

1.查看当前kafka最大文件句柄数

2.修改supervisord.service 服务配置文件

3.加载配置文件

4.重启supervisord.service服务

5.重启kafka等组件

6.查看修改后最大文件句柄数

7.查看kafka当前使用的文件句柄数

参考:

1.查看当前kafka最大文件句柄数

jps

cat /proc/<kafka_pid>/limits

2.修改supervisord.service 服务配置文件

cd /lib/systemd/system/

vim supervisord.service

添加LimitNOFILE=500000

添加完如下:

[Unit]

Description=Cloudera CM Agent Supervisor Service

After=network-online.target

Wants=network-online.target

[Install]

WantedBy=multi-user.target

[Service]

Type=simple

TasksMax=infinity

Environment=CLOUDERA_ROOT=/opt/cloudera

EnvironmentFile=-/etc/default/cloudera-scm-agent

ExecStart=/opt/cloudera/cm-agent/bin/cm supervisor

Restart=on-failure

KillMode=process

LimitNOFILE=5000003.加载配置文件

systemctl daemon-reload4.重启supervisord.service服务

systemctl restart supervisord.service5.重启kafka等组件

在CDH界面重启kafka、zookeeper等组件

6.查看修改后最大文件句柄数

jps

cat /proc/<kafka_pid>/limits

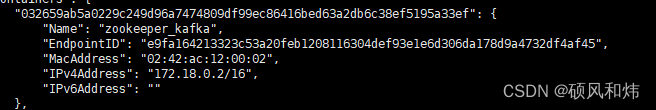

7.查看kafka当前使用的文件句柄数

lsof -p KAFKA_BROKER_PID

lsof -u kafka | wc -l

lsof | grep kafka | wc -l

参考:

limit资源限制ulimit 详解_我为AI领域做了奉献的博客-CSDN博客

Linux lsof命令_书香水墨的博客-CSDN博客

java.io.IOException: Too many open files_java.io.ioexception: 打开的文件过多-CSDN博客文章来源:https://www.toymoban.com/news/detail-446618.html

https://web.archive.org/web/20220429155307/https://blog.51cto.com/u_15072910/3961649

https://web.archive.org/web/20220615072645/https://www.jianshu.com/p/1a48a4920088

文章来源地址https://www.toymoban.com/news/detail-446618.html

到了这里,关于修改通过CDH安装的Kafka和Zookeeper等组件的最大文件句柄数的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!