1、pycharm加载包列表时出错: unknown protocol: e

解决方案1:

网络的问题。加载不了软件包列表多数是网络连接异常导致。

1、首先打开电脑检查网络。

2、其次打开pycharm软件进行测试网络连接是否异常。

3、最后点击重新连接网络后重新登录该软件即可。

结果:不成功。网络无问题,且pycharm更新到最新

解决方案2:

转到Settings/Appearance and Behavior/System Settings/HTTP Proxy并检查Auto-detect proxy settings并且它有效。

结果:不成功。

解决方案3:

尝试使用HTTP选项,但是它不起作用,然后我打开了管理存储库,并删除了https://pypi.python.org/simple以外的所有文件,并且它起作用了。

结果:成功!!!

2、tensorflow和python版本不对应

安装python + tensorflow 参考博文:https://blog.csdn.net/SparklingStar1/article/details/105353940?

ops_request_misc=%257B%2522request%255Fid%2522%253A%2522167405789616800182730134%2522%252C%2522scm%2522%253A%252220140713.130102334…%2522%257D&request_id=167405789616800182730134&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2allsobaiduend~default-2-105353940-null-null.142v71one_line,201v4add_ask&utm_term=pycharm%E5%AE%89%E8%A3%85tensorflow1.9&spm=1018.2226.3001.4187

解决方案:https://tensorflow.google.cn/install/source_windows#cpu 官网查看对应版本

python3.6 tensorflow1.9

安装tensorflow时报错

C:\Users\Felix>pip install --user tensorflow1.9.0 -i https://pypi.doubanio.com/simple/

Collecting tensorflow1.9.0

Downloading https://pypi.doubanio.com/packages/e7/88/417f18ca7eed5ba9bebd51650d04a4af929f96c10a10fbb3302196f8d098/tensorflow-1.9.0-cp36-cp36m-win_amd64.whl (37.1MB)

100% |████████████████████████████████| 37.1MB 39kB/s

Collecting numpy>=1.13.3 (from tensorflow1.9.0)

Downloading https://pypi.doubanio.com/packages/ea/bc/da526221bc111857c7ef39c3af670bbcf5e69c247b0d22e51986f6d0c5c2/numpy-1.19.5-cp36-cp36m-win_amd64.whl (13.2MB)

100% |████████████████████████████████| 13.2MB 109kB/s

Collecting protobuf>=3.4.0 (from tensorflow1.9.0)

Downloading https://pypi.doubanio.com/packages/6c/be/4e32d02bf08b8f76bf6e59f2a531690c1e4264530404501f3489ca975d9a/protobuf-4.21.0-py2.py3-none-any.whl (164kB)

100% |████████████████████████████████| 174kB 3.2MB/s

protobuf requires Python ‘>=3.7’ but the running Python is 3.6.5

You are using pip version 9.0.3, however version 22.3.1 is available.

You should consider upgrading via the ‘python -m pip install --upgrade pip’ command.

无法导入tensorflow

解决办法:更新protobuf

参考博文:https://blog.csdn.net/qq_39343904/article/details/85048483

结果:成功!!!文章来源:https://www.toymoban.com/news/detail-446651.html

3、PyCharm导入tensorflow包

pycharm -> 文件 -> 设置 -> 项目:pycharmproject -> python解释器 -> 齿轮图标 -> 添加 -> conda环境 -> 现有环境

解释器:python安装路径下的python.exe文件

conda可执行文件:conda.exe文件

解释:

若是你也遇到这个问题,说明你也没有理解tensorflow到底在哪里。

当安装了anaconda3.6后,在PyCharm中设置interpreter,这个解释器决定了你在PyCharm环境中写的代码采用什么方式去执行。

若是你的设置是anaconda下的python.exe。就会发现在PyCharm中写入import tensorflwo as tf 时,就会报错,提示没有tensorflow模块,这是因为anaconda文件下的python.exe是3.6版本的,而你创建的conda环境是在anaconda下,而你安装的tensorflow在了conda环境下,不是在anaconda环境下,因此若是你要导入tensorflow,则需要把解释器选择为conda环境下的python.exe。

当你的解释器选择如下图的红色框中,选择的interpreter是anaconda下的python.exe时,在PyCharm环境中导入tensorflow时,就会提示没有找到tensorflow模块。

若是你想使用tensorflow,则解释器应该选择,如下图路径(anaconda->envs->tenfowflow->python.exe)下的python.exe

解释器正确的选择如图所示,单击下图箭头所指的设置按钮,选择Add local,,选择上图显示的路径的python.exe,而不是anaconda下的python.exe,选择conda环境下的python.exe后,则会显示下图红色框中显示的设置。

4、

报错:absl.flags._exceptions.IllegalFlagValueError: flag --data_dir=None: Flag --data_dir must have a value other than None.

flag --task_name=None: Flag --task_name must have a value other than None.

flag --vocab_file=None: Flag --vocab_file must have a value other than None.

flag --bert_config_file=None: Flag --bert_config_file must have a value other than None.

flag --output_dir=None: Flag --output_dir must have a value other than None.

报错原因:

#这是配置运行参数时parameters项内容,这样写会报错

–task_name=MRPC \

–do_train=true \

–do_eval=true \

–data_dir=…/glue/glue_data/MRPC \

–vocab_file=…/glue/BERT_MODEL_DIR/uncased_L-12_H-768_A-12/vocab.txt \

–bert_config_file=…/glue/BERT_MODEL_DIR/uncased_L-12_H-768_A-12/bert_config.json \

–init_checkpoint=…/glue/BERT_MODEL_DIR/uncased_L-12_H-768_A-12/bert_model.ckpt \

–max_seq_length=128 \

–train_batch_size=8 \

–learning_rate=2e-5 \

–num_train_epochs=1.0 \

–output_dir=…/glue/outputs

解决方法:参数改成下方代码

–task_name=MRPC

–do_train=true

–do_eval=true

–data_dir=…/GLUE/glue_data/MRPC

–vocab_file=…/GLUE/BERT_MODEL_DIR/chinese_L-12_H-768_A-12/vocab.txt

–bert_config_file=…/GLUE/BERT_MODEL_DIR/chinese_L-12_H-768_A-12/bert_config.json

–init_checkpoint=…/GLUE/BERT_MODEL_DIR/chinese_L-12_H-768_A-12/bert_model.ckpt

–max_seq_length=128

–train_batch_size=8

–learning_rate=2e-5

–num_train_epochs=1.0

–output_dir=…/GLUE/output

结果:没有成功运行,并且生成另外报错

tensorflow.python.framework.errors_impl.NotFoundError: NewRandomAccessFile failed to Create/Open: …/GLUE/BERT_MODEL_DIR/chinese_L-12_H-768_A-12/bert_config.json : ϵͳ\udcd5Ҳ\udcbb\udcb5\udcbdָ\udcb6\udca8\udcb5\udcc4·\udcbe\udcb6\udca1\udca3

; No such process

解决方法:其实这是个傻瓜错误,因为路径给错了,修改运行配置参数中的路径

–task_name=MRPC

–do_train=true

–do_eval=true

–data_dir=…/GLUE/glue_data/MRPC

–vocab_file=…/GLUE/BERT_BASE_DIR/uncased_L-12_H-768_A-12/vocab.txt

–bert_config_file=…/GLUE/BERT_BASE_DIR/uncased_L-12_H-768_A-12/bert_config.json

–init_checkpoint=…/GLUE/BERT_BASE_DIR/uncased_L-12_H-768_A-12/bert_model.ckpt

–max_seq_length=128

–train_batch_size=2

–learning_rate=2e-5

–num_train_epochs=1.0

–output_dir=…/GLUE/output

结果:成功!!!

5、FutureWarning: Passing (type, 1) or ‘1type‘ as a synonym of type is deprecated

问题描述

在使用BERT进行中文长文本分类用TensorFlow的过程中PyCharm控制台出现:FutureWarning: Passing (type, 1) or ‘1type’ as a synonym of type is deprecate

如下图

解决方案:

numpy的版本过高,降低版本:

结果:成功!!!

6、AttributeError: module ‘tensorflow._api.v2.train‘ has no attribute ‘Optimizer‘

解决方案:先检查 tensorflow 的版本,python版本与tensorflow版本是否匹配。

结果:成功!!!

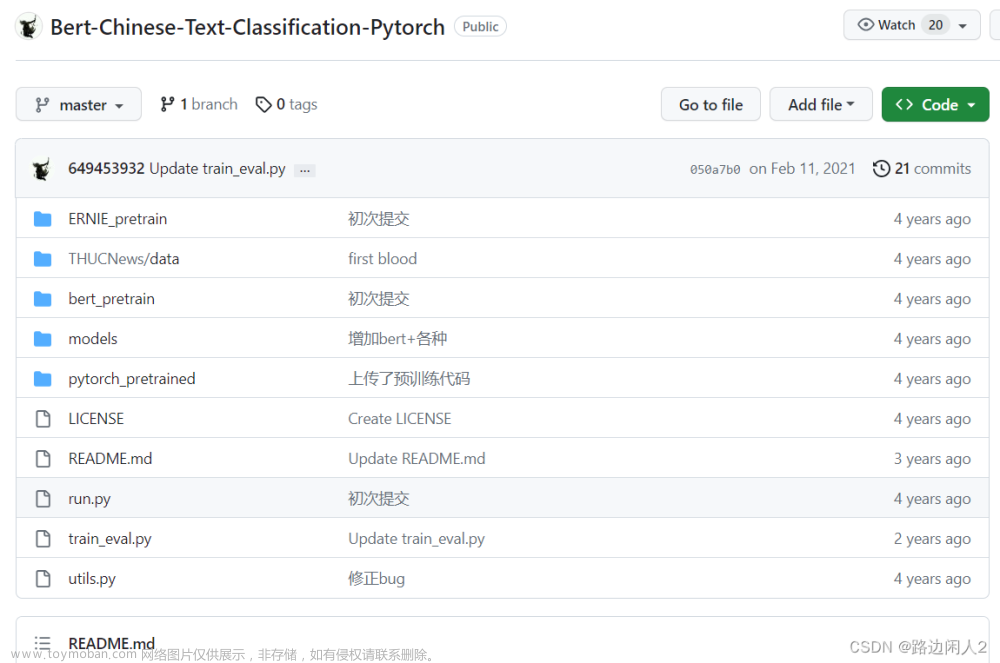

7、Traceback (most recent call last):

File “C:/Users/Felix/PycharmProjects/CSDN/bert-master/run_classifier.py”, line 1029, in

tf.app.run()

File “C:\Users\Felix\AppData\Roaming\Python\Python36\site-packages\tensorflow\python\platform\app.py”, line 125, in run

_sys.exit(main(argv))

File “C:/Users/Felix/PycharmProjects/CSDN/bert-master/run_classifier.py”, line 890, in main

train_examples = processor.get_train_examples(FLAGS.data_dir)

File “C:/Users/Felix/PycharmProjects/CSDN/bert-master/run_classifier.py”, line 351, in get_train_examples

raise train_data

TypeError: exceptions must derive from BaseException文章来源地址https://www.toymoban.com/news/detail-446651.html

到了这里,关于python_谷歌开源BERT模型文本分类出现的相关报错记录的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[oneAPI] 使用Bert进行中文文本分类](https://imgs.yssmx.com/Uploads/2024/02/661538-1.png)