爬虫数据抓取是一种自动化的数据采集技术,可以快速、高效地从互联网上获取大量的数据。本文将介绍爬虫数据抓取的基本原理、常用的爬虫框架和工具、爬虫数据抓取的注意事项以及爬虫数据抓取的应用场景。

一、爬虫数据抓取的基本原理

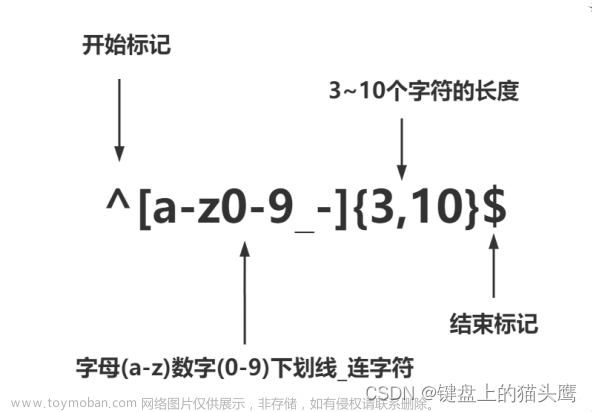

爬虫数据抓取的基本原理是通过模拟浏览器的行为,自动化地访问网站并抓取网页上的数据。具体来说,爬虫程序会向目标网站发送HTTP请求,获取网页的HTML代码,然后解析HTML代码,提取出需要的数据。爬虫程序可以通过正则表达式、XPath、CSS选择器等方式来解析HTML代码,提取出需要的数据。

二、常用的爬虫框架和工具

- Scrapy

Scrapy是一个Python编写的开源爬虫框架,它可以快速、高效地抓取网站上的数据。Scrapy提供了强大的数据抓取和处理功能,支持异步IO和多线程,可以快速地处理大量的数据。Scrapy还提供了丰富的插件和扩展,可以方便地进行数据存储、数据清洗和数据分析等操作。

- BeautifulSoup

BeautifulSoup是一个Python库,用于解析HTML和XML文档。它可以快速地解析HTML代码,提取出需要的数据。BeautifulSoup提供了简单易用的API,可以方便地进行数据解析和数据提取操作。

- Selenium

Selenium是一个自动化测试工具,可以模拟用户在浏览器上的操作。它可以自动化地打开浏览器,访问网站并抓取数据。Selenium支持多种浏览器,可以方便地进行跨浏览器测试。

三、爬虫数据抓取的注意事项

- 遵守网站的规则

在进行爬虫数据抓取时,需要遵守网站的规则。一些网站可能会禁止爬虫程序的访问,需要进行身份验证或者使用代理服务器进行访问。如果不遵守网站的规则,可能会被网站封禁IP地址或者采取其他限制措施。

- 控制爬虫速度

在进行爬虫数据抓取时,需要控制爬虫的速度,避免对网站造成过大的负担。可以设置爬虫的访问间隔时间,或者使用代理服务器进行访问,减少对网站的访问压力。

- 处理异常情况

在进行爬虫数据抓取时,可能会遇到一些异常情况,例如网络连接超时、网站返回错误信息等。需要对这些异常情况进行处理,避免爬虫程序中断或者出现错误。

四、爬虫数据抓取的应用场景

- 数据采集和分析

爬虫数据抓取可以快速地获取大量的数据,可以用于数据采集和分析。例如,可以使用爬虫程序抓取电商网站上的商品信息,进行价格比较和商品分析。

- SEO优化

爬虫数据抓取可以用于SEO优化,可以获取网站上的关键词和链接信息,进行关键词优化和链接建设。

- 网络安全

爬虫数据抓取可以用于网络安全,可以获取网站上的漏洞信息和安全事件,进行安全分析和预警。文章来源:https://www.toymoban.com/news/detail-448076.html

总之,爬虫数据抓取是一种强大的数据采集技术,可以快速、高效地获取大量的数据。在进行爬虫数据抓取时,需要遵守网站的规则,控制爬虫的速度,处理异常情况。爬虫数据抓取可以应用于数据采集和分析、SEO优化、网络安全等领域。文章来源地址https://www.toymoban.com/news/detail-448076.html

到了这里,关于爬虫数据抓取怎么弄?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!