一、人工智能的主要技术阶段:

- 第一次浪潮:符号主义。第一次浪潮随着计算机的产生而同时诞生。符号主义也被称为逻辑主义,这是一种“自上而下的人工智能分析法”在20世纪50 年代尔和西蒙提出了“物理符号系统假设”即“对一般智能行动来说,物理符号系统具有必要的和充分的手段。第一次浪潮当中:

- 我们仅用数学符号和逻辑运算,只能处理纯粹的数学形式的问题。不能够跟客观世界进行直接交互;

- 不能够表达人类各种各种各样的,复杂的知识。——人们为了将更多的复杂知识纳入到人工智能的系统中,产生了第二次浪潮。

- 第二次浪潮:专家系统。如何理解专家系统呢?可以有两层含义:第一,人工智能的全部知识都来自于人类专家。我们只是将人类专家所掌握的知识写成一条一条的规则,然后程序让系统自动实施而已。第二,有了这些知识,人工智能系统就能像人类专家一样工作。简而言之,专家系统是一种模拟人类专家解决领域问题的计算机程序系统。由于融入了人类积累的、大量的先验知识,专家系统将人工智能向前推进了一大步。但是很快就遇到了第二次瓶颈:

- 第一,它不能够自己学习新的知识,仅局限于人类已经知道的知识;

- 第二,它也只能够掌握“陈述性知识”。

- 第三次浪潮:统计学习方法。顾名思义就是用统计方法来实现学习。(1)“学习”,对于人工智能来讲,通过大量的历史数据去找到规律性的东西,而这个规律性的东西就是我们所谓的知识。这些规律性的东西有可能是能陈述的,有可能是不能陈述的,例如控制一个机器人跑步。(2)如何从历史数据当中去学到这些知识呢?非常简单,用统计的方法。例如大语言模型,它怎么知道“中国的首都是……”后面接下来那个词应当是“北京”呢?非常简单,从大量的语料学习中它就发现,前面几个词是“中国的首都是”的时候,后面99%的情况都是“北京”。做一个简单的统计就可以了。统计学习带来了接下来人工智能20多年的新一波发展,我们熟悉的 AlphaGo、ChatGPT背后的原理都是如此。

二、关键的技术节点:

- 1942:阿西莫夫“机器人三定律”。人工智能的伦理规范的基本哲学起点。

- 1950:图灵测试。从数学上告诉我们,我们是有可能用算法来模拟智能的。

- 1956: 达特茅斯会议。学者们提出了人工智能这个概念。

- 1997: IBM深蓝计算机,计算机在智力游戏中战胜人类。

- 1998: 神经网络。心理学家提出来神经网络,模拟人类大脑神经结构的一个数学模型。

- 2003: 神经语言模型,认知智能建模语言。

- 2009: ImageNet,感知智能高精度识别图片。(大数据的出现)

- 2012: 模糊的猫脸-- AI第一次生成图像内容。

【迈向通用语言智能时代】 - 2013: Word2Vec词向量。认知智能建模语义。通过优化后的训练模型可以快速有效地将一个词语表达成高维空间里的词向量形式,为自然语言处理领域的应用研究提供了新的工具。

- 2014: 谷歌收购DeepMind。AI实现自我演化、自我博弈。Lan Goodfellow从博弈论中的“二人零和博弈”得到启发 ,创造性的提出了生成对抗网络(GAN,Generative Adversarial Networks)

- 2015: OPEN AI公司成立。

- 2016: AlphaGo战胜围棋世界冠军李世石。

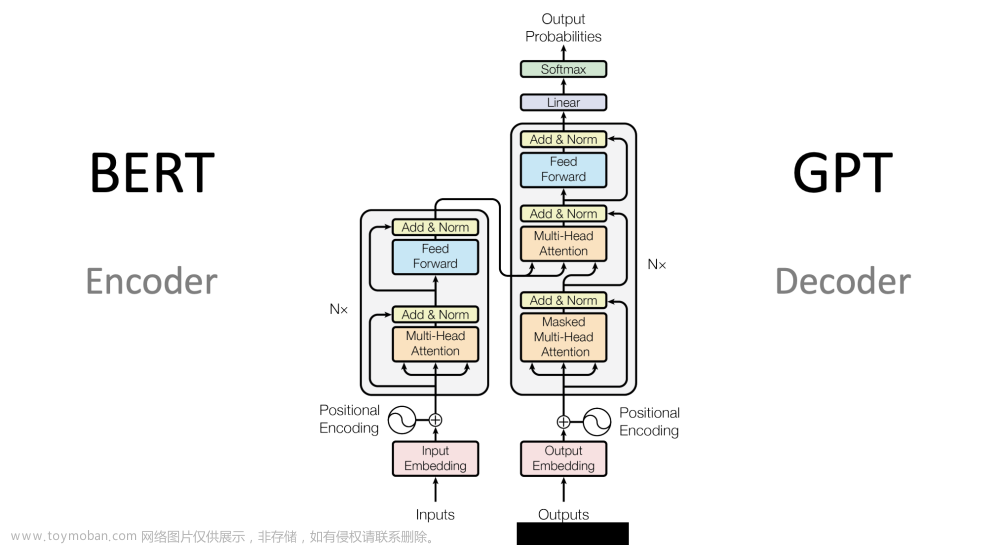

- 2017: Transformer横空出世,通用知识建模。它能够建模语言当中任意距离之间的词汇关系。大模型大数据大算力,大力出奇迹,暴力美学。

- 2018: OPEN AI发布了第一版的GPT,Google发布BERT大模型。

【大模型之路开启:预训练(Pre-trained Models)+微调】 - 2019: GPT-2,统一自然语言任务。GPT-2在经过大量无标注数据生成式训练后,展示出来的零样本(zero-shot)多任务能力。

- 2020: GPT-3,大模型“涌现”类人智能。小样本(few-shot)学习能力,通过少量的几个例子就能适应目标任务,无需进行针对性的额外微调训练。

- 2021-Feb:DALL- E,第一个“文本生成图像”的AI绘画模型。

- 2021-Jun: CodeX,代码生成,AI具有理论上的自我繁殖能力。

- 2021-Oct:Disco-Diffusion, AI绘画大模型.

- 2022-Mar: OpenAI发布InstructGPT,引入人类反馈学习。

- 2022-May: GPT-3.5。

- 2022-Jul:AlphaFold破解了几乎所有的蛋白质三维结构 + ImagenVideo,AI视频生成。

- 2022-Nov: ChatGPT大模型走进公众视野。

- 2023-Feb:OpenAI的CEO Altman发布文章,宣布OpenAI的使命是确保其造福全人类。

- 2023-Mar-1: ChatGPT的API开放,模型即服务的时代到来。

- 2023-Mar-15: GPT-4发布,突破语言空间。

- 2023-Mar-17: OFFICE COPILOT发布。

- 2023-Mar-24: GPT插件功能发布,开始与物理世界交互。

三、人工智能技术发展的三个阶段

人工智能技术发展由浅到深可以划分为计算智能(Computing)、感知智能(Sense)、决策智能(Act)三个阶段;

- 「计算/运算智能」:在这个阶段人工智能只能处理纯粹的数学问题,不能够跟客观世界进行交互。计算机能够实现存储与计算,并作为传输信息的重要手段,比如 在过去一段时间内,计算机最大的发展是将一切信息都尽可能的数字化,从早期的计算与文字,到发展至今的电商、娱乐等场景的数字化;1996年IBM的深蓝计算机战胜了当时的国际象棋冠军卡斯帕罗夫,从此,人类在这样的强运算型的比赛方面就不能战胜机器了。

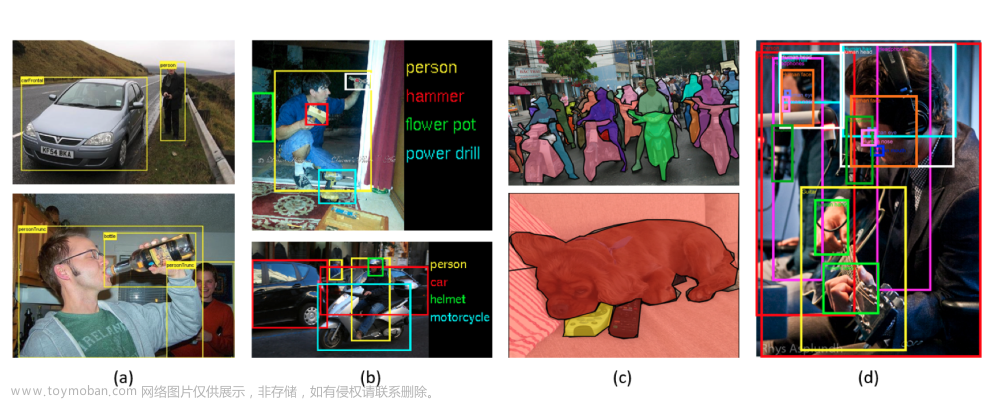

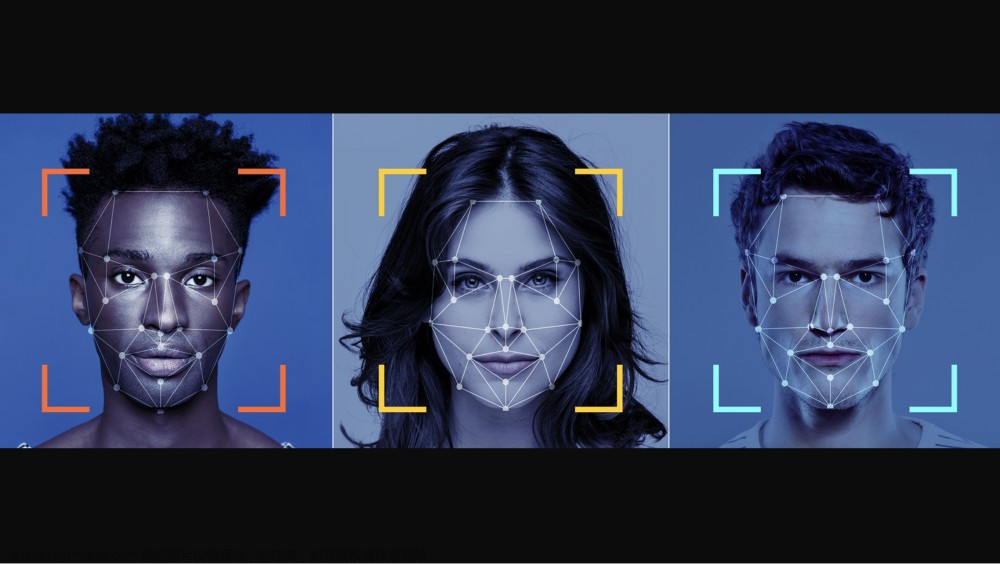

- 「感知智能」:人工智能系统拥有了人类五官能够看见、听见的能力。比如智能语音控制、人脸识别技术、医学影像识别等等。感知智能解决的是「是什么」的问题

- 认知智能:感知智能是人类的五官的能力,而认知智能是人类大脑的能力,能够进行逻辑推理、理解决策、思考、甚至创造性的活动。认知智能领域最典型的应用就是自然语言处理。

- 「决策智能」:在「是什么」的基础上还知道要「怎么办」。要求机器能够像人一样进行思考,并主动的做出行动,比如在完全自动驾驶场景下,汽车能够自己做出超车、转弯的行动等。

1. 1943-2006 年:理论知识积累的时期,相关研究进展缓慢

回顾人工智能早期发展史,其可以追溯至 1943 年,直至 2006年之前由于当时的算力受限 且数据不足,算法没办法充分发挥其作用,这一阶段主要是人工智能理论知识的启蒙与积累 阶段,期间也曾产生一些阶段性成果,但整体研究进展较为缓慢。其中,一些典型的理论积累如下:

思想启蒙:1943 年,沃伦〃麦卡洛克和沃尔特〃皮茨发表了《神经活动中内在思想的逻辑 演算》,这启发了后来神经网络和深度学习的产生。1950 年著名的图灵测试诞生,按照“人 工智能之父”艾伦〃图灵的定义:如果一台机器能够与人类展开对话(通过电传设备)而不 能被辨别出其机器身份,那么称这台机器具有智能。1956年夏天,美国达特茅斯学院举行了历史上第一次人工智能研讨会,被认为是人工智能诞生的标志。会上,麦卡锡首次提出了 “人工智能”这个概念,纽厄尔和西蒙则展示了编写的逻辑理论机器。

从推理期至知识期,期间推出大量专家系统。20 世纪 50-70 年代,人们认为如果能赋予计算机推理能力,机器就有智能,人工智能研究处于“推理期”,之后人们意识到人类能够进行判断、决策还需要知识,人工智能在 70 年代进入“知识期”,诞生了大量的专家系统如 Dendral,但由于当时的计算机有限的内存和处理速度不足以解决任何实际的人工智能问题, 导致研究缺乏进展,美国和英国相继缩减经费支持,人工智能进入第一次低谷。

第五代计算机项目:1981 年,日本经济产业省拨款 8.5 亿美元用以研发第五代计算机项目, 在当时被叫做人工智能计算机。随后,英国、美国纷纷响应,开始向信息技术领域的研究提 供大量资金。但是专家系统的实用性仅仅局限于某些特定情景。到了上世纪 80 年代晚期, 美国国防部高级研究计划局(DARPA)的新任领导认为人工智能并非“下一个浪潮”,拨款将倾向于那些看起来更容易出成果的项目;此外第五代计算机项目宣告失败,人工智能进入 第二次低谷期。

2. 2006-2016 年:算法、算力与数据三重合力推动,人工智能取得重大突破

人工智能算法的开发通常离不开三个核心要素,即算法、算力、数据。2006-2016 年这十年 间,这三大核心要素均迎来了质的飞跃:

- 第一重飞跃:深度学习算法能够支持训练更大规模的神经网络。深度学习算法能够训练更大 规模的神经网络 2006 年 Geoffrey Hinton 和他的学生 Ruslan Salakhutdinov 在《科学》上发 表文章,给出多层神经网络更好训练方法,至此神经网络算法才开始真正具有深度。与过去 传统的人工智能算法相比,深度学习算法能够训练更大规模的神经网络,从而解决更复杂的 问题,而且随着数据规模的提升,规模越大的神经网络的深度学习算法表现出的效果越显著。

- 第二重飞跃:芯片发展遵循摩尔定律,算力得到质的提升。摩尔定律指出芯片上可容纳的晶 体管数目,约每隔 18 个月便会增加一倍,性能也将提升一倍。1945 年世界上第一台计算机 ENIAC 的速度是能在一秒内完成 5000 次定点的加减法运算,到 2007 年采用英特尔酷睿芯 片的个人电脑计算速度为每秒 500 亿次浮点运算,是 ENIAC 的 1000 万倍,体积和耗电量 却小了很多;到 2012 年全球最快的计算机 IBM 的红杉的计算速度为 1.6 亿亿次,比 19 个 月前竟提高了将近 6 倍。(数据来源:吴军《浪潮之巅》)通过以上几组数据可以发现,自 2006 年 Geoffrey Hinton 发布有关深度学习的文章后,计算机的算力得到了质的提升,可以有效 的支撑大规模的模型训练。

- 第三重飞跃:PC 互联网与移动互联网的发展为人工智能模型训练提供了庞大的数据积累。 PC 互联网的发展使用户的许多场景线上化,比如新闻讯息、邮件、电商等,产生了相当规 模的数据;而移动互联网又进一步地将智能手机等更多终端纳入互联网体系,并产生丰富新 的应用,使数据规模得到了进一步地增长。根据 IDC 预测,全球数据圈将从 2018 年的 33ZB 增至 2025 年的 175ZB。

三重合力推动人工智能在多领域取得技术突破,逐步开始具有商业价值。在更强大的算力支 撑下,通过大规模训练数据喂养的深度学习算法模型表现出更优异的效果,推动计算机视觉、 语音识别等领域取得了重大的技术突破,比如 2014 年香港中文大学汤晓鸥教授团队发布 DeepID 系列人脸识别算法准确率达到 98.52%,全球首次超过人眼识别率,突破了工业化应 用红线;根据易观数据,2009 年深度神经网络算法被应用于语音识别领域时,语音识别准 确率突破 90%,至 2016 年百度、搜狗等头部公司都先后宣布其语音识别率达到了 97%。这 一阶段,人工智能开始呈现出一定的应用价值,开始逐步走向商业化。文章来源:https://www.toymoban.com/news/detail-448210.html

3. 2016 年至今:人工智能全面走向商业化应用,中国在应用场景优势突出

人工智能产业链主要分为基础层、技术层、应用层三个层级,其中:文章来源地址https://www.toymoban.com/news/detail-448210.html

- 1)基础层以数据、算力、算法为核心;

- 算法:算法实力大 幅提升,目前主流的算法框架有谷歌 旗下的 Tensorflow 与 Keras、Meta(原 Facebook)旗下的 Pytorch、微软旗下的 CNTK、 伯克利大学推出的 Caffe 等,其中 Tensor Flow 与 Pytorch 是当前使用最为广泛的两个开源 算法框架。从国内看,百度 2016 年推出的自研飞桨算法框架也形成强大的开发者影响力;

- 算力:近年涌现出非常多定制化芯片,进一步推动终端算力提升;另一方面云计算的发展将更加充分地支撑超大规模的计算力;

- 芯片

- 在人工智能场景中更适用。通用芯片主要分为 CPU、GPU 两种 类型,两者的设计构造不同,适用场景有所差异:

- 1)CPU 芯片中算术单元相对较小,控制 单元较多,主要用于处理小数据量的复杂逻辑运算;

- 2)GPU 是图形处理芯片,控制单元较 少,算术逻辑单元较多,可用于处理大规模数据量的简单运算。

- FPGA(Field Programmable Gate Array),即现场可编辑门阵列,相较于 CPU、GPU 芯片,FPGA 芯片的灵活性高、性能强、能耗低,但是价格更高;

- ASIC针对不同的人工智能场景进行了定制优化,能够达到性能更强,同时能耗更低的效果。

- 人工智能算法的应用简单可以概括为训练与推理两个阶段:

- 一般训练阶段需要通过多轮迭代得出最优的模型,可能会遇到大规模的并行运算——预计定制化的 ASIC 芯片成主流

- 推理阶段主要做逻辑判断,相较而言数据需求量比较小,此时使用 CPU 芯片、FPGA 芯片处理有时更合适

- 在人工智能场景中更适用。通用芯片主要分为 CPU、GPU 两种 类型,两者的设计构造不同,适用场景有所差异:

- 云计算

- 芯片

- 数据:人工智能快速发展的核心原因之一是互联网、移动互联网两个时代的发展实现了大规模的数字化,为算法的训练提供了充足的数 据资源。

- 2)技术层是建立在基础层的核心能力之上,通过打造一套人工智能系统使机器能够像人类一样进行感知与分析,其中最关键的领域包括计算机视觉(图像识别与分析)【看得懂】、语音识别与自然语言处理技术(语音识别与合成)【听得懂】、机器学习与深度学习(分析决策及行动)【推理】等

- 计算机视觉:计算机视觉应用广泛,安防影像分析占据市场份额最大。计算机视觉行业的应用主要分为七 大类,包括安防影像分析、广告营销分析、泛金融身份认证(解决方案)、互联网娱乐、泛金融身份认证(云服务、SDK 等)、手机及创新领域等。

- 自然语言处理:智能语音转写(例如科大讯飞旗下的“讯飞听 见”、搜狗旗下的“搜狗听写”、迅捷文字语音转化器)、语音助手(Siri)

- 知识图谱(knowledge graph ):知识图谱以结构化的形式描述现实世界中的实体,概念及其之间的关系,将互联网上的信息表达成一种更接近人类认知世界的形式,为机器提供了组织、管理和理解互联网信息的能力。主要应用于:

- 智能搜索

- 知识问答

- 关系网络:例如 天眼查。

- 不一致性检测:能够快速识别假冒身份、征信造假、组团期价欺诈等金融风控问

- 数据的异常分析:从给定的数据中找出“异常”点

- 基于规则提取特征:从知识图谱中提取一些特征,这对数据分析与应用和机器学习有关键性的价值。

- 3)应用层是将技术能力与具体场景相融合,帮助企业/城市管理者等客户降本增效,目前主要应用的场景有泛安防、金融、医疗、自动驾驶等领域。

到了这里,关于人工智能的发展爬梳的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!